GPU et autonomie : les avancées de Skylake

Lors du keynote d'ouverture de l'Intel Developper Forum, il a été question de tout (« sensification » des ordinateurs, internet des objets, stockage), sauf de Skylake. Heureusement, les sessions qui ont suivi la conférence ont permis d'en savoir plus sur cette nouvelle génération de processeurs qui a récemment fait ses débuts.

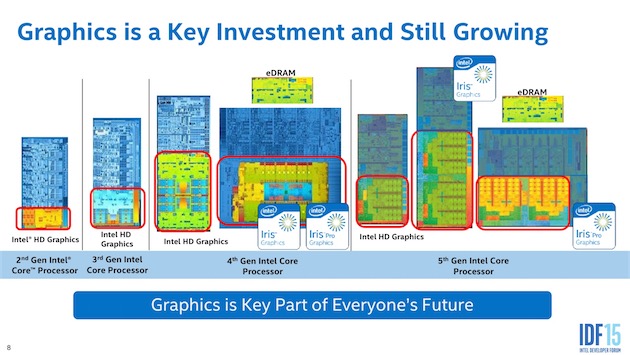

Ars Technica a consacré plusieurs articles fouillés sur les nouveautés de Skylake. L'un d'entre eux est consacré au GPU, un composant aujourd'hui essentiel puisqu'on lui confie de plus en plus de tâches — Apple l'a illustré récemment en portant l'API graphique Metal sur Mac et en s'en servant comme d'un moyen pour accélérer l'ensemble du sytème.

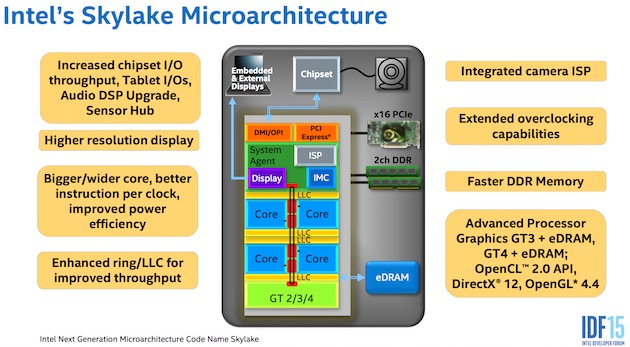

Intel a amélioré la modularité des GPU des puces Skylake. Schématiquement, si vous utilisez uniquement la partie du GPU dédiée à l'encodage/décodage matériel, le reste sera mis en veille afin de préserver l'autonomie.

L'unslice (la partie fixe qui gère la géométrie et d'autres fonctions fixes) peut aussi être cadencé indépendamment des slices (les parties qui contiennent les unités de calculs) afin d'optimiser la consommation et les performances en fonction de la tâche exécutée.

Skylake introduit par ailleurs une nouvelle configuration de GPU au nom de code « GT4 ». Il existait déjà le GT2 (Intel HD 5600) qui contient 24 unités d'exécution (EU), le GT3 avec 48 EU et le GT3e (Iris Pro) avec 48 EU et un module d'eDRAM. Le nouveau GT4 dispose, lui, de 72 EU et devient ainsi le nouveau GPU le plus puissant. Intel n'a pas annoncé de version « e » avec module d'eDRAM, mais ce n'est pas à exclure pour plus tard.

Est-ce que les prochains MacBook Pro 15" seront équipés d'un GPU GT4(e) ? Compte tenu de leur positionnement et de l'absence de GPU dédié sur le modèle de base, ce serait logique et souhaitable, mais Intel n'a toujours pas dévoilé quels seront les couples CPU + GPU — en dehors des deux premiers processeurs de bureau lancés, évidemment.

Qui dit nouvelle génération, dit généralement nouveaux protocoles pris en charge, et c'est le cas avec Skylake. Rappelons que les GPU Broadwell supportent la 4K à 60 Hz via le DisplayPort 1.2 et la 4K à 24 Hz via le HDMI 1.4, entre autres.

Les GPU Skylake peuvent gérer en plus la 4K à 60 Hz via le HDMI 2.0, mais à condition d'utiliser un adaptateur DisplayPort vers HDMI 2.0. Sur les machines qui sont équipées du contrôleur qui va bien, la norme HDMI 2.0 intégrée au Thunderbolt 3 est également supportée.

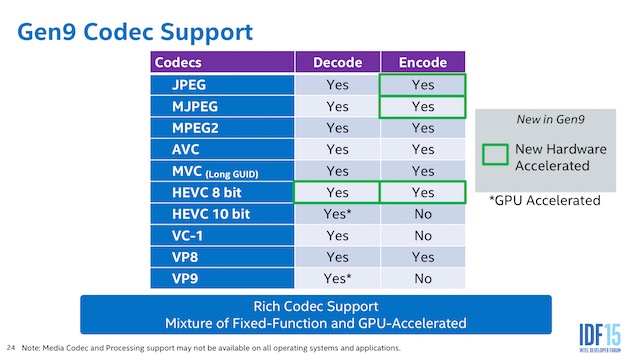

L'accélération matérielle, qui décharge le CPU de la tâche et améliore les performances, fonctionne plus largement. Les GPU Skylake peuvent encoder et décoder matériellement le H.265/HEVC 8-bit, et encoder matériellement les formats JPEG et MJPEG. Ars Technica précise que le décodage du H.265/HEVC est pris en charge par l'unslice, ce qui signifie que lire une vidéo dans cette norme va mettre à contribution seulement une partie du GPU, et ainsi ne pas grever l'autonomie.

Du côté des API, Skylake supporte DirectX 12, OpenGL 4.4 et OpenCL 2.0. Les prochaines versions d'OpenCL et OpenGL, ainsi que Vulkan, pourront être prises en charge à l'avenir.

Des perfectionnements ont été apportés à la gestion de la mémoire. Les nouveaux GPU peuvent notamment compresser les données avant de les envoyer à la RAM, permettant ainsi de laisser plus de bande passante pour le reste. Les joueurs seront sinon contents d'apprendre qu'Intel a amélioré les performances de l'antialiasing multisample (MSAA) et ajouté une option 16x. Encore faut-il que le GPU fasse tourner convenablement le jeu avec les réglages de base pour pouvoir prétendre activer cet antialiasing.

Dans un autre article, Ars Technica explique comment Intel procède pour améliorer l'autonomie avec les processeurs Skylake.

La fonction la plus importante est Speed Shift. Elle permet une meilleure répartition des rôles entre le processeur et le système d'exploitation qui gèrent tous deux la consommation. Le processeur peut choisir tout seul et quasi instantanément (1 milliseconde) un des paliers d'utilisation en fonction de l'activité — il va augmenter la fréquence si on commence une tâche ou la baisser si l'ordinateur passe en veille. Avant Skylake, cet ajustement devait être « demandé » au système et prenait environ 30 millisecondes.

Ne reste plus qu'à vérifier si toutes ces optimisations sont visibles à l'usage. Les premiers tests de Skylake étaient mi-figue mi-raisin, mais ils concernaient des processeurs de bureau équipés de GPU GT2. Les puces qui pourraient trouver leur place dans la plupart des Mac n'ont pas encore été annoncées, mais certains modèles ont déjà fuité. Une partie devrait sortir d'ici la fin de l'année.

Vivement les procs ARM Apple qu'on y comprenne de nouveau quelque chose.

pas réaliste pour l'heure.

-

et sinon, en quoi ça sera plus simple avec ARM ? Les processeurs ARM aussi peuvent être fondu en "bloc" avec une section vidéo provenant d'un autre concepteur ou en interne, ils peuvent aussi avoir un nombre variable de coeurs, d'unités de calculs (dédiées ou non à une tâche) et bien sur ils gèrent un nombre variable d'interfaces selon ce qui est intégré dans la puce.

@oomu :

"Pas réaliste pour l heure"

Sur le plan "marche" ou "performance"?

Autant je suis d accord sur le côté "marché" un changement pareil d architecture serait un gros choc surtout pour les pro (mais bon Apple l a déjà fait avec le passage PowerPC/Intel)

Sur le plan puissance, je suis pas d accord, avec une bonne optimisation d osX (ce qui a l air d être la voie suivi avec 10.11) et une meilleure maîtrise matériel/logiciel... Ça me semble pas in-envisageable. Quand on voit la fluidité des couple iPad air2/iOS en comparaison des dernier MacBook/osX... On se dit qu avec une version allégé et optimise d osX, on est plus du tout dans de la science fiction sur 1 an (ou 2) :-)

Des Mac ARM c'est tout a fait realiste depuis quelques mois deja.

L'A8x a des performances en calcul equivalente a un core i5 de 2011/2012 et le GPU est superieur aux bouses d'Intel.

regarde le Macbook: un A8x 4 core donnerait des performances superieures a celles de cette bouse de Core-M

Pareil avec le MacMini actuel en remplacant par un core A8 avec 6 ou 8 core on aurait une machine plus performante et moins gourmande que l'actuel modele d'entree de gamme.

Pour l'iMac 21", il en va de meme

En fait avec l'A8x Apple dispose d'un processeur proche des petits Core i 5. Alors c'est certain si on compare un A8x et un Core i7 a 4Ghz, y a pas photo, mais pour le reste il est tout a fait realiste d'utiliser de l'ARM.

Apres tu peux objecter le souci de compatibilite entre le code x86 et les code ARM, car il est certain qu'il est illusoire d'esperer des bonnes performances en emultation. Mais de ce cote Apple a la solution avec Swift et les API. Du moment qu'une application est programmee avec les API et en Swift, une simple phase de compilation suffit a obtenir un soft natif sur ARM.

Avec les A10 Apple aura des processeurs non seulement énergétiquement plus efficaces que les x86, moins gourmands et moins chers. Et en plus au niveau GPU la solution ARM est bien plus souple et permet de meilleures performance que celles d'Intel.

Et ça voudra donc dire que tous les gros logiciels (Office, la suite Adobe, les logiciels Avid, etc.) ne fonctionneront sur Mac ARM que des années après leurs sorties (si les éditeurs font réellement l'effort, je vois bien Adobe abandonner).

Je ne suis pas sûr qu'Apple puisse se le permettre.

Heu tu sais qu'Office ca fonctionne sur iOS?

Tu sais combien il y a de soft d'Adobe sur iOS?

iOS c'est 95% de Mac OS, en gros les API de telephonie et la gestion de l'interface tactile différent.

Donc en fait ce qui existe sur iOS existe virtuellement sur Mac OS X sur ARM...

Adobe ne va pas abandonner un marche en croissanca alors qu'il commence a avoir de la concurence...

Apres pour Avid et les logiciels destinés aux station de travail c'est effectivement une vraie question. Il faut etre clair: Apple ne fait pas de station de travail ni de serveur et tout indique que ca ne sera pas le cas dans le futur. Apple va continuer de faire du Mac et des appareil iOS, mais si le Mac Pro beneficie d'une nouvelle generation ce sera certainement la derniere.

Donc si on dispose de soft qui tournent sur des des stations de travail, on a pas de Mac aujourd'hui. Donc faut considerer de passer a Windows ou a un *nix (Linux) sur une station Dell ou HP est avec un bon prestataire pour la maintenance.

@C1rc3@0rc :

Très bonne explication mais je te contredis sur un point.

Les GPU Intel (enfin surtout les iris) sont très bon, largement plus fiable que les CG nvidia et on une puissance de calcul supérieur au milieu de gamme (les x50m), la différence observée vient de l'utilisation de Cuda, mais si Cuda n'existe pas sur l'app' que tu utilise il n'y aura pas de différence entre un GPU Intel et et une CG nvidia.

Ça ne pose pas de problème du tout de jouer avec mon MBPR 13" qui a une iris 5100 à des jeux sorties après sa commercialisation en médium/high comme wargame red nation par exemple.

En fait a part les accidentes industriels qui ont touché certaines cartes, par exemple les NVidia 8600, les GPU NVidia, comme AMD sont tres fiables.

Lorsque un probleme arrive, la plupart du temps c'est a cause des soudures qui lient le GPU a la carte qui sont trop fines et pas assez resistantes a la montee en temperature. C'est donc a la fois un probleme de soudure (technique de soudure en surface) et de refroidissement de la machine. Masi la le problème vient donc du fabricant de la machine qui n'a pas dimensionne de maniere adequate le refroidissement.

De ce point de vue, les unites graphiques d'Intel ne courent pas ce risque. Intel definit un TDP(puissance du refroidissement nécessaire) pour le processeur entier.

Donc le fabricant de PC doit prévoir un système de refroidissement large. Et ce TDP est une valeur maximale qui additionne les productions calorifiques: celles des core, celles des unités graphiques et celles des autres composants. Il en résulte que si un truc va souffrir en premier dans un processeur, c'est d'abord les core, qui sont les plus sensibles et les plus producteurs de chaleur. Et un core ca grille avant d'avoir atteint la température dangereuse pour la soudure...

Ensuite il faut bien considerer les unites graphiques d'Intel comme bas de gamme. Or la consequence c'est que depuis 2008, seules les GPU haut de gammes sont rentables pour Nvidia et AMD. Donc ils ne font que tres peu evoluer leurs GPU bas de gamme, alors qu'Intel depense des sommes folles pour faire evoluer ses UG... consequence un HD4000(2012) est au niveau d'un 8600(2007). Une iris 5100(2014) c'est a peu pres au niveau d'une Geforce 520M V2 (2011)...

Ceci etant, il faut choisir entre la puissance CPU et la puissance graphique avec Intel, le TDP etant commun lorsque l'unite graphique tourne a fond, les core eux sont mis au repos, sinon ca frise...

@C1rc3@0rc :

Merci c'est très instructif !

Si on prend un logiciel comme Premiere Pro (même en version 2015) il utilise les API QuickTime pour une grande partie de la gestion vidéo (pas d'AV Foundation) et des pans entier du logiciel sont encore en Carbon.

Alors oui, Premiere est certainement le pire, mais les autres ne sont pas si loin.

Et tu penses qu'Adobe va réellement remettre en chantier tout son développement parce qu'Apple a décidé de changer d'architecture ?

Actuellement les clients Adobe sont plus captifs du logiciel que du système d'exploitation et avec l'abonnement CC, il suffit de deux cliques pour passer de Mac OS à Windows.

Si Apple passe sur ARM, il y a de grandes chances qu'Adobe demande à ses clients de passer sur PC/Windows.

Et la situation sera pareil pour Avid (ProTools) et pour beaucoup d'autres logiciels.

Sauf si Apple donne de vrais arguments à ces éditeurs pour un changement vers les processeurs ARM (et pas la "faible" consommation parce que ça n'intéresse que peu ces gens là).

Par contre c'est vrai, peu de soucis à ce faire pour les logiciels du Mac App Store.

Mais es-ce que le Mac peut survivre dans cette situation ?

Tu le decris tres bien, Adobe a des softs, parmi les pires, qui n'ont jamais ete vraiment mis a jours depuis la transition PowePC/Intel (2006 quand meme) mais plutot bricolés a la Flash...

Tu le dis aussi les clients Adobe sont captifs.

Oui ils le sont ou enfin ils l'etaient.

Parce que les softs qui s'attaquent aux productions d'Adobe se multiplient donnant des vraies alternatives a des gammes entières de clients qui en ont marres de se faire tondre et de devoir gerer des interfaces compliquées et archaïques.

Seuls ceux qui ont besoins des fonctions les plus pointues des softs d'Adobe sont encore sans vraies alternatives, mais ca risque de changer (notamment apres des annees d'absence on voit Canvas (http://www.canvasx.com/en/canvas-for-mac) revenir sur Mac - un avant gout avec http://www.canvasx.com/en/products/canvas-draw, alors que la cible c'est le pro sur station PC..)

Comme je l'ai deja dis les clients des stations de travail sont deja passés aux stations Windows ou Linux. Si Adobe estime que la plateforme Mac, malgre sa croissance, est toujours pas intéressante pour certains de ses softs, alors ces softs agoniseront comme Flash et les derniers a ne pas avoir compris pourront migrer sur stations HP ou Dell.

Pour le reste, le chantier est deja bien avancé. D'ailleurs avec les nouvelles restrictions securitaires de 10.11 les sales petites manies d'Adobe font que beaucoup de ses softs qui tournaient encore sous 10.10 seront incompatibles, donc meme pas la peine d'attendre les MacARM pour voir ce que va decider Adobe!

Si ca tourne sur 10.11, y a de tres grandes chances que ca tourne sur MacARM...

Et finalement pour repondre a ta question:Mais es-ce que le Mac peut survivre dans cette situation ?

Oui, il ne s'est jamais autant vendu de Mac et ca accélère.

Et aux final, la dernière chose a considérer, c'est la croissance de la puissance. Aujourd'hui une station de travail ca tourne sur Xeon (ou POWER 8), mais les x86 stagnent...

Ce que tu décris donc pour le futur des Mac c'est des iPad Pro en à peine plus évolué (ports USB et HDMI) avec ou sans écran tactile.

Ça n'est franchement pas réjouissant.

En musique, en graphisme ou en vidéo beaucoup de gens utilisent encore des Mac.

Il est plus que probable que si Apple fait fuir ces clients, ils en perdent bien plus.

Et si Apple ne fait officiellement plus de station de travail, que va-t-il advenir des logiciels comme Logic, Final Cut Pro ou Motion ?

Ils seront abandonné ?

Es-ce un bon message pour donner envie d'investir dans un Mac ?

@MickaëlBazoge :

Ah je suis pas le seul à souhaiter leur arriver?

Normalement ça devrait arriver l'année prochaine avec le doux nom de A10 (ou AX peut-être même).

A titre personnelle je pense qu'il serait bien d'attendre une année de plus mais bon...

Et pour ceux qui veulent utiliser Windows il y aura évidement un convertisseur ARM vers x86.

@fousfous :

Ça sera beaucoup beaucoup moins performant …

@Pommeduverger :

Alors la tu as complètement faux, largement même.

Compare les performances brutes des processeurs ARM Apple face aux processeurs Intel, il est pas compliqué de les dépasser.

Ben en fait la supériorité et le dépassement des x86 par les ARM est mathematique.

Si on prend la courbe d’évolution de la puissance des ARM on voit que les performances évoluent selon un facteur situé entre 1.2 et 3.8 tout les 12 mois.

De sont cote Intel voit une évolution des performances située entre -0.05 et 0.3 tout les 18 a 22 mois.

Sans oublier que la puissance par watt est supérieure et en augmentation sur ARM alors qu'elle stagne chez Intel (les x86 consomment moins parce qu'Intel ameliore la gestion electrique et met de plus en plus de composant en veille, ou en baisse la frequence dynamiquement)

Il faut aussi rajouter que l'architecture x86 est de pus en plus compliquée et cela pese sur les performances et la consommation.

Sur un x86 l'execution d'une instruction passe par 4 etages (x86 -> transcription en RISC -> ordonanceur -> execution -> transcription en x86) alors que sur un ARM c'est 2 etages (RISC -> ordonnanceur -> exécution -> RISC). Cela est tres schematique (il faut aussi prendre en compte la longueur et la complexite du pipeline, les caches, les registres internes et externes, l'utilisation des unites specialisees,...) mais d'un simple point de vue physique la complication des x86 consomme plus d'energie et implique plus de latence qu'un ARM. D'ailleur ce qui sauve le x86 c'est le fait de disposer d'un moteur RISC.

Comme tu dis, techniquement il est simple de depasser les x86: il suffit d'augmenter la puissance electrique dans les ARM!

Mais voila tous les ARM sont conçus pour consommer le moins possible et comme la consommation est le facteur déterminant du marché, ben ils ne peuvent progresser en puissance que plus lentement.

L'architecture ARM est aussi bien plus souple et ouverte que celle des x86. Ca veut dire qu'un processeur ARM peut etre adapté par un fabricant pour des choses très différentes et collaborer très efficacement avec des coproceseurs et des composants externes (GPU/DSP/..)

@MickaëlBazoge :

Ça ne devrait pas arriver tout de suite. Mon frère qui travaille pour une société de BTP qui a été choisie pour remplacer les carreaux brisés des sanitaires de l'Apple Campus, m'a dit avoir vu une grande poubelle avec des trucs électroniques avec marqué ARM dessus. D'après la description précise qu'il m'en a faite (c'est un manuel) il s'agit sans aucun doute de processeurs.

Vivement le retour des processeurs Risk PowerPc pour que le Mac redevienne ce qu'il était jadis xD

Cette fois, Windows tournera aussi sur ARM. Microsoft n'est pas fou.

Quest-ce au juste qu'une amélioration matérielle ?

une amélioration permettant d'en faire plus avec un ordinateur.

par exemple:

un processeur plus performant à alimentation équivalente

une mémoire plus rapide

une mémoire plus dense et moins chère permettant d'augmenter sa capacité

etc.

Sinon oui pour les ARM, même si on va être bon pour tout racheter. On n'aurait jamais dû en sortir, en fait.

En sortir ? vous pensez au Newton ?

Les Macs étaient sur architecture PowerPC avant. Il y a des similitude les deux architectures, mais elles sont loin d'être identique.

Techniquement il est probablement plus facile de faire un portage d'une application x86 (Intel) vers ARM que x86 vers PowerPC.

Car comme les processeurs Intel, les processeur ARM sont des processeurs Little Endian, là où les PowerPC sont Big Endian.

Les PowerPC, comme les ARM et les SPARC sont en fait indianess.

De toute facon cela ne change rien pour le passage de x86 a ARM ou PowerPC: on a un jeu d'instructions CISC totalement incompatible avec un jeu d'instructions RISC. Et en plus cela serait a considérer dans le cas d'une programmation en langage machine, voire en assembleur, mais certainement pas dans le cas d'une programmation avec un langage de haut niveau (C/ADA/Pascal) ou de tres haut niveau (Python/Java/Lisp/Swift).

De plus aujourd'hui on programme des appels a des API ou a des librairies standards qui elles sont portées et optimisées pour une architectures precise et les donnees sont codees en XML, SQL, ISO.

Donc en fait, pour une bonne partie des OS modernes et l'integralite des applications, c'est le compilateur qui va etre signifiant, et le programmeur n'a meme pas a connaitre l'architecture cible.

Pour passer sur Mac d'un soft natif x86 a un soft natif ARM, c'est une case a cocher dans Xcode et lancer la compilation.

@Le docteur

Pourquoi tout racheter ?

Tu peux être certain que Xcode est déjà prêt pour compiler à la volée n'importe quelle app pour de l'ARM. L'utilisateur lambda ne s'en rendra même pas compte.

@Sostène Cambrut

Si c'était aussi simple que ca. Tout ce qui est calcul vectoriel doit être réécrit, on passe de SSE, AVX a Neon.

Il existe des interpréteurs DirectX pour les cartes OpenGL ...

Certes, il manque des instructions, certes c'est plus lent, mais ça tourne.

Et le calcul vectorial a déjà eté réécrit pas mal de fois ces dernières années sur plate forme Apple :

Coproc arithmétique du LC3 => PowerPC 601 => PowerPC G4 (altivec 128bits sur proc 32bits) => PowerPC G5 (Altivec 64bits, ok, pas une réécriture complète, une adaptation) => Intel SSE

Donc 4 ans après la "bascule" on aura plus les arguments "Faut tout réécrire !!

On sait déjà qu'il faut tout réécrire, on ne sait pas encore en quoi.

(Je ne compte pas les CUDA et autres OpenCL dans les réécritures)

@Un Type Vrai

Je parle d'instructions SIMD pour CPU, et tu viens de me parler d'interpreteur DirectX pour les cartes OpenGL, ce qui ne veut pas dire grand chose.

Une carte OpenGL... C'est quoi une carte OpenGL ? C'est quoi une carte DirectX ?

Par contre c'est vrai qu'il existe des emulateurs qui vont convertir le code a la volée comme Wine, mais ce n'est pas la même chose.

Bah oui tu va réecrire le code SIMD, comme tu dois le réécrire quand Intel sort une nouvelle version de SSE et que tu veux profitez des nouvelles fonctions. Du code SSE2, SSE3, SSE4, AVX ou AVX2 ne s'écrit pas pareil, chaque version a des instructions spécifiques.

@Stardustxxx

Metal est là pour ça non ?

@Sostène Cambrut

Tu es en train de comparer des pommes et des oranges.

Metal est une API graphique.

SSE, NEON sont des instructions CPU.

ARM dans un MBP 15 pouces ou un Mac Pro ? Laissez-moi rire !

Ça sera sans moi.

@Thibs69 :

Et pourquoi ça te fait rire?

Un A10X 16 core a 3 ou 4 GHz ce ne serait pas assez puissant pour toi?

@Thibs69

"ARM dans un MBP 15 pouces ou un Mac Pro ? Laissez-moi rire !"

Qui sait ce que Apple est capable de proposer pour du professionnel en ARM ? Moi pas en tout cas.

"Ça sera sans moi."

Ça me rappelle quelqu'un qui disait exactement la même chose lors du passage du PPC à Intel.

Si Apple passe à l'ARM tu peux être absolument certain que le reste de l'industrie informatique fera de même. Simplement parce qu'un proco ARM coûte bien moins cher qu'un proco Intel.

@Thibs69

Deja qu'est ce qu'une machine professionnelle?

Une secretaire est une professionnelle hautement qualifiée qui a besoin de la puissance d'un MBA 2011/Mac mini 2012, au plus.

Un WEB master c'est un pro qui n'a besoin que d'un editeur de texte et un editeur bitmap qui tournent meme sur un Chromebook de base.

Si tu fais du calcul lourd ou du traitement de donnees a grande echelles, tu te fous du processeur de ta machine car derrière tu as obligatoirement des serveurs de calcul. Par contre tu as besoin d'un bon terminal bien ergonomique et reactif et la ARM ou x86 pas de différence.

Si t'es dans un cas intermediaire avec un gros besoin de puissance mais sur un poste (station de travail CAD / montage video) tu as une station de travail avec un ou deux Xeon et des gros GPU en sli. Et la tu n'utilises pas un Mac/PC windows/*nix, tu utilises 3 ou 4 logiciels tres chers pour lesquels tu as des formations aussi tres cheres et tu as un contrat de maintenance avec une societe specialisee. Donc la tu te poses meme pas la question du type de processeur dont tu disposes, c'est pas ton probleme, c'est celui de la boite que tu payes ou celui de ton employeur.

Par contre si tu es un hardcore gamer, la tu vas avoir besoin d'une tour PC avec un gros Core i7 a 4Ghz et un sli de NVidia Titan X.

dans tous les cas, quel que soit la dénomination de la machine, ce qui en fait une machine de professionnel c'est l'utilisateur. La mention Pro des Mac ne veut rien dire (a part plus cher). Et avoir un Core i7 a 4Ghz ne va pas faire de toi un pro.

C'est un poil caricatural. ;-)

Toutes les boîtes de post-prod ne sont pas Pixar, Et la réalité de beaucoup de prestataires de taille TPE/PME (et pas qu'en France), ce sont les besoins du 3ème paragraphe (station de travail), avec la réalité du 4ème (machine proche de celle des gamers, pas de société de maintenance ou de formation chère, tout ça se fait en interne).

Bon ben ca s'annonce bien tout ca: manque plus que les MacBooks autour !

L'autonomie avancée et les options de gestion plus fines du comportement des softs devraient permettre de voir venir pour les 5 prochaines années en terme d'autonomie.

Pareil pour les diverses normes de la connectique: HDMI 2, Bluetooth 4, wifi ac, USB 3....

Le temps que les réseaux et les périphériques s'adaptent et dépassent les vitesses max de ces normes, y en a aussi bien pour 5 ans (enfin pour mes usages de particulier lambda: partage de fichier en AirDrop, échange avec NAS en wifi, streaming son et vidéo, pairing iPhone et casque Bluetooth, lecture film et sortie sur TV via hdmi)

En vitesse de SSD, on est a plus a 1 GHz lecture/écriture...

Reste plus qu'à attendre...

"Les joueurs seront sinon contents d'apprendre qu'Intel a amélioré les performances de l'antialiasing multisample (MSAA) et ajouté une option 16x. Encore faut-il que la carte graphique intégrée fasse tourner convenablement le jeu avec les réglages de base pour pouvoir prétendre activer cet antialiasing."

Je comprends pas cette remarque. L'anticrénelage est toujours utile, et en particulier quand la machine n'est pas assez puissante pour faire tourner un jeu en pleine résolution. C'est d'ailleurs principalement pour ça qu'il a été développé.

deja il n'y a pas de carte graphique integree.

L'unite graphique d'Intel n'est pas un GPU, mais un coprocesseur.

Ses performances, meme si elles s'ameliorent a chaque generation, sont incomparables avec ce qu'offre un GPU independant.

Ce que l'on observe avec la generation Skylake c'est qu'Intel n'a ce coup ci pas baissé les performances pour pretendre consommer moins mais a mis en place un systeme de gestion d'alimentation electrique plus malin, qui sait exactement quoi eteindre pendant un tache donnee. De ce cote on peut que féliciter Intel d'avoir travaillé si dur a l'identification des gaspillages energetiques.

Meme si la puissance de skylake progresse peut meme par rapport a Ivybridge, c'est un processeur de la meme trempe que Sandy bridge et Ivy bridge. C'est un processeur qui va durer longtemps car il est bien conçu et qu'Intel n'aura rien a proposer de mieux dans les 3-4 ans a venir. Donc pour ceux qui ont une machine sous sandy bridge ou Ivy bridge, autant ils pouvaient faire l'impasse sur Haswell et encore plus Broadwell, autant Skylake devient interressant.

Apres, il faudrait espérer qu'Apple propose des machines avec de vrais GPU, notamment des NVidia de génération Pascal qui va arriver en début d’année.

@C1rc3@0rc

Je ne suis pas certain qu'Apple ait le moindre intérêt sur le long terme à s'équiper en Nvidia.

D'abord parce que Nvidia ne respecte pas le développement d'OpenCL pour favoriser CUDA. Alors que Apple a énormément travaillé sur OpenCL (les optimisations de FCPX, l'API Metal etc.).

Ensuite parce que Nvidia est à la carte graphique ce que Intel est au microprocesseur, un incontournable qui dicte sa loi. Et Apple n'a rien à y gagner. Apple a besoin de la souplesse de ses partenaires, parce que Apple ne partage rien. C'est une des raisons de la piètre qualité des drivers graphiques sur Mac.

La logique d'Apple est donc de s'associer à un outsider (AMD) ou quelqu'un qui lui permette de développer ses solutions (et avec Intel on peut dire qu'Apple a le champ libre).

"

La logique d'Apple est donc de s'associer à un outsider (AMD) ou quelqu'un qui lui permette de développer ses solutions (et avec Intel on peut dire qu'Apple a le champ libre).

"

Avec Intel Apple n'a rien de libre comme horizon. Le modele d'Intel c'est le diktat du x86. Intel impose ses normes quel qu'en soit le prix. Et Intel est hors du marche principal d'Apple: le mobile.

Metal, c'est bien beau mais c'est propriétaire au dernier degré et compatible avec rien. C'est le DirectX d'Apple. Faudra voir sur le terme si ca passe ou pas. Et si Apple a porté Metal sur OS X, c'est bien parce que OpenCL a echoué...

CUDA et les carte NVidia sont prises en charge prioritairement par les editeurs de softs, que ce soit GPGPU ou capacites graphiques. Si on veut faire du GPGPU on pense d'abord a NVidia, ensuite a AMD et enfin a Intel avec le XeonPhi (pas vraiment un GPGPU et dont les performances sont loin de celles des solutions NVidia)

On commence a trouver un peu d'OpenCL, mais c'est loin d'etre majoritaire, et parce qu'AMD a fait le forcing sur ces normes. Avec la mort programmee d'AMD, il va rester qui?

Intel, NVidia et les GPU graphiques pour mobile...

En plus NVidia s'est associe a IBM dans OpenPower afin d'integrer CUDA au POWER. Si le message est pas clair, que faut il?

Sans oublier que NVidia se met de plus en plus dans la trace des formats ouverts, dont OpenGL et OpenCL, ouvre ses API (exemple PhysX) et s'associe a OAA...

La question des drivers sous OS X c'est pas tellement le probleme des drivers (ce sont les editeurs qui les produisent) que les interface entre l'OS et les drivers. Pourquoi Apple, membre du Khronos Group pourtant, est infoutu de realiser OpenGL correctement sur Mac alors que sur iOS c'est a la pointe?

Et OpenCL, une creation d'Apple, c'est une belle promesse, mais sur x86 c'est pas ca. Et quand on voit la pauvrete des moyens de developpement OpenCL par rapport a la qualite des outils pour CUDA, y a pas photo.

@C1rc3@0rc

"Avec Intel Apple n'a rien de libre comme horizon. Le modele d'Intel c'est le diktat du x86. Intel impose ses normes quel qu'en soit le prix. Et Intel est hors du marche principal d'Apple: le mobile."

On s'est mal compris. Je parle des possibilités d'Apple d'optimiser ses drivers graphiques. C'est beaucoup plus simple avec Intel qu'avec Nvidia qui n'en a rien à foutre.

"Metal, c'est bien beau mais c'est propriétaire au dernier degré et compatible avec rien. C'est le DirectX d'Apple. Faudra voir sur le terme si ca passe ou pas. Et si Apple a porté Metal sur OS X, c'est bien parce que OpenCL a echoué..."

Metal c'est un mix entre OpenGL et OpenCL optimisé pour OSX et iOS. Et c'est surtout ce qui va permettre à Apple de faire la transition entre x86 et ARM. Metal est pensé pour être universel.

"CUDA et les carte NVidia sont prises en charge prioritairement par les editeurs de softs, que ce soit GPGPU ou capacites graphiques. Si on veut faire du GPGPU on pense d'abord a NVidia,"

Là je sais pas trop. Je sais juste que Ars Technica dresse un portrait assez inquiétant des performances de Nvidia sur DirectX 12 par rapport à AMD.

http://arstechnica.com/gaming/2015/08/directx-12-tested-an-early-win-for-amd-and-disappointment-for-nvidia/

"On commence a trouver un peu d'OpenCL, mais c'est loin d'être majoritaire"

Toutes les grosses stations de calcul scientifique GPGPU tournent sous Linux pourtant. Donc OpenCL.

"Pourquoi Apple, membre du Khronos Group pourtant, est infoutu de realiser OpenGL correctement sur Mac alors que sur iOS c'est a la pointe?"

Parce que Apple maitrise le Hardware sur iOS, mais pas sur OSX où c'est les constructeurs qui distribue les informations. C'est pour ça que Nvidia sur Mac a toujours très mal marché.

J'ai pas tout compris donc je ne dirai qu'une seule chose : polenta.

Mais sinon, le vrai futur de nos Mac ça pourrait pas être une collaboration entre Apple et Intel pour que le premier fasse le design des puces et que le second les fonde ?

Apple pourrait faire sa tambouille dans son coin sur une "base" bénéficiant des innovations annuelles d'Intel, et on garde la compatibilité avec ce qu'on a actuellement tout en ayant une meilleur intégration hardware/software.

@fousfous : ouais enfin on est encore à 2 cœurs à 1,2 GHz sur le nouveau MacBook, ou 4 cœurs à 2,3 GHz sur les MPB 15", même en passant à ARM il faut pas s'attendre à un tel monstre dans un futur proche.

@Kimaero :

Tu peux pas faire mieux avec du x86, l'architecture est au bout du rouleau. Et vu les faibles améliorations d'intel d'année en année et tout les retards Apple a tout intérêt de définitivement stopper sa dépendance à Intel.

D'ailleurs on pourrait voir le prix baisser sur les Mac, parce qu'untel facture ses puces au minimum 300$...

Ben Intel aurait interet a effectivement proposer un service de fondeur ARM pour Apple.

Jusqu'a la demonstration de Samsung de sa maitrise de la gravure 14nm (en avance sur Intel), on pensait que le meilleur fondeur ARM serait Intel.

Mais voila depuis il y a Samsung qui a jeté un gros pavé dans la mare avec sa maitrise et IBM qui mis un gros coup de booster dans GF en leur confiant et sa technologie et la fabrication des POWER.

Et en entree et milieu de gamme les fondeurs chinois ARM ont montre eux aussi une montee en puissance de la maitrise avec des realisations complexes et performantes.

Apres si tu veut dire une conception x86, laisses tomber. Intel est le meilleur pour concevoir des x86 et les realiser. En plus Apple a developpé une grande expertise en ARM, ce qui n'a rien a voir avec le x86. Et en plus si des tiers sous licence etendue ARM peuvent modifier enormement l'architecture (tant que le jeu d'instruction est respecte, on peut tout faire) c'est pas le cas des x86 qui est une architecture fermee (on peut rajouter des instructions mais la realisation est sous le controle absolu d'intel).

Apple ne pourrait jamais faire des modifications de l'ampleur de ce qu'elle fait avec ses Ax sur du x86.

Et de toute facon, ca n'aurait pas d'interet, car comme le dis fousfous le x86 a atteint ses limites.

Pas avant 3 ans des MacBook arm , qui seraient dans les gammes non pro.

...encodage H265 ben le v'la qui arrive...

Un cierge pour qu'Apple n'utilise pas les processeurs prévus pour les portables ultra fins dans tous les Imac.

A lire les schémas de cet article, si je comprends bien, les processeurs Intel ont quoiqu'il arrive un GPU.

Euh, question bête, pourquoi ne proposent-ils pas uniquement un processeur sans GPU afin de l'associer à une carte vidéo externe ? Réponse A : c'est trop old school. Réponse B : cela permet à Intel de se faire plus de marge. Réponse C : je t'explique...

@cv21

Parce que la majorité des cartes graphiques sont intégrées, avant c'était sur la carte mère, maintenant c'est dans le processeur.

Pour ce qui est du marché des cartes discretes, ca effectivement aucun interet d'avoir un cpu avec gpu, mais ca demanderai a Intel de produire des processeurs differents, donc d'allouer d'autre ressource pour les produire, et ce n'est pas rentable, autant qu'ils aient tous une carte graphique intégré et c'est dans l'OS ou le BIOS que l'on choisi la carte principale.

@cv21

tres bonne remarque et tres bonne question.

Oui tous les processeurs x86, a part les gros Xeon pour serveur sont flanques d'une unite graphique.

Pourquoi?

Aucune raison technique a cela, meme par rapport au thunderbolt.

En fait il faut revenir quelques annees en arrière.

Le x86 a ete developpé dans un objectif de monopole absolu.

Et Intel a reussi, tous ses concurrents ont ete laminés (principalement a coup de massues financieres). Seul AMD a reussi a survivre (il avait reussi a sauver le x86 au moment de la gabegie du Pentium 4).

Mais l'incroyable pour Intel est arrivé, avec le GPGPU.

Le GPGPU, utilisation d'une carte graphique pour le calcul, a montre que pour une classe de calcul largement utilisée, les GPU étaient infiniment plus puissants et économes que les CPU. Or Intel a toujours ete nullissime sur les GPU...

AMD et Nvidia ont commencé a sérieusement menacer Intel sur tout ses marches: PC, station de travail, serveur et supercomputer.

Face a ca Intel a tente de faire du GPGPU avec ses CPU, ca a donne un naufrage appelé Larabee.

Face a cet echec, Intel n'a rien trouvé d'autre que de tenter d'assecher AMD et NVidia en les privant du marché des GPU d'entree de gamme (source principale vu la rentabilité) en développant des coprocesseurs graphiques intégrés au processeur. Et ca a marché!

Le coprocesseur graphique d'Intel est une bouse, mais il est compris dans le prix du processeur (tres cher). Et en plus Intel a rendu l'adaptation d'un GPU externe plus complexe et couteuse sur la carte mere du PC.

Bref AMD se meurt, Nvidia est confiné a vendre du haut de gamme: les unites graphiques des x86 sont une arme économique au grand désespoir des utilisateurs.

Pages