Pourquoi la transition vers des Mac ARM est inévitable

Plus de dix ans sans transition. Quand on connait l’histoire du Mac, on sait qu’Apple fait de temps en temps des choix radicaux pour ses ordinateurs : des Mac 68k au PowerPC, du PowerPC aux puces Intel…

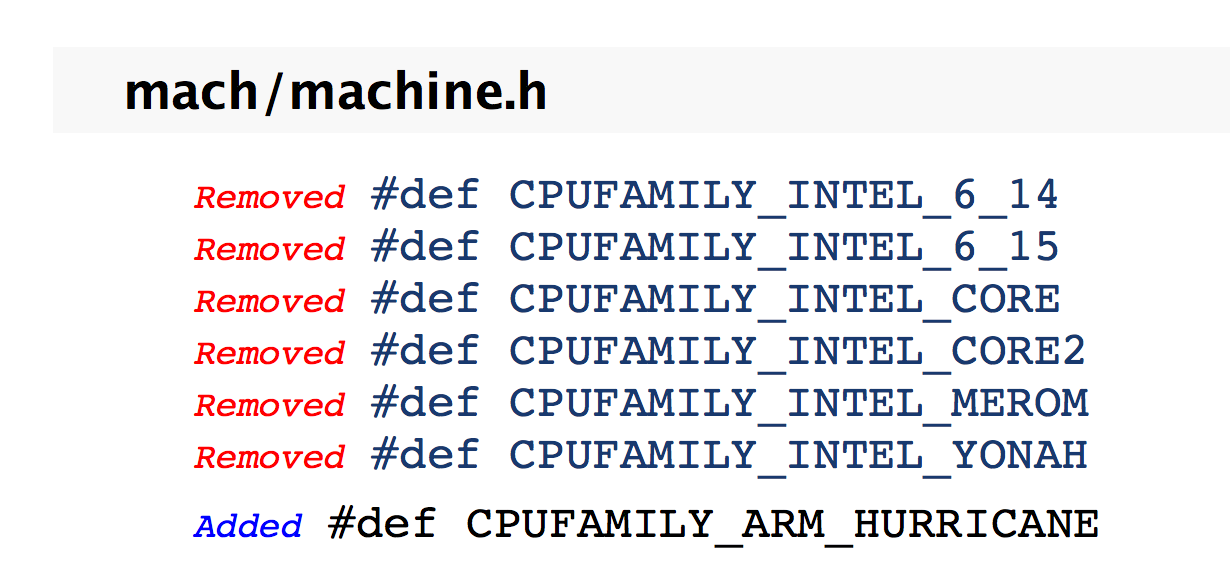

Sommes-nous à l’aube d’une nouvelle transition ? La documentation d’Apple mise à disposition des développeurs peut le laisser penser. La firme de Cupertino a pour habitude de lister toutes les différences en ce qui concerne ses API d’une version à l’autre (un procédé courant). Dans celle relative au Kernel de Sierra, Apple a ainsi retiré plusieurs références à d’anciens processeurs Intel qui ne sont plus gérés par macOS comme les puces Merom. Jusque-là, rien de bien surprenant. La vraie surprise est de constater que tout en dessous, on voit qu’elle a ajouté la prise en charge de la famille de processeurs ARM Hurricane. Ce n’est pas une puce connue, sans doute un nom de code. Hurricane signifie en anglais, rappelons-le, ouragan. Voilà qui a le mérite d’être clair.

En tout cas, comme le note iDownloadblog, ce nom de code colle bien avec les noms de code des anciennes puces d'Apple. Le petit nom de l'A7 était Cyclone, A8 Typhoon et A9 Tornade. Hurricane serait le nom de code de l'A10, d'après Hardware.fr, qui s'appuie sur les découvertes de Chipworks qui a l'habitude d'autopsier les composants des nouvelles puces d'Apple.

Qu’Apple étudie la possibilité de produire des Mac ARM, cela n’a rien d’étonnant. Cela fait maintenant quelques années qu’elle explore cette possibilité comme elle l’a fait en d’autres temps pour d’autres architectures. Mais va-t-elle passer à l’acte ?

Le très réputé Ming-Chi Kuo tablait sur de tels ordinateurs pour 2016 ou 2017 (lire : Mac ARM : dans les deux ans avec un processeur A10X ?). A l’époque, il estimait que l’A10X pourrait être le futur moteur d'un Mac ARM. Avec le recul, ses propos sont très intéressants. Les tests effectués il y a quelques jours avec Geekbench montraient que le processeur A10 Fusion de l’iPhone 7 n’avait plus grand-chose à envier en termes de puissance brute à un MacBook Air. Alors certes, Geekbench ne reflète pas forcément la réalité, mais la dynamique et la montée en puissance penchent clairement pour le camp ARM.

Pour Apple, la difficulté est avant tout matérielle contrairement aux autres transitions. D’un point de vue logiciel, elle pourrait être plus indolore pour les développeurs. La compatibilité ne devrait pas être un problème. Apple maitrise les outils de développement (du langage de programmation aux API en passant par les compilateurs), elle contrôle la distribution avec le Mac App Store et a plus qu’un pied dans le monde ARM depuis maintenant une décennie ou presque.

Pourquoi le modèle d'Intel est dépassé

La difficulté pour Apple est d’être en mesure d’avoir dans ses cartons un processeur vraiment compétitif par rapport à ce que propose la concurrence. Sachant que la complémentarité logicielle / matérielle joue à plein et au vu des scores affichés par le processeur A10, cela n’a rien d’insurmontable. Dans un tel scénario, la grande force d’Apple serait de pouvoir concevoir un processeur vraiment taillé pour faire tourner au mieux la partie logicielle.

La fin de la loi de Moore offre des perspectives intéressantes comme l’explique le chercheur Mark Pesce sur The Register. Pour lui, l’actualité des processeurs ces dernières semaines se résume à trois points :

- La prochaine génération de processeur Intel ne va pas beaucoup plus vite que la précédente (lire : Intel lance Kaby Lake, la 7e génération de processeurs Core) ;

- Intel a pris beaucoup de retard sur la gravure en 10 nm (lire : Intel retoque son Tick-Tock) ;

- La puce A10, que l’on retrouve dans l’iPhone 7, est un processeur très rapide.

D’après Mark Pecse, la formule qui a fait le succès d’Intel ne fonctionne plus. La seule chose dont le monde a besoin, c’est : "toujours plus de transistors, et des transistors toujours plus petits". Cette formule a fait le succès de la plateforme Wintel, mais elle n’est plus pertinente à l’heure actuelle.

Ces cinq dernières années, Apple n’a eu de cesse d’avoir toujours plus de contrôle sur le matériel dans ses terminaux, et a amélioré de manière spectaculaire le niveau de performance de ses processeurs : un facteur de 12 sur ces cinq dernières années. Mais contrairement à Intel, cette progression ne vient pas du fait (ou pas seulement) de l'utilisation d'un nombre toujours plus élevé de transistors, lesquels sont toujours plus petits. Si ces puces progressent en efficacité, c’est parce qu’Apple utilise uniquement les transistors dont elle a besoin dans ses tablettes. Et c’est là où tout commence pour Apple.

Nous sommes entrés dans une ère où logiciel et matériel se confondent de plus en plus. La puce A10 est optimisée à fond d’un point de vue matériel pour travailler efficacement avec le noyau d’iOS sur la gestion d’énergie.

Pour le co-inventeur du VRML qui écrit de temps à autre pour The Register, le matériel va dans les prochaines années happer le logiciel. La frontière entre les deux sera de plus en plus ténue. Et cette maitrise du logiciel et du matériel, cette fusion même, est sans doute l’un des gros points forts d’Apple actuellement.

Pour le dire autrement et plus simplement, on entre dans l’ère du sur-mesure en matière de système-sur-puce, alors que jusqu’à présent, on faisait du prêt-à-porter.

Si Apple est sans doute en pointe dans le domaine, c’est loin d’être un cas isolé. De plus en plus d’acteurs s’y sont mis, notamment Microsoft et Google (lire : Comme Apple, Google voudrait son propre processeur).

Cette évolution explique sans doute le retournement d’Intel cet été. Le géant des semi-conducteurs a annoncé son intention de fabriquer à nouveau des processeurs ARM pour les produits mobiles (lire : Intel va fabriquer des processeurs ARM pour les constructeurs de produits mobiles). Mais n’est-ce pas déjà trop tard ? Le risque pour Intel n’est pas de disparaitre, mais de devenir un vulgaire sous-traitant se pliant au cahier des charges de ses partenaires.

Enfin, si en 2017 on voit vraiment des Mac ARM apparaitre sur le marché, on comprendra rétrospectivement pourquoi 2016 a été si calme sur ce front chez Cupertino.

@_Teo_

Plutôt de strictement ne rien y comprendre dans le cas de notre camarde ;-)

@awk :

Ah définitivement nécromancie alors : )

x86 ou ARM sont des architectures en fin de course. La raison, la loi de Moore qui arrive a sa fin.

D'ici 5 ans, il n'y aurat plus beaucoup de progrès en finesse de gravure.

La solution : processeur Neuromorphique, memristors, architecture memoire radicalement différente.

IBM a fait fonctionner des réseaux de Deep Learning sur un de leur chip Neuromorphique avec des résultats dépassant les espérances. Un processeur TrueNorth consomme 100mW pour 5.4 milliards de transistors.

Dans ce cas, Macg a déjà écrit le début de son futur article !

"Quand on connait l’histoire du Mac, on sait qu’Apple fait de temps en temps des choix radicaux pour ses ordinateurs : des Mac 68k au PowerPC, du PowerPC aux puces Intel…" et Arm.

@Stardustxxx

"Les prévisions sont difficiles, surtout lorsqu’elles concernent l’avenir"

Pierre Dac

Si tu savais en une quarantaine d'année le nombre de fois où j'ai lu l'annonce tonitruante de la mort éminente d'une technologie et de même celle de la pure explosion d'une autre approche qui va tout rendre obsolète. :-)

Quant à la loi empirique de Moore, il ne faut pas en faire l'Alpha et l'Omega de ces questions.

@awk

""Les prévisions sont difficiles, surtout lorsqu’elles concernent l’avenir"

Pierre Dac"

Absolument, mais cela n'empeche pas de prevoir les tendances.

Pour la loi de Moore, il y a des contraintes physiques, donc on sait qu'elle va se terminer. Ca coute de plus en plus cher de diminuer la finesse de gravure avec des gains de plus en plus faible. Il reste 3 finesse de gravure avant d'atteindre les limites physiques du Silicium (10, 7 et 5nm).

Un fois a 5 nm ca va etre difficile d'augmenter la performance des CPU. Augmenter le nombre de transistor ne fonctionne pas, tu rentres dans des problemes de propagation d'horloge.

De plus Google, Microsoft et autres utlisent deja des "processeurs customs" : TensorFlow pour le Deep Learning ou bien des FPGA pour accelerer Bing. Pourquoi parce que l'architecture des CPU actuel n'est pas adapté pour cela.

Le Deep Learning est en train de revolutionner l'informatique moderne : Google, IBM, Facebook, Microsoft, Baidu l'utlisent tous, et investissent a fond dedans. Plusieurs compagnies travaille sur des processeurs qui implementent des reseau de neurones, IBM a meme prouve l'efficacite de leur processeur neuromorphique pour executer des reseaux de neurones avec des resultats impressionants.

Samsung a associe un reseau de neurone avec un capteur video pour augmenter les performances de facon considerable.

Comme précisé dans l'article il est très probable que nous ayons des chips de plus en plus spécialisé, mais il faudrait toujours un cpu pour coordonner tout le monde.

Donc oui je considère que ce ne sont pas les architectures actuelles x86 ou ARM qui permettrons des gains significatif en terme de puissance ou d'efficacité énergétique, par contre les processeurs neuronales et les processeurs quantiques sont nettement plus prometteur.

Rappelons q'un cerveau humain consomme 20W, cela prouve l'efficacité des réseaux de neurone ;)

@Stardustxxx

Sur les tendances que tu esquisses on ne peut évidement qu'être en accord.

La loi empire de Moore touche son asymptote, je dirais enfin tant elle est annoncé depuis longtemps ;-)

Le deep-learning a le vent en poupe et bien des acteurs, à commencer d'ailleurs par Nvidia, y consacre,t beaucoup de moyens.

Après sur tous ces enjeux, je ne vois pas de révolutions sur nos machines de tous les jours dans un avenir de quelques années, mais ce n'est peut-être que le produit d'une vue trop courte ;-)

Ce que tu évoques est pour moi encore pour longtemps du ressort des entreprises et de produit grand public qui n'auront pas vocation à se substituer à nos ordinateurs tel les véhicules autonomes par exemple.

@awk

Pour la loi de Moore, sa fin est connu depuis longtemps, c'est une question de contrainte physique. Cette contrainte n'a pas changé. ;)

Mais cela veut aussi dire que dans 5 ans le seul moyen d'augmenter la puissance des processeurs devrait venir d'une autre technologie. 5 ans c'est tres court. Et quand on voit les progrès effectuer sur des réseaux de neurone en silicium, d'ici 5 ans on devrait aussi avoir des joli gains.

Un co processeur neuronale sur un téléphone permettrait de faire la classification de photos sur le téléphone de façon ultra efficace. Pour rappel iOS fait 3 milliards d'opération par photos pour les analyser sur leur dernier iPhone.

On peut aussi imaginer que les cpu ARM ou Intel intégre des réseaux de neurone pour certaines partie. Par exemple pour le prédicteur de branche (je crois avoir lu que certains constructeurs etaient deja en train de tester cela), un reseau de neurone pourrait etre particulièrement efficace.

Tout cela pour dire que o

@Stardustxxx

"Pour la loi de Moore, sa fin est connu depuis longtemps, c'est une question de contrainte physique. Cette contrainte n'a pas changé. ;)"

Si tu regarde l'histoire de la micro-électronique l'horizon infranchissable de la poursuite de l'intégration a été annoncé de très nombreuse fois depuis au moins les années 80 :-)

Et à chaque fois des solutions techniques ont été trouvée, mais là effectivement on touche vraiment le mur :-)

@Stardustxxx

Je ne connais pas ton âge, mais tu es peut-être trop jeune pour avoir connu par exemple la révolution annoncée du passage du Silicium à l'Arséniure de gallium.

Où celle très médiatisée en son temps des mémoire à bulles et j'en passe ;-)

@awk

Pour avoir étudié les semi-conducteurs au debut des années 90, j'ai entendu les promesses de l'AsGa.

J'ai aussi vécu le mur de l'augmentation de la fréquence des CPU. Qui prouve d'ailleurs que tout a une limite, et que l'on ne peut pas augmenter linéairement sans limite.

Pour les CPU traditionels, une fois les limites de gravure atteinte, les possibilité d'augmentation de puissance seront limités. Des design radicalement différents seront nécessaire.

@Stardustxxx

Il semble que nous ayons vécus les mêmes époques ;-)

@Stardustxxx

"Mais cela veut aussi dire que dans 5 ans"

Si tu es sur de telles horizon cela me semble effectivement plus qu'envisageable d'avoir des applications du deep-learning sur des produits de masse d'informatique personnelle basé sur des circuits dédiés.

Je suppose que tu as vu l'emphase stratégique que met Nvidia sur ce type d'enjeux, c'est clairement pour eux le relais de croissance à ne pas rater.

@awk

Il y a un an je n'aurais pas pensé cela. Mais en voyant en progrès effectué depuis, l'arrivée de plusieurs processeur basé sur des neurones, les avancées de nVidia avec les CPU pour voiture autonome et les résultats quand on associe hardware et software.

Sans compter les compagnies derrière cela : Samsung, nVidia, IBM, Google, Microsoft, Facebook...

Même Apple est dans le deep learning avec Siri, Mail, Plan, combien de temps avant qu'ils produisent leur propre chip.

En medecine, le deep learning prouve son efficacité dans beaucoup de domaine, dont la détection de cancer.

La classification d'image de facon automatique va etre un standard très rapidement, et ca va se faire sur le téléphone de facon automatique. Tout le monde veut pouvoir trier ses photos de facon automatique et pouvoir les chercher de facon plus naturel.

Bref, le deep learning, avec le blockchain, est la prochaine révolution informatique, et elle deja en marche. Donc oui d'ici 5 ans je pense que ces technologies commenceront a être intégrées dans nos téléphones (au moins ceux qui seront haut de gamme), dans 10 ans elles seront totalement démocratisées.

@Stardustxxx

Oui ça bouge assez vite et à un horizon de 5 ans je ne serais pas surpris de l'arrivée de produit B2C intégrant ce type de technologie, peut-être même un peu avant.

Ce qui est aussi intéressant c'est de constater que pour une fois ce ne sont pas les usages de l'informatique personnel qui sont le moteur des perspective de marché porteur provoquant de lourds investissement.

Mais les énormes perspective économique qu'ouvre la transition vers la locomotion autonome.

Est ce que l'informatique quantique arrivera bien assez vite pour reduire a nean les efforts fournis dans l'architecture ARM?

@Paquito06

nop

@awk :

Glop?!

@Pieromanu

nop

@awk :

Nop, ça ne veut rien dire. Nope veut dire quelque chose.

@Pieromanu

"Nop, ça ne veut rien dire"

Ton manque de culture informatique est consternant, NOP c'est le mnémonique pour No Operation, sur une discussion consacré au CPU c'est un usage plutôt amusant :-)

En gros le message est il faudra bien des cycles avant que l'informatique quantique soit là.

nop

@_@

Tombe le masque Sheldon, on t-as reconnu!

@Paquito06

Non, les ordinateurs quantiques résolvent d'autre type de problèmes.

Pour casser des clés d'encryption, ils sont pas mal par contre.

En tout cas Intel sait qu'il doit redoubler d'efforts, s'il veut éviter ceci ..... Tout le contraire de l'absence de concurrence dans le duopole Wintel ... qui est la cause de sa stagnation ....

@umrk

On a enfin l'explication simpliste que nous attendions tous, merci.

Et en terme tarifaire, ca pourrait avoir un effet?

@remids

yep

cf : supra

Dans une autre news vous dites que le processeur de l'iPhone 7 n'a rien à envier à un MacBook Air

Donc le processeur mobile le plus puissant au monde actuellement, arrive quasiement au niveau de Core Ix Ultra Low Voltage obsolètes.

Et c'est ce genre de merde qu'on devrait retrouver dans un Macbook Pro?

Faut se rendre à l'évidence. Rien chez ARM ne peut concurrencer un gros Core i7 non bridé.

Au pire ils mettrons les processeurs ARM dans leur espèce de démonstration technologique inutilisable là, le MacBook, mais pour les autres ......

@TmrFromNO :

Le MacBook Pro est le dernier avatar d'une époque révolue avec l'apparition des MacBook Air. Qui eux fait ce pour quoi ils sont désignés : la mobilté.

Plus légère et simple.

Si on désire de la puissance on prend un MAC Pro.

Un Mac Pro portable, absolument...

Les stations de travail mobiles sont encore utiles. Seul le MacBook Pro 15 en est une chez Apple.

Et avant qu'un processeur ARM délivre la puissance d'un Gros quadcore I7, on aura remarché sur la lune.

Les iPhones, iPad Pro et ibidules sont-ils moins cher? De passer à l'Arm ne coûterait pas moins cher donc.

@mfams :

Tout ces produits ont toujours tourné avec Arm. Difficile donc de faire la comparaison...

@ludmer67 :

Oui, je sais. Je ne disais que les Mac sous Arm ne seraient pas moins cher.

@mfams

Oui au niveau des tarifs pratiqué Intel est un fournisseur assez gourmand.

Question toute simple : nous, on y gagne quoi ?

@stemou75

Un retour à plus d'inventivité sur l'offre

Aujourd'hui, Intel en terme de puissance brute, est encore largement devant, quoi qu'en dise Geekbench dont il faut se méfier et qui pour certains semble constituer une sainte bible.

A l'époque ou Apple est passé du PPC au x86, Intel était déjà devant, ce qui a permis de pouvoir utiliser Rosetta sans casse.

Reste à voir comment va se dérouler la transition pour ceux qui utilisent leur machine pour faire autre chose que la sainte trinité iTunes / Safari / Mail.

J'avoue que je suis inquiet et pas emballé à l'idée. Mais je ne demande qu'à changer d'avis.

@NestorK

Pour le commun des usages nous ne sommes vraiment pas loin d'avoir largement ce qu'il faut avec les ARM en prenant une bonne marge de sécurité.

Si transition il y a je ne la voit pas advenir brutalement sur l'ensemble de l'offre mais par exemple sur une machine de type MacBook

@Nestork

Si j'utilise Safari et Mail, je dois aussi utiliser des logiciels orientés création graphique et vidéo. L'idée d'un nouveau bouleversement ne m'emballe pas non plus mais malheureusement, plus je lis d'infos sur l'évolution de la présence de ARM dans tous les domaines liés à l'informatique, plus je trouve le titre de MacG juste.

Même si je partage l'avis de awk sur un étalement dans le temps si Apple est le premier à dégainer son ordi sur ARM, avec toutes les incompatibilités que cela risque d'entrainer sur plusieurs mois, la perte de confiance risque d'être renforcée.

Cependant, maigre consolation, je suis tombé sur cela :

NVIDIA a ses propres processeurs ARM et ils intègrent CUDA ! Les capacités 4K à 60p, H265 sont déjà là. Ce n'est probablement pas aussi performant qu'une carte graphique 1080 mais pour des processeurs vendus pour les secteurs de l'automobile et de l'embarqué, j'aimerais déjà avoir ça sur un iMac de 2016 ! Avec les logiciels qui vont avec :))

http://www.nvidia.fr/object/tegra-x1-processor-fr.html

Inévitable ?

Pour ? Pour nous enfermer toujours plus dans le cage dorée d'Apple ?

Pour nous faire entièrement changer notre logithèque ? Nous enfermer dans les quelques logiciels Apple ?

Rendre notre Mac entièrement incompatible avec le reste du monde informatique ?

Nous retrouver avec des Macs toujours plus fins, toujours plus collées, irréparables, indémontables ? Jetable ?

Non, merci.

[modéré]

FI

Intéressant tout ca ....

Vu la puissance de hurricane , avec 4 hurricane ca doit dépoter sec et avec un gpu encore meilleur ce sera cool

Après ca veut peut être dire un ipad pro sous os x version arm ?

Suis néophyte mais Si on peut m expliquer.

Si un A10 est aussi puissant et Si petit pour faire de l'iPhone une machine aussi puissante qu'un mba qu est ce qui empêche d en coller 4 (ou plus) dans un mac?

@joshual

"qu est ce qui empêche d en coller 4 (ou plus) dans un mac"

Pas aussi simple que ça, on le voit avec la multiplication des coeurs sur les CPU, pas si simple dans tirer parti au quotidien hors tâches spécifiques.

S'il suffisait de multiplier les unités de calcul pour gagner en performance sur tous les usages ce serait fabuleux.

9 femmes ne font pas un enfant en 1 mois

dans ce cas il faudrait une compatibilité entre les deux "systeme" a mon sens mais pas sur que ce soit bénéfique pour les ventes !!

Faire un os compatible mac (imacOs ) et iPad pro ?

Je n'y crois pas : trop de compromis pour l'un et pour l'autre...

@bbtom007

Aucun sens macOS c'est du paradigme Wimp, iOS c'est du multitouch

Intel racheté par Microsoft d'ici quelque années ?

@kinou_

Qu'en ferait-il ?

Pages