Plus de dix ans sans transition. Quand on connait l’histoire du Mac, on sait qu’Apple fait de temps en temps des choix radicaux pour ses ordinateurs : des Mac 68k au PowerPC, du PowerPC aux puces Intel…

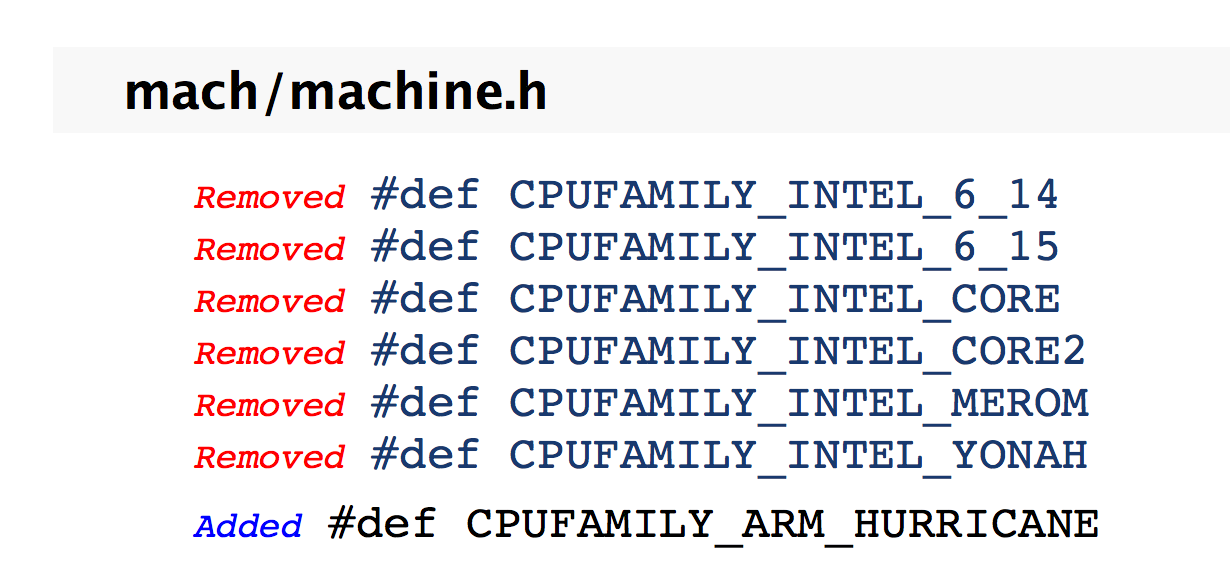

Sommes-nous à l’aube d’une nouvelle transition ? La documentation d’Apple mise à disposition des développeurs peut le laisser penser. La firme de Cupertino a pour habitude de lister toutes les différences en ce qui concerne ses API d’une version à l’autre (un procédé courant). Dans celle relative au Kernel de Sierra, Apple a ainsi retiré plusieurs références à d’anciens processeurs Intel qui ne sont plus gérés par macOS comme les puces Merom. Jusque-là, rien de bien surprenant. La vraie surprise est de constater que tout en dessous, on voit qu’elle a ajouté la prise en charge de la famille de processeurs ARM Hurricane. Ce n’est pas une puce connue, sans doute un nom de code. Hurricane signifie en anglais, rappelons-le, ouragan. Voilà qui a le mérite d’être clair.

En tout cas, comme le note iDownloadblog, ce nom de code colle bien avec les noms de code des anciennes puces d'Apple. Le petit nom de l'A7 était Cyclone, A8 Typhoon et A9 Tornade. Hurricane serait le nom de code de l'A10, d'après Hardware.fr, qui s'appuie sur les découvertes de Chipworks qui a l'habitude d'autopsier les composants des nouvelles puces d'Apple.

Qu’Apple étudie la possibilité de produire des Mac ARM, cela n’a rien d’étonnant. Cela fait maintenant quelques années qu’elle explore cette possibilité comme elle l’a fait en d’autres temps pour d’autres architectures. Mais va-t-elle passer à l’acte ?

Le très réputé Ming-Chi Kuo tablait sur de tels ordinateurs pour 2016 ou 2017 (lire : Mac ARM : dans les deux ans avec un processeur A10X ?). A l’époque, il estimait que l’A10X pourrait être le futur moteur d'un Mac ARM. Avec le recul, ses propos sont très intéressants. Les tests effectués il y a quelques jours avec Geekbench montraient que le processeur A10 Fusion de l’iPhone 7 n’avait plus grand-chose à envier en termes de puissance brute à un MacBook Air. Alors certes, Geekbench ne reflète pas forcément la réalité, mais la dynamique et la montée en puissance penchent clairement pour le camp ARM.

Pour Apple, la difficulté est avant tout matérielle contrairement aux autres transitions. D’un point de vue logiciel, elle pourrait être plus indolore pour les développeurs. La compatibilité ne devrait pas être un problème. Apple maitrise les outils de développement (du langage de programmation aux API en passant par les compilateurs), elle contrôle la distribution avec le Mac App Store et a plus qu’un pied dans le monde ARM depuis maintenant une décennie ou presque.

Pourquoi le modèle d'Intel est dépassé

La difficulté pour Apple est d’être en mesure d’avoir dans ses cartons un processeur vraiment compétitif par rapport à ce que propose la concurrence. Sachant que la complémentarité logicielle / matérielle joue à plein et au vu des scores affichés par le processeur A10, cela n’a rien d’insurmontable. Dans un tel scénario, la grande force d’Apple serait de pouvoir concevoir un processeur vraiment taillé pour faire tourner au mieux la partie logicielle.

La fin de la loi de Moore offre des perspectives intéressantes comme l’explique le chercheur Mark Pesce sur The Register. Pour lui, l’actualité des processeurs ces dernières semaines se résume à trois points :

- La prochaine génération de processeur Intel ne va pas beaucoup plus vite que la précédente (lire : Intel lance Kaby Lake, la 7e génération de processeurs Core) ;

- Intel a pris beaucoup de retard sur la gravure en 10 nm (lire : Intel retoque son Tick-Tock) ;

- La puce A10, que l’on retrouve dans l’iPhone 7, est un processeur très rapide.

D’après Mark Pecse, la formule qui a fait le succès d’Intel ne fonctionne plus. La seule chose dont le monde a besoin, c’est : "toujours plus de transistors, et des transistors toujours plus petits". Cette formule a fait le succès de la plateforme Wintel, mais elle n’est plus pertinente à l’heure actuelle.

Ces cinq dernières années, Apple n’a eu de cesse d’avoir toujours plus de contrôle sur le matériel dans ses terminaux, et a amélioré de manière spectaculaire le niveau de performance de ses processeurs : un facteur de 12 sur ces cinq dernières années. Mais contrairement à Intel, cette progression ne vient pas du fait (ou pas seulement) de l'utilisation d'un nombre toujours plus élevé de transistors, lesquels sont toujours plus petits. Si ces puces progressent en efficacité, c’est parce qu’Apple utilise uniquement les transistors dont elle a besoin dans ses tablettes. Et c’est là où tout commence pour Apple.

Nous sommes entrés dans une ère où logiciel et matériel se confondent de plus en plus. La puce A10 est optimisée à fond d’un point de vue matériel pour travailler efficacement avec le noyau d’iOS sur la gestion d’énergie.

Pour le co-inventeur du VRML qui écrit de temps à autre pour The Register, le matériel va dans les prochaines années happer le logiciel. La frontière entre les deux sera de plus en plus ténue. Et cette maitrise du logiciel et du matériel, cette fusion même, est sans doute l’un des gros points forts d’Apple actuellement.

Pour le dire autrement et plus simplement, on entre dans l’ère du sur-mesure en matière de système-sur-puce, alors que jusqu’à présent, on faisait du prêt-à-porter.

Si Apple est sans doute en pointe dans le domaine, c’est loin d’être un cas isolé. De plus en plus d’acteurs s’y sont mis, notamment Microsoft et Google (lire : Comme Apple, Google voudrait son propre processeur).

Cette évolution explique sans doute le retournement d’Intel cet été. Le géant des semi-conducteurs a annoncé son intention de fabriquer à nouveau des processeurs ARM pour les produits mobiles (lire : Intel va fabriquer des processeurs ARM pour les constructeurs de produits mobiles). Mais n’est-ce pas déjà trop tard ? Le risque pour Intel n’est pas de disparaitre, mais de devenir un vulgaire sous-traitant se pliant au cahier des charges de ses partenaires.

Enfin, si en 2017 on voit vraiment des Mac ARM apparaitre sur le marché, on comprendra rétrospectivement pourquoi 2016 a été si calme sur ce front chez Cupertino.