Maintenant que le processeur M1 est largement utilisé, il ne fait pas de doute qu'Apple a gagné son pari. Son processeur est aujourd'hui unanimement salué, et pas seulement dans le monde Apple. À part Intel, tout le monde s'accorde sur le fait que le système sur puce M1 est habilement conçu, puissant, économe, et particulièrement bien mis à profit par macOS et ses technologies. Et pourtant, il reste de belles marges de manoeuvre pour des améliorations que nous verrons sans doute apparaître au cours des prochains mois.

Le processeur M1, le plus petit des Apple Silicon

Aujourd'hui, le processeur M1 est au sommet de la gamme Apple Silicon. Il est le caïd de la famille, plus gros et plus fort que ses petits frères A13 et A14 embarqués dans les gammes iPad et iPhone. Et il n'a même pas peur d'aller se bagarrer dans la cour des grands. Mais viendra un temps où l'on se souviendra avec nostalgie de ce petit nouveau.

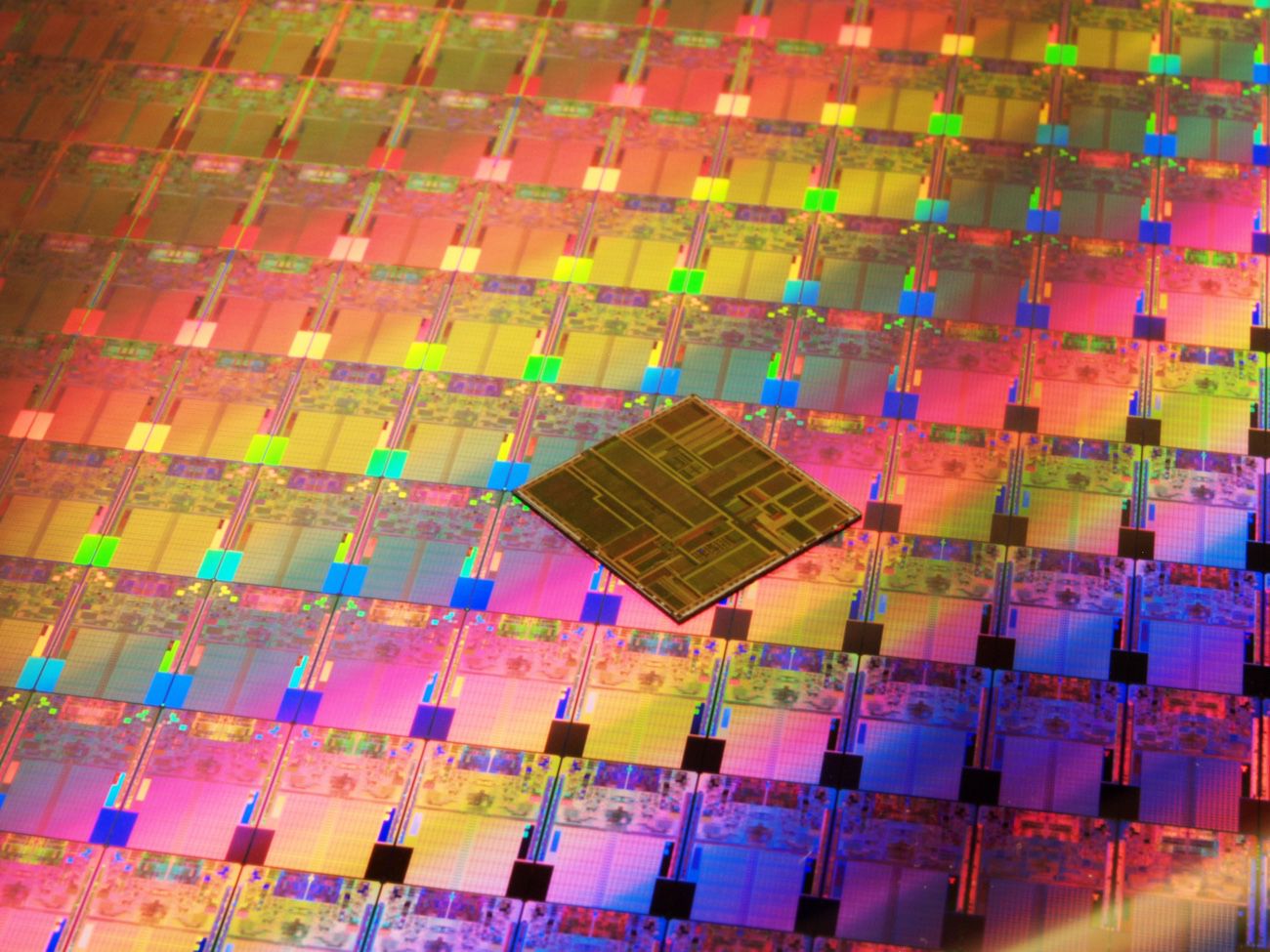

Car sur le papier, comparé aux processeurs qui équipent les autres ordinateurs, le M1 n'est pas si impressionnant. Pour commencer, il est tout petit. À peine 120 millimètres carrés, soit un ongle de pouce. L'Intel Core i9 de l'iMac est presque deux fois plus gros, et le Xeon du Mac Pro, six fois plus gros. Autrement dit : Apple peut sans difficulté envisager d'étendre son processeur pour y caser plus de cœurs, plus de mémoire cache, et plus de mémoire vive…

En termes de consommation, c'est aussi le petit poucet des processeurs du moment. Un Mac mini à fond la caisse consomme moins de 40 watts, tout en chatouillant l'iMac Pro qui en consomme 370. Apple n'est donc pas limitée par cet aspect. En quelque sorte, la gamme Apple Silicon permet à la marque de repartir d'une feuille presque blanche, sans contrainte particulière.

Il n'y a guère que sur la question de la cadence d'horloge qu'Apple n'a pas lésiné sur les moyens. Son premier processeur est directement calé sur une fréquence de 3,2 GHz, loin d'être ridicule au milieu de ses concurrents. Mais cette fréquence est atteinte avec une finesse de gravure de 5 nanomètres, qui doit offrir une marge que l'on ne connaît pas encore, puisqu'Apple est la première à s'y aventurer. On sait cependant qu'AMD dépasse cette fréquence avec la quasi-totalité de sa gamme Ryzen pourtant gravée en 7 nm. Et Intel, qui n'a peur de rien, parvient à maîtriser son i9 en 14 nm à près de 5 GHz.

Reste la question du coût. Là encore, il faut mettre tout le monde à l'aise : il y a de la marge. Un cadre d'IBM s'est lancé dans une estimation du coût du M1 pour Apple et pense pouvoir affirmer que chaque M1 coûte environ 50 $ à fabriquer. Apple a en quelque sorte internalisé le coût du développement de ce processeur, qui était auparavant facturé par Intel. Si elle doit maintenant payer elle-même les ingénieurs qui mettent au point ses processeurs, elle empoche en contrepartie une partie des copieux bénéfices qu'Intel engrangeait année après année.

M1, ce processeur dont on ne sait presque rien

Ce qui complique l'exercice de divination auquel je me prête aujourd'hui, c'est qu'on en sait relativement assez peu sur les spécifications techniques du processeur M1, malgré le travail d'analyse de l'A14 par Anandtech. Apple ne travaille que pour elle-même, contrairement à Intel, et n'a donc divulgué que les informations strictement nécessaires.

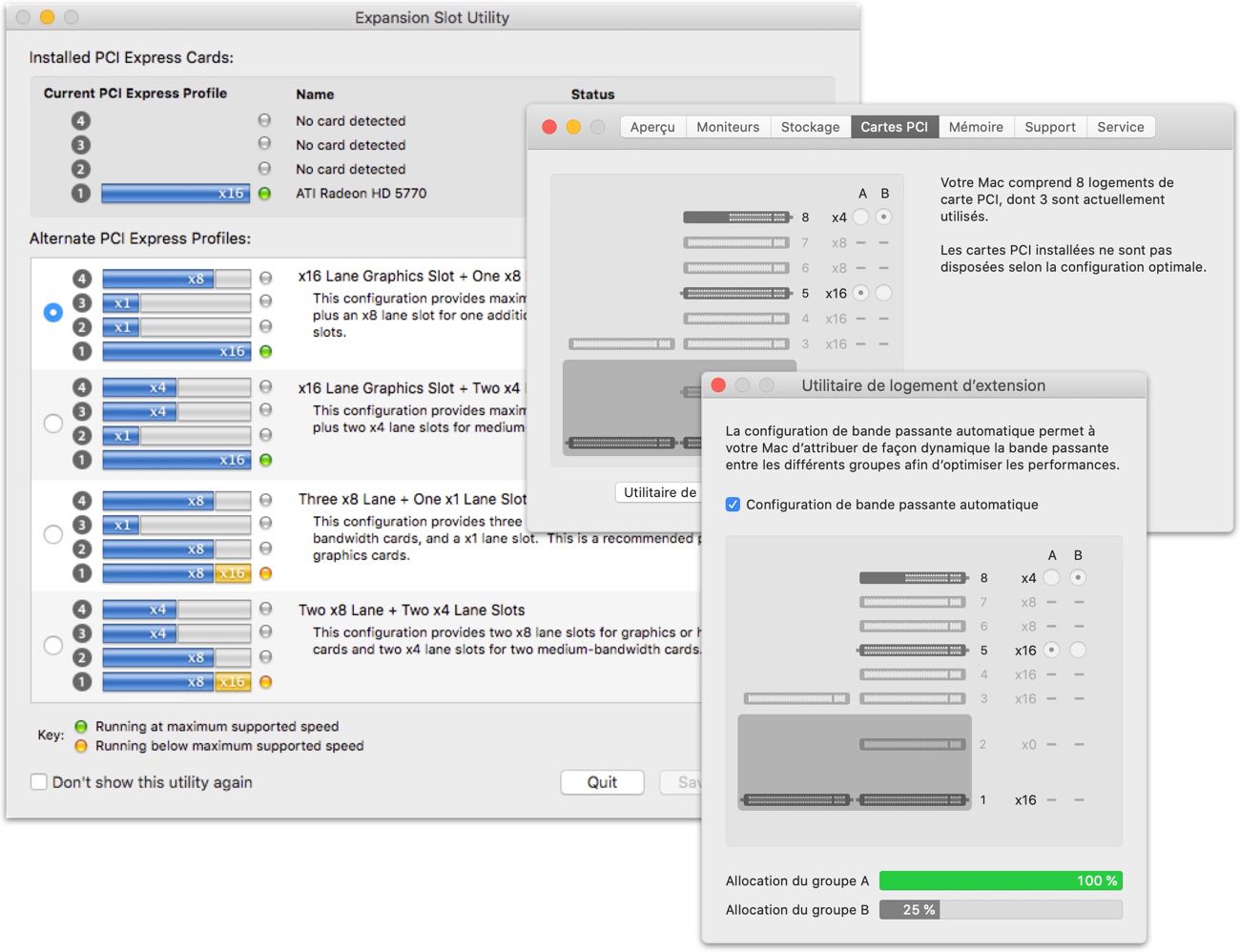

Parmi les éléments manquants, on ignore tout de la dotation en lignes PCIe des processeurs Apple Silicon. Jusqu'à présent, cette donnée n'avait que peu d'importance, que ce soit pour l'iPhone, totalement fermé, comme pour le Mac mini et le MacBook Air, dont les capacités d'extension se résument à quelques ports Thunderbolt. D'autant plus que, rappelons-le, le processeur M1 intègre la partie graphique, qui occupait auparavant plusieurs lignes PCIe (généralement, quatre lignes pour une petite carte graphique, mais jusqu'à vingt-quatre pour chaque carte AMD Radeon Pro Vega II Duo du Mac Pro 2019).

En intégrant la puce graphique à son système sur puce, Apple a sans doute pu réduire le nombre de lignes PCIe gérées par son système. Mais dans le même temps, on a vu grimper les exigences du Thunderbolt, au point que sa version 4 exige que chaque port dispose d'une capacité PCIe de 32 Gbit/s. Apple tente actuellement de noyer le poisson en n'annonçant pas officiellement de compatibilité avec le Thunderbolt 4. Elle ne pourra pas éternellement rester sur cette ligne.

Une partie de la réponse est peut-être dans le PCIe 4.0. Cette nouvelle version qui se démocratise depuis deux ans double le débit de chaque ligne, permettant ainsi d'économiser des ressources. On ne sait pas encore avec certitude si le processeur M1 gère cette nouvelle version de la norme, mais ce serait une solution pour offrir sans difficulté le niveau de connectivité des anciens Mac sans nécessiter autant de lignes physiques. Mais il y a un bémol : le PCIe 4.0 est surtout une version accélérée de la version précédente, avec peu d'optimisations. Ses composants chauffent donc beaucoup plus que ses prédécesseurs, ce qui est un frein à une adoption massive dans les petites configurations M1.

Pourquoi Apple ne proposera bientôt plus de carte graphique

Cette intégration d'un nombre croissant de fonctions au sein d'une seule puce est un mouvement de fond pour Apple. Le mouvement originel du « tout soudé » n'était qu'un début, avant la phase du « tout en un ». Il y a fort à parier que les gammes iMac et MacBook Pro se passent définitivement de cartes graphiques dédiées.

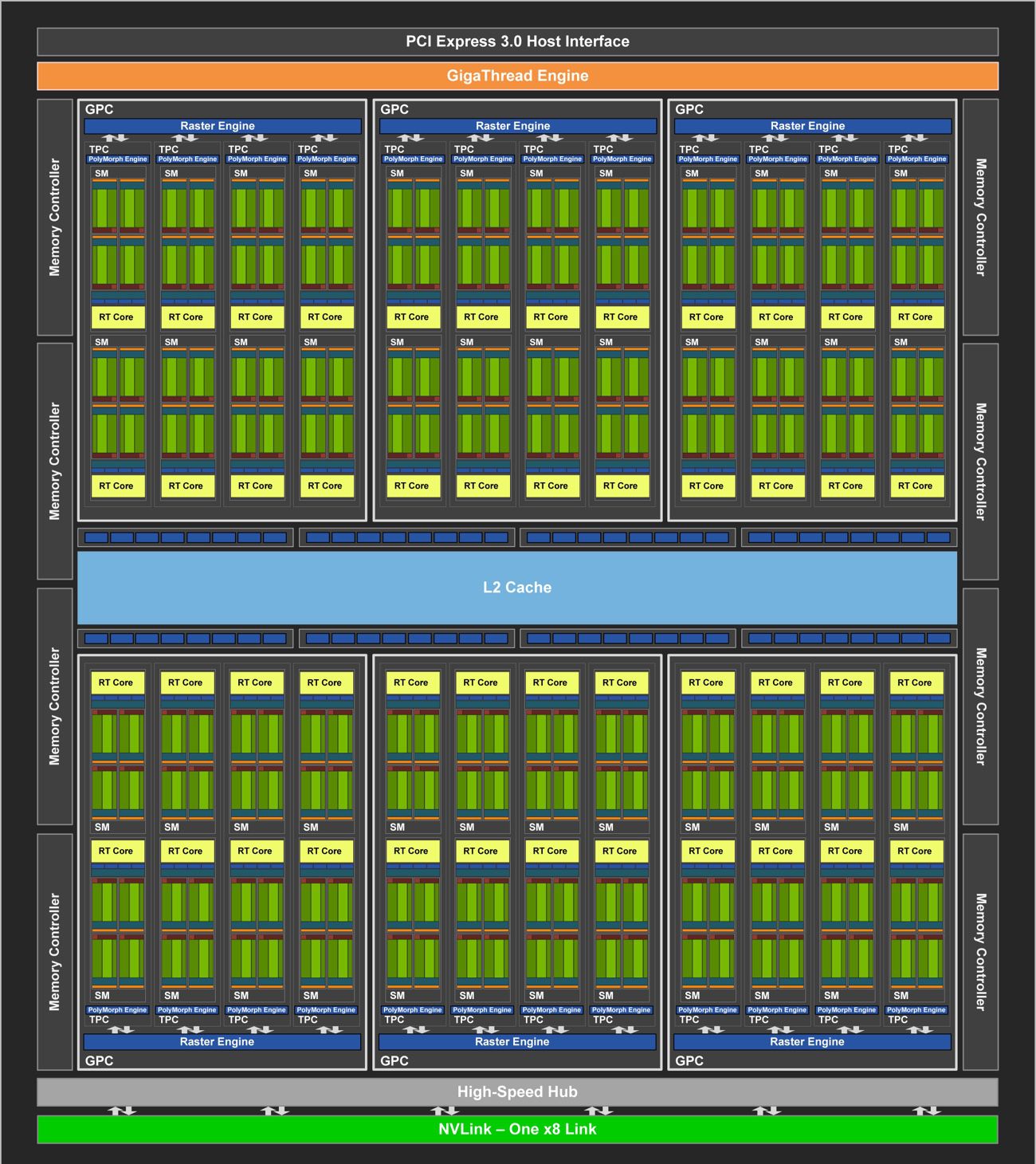

Si le « petit » M1 se contente de 8 cœurs graphiques, rien n'empêche Apple d'envisager un processeur plus richement doté, apte à propulser la gamme au niveau des cartes dédiées. Ajouter des cœurs supplémentaires à une architecture existante, c'est ainsi qu'Apple est passée de l'A10 à l'A10X ou de l'A12 à l'A12X. Et il n'y a pas beaucoup de retard à rattraper : les Mac M1 ne sont en retrait que de 10 à 30 % sur le MacBook Pro 16" et l'iMac 27" dotés d'une Radeon Pro 5300.

Autrement dit : si les 8 cœurs graphiques du M1 ne sont pas ridicules face aux cartes dédiées qu'Apple colle aujourd'hui dans sa gamme, sans doute une version enrichie pourra-t-elle venir chatouiller la Radeon Pro 5500 XT qui équipe avec ses 22 cœurs l'iMac haut de gamme. Car le rendu graphique est un domaine qui se plie fort bien à ces structures hautement parallèles où la charge de travail est répartie entre de nombreuses unités de calcul.

Là encore, Apple évitera d'enrichir un sous-traitant. Ayant habitué ses clients à des cartes de milieu de gamme ou issues du monde des ordinateurs portables, elle n'a pas besoin de s'attaquer directement aux monstres de Nvidia ou d'AMD et peut tranquillement nous assurer de meilleurs performances que la gamme précédente. Restera la question du gros Mac Pro, sur lequel nous reviendrons en fin d'article.

Pourquoi Intel n'applique-t-il pas les mêmes recettes ?

Loin de moi l'idée de tomber dans le sectarisme que l'on prête souvent aux clients d'Apple, mais ce décrochage du monde x86 face au monde ARM est l'une des questions récurrentes des observateurs depuis plusieurs mois. Qu'est-ce qui peut bien empêcher Intel d'appliquer les mêmes recettes à ses propres processeurs pour combler le fossé qui s'est creusé ? On imagine parfois qu'après tout, un processeur est un processeur, tout comme un vélo est un vélo. Il suffirait donc d'appliquer à un processeur x86 les mêmes solutions pour le rendre à la fois beaucoup plus puissant et plus économe.

Sauf que les « recettes miracles » adoptées par Apple pour son M1 sont intimement liées à l'architecture ARM qui le sous-tend. Dans cette architecture, les instructions traitées par le processeur ont une longueur fixe qui facilite leur dispersion entre les différentes unités de traitement. À l'inverse, dans l'architecture x86, les instructions se succèdent à un rythme irrégulier, ce qui complique la tâche du processeur. Intel et AMD ont inventé quelques astuces, comme un système qui tente de deviner où démarrera la prochaine instruction pour l'exécuter sans attendre. Mais plus on y a recours, plus le taux d'erreur augmente.

Tout ce qui pouvait être fait pour pousser l'architecture x86 dans ses derniers retranchements a été fait. Dès les années 1990, les processeurs 486 puis les Pentium ont adopté au plus profond de leurs transistors une structure décomposant les complexes instructions de haut niveau en micro-opérations élémentaires, plus aisées à manipuler, à réordonner et à anticiper. Ce choix technologique a également permis, au début des années 2000, de développer l'Hyper-Threading, où chaque cœur est mis à disposition de deux files d'attente d'instructions : à chaque fois que l'une des deux laisse un « blanc », l'autre file d'attente en profite pour lancer ses propres instructions. Et depuis quelques mois, Intel cherche à associer deux types de cœurs dans ses puces, à la manière de la technique big.LITTLE d'ARM. Ces méthodes ont permis d'optimiser les ressources matérielles en compensant les faiblesses héritées de la conception très linéaire des premières puces d'Intel.

Résultat : depuis quelques années, à défaut de pouvoir encore optimiser la gestion des instructions, on assiste plutôt à une multiplication des cœurs, au prix d'une explosion de la consommation électrique, du dégagement de chaleur et du coût de fabrication. Intel propose un Core i9 disposant de 10 cœurs physiques, qui tutoie les 200 watts à lui tout seul. Chez AMD, le fleuron de la gamme est actuellement le Ryzen Threadripper 3990X, un véritable monstre : un PC équipé de ce processeur à 4 500 $ peut atteindre une consommation de 1 000 watts quand il active ses 64 cœurs. Mais il se montre alors dix fois plus rapide qu'un Mac M1 sous CineBench et cinq fois plus rapide sous GeekBench.

Rien n'empêcherait aujourd'hui Intel de repartir aussi d'une page blanche. Elle en a d'ailleurs eu l'occasion en 1997 en rachetant à DEC sa famille de processeurs StrongARM, rebaptisée XScale. Elle n'a cependant pas trop su quoi en faire, et l'a revendue dix ans plus tard. Faute de succès des processeurs ARM dans le monde PC, Windows ARM n'a pas percé. Et puisque Windows ARM n'a pas percé, personne ne veut investir dans un processeur ARM pour le monde PC. Enfin, Qualcomm montre bien une certaine ambition dans le domaine, mais le fabricant vient juste de s'adjoindre les services d'anciens d'Apple pour tenter de rattraper son retard sur le processeur M1. Il est donc toujours aussi difficile de renoncer à ce qui fait l'essence de l'architecture x86, car tout l'écosystème du PC repose sur ces fondations, à commencer par Windows. C'est le serpent qui se mord la queue — pour le moment.

Verra-t-on un Mac Pro Apple Silicon ?

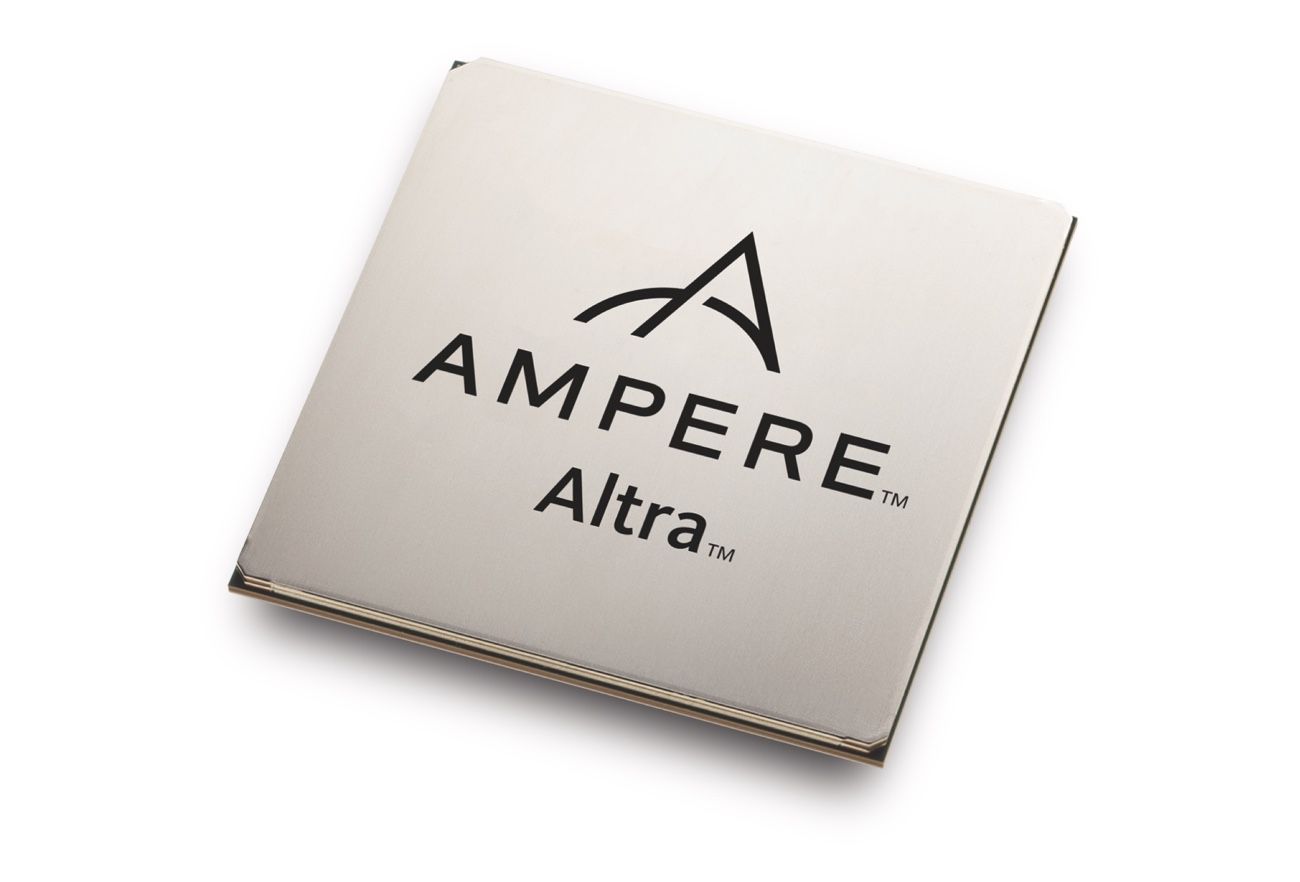

L'architecture ARM se prête facilement à la multiplication des cœurs, d'autant plus qu'Apple a organisé de longue date son système d'exploitation pour en tirer parti. Si Apple a le moindre doute sur la possibilité de caser toujours plus d'unités de calcul dans une puce, elle pourra s'intéresser à la microarchitecture Neoverse N1 qu'ARM diffuse depuis 2019. Le concepteur californien Ampere Computing en a tiré la puce Altra, dotée de 32 à 80 cœurs physiques (et bientôt 128). Grâce à une gravure à 7 nm, ce paquebot de 80 cœurs cadencés à 3,3 GHz, capable de gérer huit canaux de mémoire vive (contre six pour le Mac Pro actuel) et 128 lignes PCIe (contre 64 pour le processeur Xeon du Mac Pro, soit quatre fois moins de débit compte tenu de la différence de génération) se contente d'une enveloppe thermique (TDP) de 250W, à peine plus que le Xeon, dont les 28 cœurs tournent à 2,5 GHz.

Comme si un seul de ces cerveaux ne suffisait pas, Ampere a prévu la possibilité de les associer deux par deux. Des ordinateurs bi-processeurs, comme Apple a cessé d'en proposer depuis 2012. Pourtant, le jeu en vaut la chandelle : selon les tests, la version 80 cœurs de l'Altra peut se montrer trois à cinq fois plus rapide que le Xeon, pour la moitié de son prix !

En attendant, la question du Mac Pro est une vraie épine dans le pied d'Apple. La marque est consciente que ce modèle est incontournable dans sa gamme, car il lui donne une légitimité auprès d'un public exigeant. Sans Mac Pro, sa gamme ne paraîtrait pas très professionnelle. Or jusqu'à présent, pour fabriquer un Mac Pro, ce n'était pas très compliqué. Il suffisait de faire une grosse boîte et d'y inclure un gros processeur produit par Intel. Apple a bien essayé d'expliquer aux professionnels qu'ils pouvaient se contenter d'un petit cylindre discret et silencieux, mais ça n'a pas marché : elle a dû se résoudre à leur proposer à nouveau un gros machin plein de vide avec une alimentation électrique digne d'une friteuse.

Mais au moins, Apple n'a pas eu à inventer le processeur qui va avec. Pour le plus puissant Mac Pro, le tarif public du Xeon W-3275M à 28 cœurs se situe aux alentours de 7 000 €. Intel en vend des palettes entières, car la plupart d'entre eux terminent dans des fermes de serveurs, où leurs nombreux cœurs font merveille pour servir plusieurs clients ou faire tourner plusieurs machines virtuelles en parallèle. Pour Apple, c'est juste un achat comme un autre, qu'elle rentabilise en vendant la machine au bon prix.

Mais voilà, pour équiper son futur Mac Pro d'un processeur à la hauteur de la gamme Xeon d'Intel, ou de leurs concurrents Threadripper d'AMD, Apple va devoir inventer son propre monstre de puissance. Et comme elle n'a sûrement pas l'intention de le vendre ensuite à ses concurrents, il faudra qu'elle rentabilise toute seule la recherche, le développement et la fabrication de ces processeurs. Elle a peut-être un projet secret consistant à envahir les centres de données, mais en attendant, la cible du Mac Pro ne semble pas suffisante pour rentabiliser l'investissement de base.

Il sera intéressant de voir quels seront les choix d'Apple en la matière. Multiplier les cœurs dédiés à l'intelligence artificielle (comme le Neural Engine) ou les cœurs GPU ne suffira pas à offrir une machine capable de se confronter à la force brute des modèles Intel ou AMD. On n'imagine quand même pas qu'Apple va proposer un nouveau Mac Pro doté d'un processeur x86 : ce serait reconnaître qu'elle ne peut pas concurrencer Intel sur le terrain de la puissance. Même à titre provisoire, ce serait un message négatif, dont Intel s’empresserait de tirer un profit médiatique.

Apple a-t-elle dans ses cartons un super-processeur à plusieurs dizaines de cœurs, peut-être pas rentable, mais capable de servir de vitrine technologique à Apple Silicon ? Un M1X, M1 Pro ou M2 qui serait ensuite adapté au reste de la gamme ? Va-t-elle développer des systèmes multi-processeurs en associant deux, quatre, voire des dizaines de ses petits M1 ? Va-t-elle développer ses propres cartes d'extension pour externaliser la puissance de calcul à la mode GPGPU ?

Et quand Apple aura résolu cette question, il lui en restera une autre : le design. On a entendu dire qu'elle réfléchissait à un Mac Pro de taille réduite. Cela signifierait qu'elle renoncerait à la possibilité d'offrir des emplacements pour des cartes d'extension, qui justifient à eux seuls le volume de l'actuel Mac Pro. Alors, retour au Mac Pro « poubelle » ou maintien d'un Mac Pro « camion » ? L'avenir s'annonce passionnant !