Après avoir débattu de l'absence des processeurs AMD dans les Mac dans un article précédent, tournons-nous maintenant vers Intel, le choix principal d'Apple depuis le milieu des années 2000. Mais avant de parler de la situation actuelle, un peu d'histoire.

Comment fonctionne un processeur

Intel a inventé le concept de microprocesseur au début des années 1970, avec le 4004, et son premier processeur « x86 » date de 1978. Le nom fait référence au nom de la puce, 8086, et au jeu d'instructions, qui a évolué depuis tout en gardant une rétrocompatibilité.

Le jeu d'instructions est l'ensemble des commandes que le processeur peut exécuter. Il en existe de plusieurs types : x86 (Intel, AMD), ARM (ARM, Apple, Qualcomm, etc.), 68000 (Motorola), PowerPC (IBM, Motorola, Apple, etc.)… Ils évoluent régulièrement, mais gardent généralement une rétrocompatibilité : un processeur récent accepte souvent les programmes écrits pour un ancien CPU avec le même jeu d'instructions.

Au fil des années, le x86 a évolué sous des marques successives : 80386 (le premier 32 bits), Pentium, Pentium Pro, Pentium 4, Core Duo, Core 2 Duo, Core i7, etc. Nous n'allons pas citer tous les modèles — ils sont trop nombreux — mais il faut retenir une chose : Intel fait évoluer très régulièrement ses puces. Et pour comprendre ce qui se passe actuellement, il faut parler d'architecture, de gravure, de cœurs et de fréquence.

L'architecture, en schématisant, est la base du processeur. Un CPU avec une architecture précise (par exemple Skylake actuellement) va disposer d'une liste d'instructions x86, qu'il va exécuter en un nombre de cycles précis. Le passage dans une nouvelle architecture (par exemple Sunny Cove) va modifier l'agencement interne des unités de calcul, de la mémoire cache, les instructions supportées ou le nombre de cycles nécessaires pour une instruction.

Le but, dans la majorité des cas, va être de diminuer le nombre de cycles pour accélérer les calculs. Changer d'architecture nécessite évidemment beaucoup de R&D, et les concepteurs de CPU disposent d'autres méthodes pour améliorer les performances : augmenter le nombre de cœurs, augmenter la fréquence ou améliorer la gravure.

La première solution n'est efficace que dans une certaine mesure : ajouter des cœurs n'a pas d'impact sur tous les usages et augmente la consommation et le coût du CPU. La seconde a un impact direct sur les performances mais aussi sur la consommation. De plus, la fréquence dépend en partie de l'architecture 1, ce n'est donc pas un levier totalement efficace.

Enfin, la gravure. On parle de x nm (nanomètres) pour indiquer la taille des transistors. Plus la valeur est faible (et donc plus les transistors sont petits), plus la consommation diminue (en théorie). Améliorer la finesse de gravure permet de mettre plus de transistors sur la même surface (donc plus de cœurs, de mémoire cache, d'unités, etc.) et d'augmenter la fréquence (à consommation égale) ou diminuer la consommation (à fréquence égale).

Intel n'utilise que deux leviers

Nous l'avons vu dans le premier article sur AMD, il est possible d'utiliser les quatre avancées simultanément : les Ryzen 3000 utilisent une nouvelle architecture (Zen 2), une fréquence plus élevée, plus de cœurs (jusqu'à 16 en grand public) et une gravure plus fine (7 nm au lieu de 12 nm).

Or, depuis 2015, Intel n'exploite que deux leviers : augmenter la fréquence et augmenter le nombre de cœurs. Pour diverses raisons, comme l'absence de concurrence à l'époque et des choix malheureux dans le monde mobile, le développement de nouvelles architectures a été mis en pause. La seule innovation dans ce domaine date de fin 2019 avec Ice Lake (le nom de la gamme mobile) et son architecture Sunny Cove2.

Vous vous demandez pourquoi Intel n'améliore pas la gravure ? Parce que c'est compliqué. Historiquement, Intel grave ses puces directement, sans faire appel à un fondeur externe comme TSMC, Global Foundries ou Samsung, au contraire d'AMD actuellement, ou d'Apple.

Pendant des années, la société avait une avance confortable sur ses concurrents (jusqu'en 2013 environ) avant de tout perdre rapidement. Le passage du 22 nm (Haswell, Core de 4e génération) au 14 nm (Broadwell, Core de 5e génération) a été horrible pour Intel, avec un rendement très faible.

Pour bien comprendre : les CPU sont fabriqués sur de grands disques de silicium (les wafers) et le rendement est calculé en prenant le nombre de processeurs utilisables à la fin divisé par le nombre de processeurs gravés. Le but, évidemment, est d'avoir un rendement élevé, proche de 100 %.

Or, la gravure en 14 nm n'a jamais été parfaite, comme les pénuries récurrentes de puces le montrent bien, mais surtout le passage en 10 nm, l'étape suivante chez Intel, a subi le même sort. Intel a dû abandonner son premier CPU en 10 nm (Cannon Lake) et les Core de 10e génération combinent des modèles en 10 nm (Ice Lake) et 14 nm (Comet Lake).

Skylake, encore Skylake, toujours Skylake

Vous lirez ou entendrez souvent qu'Intel n'innove plus, et c'est malheureusement en partie vrai. Depuis la sixième génération Core (2015), la base ne change pas. Skylake (qui désigne ici l'architecture et la gamme de processeurs) était une nouvelle architecture qui succédait à Broadwell (un CPU vu dans quelques Mac portables) avec une gravure en 14 nm.

À l'époque, le haut de gamme possédait quatre cœurs avec une fréquence maximale de 4,2 GHz en mode Turbo (le Core i7 6700K), le tout avec un éventuel GPU de la neuvième génération (la série 500). La septième génération (Kaby Lake) n'amène… presque rien. La partie CPU ne bouge pas, mais monte (un peu) en fréquence : 4,5 GHz dans le Core i7-7700K et ses quatre cœurs. Les rares modifications concernent le GPU (série 600) : il gagne le décodage matériel du HEVC en 10 bits et quelques optimisations sur la fréquence.

La huitième génération (Coffee Lake) ? Même chose. On reste en 14 nm, avec une augmentation de la fréquence (5 GHz au maximum) et du nombre de cœurs (six sur les Core i7). Mais les performances à fréquence identique n'évoluent pas. Le GPU gagne un petit U dans le nom (par exemple Intel UHD Graphics 630) qui indique juste la prise en charge des DRM (HDCP 2.2).

La neuvième génération, Coffee Lake Refresh, ne change toujours rien. C'est du 14 nm avec une fréquence élevée (5 GHz) et plus de cœurs (huit dans le Core i9-9900K). Le GPU, lui, ne bouge pas. Sur cette génération, un gros problème survient : monter la fréquence et le nombre de cœurs a un impact direct sur la consommation. Un Core i7-6700K avait un TDP (en simplifiant, la consommation maximale) de 91 W, un Core i9-9900KS monte à 127 W et cette valeur est trop faible pour vraiment profiter du CPU. Il faut débrider le TDP — ce que les Mac ne proposent pas — pour tirer la quintessence du CPU, qui consomme alors plus de 160 W. Nous en arrivons aux dixièmes générations (oui, il y en a deux) qui nécessitent quelques explications.

Dixième ou dixième ? Mon cœur balance

Nous venons de le voir, Intel vend grosso modo la même chose depuis 5 ans. Skylake offrait d'excellentes performances en 2015 et offre toujours de bonnes performances en 2020. Mais il y a de la concurrence, que ce soit dans le monde du x86 avec les Zen 2 d'AMD ou dans le monde ARM avec les puces Ax d'Apple.

Le premier essai d'Intel en 10 nm, qui portait le nom de Cannon Lake (architecture Palm Cove), a été une vraie débâcle. Il s'agissait essentiellement d'un Skylake gravé en 10 nm avec un GPU qui ne fonctionnait pas (dixième génération) et quelques instructions ajoutées (AVX-512). Sorti en catimini dans un NUC et dans un PC portable chinois, Cannon Lake a été rapidement poussé sous le tapis, et son évocation amène directement un silence gêné chez Intel.

Deuxième essai, Ice Lake. Il s'agit de la vraie dixième génération, que l'on retrouve notamment dans les MacBook Air 2020. Premièrement, Ice Lake inaugure une nouvelle architecture (Sunny Cove) qui offre des gains intéressants (jusqu'à 15 % dans certains cas). Deuxièmement, le GPU gagne en puissance (64 cœurs au lieu de 48 au mieux auparavant), en fonctions et en consommation.

Mais Ice Lake a un souci : la gravure en 10 nm. Intel ne maîtrise pas encore celle-ci et cantonne donc Ice Lake au monde mobile, avec des puces dotées de quatre cœurs et des fréquences conservatrices (4,1 GHz).

C'est là que la seconde dixième génération intervient : Comet Lake. Attention… roulements de tambour… Intel continue de recycler Skylake. C'est du 14 nm, avec le même GPU, le même CPU qu'en 2015 et plus de cœurs et de fréquence. Comet Lake va monter à 5,3 GHz et 10 cœurs (dans les machines de bureau, 8 cœurs en portable), avec évidemment la consommation associée…

Globalement, Comet Lake n'a que peu d'intérêt mais vous n'aurez de toute façon pas le choix : tous les constructeurs y passeront, Apple compris, ne serait-ce que parce qu'Intel arrêtera la « génération » précédente.

Les Lake du Connemara

Avant de parler du futur, il faut tout de même évoquer le fait qu'Intel essaye de proposer des choses intéressantes, comme le récent CPU Lakefield. Gravé avec plusieurs technologies, il combine un cœur puissant (Sunny Cove) avec quatre cœurs qui consomment peu et offrent des performances faibles (Tremont, vu dans les puces Atom). Cette voie vous semble familière ?

C'est normal, c'est celle utilisée par ARM, Apple, Samsung et bien d'autres dans le monde mobile. Maintenant, parlons de ce qui va suivre, et c'est compliqué.

Il faut le répéter : le 10 nm d'Intel n'est pas efficace. Actuellement, les puces en 10 nm tournent à des fréquences significativement plus faibles qu'en 14 nm, et c'est un problème. De façon plus concrète, Sunny Cove (l'architecture des Ice Lake mobiles) ne devrait pas être proposée dans les machines de bureau.

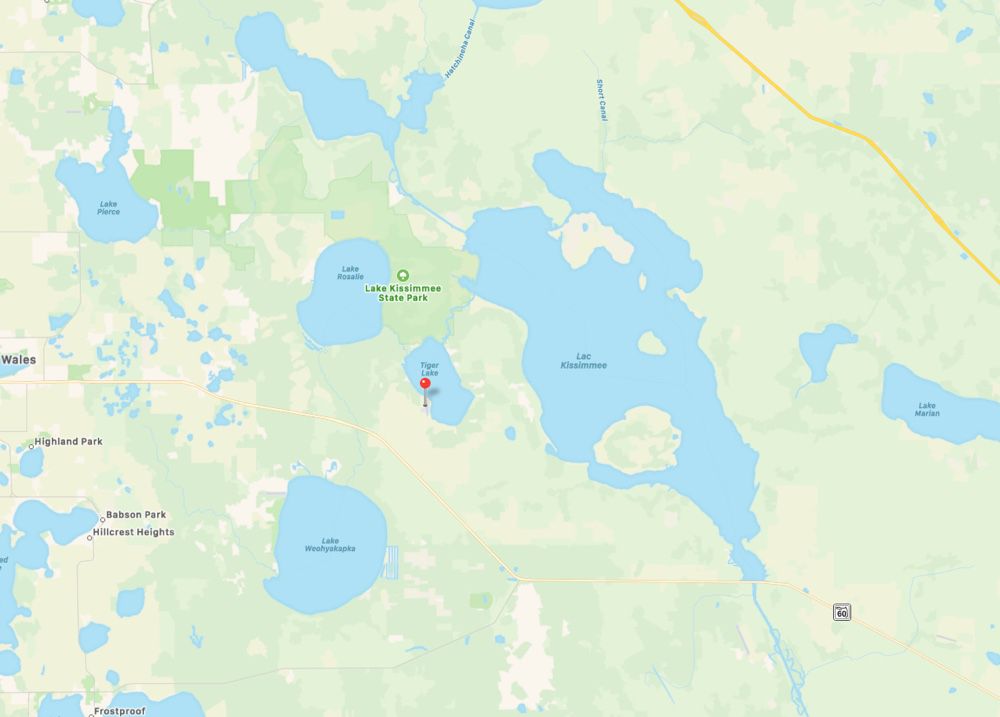

Dans le meilleur des cas, Intel proposera en 2020 la gamme Tiger Lake, avec une nouvelle architecture (Willow Cove) qui amènera le PCI-Express 4.0, une nouvelle génération de GPU (Xe) et quelques améliorations sur la mémoire cache. Les puces Tiger Lake viseront les appareils mobiles mais aussi les ordinateurs de bureau, avec une gravure en 10 nm. En parallèle, un plan de secours en 14 nm (encore) existe : Rocket Lake. Et pour la suite, il y a aussi Alder Lake. Cette famille de CPU, attendue en 2021, ne sera peut-être d'ailleurs pas présente dans les Mac…

Le probable abandon par Apple

Parlons d'Apple, qui utilise les processeurs d'Intel depuis une quinzaine d'années. Assez logiquement, les problèmes du fondeur ont un impact direct sur les Mac : les portables évoluent assez peu, les machines de bureau encore moins. Le Mac mini coincé sur des puces de 8e génération montre bien le problème : la 9e et la 10e n'apportent pas de gains vraiment intéressants en dehors de quelques MHz.

La question qui se pose reste la même que dans la partie sur AMD : pourquoi rester chez Intel ? Sûrement d'abord parce qu'Intel est un bon client pour Apple (ou Apple un bon client pour Intel). Apple n'a pas souffert publiquement de pénurie, Intel propose de temps en temps des puces un peu modifiées pour les machines ornées d'une pomme (c'est le cas des récents MacBook Air, dotés d'un CPU plus compact) et même si les performances évoluent peu, elles restent globalement très bonnes.

AMD fournit une alternative tout à fait valable en 2020, mais passer chez le concurrent n'amènerait pas une vraie révolution. De plus, et cet argument est tout aussi valable que pour un passage chez AMD, les rumeurs sur une transition vers des puces ARM sont récurrentes.

Abandonner un partenaire de longue date pour un autre alors même que le x86 (au sens large) pourrait disparaître des Mac semble étonnant. Nous allons nous arrêter ici pour vous donner rendez-vous dans une troisième partie qui sera dédiée aux puces ARM et aux choix possibles d'Apple. Mais la chose à retenir de ce long article, c'est que l'absence de mise à jour de certains Mac et l'évolution assez faible des performances ces dernières années vient de mauvais choix d'Intel, qui n'avait pas anticipé le retour d'AMD ni la montée en puissance des CPU de type ARM…

-

Au début des années 2000, Intel a suivi une voie un peu particulière avec le Pentium 4. L'architecture était optimisée pour une haute fréquence, au détriment de l'efficacité. Malheureusement, Intel a foncé dans un mur : la consommation, qui a limité la fréquence en pratique. ↩

-

Architectures et noms de code désignent parfois la même chose. Skylake fait référence autant à la sixième génération de Core qu'à l'architecture, par exemple. ↩