AMD complète sa gamme Zen 4 avec des processeurs à 96 cœurs

Il y a un an, AMD lançait son architecture Zen 4 et les processeurs Ryzen 7000 associés. Cette gamme a été très bien reçue, car AMD a amené de bonnes évolutions architecturales avec une consommation mesurée et d'excellentes performances. Au fil de l'année, la société a ajouté des puces mobiles à la gamme, mais aussi des versions pour les serveurs (Epyc) et des versions pensées pour les joueurs (les Ryzen 7000 « 3D »). Il ne manquait qu'une case dans la gamme : le très haut de gamme « grand public1 ».

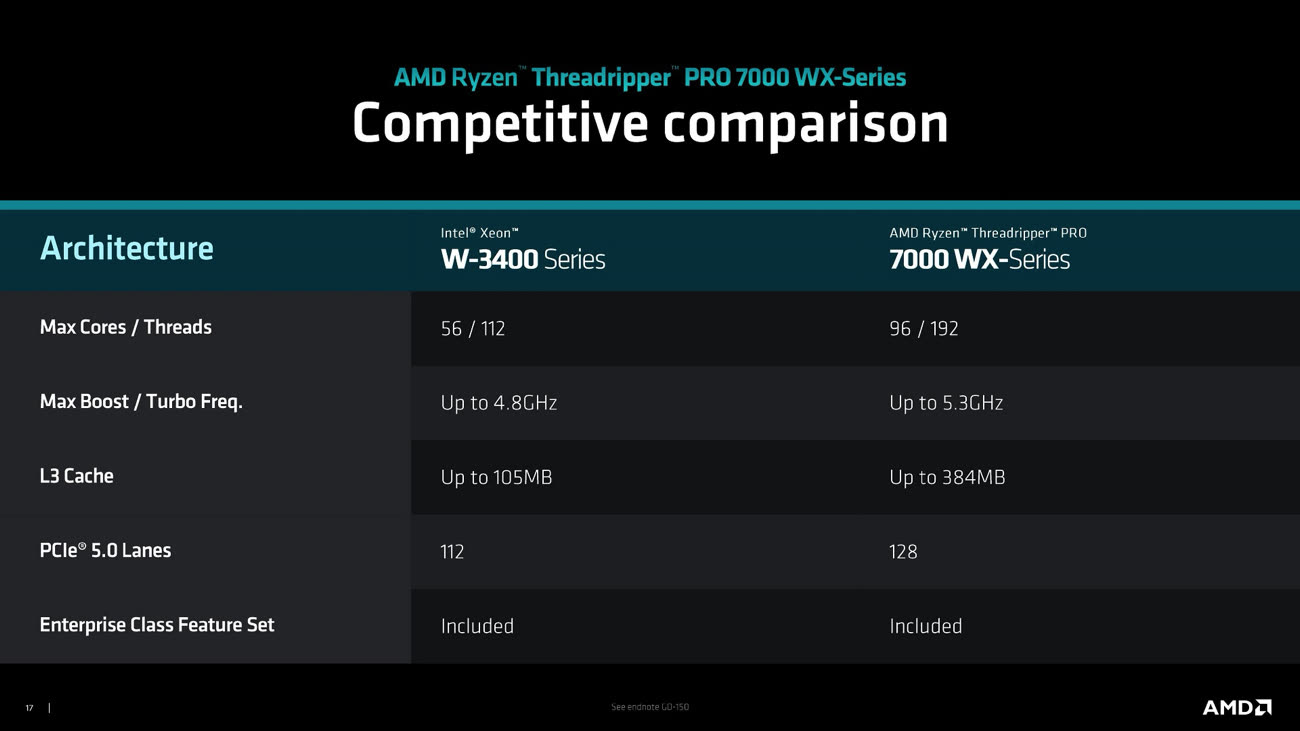

Nous parlons ici de la gamme Threadripper et de sa variante Threadripper Pro, deux lignes de processeurs qui visent les stations de travail mais aussi les amateurs de performances. AMD a toujours mis en avant le nombre de cœurs dans cette série : 16 cœurs en 2017 (Threadripper 1000), 32 cœurs en 2018 (Threadripper 2000) et 64 cœurs en 2020 (Threadripper 3000). Ces puces sont l'équivalent des Core X d'Intel, qui dérivent des Xeon avec la même idée : proposer des CPU hors de prix avec plus de cœurs à ceux qui ont les moyens de se les payer.

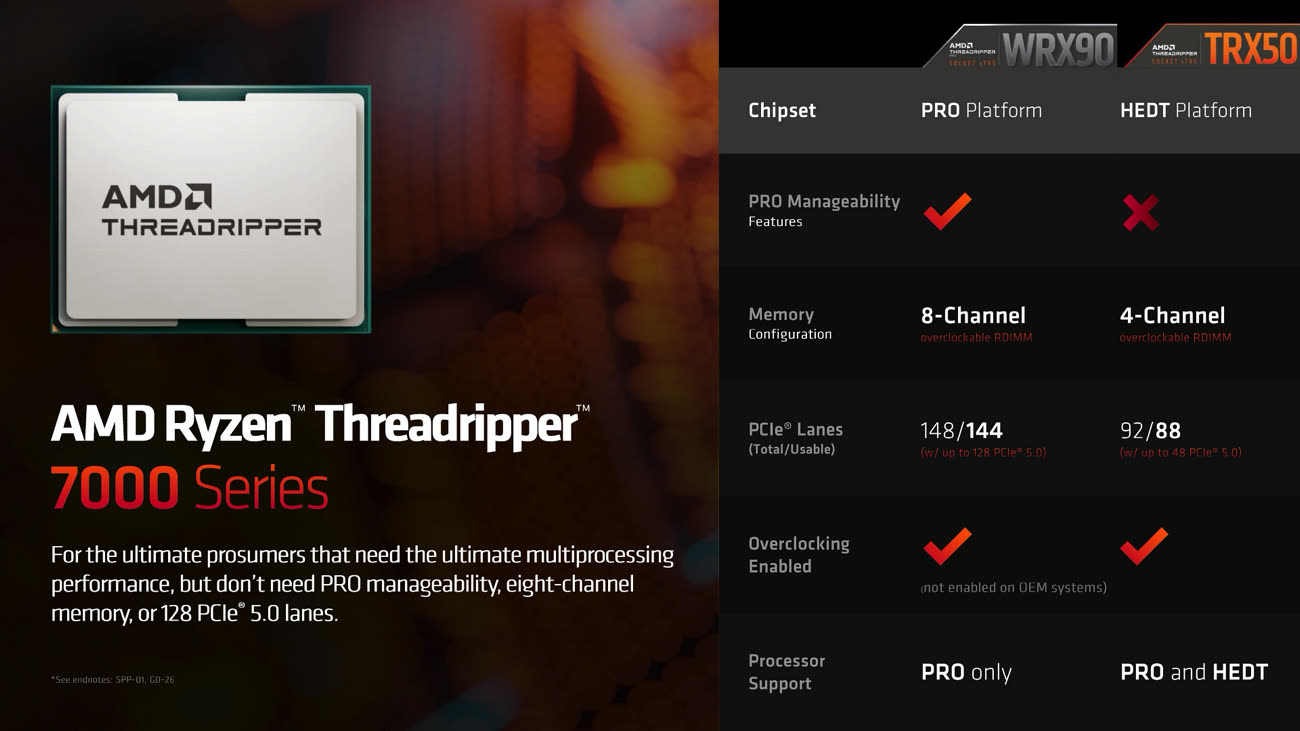

La gamme Threadripper 7000 (pour suivre les Ryzen 7000) reprend donc l'architecture Zen 4 avec des puces équipées de 24 à 64 cœurs (avec SMT, l'équivalent de l'Hyper-Threading qui permet d'exécuter deux threads sur un cœur). La fréquence est élevée (jusqu'à 5,1 GHz sur le haut de gamme2) et les puces prennent en charge beaucoup de lignes PCI-Express. On retrouve cette année 48 lignes PCI-Express 5.0 et 32 lignes PCI-Express 4.0, de quoi prendre en charge de nombreux GPU ou SSD NVMe.

En plus des Threadripper 7000, AMD propose aussi des versions « Pro », qui montent à 96 cœurs. La fréquence maximale reste la même, le TDP (la consommation) aussi — 350 W — mais la mémoire cache augmente (elle passe de 256 à 384 Mo) tout comme le nombre de lignes PCI-Express. Les meilleurs CPU prennent en charge 128 lignes PCIe 5.0 et 8 lignes PCIe 4.0. Autre petite différence entre les versions classiques et les variantes Pro, la mémoire : les seconds gèrent 8 canaux DDR5 (contre 4) et peuvent accepter 2 To de RAM au total (contre 1 To). Attention, la plateforme dérive des serveurs et nécessite donc de la mémoire de type RDIMM, plus onéreuse.

Une gamme assez large

Dans les Threadripper 7000 Pro, les puces contiennent entre 12 et 96 cœurs, avec un prix qui n'est pas connu. Pour les Treadripper 7000 classiques, la version 24 cœurs est annoncée à 1 500 $, celle dotée de de 32 cœurs monte à 2 500 $ et la variante dotée de 64 cœurs est proposée à 5 000 $. En plus de ces tarifs assez élevés, il ne faut pas oublier le prix de la mémoire mais aussi celui des cartes mères : AMD passe par un nouveau connecteur (le sTR5) et il existe deux chipsets, le TRX50 (pour le grand public) et le WRX90 (pour les stations de travail). Les cartes mères pour cette plateforme haut de gamme sont elles aussi proposées à un tarif assez élevé, et dépasser les 1 000 € n'est pas rare.

Dans un monde alternatif, ces puces auraient pu animer un Mac Pro "x86", mais dans la pratique elles se retrouvent dans des PC (très) haut de gamme et dans des stations de travail chez les grands constructeurs comme Lenovo.

A titre de comparaison, les EPYC basés sur Zen 4 proposent combien de coeurs au maximum ?

Je me réponds à moi-même.

Jusqu'à 128 coeurs et 256 threads à 2,25Ghz pour le plus gros EPYC.

Le tout pour 360W de TDP... C'est que ça consomme un max, on est loin de toute considération de sobriété énergétique...

Edit : Bon après il y a celui-ci : https://www.amd.com/fr/products/cpu/amd-epyc-9684x

Il a moins de coeurs mais une fréquence plus élevée et surtout un cache L3 énorme de plus de 1,1Go (!), pour... 400W de TDP. :o

@LolYangccool

Le TDP seul ne veut rien dire, sans oublier que chacun semble le calculer à sa sauce. Ce sont des puces pour des besoins spécifiques, donc la consommation est certainement intéressante pour l'usage visé.

@LolYangccool

"C'est que ça consomme un max, on est loin de toute considération de sobriété énergétique..."

Ce n’est bien entendu pas l’objectif, tu imagines bien. Il n’y a que des usages spécifiques qui peuvent tirer parti d’autant de parallélisme, clairement pas les applications "courantes"... la sobriété recherchée ici est la sobriété temporelle, rien d’autre.

Oui je sais bien. :)

128 sauf erreur

"Ces puces sont l'équivalent des Core X d'Intel, qui dérivent des Xeon avec la même idée : proposer des CPU hors de prix avec plus de cœurs à ceux qui ont les moyens de se les payer."

Ôtez-moi d'un doute, c'est de l'humour ?

Oui je suis d'accord. On peut donc faire le parallèle avec une certaine gamme de produits d'une certaine marque dont nous sommes tous fans ici dans ce cas.

@ilyon

pas exactement vu que la marque en question ne s’adresse pas (mac pro…) à cette frange de la clientèle

Il y a déjà des tests de ces petites merveilles ?

Parfait pour le prochain MacBook Air !

Le problème c’est que pour faire de la vidéo ou de la musique ( principale activité des Mac Pro ) ce n’est pas vraiment nécessaire.

Ces processeurs sont surtout faits pour des calculs en continu ( d’où la ram rdimm ecc) sans erreurs.

@Dark Phantom

"Le problème c’est que pour faire de la vidéo ou de la musique ( principale activité des Mac Pro ) ce n’est pas vraiment nécessaire."

Vidéo, ça se discute. Pour des machines de rendering à haut volume, ça tient la route pas mal. Mais ce n’est totalement pas le secteur des Mac Pro ou de n’importe quel Mac d’ailleurs.

Ce qui est amusant avec ces processeurs, c’est qu’ils préfigurent sans doute de ce qui sera le nouveau normal grand public d’ici 5 ou 10 ans.

Le problème c’est que le Mac se spécialise sur ce que son CPU peut faire de mieux. En l’occurrence, consommer moins d’énergie à performance égale. Donc un usage bureautique / mail / web.

Mais pour ceux qui veulent de la perf pure, le Mac n’est plus vraiment un choix.

A voir si l’évolution des processeurs Mx arrivera à changer la donne

Existe-t-il des compilateurs (et des soft) développés pour exploiter autant de cœurs, de threads…

J’ai des fois l’impression - et je peux me tromper, ce n’est qu’une impression - qu’il y a une course effrénée sur le matériel et qu’on oublie que l’expérience utilisateur dépend aussi beaucoup de l’OS et des applications.

Bref qu’au lieu d’optimiser le code, on préfère ajouter des cœurs et des GHz.

@Mac1978

"Bref qu’au lieu d’optimiser le code, on préfère ajouter des cœurs et des GHz."

Optimiser est une légende. Ça n’apporte que peu. Le choix d’algorithmes appropriés apporte beaucoup plus. Optimisés ou non. On ne découvre pas de nouveaux algorithmes révolutionnaires tous les jours.

On n’a plus beaucoup de GHz ajoutables depuis plus d’une décennie. Du coup, que reste-t-il ?

Des cœurs.

@Mac1978

"Existe-t-il des compilateurs (et des soft) développés pour exploiter autant de cœurs, de threads…"

Non et oui.

Des compilateurs, automatiquement ? Non. Pas vraiment. Certains langages se prêtent plus que d’autres à une parallélisation automatique, langages fonctionnels en particulier. Mais en général c’est un travail manuel.

Quant à des softs, oui, absolument, il y en a, beaucoup même. De plus en plus. Tout internet fonctionne de façon massivement parallèle, des bases de donnés aux logiciels serveur gérant des milliers de transactions aux logiciels de télécommunication, etc. Le calcul scientifique, la modélisation, le rendering… tellement de choses.

De toute manière il n’y a aucune alternative, le parallélisme est une obligation.

@fte

Merci de ces explications.

La question de la création de nouveaux algorithmes est intéressante justement. Ne devrait-on pas on aussi travailler davantage dans ce secteur ?

Je me souviens de mes cours d’analyse numérique à la fin des années 70, rien n’était pensé pour le parallélisme.

En plus, l’informatique quantique nécessite de repenser complètement l’algorithmique semble-t-il.

@Mac1978

"La question de la création de nouveaux algorithmes est intéressante justement. Ne devrait-on pas on aussi travailler davantage dans ce secteur ?"

Mais c’est déjà le cas. Le machine learning / AI est l’une de ces voies de recherche justement.

La parallélisation massive est absolument un secteur très dynamique en 2020+. L’architecture des logiciels, OSs y compris, évolue dans ce sens.

Mais c’est un processus qui prend du temps. Des codes écrits il y a plus de 50 ans, il y a plus de 29 ans, sont encore en usage aujourd’hui très fréquemment. Parce qu’on sait qu’ils fonctionnent.

Fonctionner est important. Plus important que peut-être fonctionner rapidement.

"Je me souviens de mes cours d’analyse numérique à la fin des années 70, rien n’était pensé pour le parallélisme."

J’utilise des microcontrôleurs, beaucoup. Des vieux, monocoeur, et des plus récents, tous multicoeurs.

En effet dans les années 70, 90 même, on comptait sur un doublement de fréquence chaque 18 mois, jusqu’à ce qu’on atteigne 2 GHz… Les problèmes ont commencé… un de ces problèmes est la longueur d’onde, et il n’y a pas de workaround.

C’est terminé depuis plus d’une décennie. L’ère est au multicoeurs. Nos téléphones ont 4, 8, 12 coeurs même. Téléphones ! L’ère est au parallélisme, y compris hors du domaine logiciel.

"En plus, l’informatique quantique nécessite de repenser complètement l’algorithmique semble-t-il."

La quantique n’est pas algorithmique. La quantique n’est pas Turing complete. On n’y exécute pas des programmes.

Aussi, l’AI ne peut garantir un résultat correct. La quantique est encore pire.

Plus important, ni l’AI ni la quantique ne sont des accélérations d’algorithmes actuels. Ce sont des méthodologies différentes pour des problèmes différents au pire, des approches différentes donnant des résultats différents pour un problème donné au mieux.

Bref. Tout ça pour dire que l’optimisation et ses effets sont grandement exagérés. Si un logiciel est lent, c’est peut-être une question d’architecture (mono vs multi threads par exemple), d’algorithme, ou juste de complexité globale… ou d’incompétence. Pour ainsi dire jamais d’optimisation.