Qualcomm annonce que le Snapdragon X Elite est plus rapide que l'Apple M3… et c'est probablement le cas

En octobre, Qualcomm a annoncé le Snapdragon X Elite, un système sur puce pensé pour les ordinateurs sous Windows, et annoncé pour le milieu de l'année 2024. Il est basé sur le cœur Oryon (issu des travaux de Nuvia) et la société américaine a indiqué récemment que la nouvelle puce serait plus rapide que l'Apple M3. Et au vu des configurations des deux SoC… c'est probablement le cas et c'est normal.

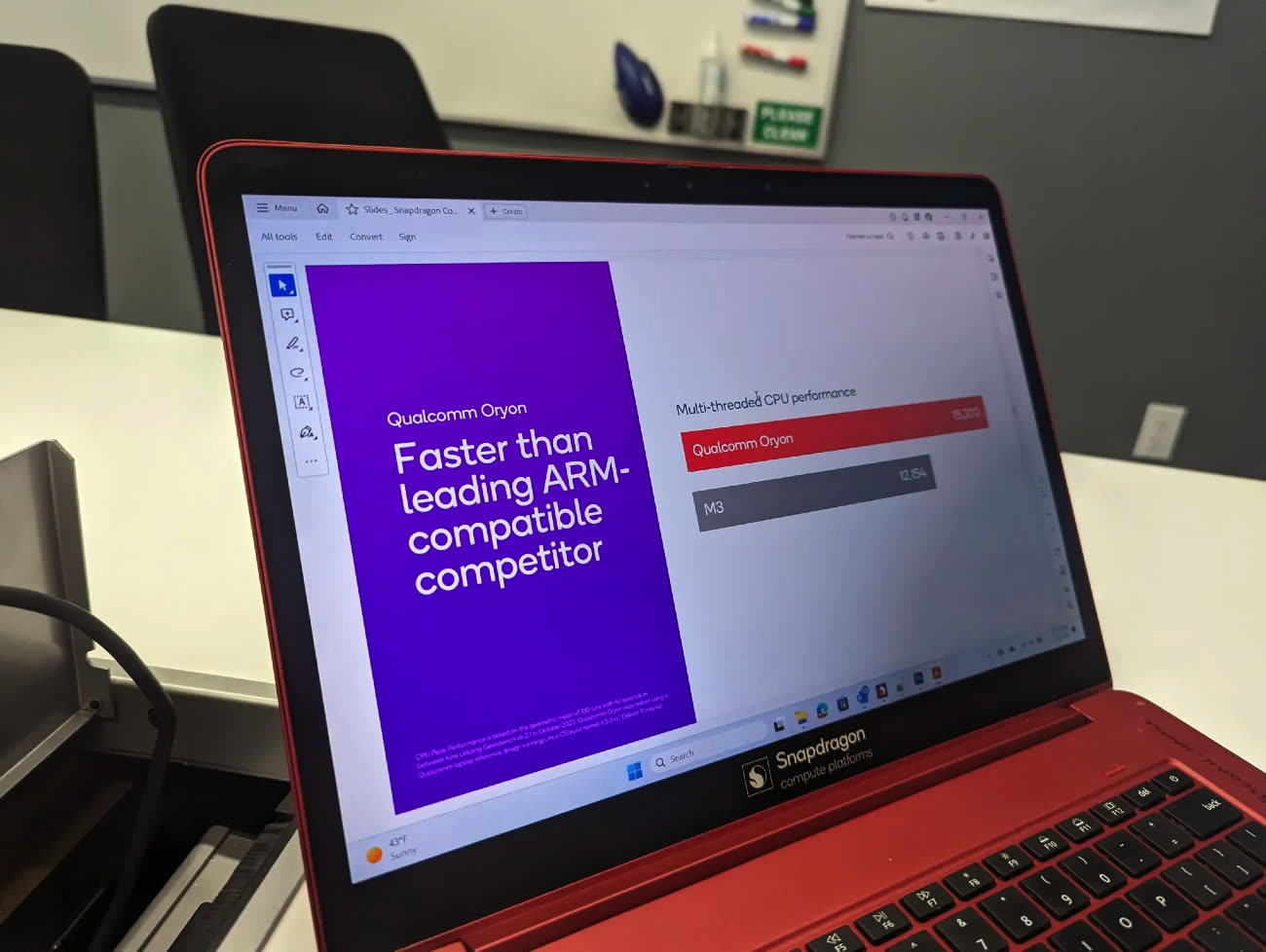

Ce sont nos confrères de Digital Trends qui partagent cette image : un benchmark fourni par Qualcomm montre que la nouvelle puce est plus rapide que l'Apple M3 sur plusieurs cœurs, avec un gain d'environ 20 %. Mais il n'y a rien d'étonnant : la puce possède plus de cœurs.

Avec Oryon et le Snapdragon X Elite, Qualcomm compte battre le M2 et les puces x86

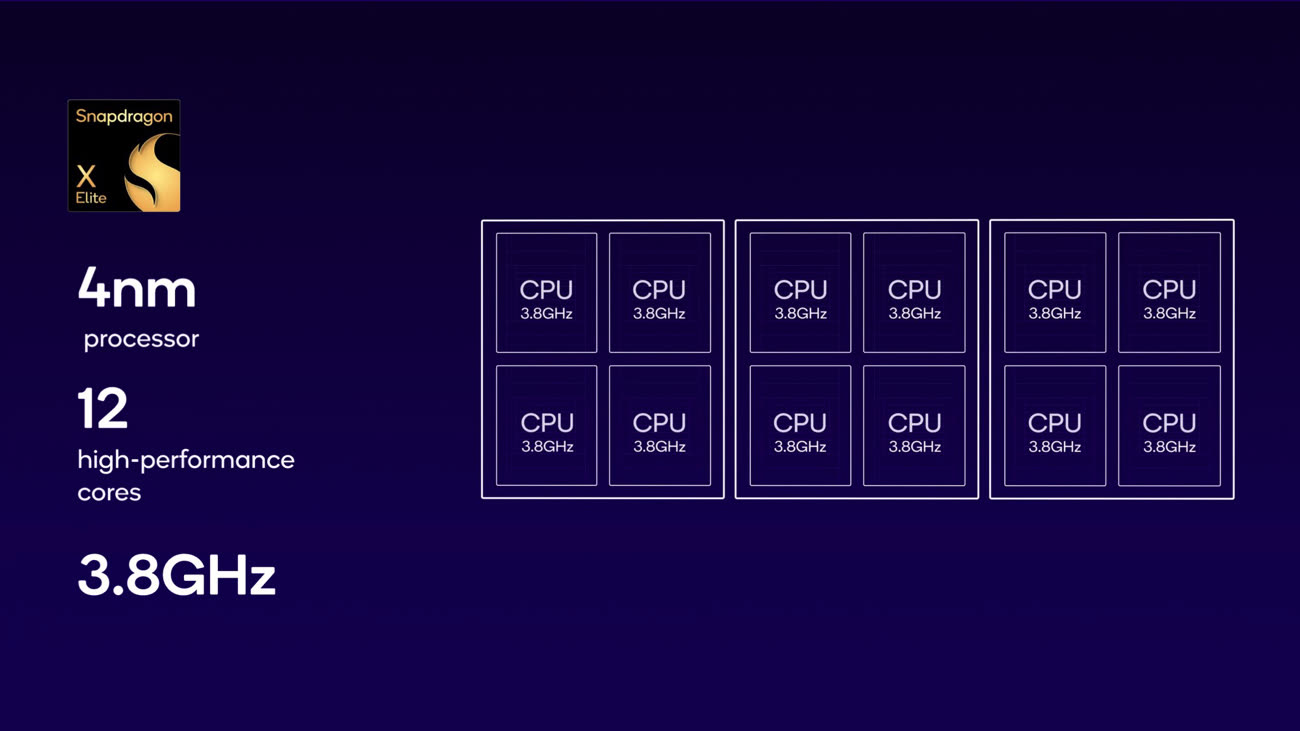

Notre actualité sur le sujet l'expliquait déjà : le système sur puce Snapdragon X Elite a été annoncé avec 12 cœurs identiques et une fréquence de 3,8 GHz (4,3 GHz en pointe). En face, l'Apple M3 reste assez conservateur : il possède quatre cœurs performants et quatre cœurs basse consommation (4+4). Même en prenant en compte que les performances sur un seul cœur sont à l'avantage d'Apple, le plus grand nombre de cœurs permet mécaniquement à la puce de Qualcomm de prendre la tête. Pour tout dire, le Snapdragon X Elite est probablement plus rapide dans ce cas de figure que l'Apple M3 Pro, un système sur puce doté de 11 (5+6) ou 12 (6+6) cœurs.

Par contre, Qualcomm évite pour le moment de trop mettre en avant la puissance de son GPU : si le CPU est très rapide, le GPU est un peu à la traîne comparativement et se place entre une puce M2 et une puce M1 Pro (Apple ne donne pas la puissance exacte du M3, mais elle est probablement au moins équivalente au vu des performances mesurées.

En réalité, comme souvent avant la sortie d'un produit, les fabricants choisissent évidemment les cas les plus favorables et mettre en avant les performances d'un CPU doté de 12 cœurs est logique. Reste à voir comment s'en sortiront les PC équipés de la puce dans la pratique : elle aura du travail pour émuler des logiciels comme Chrome, qui n'existe pour le moment pas dans une variante ARM64 pour les PC sous Windows.

@Bruno de Malaisie

"Pour un portable, la puissance, c’est bien, mais l’autonomie, c’est mieux."

Tu généralises tes usages. Ce ne sont pas les miens. Mes usages sont tous à moins de 2 mètres d’une prise.

@fte

Certes mais quel est l’intérêt d’avoir un portable dans ces conditions?

Question sans arrière pensée.

J’ai un MacBook Air M1 et je le charge la nuit avant de l’utiliser pendant la journée. Je ne prends même pas le chargeur avec moi.

J’ai deux prise à côté de mon bureau, mais elles servent à mes élèves quand leurs ordinateurs sont déchargés.

@Bruno de Malaisie

"Certes mais quel est l’intérêt d’avoir un portable dans ces conditions?"

Je ne me promenais pas avec ma workstation, un boîtier de 80 litres, et mes 27”, lorsque j’allais à l’université ces dernières années. Je prenais un portable. Les prises étaient juste sous les bureaux.

Je n’ai pas besoin d’un portable. J’ai besoin d’un transportable. ;)

@Paquito06

"Est ce que, a 💛 egal, la M3 est plus energivore que la Snap X Elite? Si ca a de l’importance?"

Sans doute majoritairement une question de gravure.

Non, ça n’a pas d’importance. Les puces ne sont pas en compétition IRL, seulement dans la tête des nerds.

@fte

Je crois aussi 😅

Oui bon, à 80W ce n'est pas très surprenant non plus

Cool

C'est très bien de la concurrence, effectivement on manque d'encore trop d'infos pour vraiment comparer.

Mais si ça met la pression sur Apple tant mieux. Déjà pour le M3 changer le process N3 du 3nm, qui est actuellement le moins performant, vers le N3E ou mieux, mais aussi pousser à ce que le M4 fasse le vrai saut de puissance que l'on a pas eu avec le M3 (genre PPC750 vs PPC603).

@melaure

Après ce qui est amusant, c'est que si le nouveau processeur de Qualcomm sort courant 2024, on peut quasiment être certain nous qu'à la fin 2024, on aura déjà le M4

@raoolito

Il faut l’espérer, qu’il n’y ait pas de retard. Et puis la gamme M ce n’est pas juste le modèle de base, on a le Pro, le Max et le Ultra. En attendant le Bomba 😛 avec 4 Max dedans ;)

@melaure

Cette année, ça ne les a pas vraiment gêné 🤣

@raoolito

"quasiment être certain"

Quasiment être certain c’est pas comme de dire qu’on est pas certain ?

On ne sait pas prédire l’avenir, et on ne sait pas prédire Apple. Alors les deux !

@fte

Ok je mise sur un m4 au dernier trimestre 2024 !

@raoolito

"Ok je mise sur un m4 au dernier trimestre 2024 !"

C’est toi qui offre la tournée de fondue si tu t’es planté !

pourvu que je me plante, c'est torp bon à partager çà ! 😛

On ne sait pas grand chose de la gestion memoire cpu/gpu non plus…

C'est bien beau tout ça mais quid du software qui saura s'en servir et de son optimisation ? Windows ARM ? L.O.L comme on dit chez les geeks de plus de 40 ans.

@aricoseco

Oui ils en parlent à à la fin de l'article parce que le hardware c'est une chose mais le software c'est tout aussi important

@aricoseco

"Windows ARM ? L.O.L comme on dit chez les geeks de plus de 40 ans."

Je suis un geek de plus de 40 ans et on ne dit pas ça chez moi.

« Plus rapide que l’Apple M3 »

Encore heureux… 8 cœurs vs 12 cœurs. 😂

@Nexon99

Apple compare aussi des puces qui ont aussi plus de cœur en disant que c’est incroyable, 40% plus puissant, tout en ayant 40% plus de cœur…

@redchou

Les comparaisons que j’ai vu personnellement portaient sur les hauts de gamme de Intel, et avaient donc plus de cœurs ainsi qu’une fréquence plus élevée (je ne parle même pas de la conso). On était sur des i7/i9 à plus de 12 cœurs facile.

Apres j’ai peut-être loupé un truc. 🤷🏻♂️ Mais je ne me rappel pas avoir vu une tels comparaisons.

En plus, là on a une comparaison d’un CPU d’entrée de gamme, contre un CPU censé être le « haut de panier », et c’est seulement ~20% plus puissant pour un TDP de 80W, contre 20W, et inférieur à 30W à fond pour la M3.

Il n’y a rien d’extraordinaire là dedans. Il rattrape un peu leur retard, et ça reste de belles performances parce que c’est l’équivalent d’un M3 Pro, mais ils sont encore loin de ce que propose Apple globalement, surtout niveau conso. 😅

@Nexon99:

Non, les comparaisons qu'ont fait Apple, c'est en rapport aux procs intel qui équipaient les anciens Mac...

Quand ils sortent le M1, ils le comparent aux i7/i9 qui équipaient les macs, pas à ce qui se faisait de mieux à cet instant (Intel avait déjà sorti de nouveau proc) et c'est même permis de dire que la partie GPU était à niveau des 3080. Ce qui était faux pour la partie GPU, le M1 était largement en dessous, les softs l'ont démontré après.

Après Apple reste largement devant en terme de perf/watt, mais en gros sur un studio, on en a un peu rien à carré.

Apple a fait un SOC dédié aux portables et ils ont mis ces Soc aussi dans les machines fixes.

Apple fait de l'Apple, tout comme aux temps de l'iMac qui embarquaient en fait des composants de portables, et quand ils mettaient un truc un peu péchu, ils étaient obligé de sous cadencer le tout. Rentabilité assurée.

@debione

Ah là tu parles plutôt des générations de processeurs là. Car la comparaison avec le M1 était faites avec le i9-9880H par exemple (si je ne me trompe pas) pour le cas du MacBook Pro, et il possédait aussi 8 cœurs. Après je trouve ça normal de comparer des processeurs qui équipaient les anciens modèles. Ça permet d’avoir une idée de l’évolution des performances par rapport à ce qui existait déjà.

De même qu’ils ont comparés la partie GPU avec la 3080, ET avec leurs anciens modèles (AMD).

S’ils avaient comparé avec un modèle autre (modèle desktop par exemple), ça aurait été un peu plus confus pour le client je pense, même si les performances n’étaient pas si éloignés que ça sur la plupart des tests.

Concernant la comparaison avec la 3080, le graphique et le texte était un peu confus mais ils parlaient de la consommation à puissance égale, soit autant de x performance pour une consommation 40% moins élevées.

« À son maximum, la puce M1 Max offre de meilleures performances - tout en consommant 40 % d'énergie de moins - qu'un ordinateur portable pro compact équipé d'un GPU distinct ultra-performant. Et par rapport à un ordinateur portable haut de gamme équipé d'une carte graphique distincte, la M1 Max livre des performances équivalentes en consommant 100 watts d'énergie de moins qu’une carte graphique de portable PC haut de gamme. »

Mais le graphique indiquait que le GPU dédié était plus puissant en quelque sortes, car les Watts n’allaient que jusqu’à 180W, et on sait tous que les CG dédié frôlent aisément les 450W pour les gros modèles.

Il n’était pas dit que la M1 Max était plus puissante qu’une 3080.

—

En finalité, Qualcomm compare son SoC avec 12 cœurs avec une cadence légèrement supérieure, en face d’un SoC d’entrée de gamme qui en a 8. Ça n’a rien d’exceptionnel selon moi et il n’y a pas besoin de s’en vanter.

Parce que en face du M3 Pro qui a 2 cœurs en moins, il fait à peine mieux, tout en ayant une conso de malade.

C’est un belle perf pour un début je le conçois, mais ce n’est pas aussi bien qu’Apple pour le moment. Mais ça a le mérite d’être un concurrent intéressant.

@Nexon99:

"Après je trouve ça normal de comparer des processeurs qui équipaient les anciens modèles. Ça permet d’avoir une idée de l’évolution des performances par rapport à ce qui existait déjà."

Normal, de mon point de vue, uniquement sur le point marketing.

Quand tu utilises par exemple la suite Adobe, c'est très intéressant de savoir si tu as plus de puissance sur un Lenovo i7/4090 @ 3000 boules ou si tu as plus de puissance sur un M2 Max 14" au même prix.

La puissance en elle même n'a aucune importance, c'est un argument marketing. L'intéressant c'est la puissance délivrée à tel ou tel application et la façon de gérer cette puissance, de savoir si Premiere ou PS ou Protools tournera plus vite sur tel ou tel configuration. Ou si cela est notre souhait, le temps ou l'on pourra travailler sur tel ou tel application.

C'est d'ailleurs ce qui ne me fait plus qu'utiliser des applications cross-plateforme, avoir le choix lors du renouvellement de la partie puissance. J'ai une seule exception, et elle m'emmerde, car elle me demande de savoir si je suis prêt à mettre 3k sur la table, alors 1k dans le camps d'en face serait exactement ce que je recherche (mais ne possède pas le soft).

Reste à espérer que les intégrateurs des puces Qualcomm ne fassent pas la connerie d’Apple en utilisant des SSDs standards plutôt qu’une puce propriétaire introuvable.

.

Malheureusement quand Apple sort une mauvaise idée d’autres s’empressent de la copier.

On dit Risc-V et non pas Risk avec un k svp.

Risc-V est une architecture non seulement moins chère car libre mais aussi plus moderne (récente) donc a priori plus capable (puissance économie d'énergie etc.). Les chinois et russes investissent dessus pour ne rien devoir aux occidentaux. Wait&see... Mais il y aura sûrement donc 3 architectures , gammes de CPU.

Comme les OS, vous oubliez le 3e, ChromeOS, qui se vend plus que des MacOSX aux USA : et là oui Chrome tourne sur ARM (Mediatek notamment) et même très bien ! Normal, Chrome c'est Google qui fait Android et Chrome mobile sur ARM: y'a pire ;) donc un Chrome ARM sous Windows, c'est plié.

Perso j'attends depuis longtemps un bon Chromebook sous ARM avec 5G et enfin libre des mots de passe Wi-Fi et des virus, vive la liberté ! Ça tombe bien mon vieux MacBook Air de 2014 vient de rendre l'âme (il n'a pas dû supporter quelques gouttes d'eau...), et Noël approche.

Ou mieux, des lunettes AR X-Real ou Rokid sous Android (connecté directement à mon smartphone récent , qui est plus puissant que mon vieux Mac): un (ou plusieurs ) écran de 3m à 4m devant moi, en marchant, 170g au lieu de 1300g, pas mieux!

@Nhugodot

Tout ça c'est possible, mais il y a quand même deux points À noter.

1-quand on lis les articles dédiés à cela dans le club igen on a une décennie devant nous avant d'avoir quelque chose d'utilisable. Il semble se diriger beaucoup plus vers l'Internet des objets.

2-la quasi-totalité des grands groupes ont des départements dédiés au développement sur risc-v Apple et les autres. Juste qu'on n'en parle pas c'est pas pareil, parce que ça n'intéresse personne de commun.

"On dit Risc-V et non pas Risk avec un k svp."

Il y en a un qui a pensé au jeu de plateau et tout le monde a suivi ^^

Sinon pour la Chine, il y avait cet article récemment :

https://www.macg.co/materiel/2023/11/les-puces-chinoises-loongson-se-rapprochent-peu-peu-des-cpu-occidentaux-140269

Je me demande si les Chinois ont vraiment intérêt à miser sur RISC-V. Open, c'est cool, mais au final il y a un pilotage et le siège est en Suisse. S'ils veulent leur projet, pilotés par eux et eux seuls, je me demande si c'est vraiment possible en utilisant RISC-V comme base.

@jackhal:

"Il y en a un qui a pensé au jeu de plateau et tout le monde a suivi ^^"

Je plaide complètement coupable votre honneur...^^

J'y jouais il y a fort longtemps avec ma grand-maman...^^

Et quid de la consommation ???

Sur le papier la concurrence c'est bien, après dans la réalité j'y crois pas plus que ça pour déplacer les lignes. Si vous voulez du ARM super bien supporté avec un écosystème aux petits oignons c'est chez Apple et je pense que personne ne se souciera de quelques Benchmark qui donnent une avance sur une puce concurrente.

Car tout est histoire de software et d'écosystème. MS a fait une erreur monumentale en laissant tomber Windows Phone (même leur CEO qui a fait cette énormité le dit), ce qui fait que Microsoft n'a pas d'écosystème et que donc ils ne peuvent pas faire une synergie aussi poussée qu'Apple entre le hardware et le software. Donc quelle est l'utilité d'ARM sur Windows? Sur fixe, c'est clairement mort et sur portable les dernières puces intel ont l'air top et font tout tourner en natif.

C'est surtout Google qui aurait une partition à jouer et pourrait même débouloner MS en entreprise, mais bon Google et stratégie Produit à long terme...

Au contraire, MS a bien fait d’abandonner Windows phone puisque aujourd’hui android est bien intégré dans l écosystème Windows avec des fonctionnalités similaires qu’entre iPhone et Mac et aussi les apps android.

Sachant qu’android est l’os mobile qui domine la planète, c’est un bon move.

Vous trouvez? Je ne nie pas que MS se donne du mal à essayer d'intégrer Android au mieux mais vu que Google ne montre aucune envie de collaborer, je trouve que ça ressemble toujours à du bricolage.

Perso le Lumia 920 reste pour moi l'un de mes meilleurs Smartphones avec des "features" à l'époque qui sont devenus seulement depuis peu de temps standard chez les autres (Stabilisation optique, photo de nuit, Bokeh, Photo live, recharge Qi, Always on Display). Certes on avait moins d'Apps que les autres OS mobile, mais ça marchait très bien et le système avait plein de bonnes astuces (le système d'Hub). Si on est méchant, on pourrait dire que MS récolte les fruits de son manque de tenacité. Surface RT était le Windows ARM déjà à l'époque et Windows Phone un truc avec du potentiel. Certes les ventes ne suivaient pas mais la direction était la bonne et MS aurait du améliorer ses produits et y croire. (ils avaient même un bracelet santé...).

Aujourd'hui je n'achète plus de Matos MS à cause de cette façon de lâcher leur propre produit. (Dernière exemple en date avec la surface Duo) Chez Apple au moins, il y a un certains respect pour les gens qui investissent dans leur matos.

@Glop0606:

"Aujourd'hui je n'achète plus de Matos MS à cause de cette façon de lâcher leur propre produit."

Il en va de même chez Apple, et c'est en fait moins rigolo que dans le monde d'en face, car excepté changer d'éco-système, tu te retrouves le bec dans l'eau. Je cite en vrac:

-L'imac 27"

-les iPods

-les petits écrans smartphone

-les mbp 17"

...

Ce ne sont pas en fait des question de "respect", mais de rentabilité/halo. En abandonnant la surface duo, les utilisateurs ne se sont pas retrouvé sans rien. Une fois la durée de vie terminée, ils peuvent tout à fait aller sur d'autres matos. Les softs acheté seront utilisables.

Si demain Apple arrête les iPads(!), les clients n'auront aucun autre choix pour faire tourner leurs softs tablette qu'ils ont acheté.

Je suis chez la concurrence depuis que j'ai eu l'impression de l'arnaque total sur mon iPhone6. Depuis j'ai possédé un Xperia (meilleur smartphone que j'ai eu avec le recul, oublié dans un taxi dans une mégapole asiatique), un Samsung mort dans de la vinasse, un Nokia très entrée de gamme qui tourne toujours bien et un Oppo pour le boulot. Du coup, une marque peu bien arrêter un produit, cela ne me gêne absolument pas... D'autant plus si tu utilises un launcher et que tu retrouves toujours exactement la même config après restauration. Si il y a un truc dont je me fous bien, c'est que la gamme que j'utilise actuellement ne soit pas renouvelé.

Il faut aussi voir que Microsoft peut se permettre sur le matos ce qu'Apple peut se permettre sur le soft. Et ils le font les deux.

Question respect? il n'y en a pas, ni d'un côté, ni de l'autre. Match nul.

Je crois que c’est clair !

Apple doit pour les M4+ ajouter des cœurs CPU et GPU (pour ne pas être trop largué par Amd et Nvidia)

Cette communication ne sert pas à grand chose tant qu'on n'a pas les performances en single-core et le prix d'une machine pour comparer. Parce que sinon y en a des pelletés des CPU qui sont plus puissants que le M3 de base en multicore, y compris sur ARM.

Mais sinon c'est une bonne nouvelle. Avec un gros GPU on peut imaginer que le PC ARM va enfin commencer à être pris au sérieux. Pas de quoi effrayer Apple, mais Intel doit l'avoir un peu moins bonne

@joneskind

"mais Intel doit l'avoir un peu moins bonne"

Je ne sais pas ça. Les vrais concurrent d’Intel sont AMD côté CPU et Nvidia côté GPU. Intel se fait tailler les oreilles. Ils n’ont jamais été compétitifs coté GPU (sauf en parts de marché généraliste). Ils perdent maintenant la compétition coté CPU.

Il y a même des bruits qui circulent dans le milieu que la chute entamée ne pourra pas être arrêtée durant cette décennie.

Clairement ils l’ont mauvaise. Mais pas à cause de Qualcomm. Not yet.

Pages