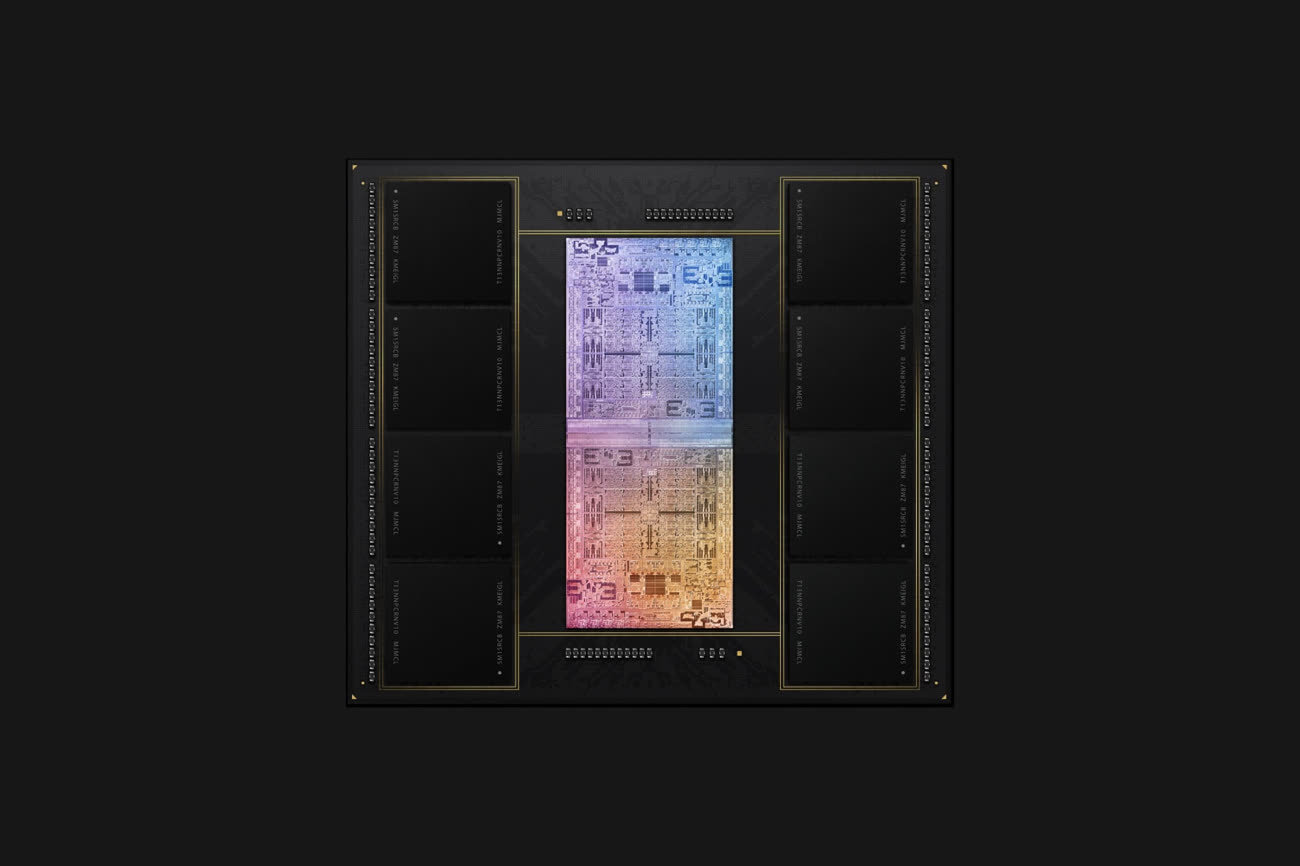

Lorsqu’elles sont unies par les liens d’un interconnecteur UltraFusion, deux puces M1 Max « fonctionnent comme une seule puce », la fameuse M1 Ultra. Il n’empêche qu’il reste possible de distinguer les deux hémisphères du cerveau du Mac Studio.

La puce M1 Max possède deux clusters de quatre cœurs Firestorm, des P-clusters chargés des calculs complexes, et un cluster de deux cœurs Icestorm, un E-cluster plus économe. Une puce véritablement unifiée possèderait deux P-clusters de huit cœurs et un E-cluster de quatre cœurs, mais la puce M1 Ultra possède deux paires de P-clusters de quatre cœurs et une paire d’E-cluster de deux cœurs.

Que les choses soient bien claires, cela ne fera aucune espèce de différence pour le développeur moyen, le problème de la répartition des tâches étant largement abstrait par Dispatch. Johny Srouji, vice-président d’Apple en charge des technologies matérielles, précisait d’ailleurs que le système M1 Ultra apparaissait comme une seule puce « du point de vue du logiciel ».

Les cœurs Icestorm peuvent fonctionner à 600, 972, 1 332, 1 704, ou 2 064 MHz. Les cœurs Firestorm peuvent atteindre 3 228 MHz avec des paliers à 600, 828, 1 056, 1 296, 1 524, 1 752, 1 980, 2 208, 2 448, 2 676, 2904, 3 036, 3 132, et 3 168 MHz. Chaque P-cluster peut gérer la fréquence de ses cœurs indépendamment de l’autre, la fréquence maximale baissant avec le nombre de cœurs actifs.

Contrairement au MacBook Pro 16" à puce M1 Max, le Mac Studio ne possède pas de réglage du « mode performance »… parce qu’il est activé en permanence. Dans nos premiers tests, le Mac Studio doté d’une puce M1 Ultra à vingt cœurs est presque exactement deux fois plus rapide que le modèle équipé d’une puce M1 Max à dix cœurs. UltraFusion n’est pas juste une illusion.