Grosse mise à jour pour l’application Ollama, qui permet de faire tourner un modèle de langage en local. Celle-ci s’occupe de préparer un serveur local avant de récupérer des modèles optimisés pour les ordinateurs grand public. Elle vient de passer en version 0.9.5, qui lui apporte une cure minceur en plus d’une connectivité réseau.

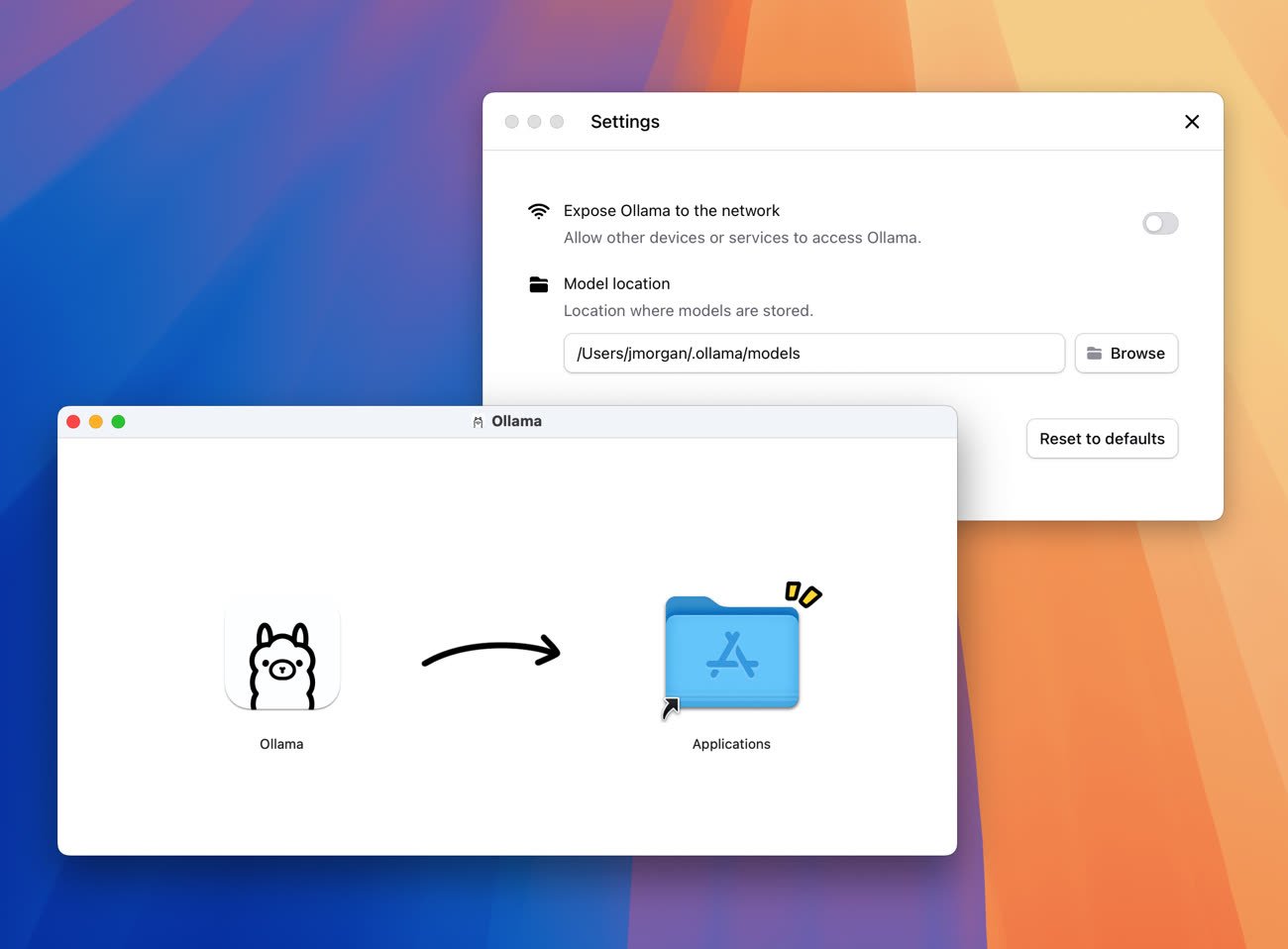

Ollama est désormais une application native pour macOS, et ça se sent : on passe de 452 Mo à 115 Mo, et les temps de chargements sont réduits. L’app a également gagné une petite interface graphique pour les réglages, permettant de changer le dossier dans lequel sont sauvegardés les modèles. Pratique pour les garder sur un disque dur externe, ou simplement dans un autre endroit que le répertoire par défaut. Attention toutefois, car le gros de l’utilisation continue de passer par le terminal, comme nous l’avions expliqué dans notre guide :

Comment faire tourner DeepSeek-R1 (ou un autre LLM) sur votre Mac

Enfin, l’app s’ouvre à Internet et permet désormais d’exécuter un modèle sur un Mac avant d’y accéder depuis un autre appareil. On pourra par exemple faire tourner un LLM sur son Mac Studio constamment allumé, puis l’interroger depuis un simple MacBook Air en déplacement. Ollama est disponible sur macOS, Windows et Linux. Vous pouvez trouver plus d’informations sur son fonctionnement sur la page Github du projet.