IA : Apple publie un modèle pouvant faire de grosses retouches photo sur simple demande

Apple continue de discrètement présenter ses avancées liées à l’intelligence artificielle. L’entreprise a mis en ligne un nouveau modèle baptisé MGIE permettant de modifier une image à l’aide d’indications données de manière naturelle. Il peut gérer différents aspects de la retouche, que ce soit des changements précis ou beaucoup plus généraux.

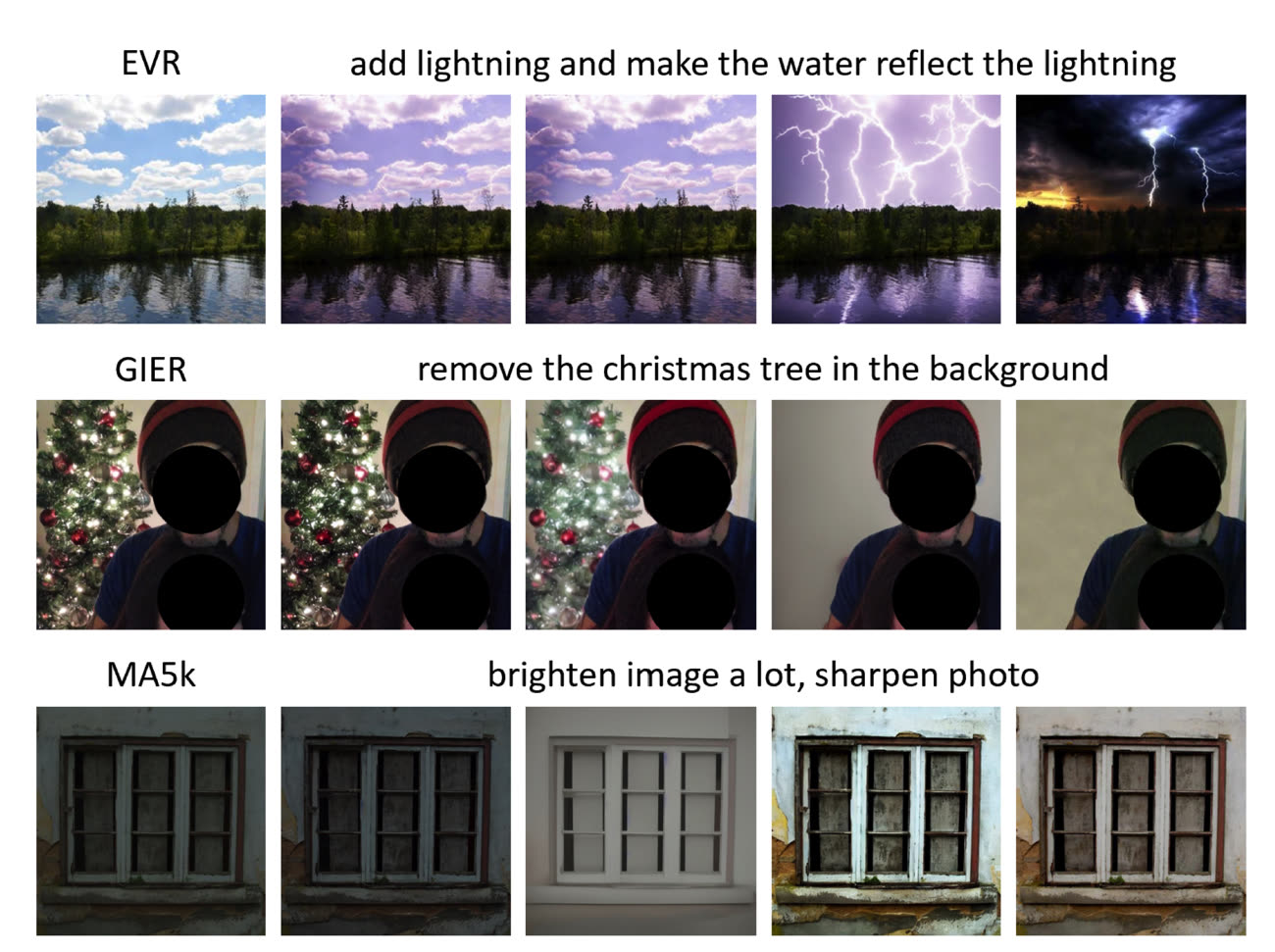

MGIE (pour MLLM-Guided Image Editing) repose sur l’utilisation d’un modèle de langage multimodal pouvant à la fois interagir avec des images et du texte. Il peut gérer différentes manipulations : recadrer une photo, ajouter un filtre, changer l’arrière-plan, supprimer des objets… De manière plus globale, le modèle peut améliorer la qualité de la photo en retouchant la luminosité, le contraste ou les couleurs. Il pourra carrément changer le style d’une photo en y ajoutant des effets artistiques, donnant par exemple un style cartoon ou de peinture.

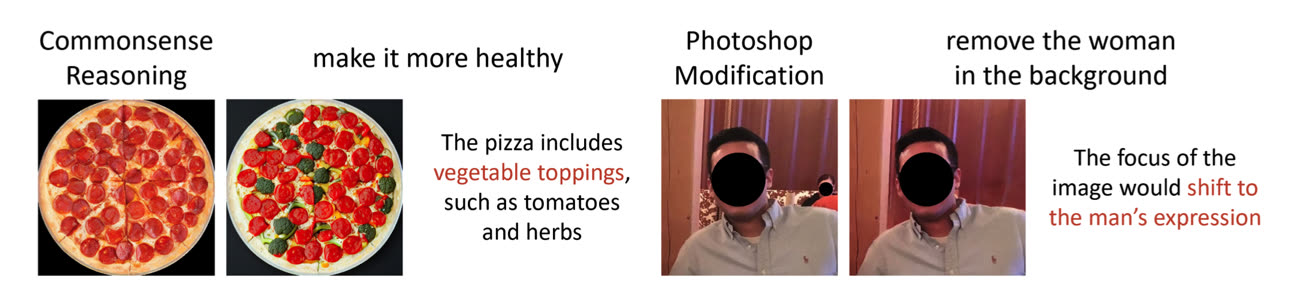

Mais MGIE peut aussi modifier certaines parties spécifiques d’une image, par exemple en retouchant les cheveux d’une personne ou ses habits. La couleur, taille ou texture des différents éléments pourra être modifiée. Il est également possible d’effacer de manière naturelle certains éléments, ou bien encore d’en ajouter d’autres. Le modèle est en capacité de raisonner : si l’utilisateur lui demande de rendre une pizza « plus saine pour la santé », l’IA ajoutera des légumes à la garniture. Le modèle a été créé en partenariat avec des chercheurs de l’université de Californie, et est disponible sur GitHub (une démo est proposée via navigateur).

Apple suit de près le développement des IA liées aux images. Elle a présenté en début d’année son modèle multimodal Ferret, qui peut identifier les différents éléments d’un cliché pour en faire des déductions. En novembre dernier, Cupertino avait publié un rapport sur une nouvelle technologie de génération d'images et de vidéos.

Si rien n’est visible pour le moment sur nos appareils, on peut s’attendre à ce que toutes ces découvertes émergent d’une manière ou d’une autre dans iOS 18, qui devrait être une mise à jour d’ampleur « historique ». Les rumeurs voudraient que l’IA soit au cœur d’une grosse refonte de Siri, tout en infusant dans différentes parties du système (suite iWork, Xcode, Apple Music…). Fin décembre dernier, Apple a publié un travail de recherche montrant comment utiliser la mémoire flash d’un appareil pour faire tourner un modèle d’IA.

Allez boire une tisane et détendez vous… Qu’Apple travaille sur l’IA, c’est pas un scoop. On verra bien ce qui en sortira. Et, oui, on espère un Siri aux stéroïdes !

Un peu comme si un cancre pouvait d’un coup sauter plusieurs classes…

Dis Siri ! Supprime la barrière de la photo.

« Désolé! Je n’ai pas trouvé cela dans votre bibliothèque musicale »

C’est pas gagné !!!

@kafy28

J’ai cru que sur la dernière phrase de ton commentaire t’avais répondu : « C’est pas grave »

😂

@kafy28

C’est tellement ça ! 😂😂🤣

Les exemples de « Commonsense Reasoning » et de manip PhotoShop illustrent le genre de problèmes de fond liés aux LLM : la qualité des training sets, mais surtout la qualité des esprits qui les sélectionnent et les guident.

Qui décide de ce qui est « plus sain » sur pizza ? Pour qui, quand, en fonction de quels critères ? La marge laissée à une idéologisation subtile mais pervasive est vaste, au point d’apparaître infinie. Et n’oublions pas que le « Commonsense Reasoning » est l’argument massue des populistes de tout bord.

Le deuxième exemple, « remove the woman in the background », est encore plus pernicieux. Alors que l’idéologie ambiante exaspère par sa négation des faits biologiques, en voulant confondre les déterminants génétiques et la fluidité, inaliénable individuelle à chaque humain, du spectre d’identités, de genres et de sexualités assumées, ce genre de reconnaissance d’image passe nécessairement par une cimentation statistique des dichotomies biométriques. Une sorte de test de Turing visuel, et surtout inversé, qui conforte les stéréotypes.

Le dialogue menant au résultat imagé aurait dû comporter au moins la question « Which figure is ‘the woman’ ? ». Mieux, il aurait dû indiquer : « Please use neutral terms. Do you wish to eliminate the figure in the background ? »

On pourra toujours se demander par quels biais congnitifs l’équipe d’Apple a cru convenable d’éliminer une femme plutôt qu’un homme. Juste pour l’exemple.

C'est la première fois que je google chaque ligne d'un commentaire

@ occam

> On pourra toujours se demander par quels biais congnitifs l’équipe d’Apple a cru convenable d’éliminer une femme plutôt qu’un homme. Juste pour l’exemple.

Apple n'a rien décidé.

Ce sont les données d'entrainement qui sont probablement biaisées.

Hier soir il y a eu une émission très intéressante au sujet des "IA" sur LCP.

Peut-être peut-on encore la voir.

Quoiqu'il en soit, ils rappelaient que le gros risque des IA entrainées sur des jeux de données énormes, ce sont les biais cognitifs.

Exemple : Si vous montrez une photo d'un passant à Monsieur Dupont, et que vous lui demandez s'il lui paraît suspect, j'imagine que vous ne prendrez pas son avis pour argent comptant. Que vous vous doutez qu'il peut ne pas être objectif, par exemple, s'il a eu dans le passé des problèmes avec des personnes, disons de la même origine que le passant de la photo.

Or, si vous entrainez une IA avec les avis de cent mille personnes, celle-ci va en déduire des tendances statistiques. Mais elle sont biaisées, car les données de départ son biaisées !

Mais le fait que les résultats sont présentés par ces systèmes comme s'ils étaient vérité vraie entraine une double tromperie:

1. Il y n'y a aucune garantie sur le résultat (uniquement une garantie en termes de probabilité, mais celle-ci n'est jamais fournie).

2. Vous écoutez une machine. Et, concentré sur le résultat attendu, vous ne savez pas ou vous oubliez qu'elle ne fait en vérité que vous raconter les sornettes

entendues dans la ruelues dans le jeu de données d'entrainement.Ce n'est pas de la fiction :

Aux USA il y a des tribunaux avec de juges qui consultent l'avis d'une IA en live pour "connaître" les risques de récidive et adapter la peine en fonction de ces risques !

Or il s'avère qu'après études "post sortie de prison" pour compter les récidives qui ont réellement eu lieu, il a été constaté que la probabilité de récidive avait été largement sur-évaluée pour la population noire, et sous-évaluée pour la population blanche qui a en vérité commis plus de récidives que "prévu".

Il s'agit là clairement d'un biais qui s'avère être un bias raciste.

Ce qui est logique, car le jeu de données pour l'entrainement a été constitué dans une population en majorité "raciste", ou tout du moins qui croit en majorité ceux qui prétendent que la récidive seraient supérieure chez les gens "de couleur".

Hâte d’être en juin 2024 et de voir comment les ingénieurs et les équipes produit d’Apple ont imaginé tout ça. J’espère voir un peu de magie et pas une intégration basique 😁

@YosraF

"J’espère voir un peu de magie"

Tu veux dire de MGIE ?

@Brice21

😂👍

@Brice21

Joli!

Une IA ben pourquoi faire y'a déjà Siri...

@ Félix

> Le modèle est en capacité de raisonner

Désolé de dire ça, mais cette remarque semble montrer que vous n'avez pas bien compris ce qu'est vraiment ce qui est présenté comme « IA » actuellement.

Rappel: L'IA, c'est une domaine de recherche depuis plus de 30 ans dont le langage Prolog fut un outil, de la même manière que les réseaux de neurones et le machine learning d'aujourd'hui.

Et les "IA" d'aujourd'hui sont en fait des méthodes statistiques. Après avoir ingurgité des millions de données, ces IA savent déduire des généralités, des tendances, etc. Leurs résultats n'ont aucune garantie d'être "vrais". Ils sont uniquement les résultats les plus probables au moment de la requête.

Bref, ces IA ne tiennent absolument aucun raisonnement - qui serait comparable au raisonnement d'un être humain. D'ailleurs si à ses débuts les ingénieurs cherchaient à reproduire notre raisonnement, ce n'est plus le cas aujourd'hui.

Avec une IA basée sur des raisonnements, on peut les comprendre.

Aujourd'hui, les "IA" sont des boites noires incompréhensibles.

Ça n'a rien à voir.

Ce qui ne veut pas dire que ce n'est pas efficace dans des domaines précis.

Dans l’exemple de la fenêtre, l’IA n’a visiblement pas compris l’injonction : Sharpen photo :D

Pages