À défaut d'acquérir Imagination Technologies, Apple recrute plusieurs de ses ingénieurs ainsi que son directeur de l'exploitation, John Metcalfe. Un petit tour sur LinkedIn révèle qu'au moins quatre ingénieurs du spécialiste des puces graphiques ont rejoint Apple récemment, sans doute à la faveur de la vague de suppression de postes annoncée en début d'année.

MacRumors s'est laissé entendre dire que la Pomme a mis en place une équipe dédiée au développement d'un GPU maison à Londres, à proximité du siège d'Imagination.

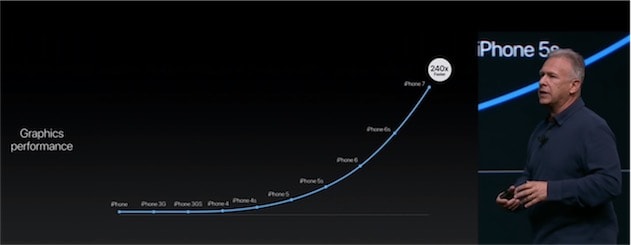

Il s'agit d'un partenaire de premier ordre pour Cupertino, puisque c'est lui qui conçoit les GPU (PowerVR) des terminaux iOS — qui sont ensuite customisés par les équipes de Johny Srouji. En mars dernier, Apple avait démenti une rumeur d'acquisition de l'entreprise britannique, tout en précisant qu'il y avait bien eu des discussions à ce sujet.

En 2013, Apple avait déjà profité de la restructuration d'une entreprise pour faire grossir ses rangs de spécialistes en GPU. Il s'agissait alors d'AMD.