« Les iMac apprennent à coder les couleurs sur 10 bits », proclame le blog Mac & i, relayé par MacBidouille. Après vérification pourtant, il semble que les choses soient plus compliquées qu’il n’y paraît. Si notre iMac Retina 5K code bien les couleurs sur 10 bits, ce n’est pas le cas de son petit frère l’iMac Retina 4K.

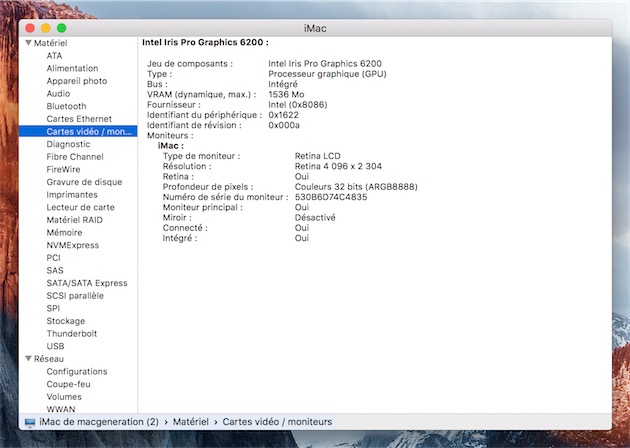

Ce que cela change ? L’écran de l’iMac Retina 4K fin 2015 est un écran ARGB8888, ce qui signifie que chacun de ses pixels est défini par quatre bytes de huit bits, autrement dit quatre octets. Le byte A code la transparence (alpha), R le rouge, G le vert (green), et B le bleu. Chacun de ses bytes contient huit bits, ce qui signifie qu’il peut « stocker » 256 valeurs. La transparence n’étant utilisée qu’au calcul, l’écran peut donc afficher 256x256x256 couleurs, soit 16,8 millions de couleurs(*).

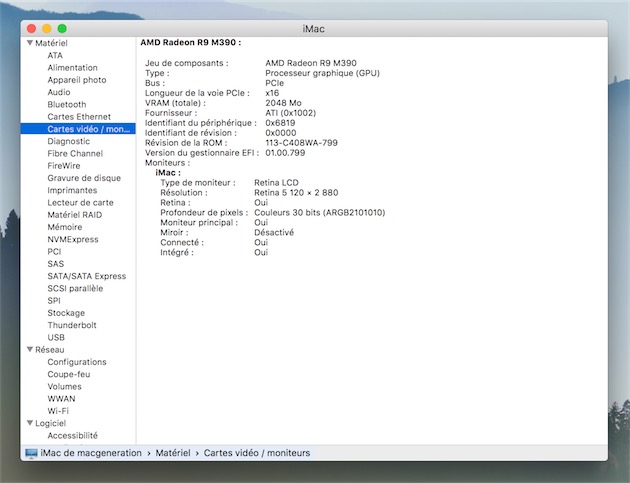

L’écran de l’iMac Retina 5K fin 2015 est un écran ARGB2101010 : la couche alpha est codée sur deux bits, tandis que chacune des couleurs primaires est codée sur dix bits. Ces 10 bits permettent de « stocker » 1 024 valeurs : l’écran peut donc afficher 1 024x1 024x1 024 couleurs, soit plus d’un milliard de couleurs. Cette plus grande précision prévient notamment le phénomène de banding, qui se manifeste par l’apparition de bandes dans des dégradés de couleurs très proches, comme dans l’étendue d’un ciel bleu.

Nous avions mesuré une légère différence entre l’écran de l’iMac Retina 5K et celui de l’iMac Retina 4K, mais pas suffisante pour qu’elle puisse être considérée comme sensible, au contraire de leurs problèmes d’uniformité (lire : Test de l’iMac 21,5" Retina 4K (fin 2015)). Nos outils sont-ils défaillants ? Le signal DCI P3 est-il compressé sur le modèle 21,5 pouces ? Difficile de le dire à ce stade. Une chose est sûre : le gain est d’autant moins visible que les systèmes OpenGL sont encore limités à 8 bits dans la plupart des cas, et qu’il faudra sans doute attendre des optimisations avec Metal pour profiter pleinement du codage sur 10 bits.

Reste que les photographes prenant des fichiers RAW de 12 ou 14 bits et les graphistes travaillant sur des fichiers 16 bits attendaient avec impatience cette avancée, d’autant plus que les PC prennent en charge les écrans 10 bits depuis Windows 7. Mieux : les écrans 10 bits reliés à l’iMac Retina 5K fin 2015 sont désormais pleinement gérés par OS X El Capitan. Selon Mac & i, cette prise en charge s’étend même aux iMac Retina 5K fin 2014, qui passent de 8 à 10 bits avec OS X 10.11.1. Nous n’avons malheureusement pas le matériel nécessaire pour vérifier ces deux dernières informations.

(*) Les choses sont encore plus compliquées en réalité, mais ce résumé suffit largement pour comprendre la différence.