En début d'année, Intel avait lancé une campagne intitulée "Vous n'êtes pas sur Mac" destinée à dénigrer la nouvelle puce M1 d'Apple. Cette communication mettait en avant diverses lacunes des ordinateurs Apple, comme l'impossibilité de jouer ou l'absence d'écran tactile. Le fondeur avait également diffusé plusieurs benchmarks (dont certains étaient discutables) pour affirmer la supériorité de ses processeurs.

Les relations entre les deux nouveaux adversaires ne vont pas s'améliorer après la diffusion hier d'une nouvelle campagne présentée lors du Computex 21. Celle-ci a été dévoilée à l'occasion de la sortie des nouveaux processeurs 11è génération Série H d'Intel.

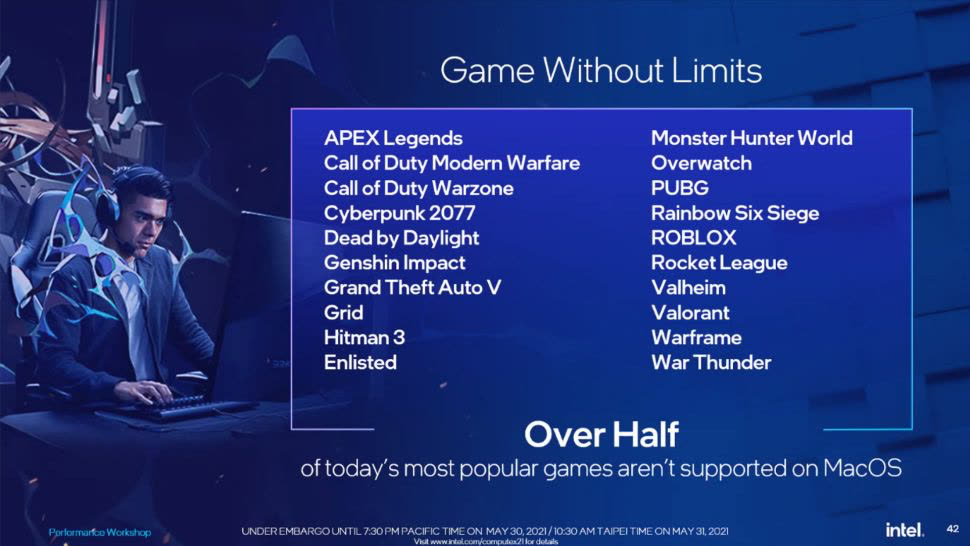

D'après l'entreprise, les Mac sont des produits inférieurs de par le manque de compatibilité avec les jeux : le fabricant en a profité pour publier une liste de titres, parmi les plus populaires, incompatibles avec macOS. Un argument qui ne date certes pas d'hier — c'est sur iOS qu'Apple a réussi à faire se rencontrer éditeurs et joueurs — mais qui reste valable : mis à part au travers de l'émulation, il est pour le moment impossible d'installer Windows directement sur un Mac M1.

Intel a également diffusé un benchmark opposant un MacBook Pro 16 pouces (le plus puissant commercialisé actuellement) à un ordinateur Intel. Sans surprise, celui-ci est à l'avantage d'Intel qui a évidemment soigneusement sélectionné les tests. La campagne vante aussi le fait que de nombreux créatifs sont des joueurs et vice-versa.

Interrogé par PCGamer, Ryan Shrout, Chief Performance Strategist chez Intel a justifié cette campagne par le fait qu'Apple n'avait fait « aucun mystère auprès des consommateurs du passage à ses propres processeurs » et qu'il considérait maintenant la firme de Cupertino comme un concurrent.