Avec le report de la sortie de Larrabee, qu'on attendait pour 2010, Intel vient d'essuyer un lourd revers. Le fondeur avait en effet placé beaucoup d'espoir dans cette nouvelle technologie pour résister à la déferlante du GPGPU, et n'a pas hésité à peser de tout son poids pour gagner du temps, en vain.

L'augmentation transversale de puissance

Commençons par faire un bref récapitulatif : la logique d'augmentation de la fréquence d'horloge des processeurs est arrivée en bout de course lorsqu'elle a montré ses limites en matière énergétique. Nous sommes arrivés à un palier où, s'il est encore possible d'augmenter le nombre de cycles par seconde qu'un processeur peut effectuer, cette augmentation se fait cependant à un coût énergétique qui ne le justifie plus. Pour pallier cela, on s'est orientés vers une augmentation de puissance transversale, en augmentant le nombre de processeurs, et leur nombre de cores.

Cette nouvelle stratégie a ouvert la voie au calcul parallèle, autrefois réservé aux serveurs et aux "fermes de calcul", et l'a mis à la portée de l'ordinateur de monsieur tout le monde. Cependant, la nature des calculs est bien différente entre ces deux mondes : sur les serveurs, il est courant d'exécuter plusieurs tâches en simultané (initiées par autant de postes clients), alors qu'une telle opération est plus rare sur l'ordinateur personnel. Pour ces derniers, il a donc fallu entamer une révision de l'architecture des logiciels, en découpant les tâches en plusieurs opérations exécutées concomitamment, du moins lorsque la nature des calculs s'y prête : s'il est possible de transformer tout calcul parallèle en calcul séquentiel, l'inverse n'est pas pour autant vrai. Avec Snow Leopard, Apple a mis à disposition Grand Central Dispatch, un nouveau standard qui a pour vocation d'organiser le "triage" de ces différentes tâches au niveau du système d'exploitation afin de gagner en efficacité.

Le calcul parallèle attise l'intérêt pour les GPU

Mais en ouvrant cette voie avec les Core Duo puis les Core 2 Duo, Intel a ouvert la boîte de Pandore : quitte à paralléliser les calculs, autant les confier à des processeurs taillés pour de telles opérations, à savoir les GPU. En effet, les processeurs qui équipent les cartes graphiques sont capables de traiter un flot de données autrement plus conséquent que ce que traite un processeur standard : avec les pixel shaders, il est devenu possible de faire des calculs graphiques sur des textures entières en une seule passe, chaque génération de carte graphique supplantant la précédente dans ses capacités. Il suffit de convertir les données, de quelques natures qu'elles soient, en données bitmap, et de les faire traiter par le GPU, pour que ce dernier dépasse le cadre strictement graphique dans lequel il était jusqu'ici confiné. Le GPGPU (General Purpose Graphics Processing Units, Unités de Calcul Graphique à Usage General) était né.

Voilà qui n'était pas du tout du goût d'Intel : le GPGPU risquait bel et bien de déporter l'attention jusqu'ici accordée au processeur, de tout temps organe décisif quant à la vitesse de calcul d'un ordinateur, vers la carte graphique, et de reléguer au second plan un CPU en perte de vitesse. Le concurrent de toujours d'Intel, AMD, ne s'y est d'ailleurs pas trompé en faisant l'acquisition d'ATI. Pire encore, NVIDIA a sérieusement empiété sur la chasse gardée d'Intel en proposant des chipsets autrement plus performants que les siens avec leurs puces GMA. A tel point qu'Apple a remplacé les seconds par les premiers sur toutes les machines qui en faisaient emploi jusqu'ici.

Un processeur pour les gouverner tous

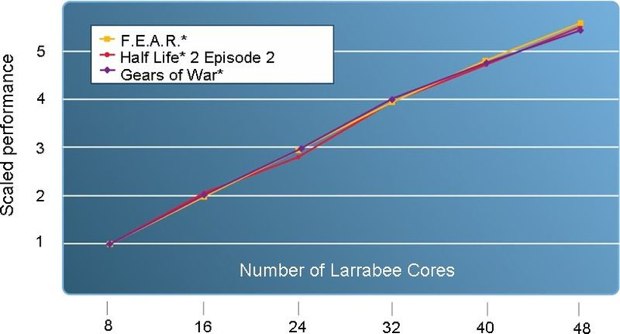

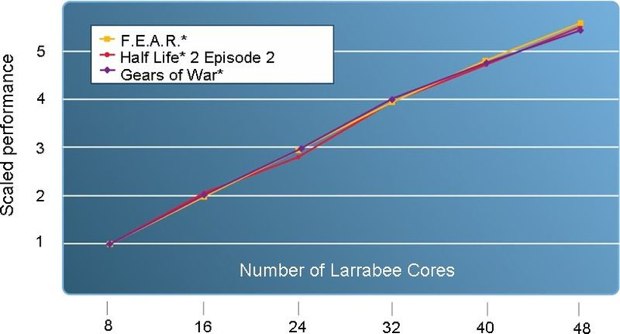

Intel, se voyant débordée sur son flanc, a donc réagi avec la dernière énergie pour mettre un frein à une telle concurrence. Dans un premier temps, le fondeur a annoncé une nouvelle génération de processeurs, sortes d'hybrides entre les GPU et les CPU : un processeur massivement parallèle, composé de plusieurs dizaines de cores x86, sous le nom de Larrabee.

Pour gagner du temps durant le développement de cette nouvelle technologie, Intel a mis un terme à l'accord de licence qui permettait jusqu'ici à NVIDIA de proposer des chipsets compatibles avec ses processeurs, arguant que celui-ci ne portait pas sur la famille de processeurs Nehalem. L'affaire est devant les tribunaux (voir notre article NVIDIA accuse Intel d'étouffer son innovation), et NVIDIA se voit contrainte de mettre un terme au développement de ses chipsets, en attendant que la justice tranche (voir notre article NVIDIA suspend ses développements de chipsets). Intel faisait d'une pierre deux coups : arrêter la progression des chipsets concurrents, et amoindrir l'impact du GPGPU, en gardant le contrôle du marché.

Intel fait tout pour reprendre la main

Naturellement, Intel a dès l'origine contesté vivement l'intérêt du GPGPU et s'est entêtée à ne livrer aucun driver permettant d'effectuer ce type de calcul avec ses puces graphiques. La société poussera la logique plus loin encore, en proposant des processeurs Arrandale qui incorporent une puce graphique en standard, coupant l'herbe sous le pied à toute concurrence : les constructeurs n'ont plus le choix ni du chipset, ni de la carte graphique qui équiperont leurs machines. S'il reste envisageable d'ajouter une seconde puce graphique sur les modèles haut de gamme, ça n'est pas le cas de l'entrée de gamme où chaque dollar compte. Cette stratégie ferait d'ailleurs l'objet de tensions entre Apple et Intel, des rumeurs affirmant que la firme de Cupertino ne tolérerait pas de se voir dictée la manière dont elle doit élaborer l'architecture de ses machines (voir notre article Vers un bras de fer entre Apple et Intel ?), ce qui cadre assez bien avec ce qu'on sait de la façon qu'Apple a de traiter avec ses fournisseurs. La lune de miel entre Apple et Intel semble être largement consommée : si Intel a régulièrement fourni ses derniers processeurs à Apple avec quelques semaines d'exclusivité et même créé un design pour le MacBook Air, Apple a montré quelque infidélité à son nouveau partenaire en se tournant vers les chipsets de NVIDIA, il est vrai autrement plus performants que les puces GMA, unanimement critiquées. Les GeForce 9400M font d'ailleurs partie des dernières cartes gérées par OpenCL, le standard qu'Apple a mis au point pour unifier un langage voué au GPU computing.

Illusions perdues

Alors que la Commission Fédérale du Commerce s'intéresse à la dispute entre NVIDIA et Intel dans le cadre de son enquête antitrust initiée suite à un litige avec AMD, soldé à l'amiable depuis (voir notre article La FTC se penche sur l'affaire Intel-NVIDIA), le compteur tourne et Intel ne parvient pas aux résultats escomptés avec Larrabee dans le temps qu'elle s'était imparti. De son propre aveu, d'ici à ce que Larrabee arrive à maturation pour être mis sur le marché, la concurrence (comprendre NVIDIA et ATI) aura amplement dépassé ses capacités. Initié en 2006, Larrabee devait arriver sur le marché l'année prochaine, la dernière démonstration publique en date remontant au mois de septembre, durant l'Intel Developer Forum. Celle-ci montrait un rendu en lancer de rayons (raytracing) en temps réel avec Ennemy Territory : Quake Wars (une démonstration qui date en fait de la Game Developer Conference de février 2008).

Cette démonstration est à remettre en perspective avec celle d'AMD, qui montrait une technologie comparable en juin 2008 (voir notre article Du cinéma 2.0 dans Mac OS X 10.5.5 ?).

Quelques mois plus tard, Intel décide donc de recycler la première version de Larrabee en outil de développement, et annonce son intention de poursuivre ses efforts directement sur une version 2, sans toutefois donner la moindre feuille de route. Difficile dans ces conditions de prédire si l'on verra un jour le fruit de ces recherches, ou s'il s'agit là d'une pirouette pour garder la face. Une chose est sûre, il s'agit là d'un amer constat d'échec pour Intel, et les méthodes discutables qu'elle a employées pour retarder ses adversaires l'auront été en pure perte, au détriment de l'industrie et des consommateurs. S'il fallait un seul élément pour se convaincre de l'échec d'Intel, on retiendra l'annonce de fonctions GPGPU pour les processeurs Clarkdale (voir notre article GPGPU : Intel finit par plier), alors que le géant de Santa Clara s'était jusqu'ici toujours refusé à une telle compromission.

Il reste toutefois quelques inconnues qui détermineront le déroulement à venir de la bataille. On se penchera avec beaucoup d'intérêt sur la prochaine mise à jour des portables d'Apple, qui devraient intégrer les fameux processeurs Arrandale, pour voir qui d'Apple ou d'Intel a fini par plier, en fonction de la carte graphique qui équipera les MacBook. On suivra également de près le feuilleton judiciaire avec NVIDIA, dont l'issue, qu'on attend dans le courant de l'année prochaine, influera lourdement sur l'industrie. Quoi qu'il en soit, il est probable qu'après cette déconvenue, Intel soit plus encline à lâcher du lest à ses partenaires, peut-être même décidera-t-elle de s'investir plus massivement dans le GPU, en guise de nouvelle stratégie : pour l'heure, la société se trouve plus démunie que jamais face à cette concurrence.

L'augmentation transversale de puissance

Commençons par faire un bref récapitulatif : la logique d'augmentation de la fréquence d'horloge des processeurs est arrivée en bout de course lorsqu'elle a montré ses limites en matière énergétique. Nous sommes arrivés à un palier où, s'il est encore possible d'augmenter le nombre de cycles par seconde qu'un processeur peut effectuer, cette augmentation se fait cependant à un coût énergétique qui ne le justifie plus. Pour pallier cela, on s'est orientés vers une augmentation de puissance transversale, en augmentant le nombre de processeurs, et leur nombre de cores.

Cette nouvelle stratégie a ouvert la voie au calcul parallèle, autrefois réservé aux serveurs et aux "fermes de calcul", et l'a mis à la portée de l'ordinateur de monsieur tout le monde. Cependant, la nature des calculs est bien différente entre ces deux mondes : sur les serveurs, il est courant d'exécuter plusieurs tâches en simultané (initiées par autant de postes clients), alors qu'une telle opération est plus rare sur l'ordinateur personnel. Pour ces derniers, il a donc fallu entamer une révision de l'architecture des logiciels, en découpant les tâches en plusieurs opérations exécutées concomitamment, du moins lorsque la nature des calculs s'y prête : s'il est possible de transformer tout calcul parallèle en calcul séquentiel, l'inverse n'est pas pour autant vrai. Avec Snow Leopard, Apple a mis à disposition Grand Central Dispatch, un nouveau standard qui a pour vocation d'organiser le "triage" de ces différentes tâches au niveau du système d'exploitation afin de gagner en efficacité.

Le calcul parallèle attise l'intérêt pour les GPU

Mais en ouvrant cette voie avec les Core Duo puis les Core 2 Duo, Intel a ouvert la boîte de Pandore : quitte à paralléliser les calculs, autant les confier à des processeurs taillés pour de telles opérations, à savoir les GPU. En effet, les processeurs qui équipent les cartes graphiques sont capables de traiter un flot de données autrement plus conséquent que ce que traite un processeur standard : avec les pixel shaders, il est devenu possible de faire des calculs graphiques sur des textures entières en une seule passe, chaque génération de carte graphique supplantant la précédente dans ses capacités. Il suffit de convertir les données, de quelques natures qu'elles soient, en données bitmap, et de les faire traiter par le GPU, pour que ce dernier dépasse le cadre strictement graphique dans lequel il était jusqu'ici confiné. Le GPGPU (General Purpose Graphics Processing Units, Unités de Calcul Graphique à Usage General) était né.

Voilà qui n'était pas du tout du goût d'Intel : le GPGPU risquait bel et bien de déporter l'attention jusqu'ici accordée au processeur, de tout temps organe décisif quant à la vitesse de calcul d'un ordinateur, vers la carte graphique, et de reléguer au second plan un CPU en perte de vitesse. Le concurrent de toujours d'Intel, AMD, ne s'y est d'ailleurs pas trompé en faisant l'acquisition d'ATI. Pire encore, NVIDIA a sérieusement empiété sur la chasse gardée d'Intel en proposant des chipsets autrement plus performants que les siens avec leurs puces GMA. A tel point qu'Apple a remplacé les seconds par les premiers sur toutes les machines qui en faisaient emploi jusqu'ici.

Un processeur pour les gouverner tous

Intel, se voyant débordée sur son flanc, a donc réagi avec la dernière énergie pour mettre un frein à une telle concurrence. Dans un premier temps, le fondeur a annoncé une nouvelle génération de processeurs, sortes d'hybrides entre les GPU et les CPU : un processeur massivement parallèle, composé de plusieurs dizaines de cores x86, sous le nom de Larrabee.

Pour gagner du temps durant le développement de cette nouvelle technologie, Intel a mis un terme à l'accord de licence qui permettait jusqu'ici à NVIDIA de proposer des chipsets compatibles avec ses processeurs, arguant que celui-ci ne portait pas sur la famille de processeurs Nehalem. L'affaire est devant les tribunaux (voir notre article NVIDIA accuse Intel d'étouffer son innovation), et NVIDIA se voit contrainte de mettre un terme au développement de ses chipsets, en attendant que la justice tranche (voir notre article NVIDIA suspend ses développements de chipsets). Intel faisait d'une pierre deux coups : arrêter la progression des chipsets concurrents, et amoindrir l'impact du GPGPU, en gardant le contrôle du marché.

Intel fait tout pour reprendre la main

Naturellement, Intel a dès l'origine contesté vivement l'intérêt du GPGPU et s'est entêtée à ne livrer aucun driver permettant d'effectuer ce type de calcul avec ses puces graphiques. La société poussera la logique plus loin encore, en proposant des processeurs Arrandale qui incorporent une puce graphique en standard, coupant l'herbe sous le pied à toute concurrence : les constructeurs n'ont plus le choix ni du chipset, ni de la carte graphique qui équiperont leurs machines. S'il reste envisageable d'ajouter une seconde puce graphique sur les modèles haut de gamme, ça n'est pas le cas de l'entrée de gamme où chaque dollar compte. Cette stratégie ferait d'ailleurs l'objet de tensions entre Apple et Intel, des rumeurs affirmant que la firme de Cupertino ne tolérerait pas de se voir dictée la manière dont elle doit élaborer l'architecture de ses machines (voir notre article Vers un bras de fer entre Apple et Intel ?), ce qui cadre assez bien avec ce qu'on sait de la façon qu'Apple a de traiter avec ses fournisseurs. La lune de miel entre Apple et Intel semble être largement consommée : si Intel a régulièrement fourni ses derniers processeurs à Apple avec quelques semaines d'exclusivité et même créé un design pour le MacBook Air, Apple a montré quelque infidélité à son nouveau partenaire en se tournant vers les chipsets de NVIDIA, il est vrai autrement plus performants que les puces GMA, unanimement critiquées. Les GeForce 9400M font d'ailleurs partie des dernières cartes gérées par OpenCL, le standard qu'Apple a mis au point pour unifier un langage voué au GPU computing.

Illusions perdues

Alors que la Commission Fédérale du Commerce s'intéresse à la dispute entre NVIDIA et Intel dans le cadre de son enquête antitrust initiée suite à un litige avec AMD, soldé à l'amiable depuis (voir notre article La FTC se penche sur l'affaire Intel-NVIDIA), le compteur tourne et Intel ne parvient pas aux résultats escomptés avec Larrabee dans le temps qu'elle s'était imparti. De son propre aveu, d'ici à ce que Larrabee arrive à maturation pour être mis sur le marché, la concurrence (comprendre NVIDIA et ATI) aura amplement dépassé ses capacités. Initié en 2006, Larrabee devait arriver sur le marché l'année prochaine, la dernière démonstration publique en date remontant au mois de septembre, durant l'Intel Developer Forum. Celle-ci montrait un rendu en lancer de rayons (raytracing) en temps réel avec Ennemy Territory : Quake Wars (une démonstration qui date en fait de la Game Developer Conference de février 2008).

Cette démonstration est à remettre en perspective avec celle d'AMD, qui montrait une technologie comparable en juin 2008 (voir notre article Du cinéma 2.0 dans Mac OS X 10.5.5 ?).

Quelques mois plus tard, Intel décide donc de recycler la première version de Larrabee en outil de développement, et annonce son intention de poursuivre ses efforts directement sur une version 2, sans toutefois donner la moindre feuille de route. Difficile dans ces conditions de prédire si l'on verra un jour le fruit de ces recherches, ou s'il s'agit là d'une pirouette pour garder la face. Une chose est sûre, il s'agit là d'un amer constat d'échec pour Intel, et les méthodes discutables qu'elle a employées pour retarder ses adversaires l'auront été en pure perte, au détriment de l'industrie et des consommateurs. S'il fallait un seul élément pour se convaincre de l'échec d'Intel, on retiendra l'annonce de fonctions GPGPU pour les processeurs Clarkdale (voir notre article GPGPU : Intel finit par plier), alors que le géant de Santa Clara s'était jusqu'ici toujours refusé à une telle compromission.

Il reste toutefois quelques inconnues qui détermineront le déroulement à venir de la bataille. On se penchera avec beaucoup d'intérêt sur la prochaine mise à jour des portables d'Apple, qui devraient intégrer les fameux processeurs Arrandale, pour voir qui d'Apple ou d'Intel a fini par plier, en fonction de la carte graphique qui équipera les MacBook. On suivra également de près le feuilleton judiciaire avec NVIDIA, dont l'issue, qu'on attend dans le courant de l'année prochaine, influera lourdement sur l'industrie. Quoi qu'il en soit, il est probable qu'après cette déconvenue, Intel soit plus encline à lâcher du lest à ses partenaires, peut-être même décidera-t-elle de s'investir plus massivement dans le GPU, en guise de nouvelle stratégie : pour l'heure, la société se trouve plus démunie que jamais face à cette concurrence.