« Nous avions fait électrifier une Renault Twingo au Tessin », raconte Marc Oehler, « c’était le premier véhicule électrique immatriculé dans le canton de Genève, mais elle est tombée en panne au milieu de l’autoroute ». C’est donc en Tesla Model 3 que le CEO d’Infomaniak nous emmène visiter son troisième data center, qui « dépasse les standards d’efficacité du marché » et utilise 100 % d’énergie renouvelable.

La localisation précise doit rester secrète : « on parle d’or numérique », dit Thomas Jacobsen, directeur du marketing et de la communication d’Infomaniak, « et ici il y a tous nos lingots ». L’emplacement du prochain data center de l’entreprise est pourtant connu : il sera bientôt construit dans le nouveau quartier de La Chapelle-Les Sciers, à quelques encablures du siège de l’hébergeur, où il intègrera le réseau de chaleur urbaine.

« Il faut arrêter les mégaprojets éloignés des centres urbains », explique Thomas Jacobsen, qui cite les immenses data centers installés par Google et Microsoft dans la campagne wallonne. Un data center peut être vu comme une manière de transformer l’électricité en chaleur par l’entremise de serveurs. L’indicateur d’efficacité énergétique, ou PUE pour power usage effectiveness, mesure la part des serveurs dans l’énergie consommée par le centre dans son ensemble.

Pour 100 W consacrés aux serveurs, le data center européen moyen consomme 40 à 60 W pour la climatisation et les autres besoins électriques, soit un PUE de 1,4 à 1,6. Infomaniak « gâche » seulement 10 W, et rivalise ainsi avec les plus grands noms de la Silicon Valley en affichant un PUE de 1,1. En s’installant au pied des immeubles plutôt qu’au milieu des champs, l’hébergeur suisse veut diriger toute cette énergie vers le chauffage de 1 400 logements.

Dès lors, le PUE importera moins que l’efficacité de la pompe à chaleur. En attendant l’inauguration du « DC IV » en 2024, le « DC III » représente le summum du savoir-faire d’Infomaniak, continuellement amélioré depuis son ouverture en 2013. Après avoir franchi les contrôles biométriques imposés par la norme ISO 27001, nous pénétrons enfin dans le saint des saints.

Les Services industriels de Genève fournissent plus d’un mégawatt d’énergie entièrement renouvelable1, qui arrive au centre du bâtiment, occupé par d’immenses tableaux électriques. Un niveau plus bas, « les onduleurs lissent le courant », explique Julien Bonnat, le directeur des opérations du data center. Tous les équipements sont dédoublés :

Nous avons quatre voies, deux rouges et deux vertes, que l’on peut suivre tout au long du data center. Deux onduleurs sont sur la voie verte, et les deux autres sur la voie rouge. Si je coupe un onduleur sur une voie, il reste le deuxième, et si je le coupe aussi, il reste la deuxième voie. Un seul onduleur peut soutenir la charge entière. Si nous perdons l’alimentation électrique, les batteries prennent le relai, et peuvent assurer une dizaine de minutes d’autonomie en attendant le démarrage des groupes électrogènes.

Une coupure « n’est pas impossible », explique Marc Oehler, « mais très improbable. Nous faisons le maximum pour éviter que cela arrive. » « Notre angoisse principale, c’est l’interruption de service », ajoute Thomas Jacobsen, « nous devons faire en sorte que les gens ne s’imaginent pas que tout cela existe ».

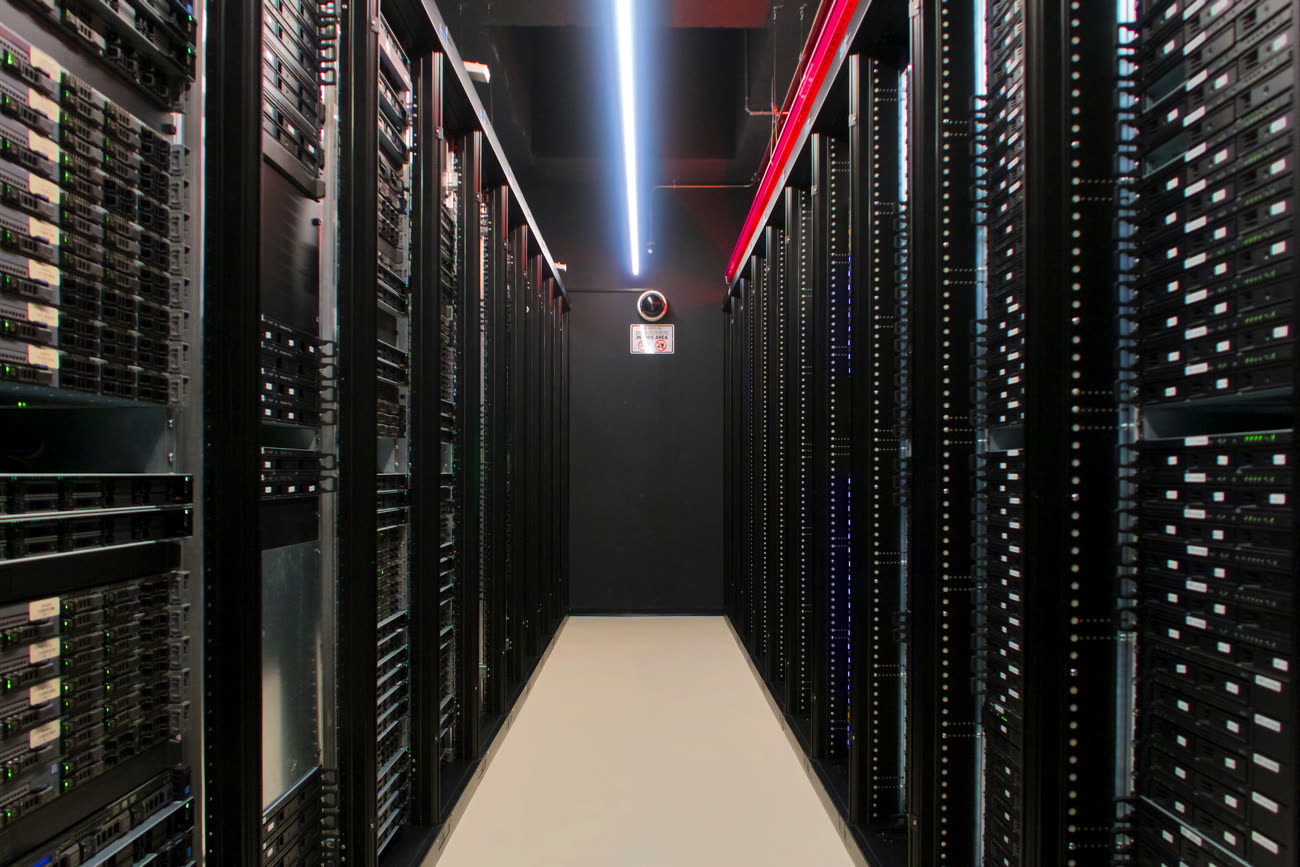

Les tableaux électriques coupent le bâtiment en deux : Infomaniak opère ses propres services d’un côté, et propose un service de housing de l’autre. Chaque « aile » compte huit allées2, qui comportent chacune 24 baies bourrées de serveurs et de systèmes de stockage. Les gouttières colorées guident le regard, qui se perd dans la succession des modules.

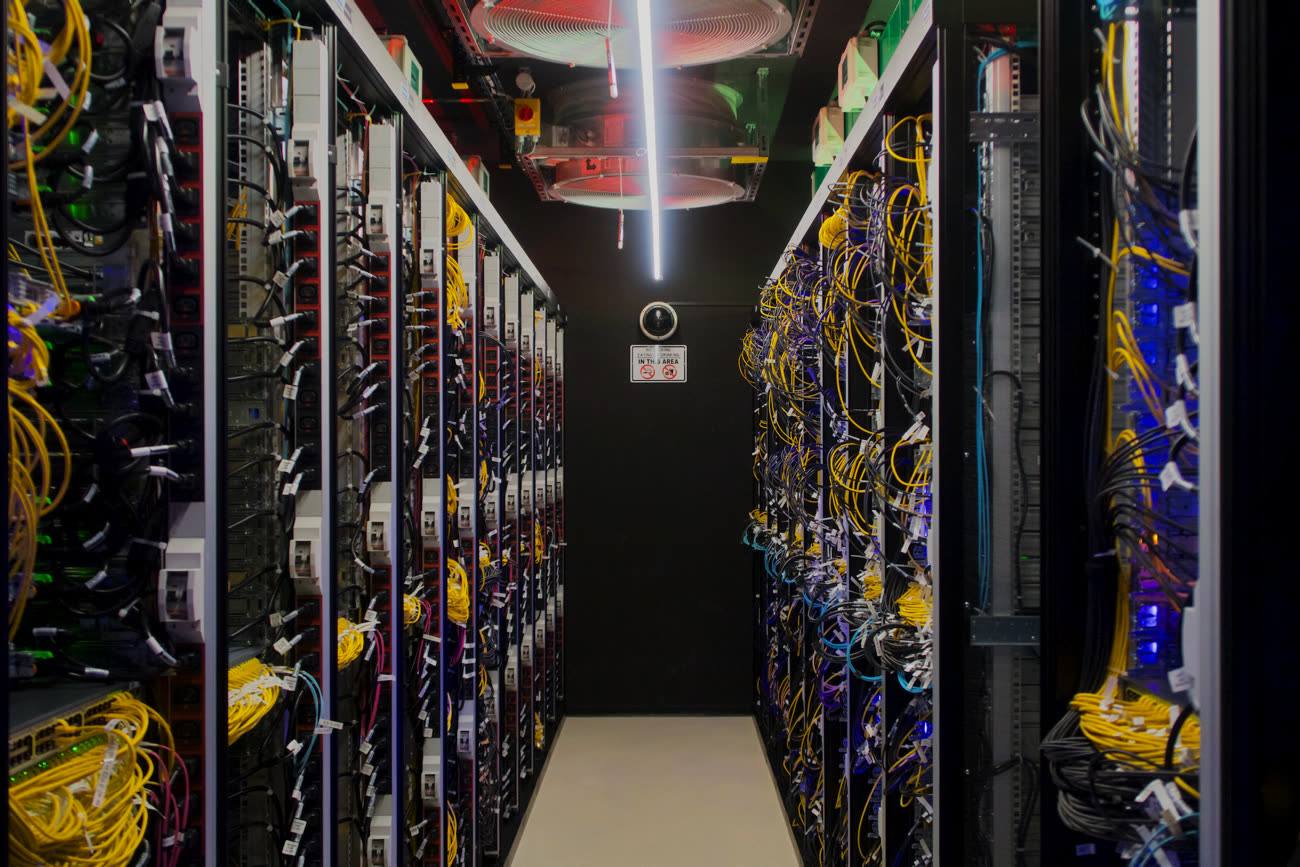

« On retrouve le rouge et le vert des deux alimentations », pointe Julien Bonnat, « le rose pour les courants faibles, le bleu pour la ventilation, et le jaune pour la fibre ». Les installations d’Infomaniak sont reliées les unes aux autres dans une grande boucle : « deux fibres arrivant de directions opposées rentrent à chaque bout du data-center pour éviter les problèmes en cas de travaux par exemple, et assurer une redondance ».

Après un premier coup de chaud auprès des onduleurs, on finit de mouiller la chemise dans les « allées chaudes » à l’arrière des serveurs. « Ici tout est câblé par le côté, alors que dans la plupart des data centers, les câbles reviennent devant en traversant les armoires », explique le directeur des opérations, « l’air frais descend depuis le toit, traverse les serveurs, et ressort dans les allées chaudes ».

Le bruit du système de refroidissement est assourdissant. « Nous n’avons pas de clim ! », précise Julien Bonnat, « c’est le bruit de la ventilation », qui tourne seulement à mi-régime au printemps. Infomaniak utilise des serveurs Dell et HP capables de supporter des températures de 35 à 45 ℃ sans régulation de l’humidité, des conditions dont les systèmes de stockage Synology semblent s’accommoder.

L’hébergeur doit plutôt veiller à ne pas faire entrer de l’air trop froid : « les faces avant sont entre 15 et 20 ℃ », explique le directeur des opérations, « pour éviter de tomber sous les 15 ℃ pendant l’hiver, nous réinjectons l’air des allées chaudes ». Quand la ventilation tourne à plein régime l’été, « même avec de l’air à 35 ℃, le flux est énorme, et puis aucun serveur n’est à moins de 35 ℃, c’est de l’air frais en comparaison ».

Avec la petite climatisation qui préserve les batteries de secours des fortes chaleurs et les autres besoins du bâtiment, le PUE ne dépasse pas 1,06. « Nous étions à 1,08 ou 1,09 il y a cinq ans », explique Marc Oehler, « nous essayons d’améliorer quelque chose chaque année ». « Nous ne pourrons pas faire beaucoup mieux ici », ajoute Julien Bonnat, « la seule perte maintenant, c’est la chaleur ».

Voilà pourquoi Infomaniak veut implanter son futur « DC IV » au cœur de la trame urbaine. Alors que le PUE des installations des géants du marché stagne depuis quelques années autour de 1,2, cet indicateur est de moins en moins pertinent. L’enjeu porte désormais sur la capacité de récupérer la « chaleur fatale »3, sur la consommation d’eau et sur l’étendue de l’artificialisation des sols.

Mais la visite du DC III n’est pas finie : sur le toit, des groupes électrogènes assurent une « autonomie infinie » en cas de coupure de courant, avec le secours d’une cuve de 10 000 litres de fioul qui dorment sous le centre de données. Comme les batteries, l’hébergeur espère n’en avoir jamais besoin, « mais il faut que ça fonctionne le jour où on en aura besoin ». Les équipements sont régulièrement testés, explique Julien Bonnat :

Avec les batteries et les groupes électrogènes, nous avons trois sources d’électricité. Si le test de charge sur les onduleurs ne passe pas, les batteries prennent le relai, et nous avons dix minutes pour réagir. Si le test des batteries ne passe pas, les groupes prennent le relai, et nous pouvons tenir aussi longtemps que nous voulons. C’est un test en conditions réelles : je coupe l’alimentation du data center. Les onduleurs prennent la charge et les groupes démarrent, mais nous testons surtout les automatisations, la synchronisation entre les équipements.

Dans les prochains mois, une installation photovoltaïque d’une puissance de 600 kWc prendra la place des générateurs. « La plupart des panneaux solaires sont fabriqués en Chine », dit Marc Oehler, « mais nous avons fini par trouver des panneaux européens ». Conçus en Suisse et fabriqués en Allemagne par Meyer Burger, ils sont « 100 % européens, mais aussi 100 % plus chers ». Le patron d’Infomaniak estime toutefois que l’opération sera rentable à long terme.

« Ces panneaux offrent 20 % de rendement supplémentaire et une garantie de production de 93 % après trente ans d’exploitation », explique Thomas Jacobsen, « ce n’est pas seulement plus cher ». Infomaniak ambitionne d’alimenter l’intégralité du « DC III » à l’énergie solaire, et compte bien doter le futur « DC IV » de ses propres panneaux solaires.

Cette visite rend le cloud très tangible : 78 % de l’empreinte carbone de l’hébergeur repose dans les stocks et dans les baies. « Un serveur comme celui-ci », dit le patron d’Infomaniak en tapotant une machine Dell, « c’est 1,7 tonne de CO2e ». Infomaniak compense ses émissions à 200 % avec la fondation myclimate, 100 % au Nicaragua et 100 % en Suisse, explique Thomas Jacobsen, « même si c’est beaucoup plus cher, nous faisons 100 % en Suisse parce que nous travaillons ici, mais que nous avons conscience que les serveurs ne viennent pas d’ici ».

La pérennité des efforts de reforestation est contestable, mais l’hébergeur préfère réduire son empreinte en allongeant la durée de vie du matériel. « Nous voulons garder les serveurs pendant quinze ans », répètent Marc Oehler et Julien Bonnat :

Nous achetons généralement des machines avec deux sockets, mais nous ne mettons qu’un seul processeur, le plus puissant du moment. Pendant les cinq premières années, ce sera vraiment le « top niveau ». Après cinq ans, nous retirons le processeur maintenant dépassé, nous mettons les deux processeurs les plus puissants que nous pouvons trouver avec le maximum de mémoire possible, et elles repartent pour cinq nouvelles années. Enfin les cinq dernières années, elles peuvent servir de serveur de stockage, de sauvegarde, ou de test. Avec le cloud, c’est moins grave de perdre en puissance sur une machine, parce qu’on utilise la puissance de calcul de l’ensemble des machines.

En somme, il vaut mieux conserver deux vieilles machines un peu dépassées qu’acheter une nouvelle machine dernier cri. « Les performances globales sont identiques », conclut le patron d’Infomaniak, « mais les performances écologiques sont bien meilleures. » Une machine doit tourner entre sept et dix ans pour « rembourser » l’empreinte carbone de sa fabrication.

« La préservation de l’environnement n’est pas un objectif d’Infomaniak », explique Marc Oehler, « c’est toute sa culture ». Une culture insufflée par le cofondateur Boris Siegenthaler, qui reste directeur de la stratégie de l’hébergeur et son « écolo en chef ». Entre autres mesures, Infomaniak verse une prime « mobilités douces » allant jusqu’à 1 500 CHF par an (env. 1 444 €) et préfère les vidéoconférences aux voyages en avion.

En concevant sa propre suite infonuagique, de kDrive à Swiss Backup en passant par le service mail, Infomaniak promeut une certaine écologie des données. « Nous accumulons nécessairement des données, mais nous voulons nous donner les moyens de respecter nos engagements », dit Thomas Jacobsen, « si nous nous contentions de revendre des services des GAFAM, comme le font la plupart de nos concurrents, nous ne pourrions pas offrir de garanties aux clients ».

Ce data center suisse carbure à l’énergie suisse pour faire tourner des services suisses… sur des serveurs américains fabriqués en Chine. « La désindustrialisation européenne est un problème », concède Marc Oehler, « mais la pandémie, et maintenant la guerre en Ukraine, montrent l’intérêt d’une production plus locale ».

« Même cette voiture », dit-il en appuyant sur l’accélérateur de la Model 3, « nous aurions préféré acheter un modèle produit en Europe ». Lorsque viendra le temps de la remplacer, « dans vingt ans si elle tient la route », il espère pouvoir se fournir beaucoup plus près de Genève. Mais après avoir exporté ses data centers au-delà du canton, en Suisse alémanique d’abord, et pourquoi pas en France…

-

Composée de 60 % d’énergie d’origine hydraulique certifiée TÜV SÜD EE01 et 40 % d’énergie d’« origine verte » certifiée Naturemade Star provenant de petites installations hydroélectriques portant un soin particulier à la préservation de la faune aquatique et de centrales photovoltaïques. ↩︎

-

Une allée supplémentaire se situe au milieu du bâtiment, ainsi qu’une armoire consacrée aux services généraux, c’est-à-dire le réseau interne au data center. ↩︎

-

Ou « chaleur de récupération ». C’est la chaleur qui est produite par un dispositif sans être la finalité, et pourrait être récupérée, pour chauffer de l’eau ou produire de l’électricité par exemple. ↩︎