Les MacBook Pro 13" avec processeurs "Kaby Lake" (7e génération) lancés en juin sentent encore l'odeur du neuf que la concurrence prépare la rentrée avec des modèles équipés en Kaby Lake de 8e génération. C'est le cas de Dell avec son XPS 13.

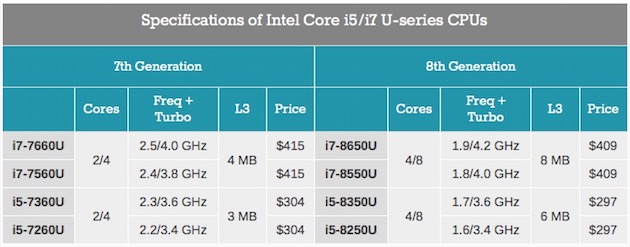

Il embarque un processeur appartenant à la famille dite "Kaby Lake Refresh", plus puissante grâce à quatre cœurs physiques au lieu de deux (l'Hyperthreading est toujours au menu, pour aller jusqu'à 8 cœurs logiques avec des applications de modélisation 3D par exemple) et une puce graphique plus récente. Intel avance un gain en rapidité de 25 % lorsque les 4 cœurs fonctionnent et jusqu'à 40 % dans le meilleur des cas.

Chez Apple, ces Kaby Lake aux épaules plus carrées ont vocation à équiper les MacBook 13" dépourvus de la Touch Bar. Une configuration qui utilise aujourd'hui les références 7360U et 7660U.

Le 13" avec Touch Bar et les 15" emploient pour leur part des Kaby Lake pour lesquels Intel n'a pas encore annoncé la version boostée (lire Intel lance Kaby Lake refresh, une partie de sa 8e génération de processeurs).

Dell en fait profiter plusieurs de ses portables dont cet XPS 13" (Core i7 Quad, USB 3, Thunderbolt 3, lecteur SD), pour lequel le texan revendique un gain de 44 % en vitesse avec les 4 cœurs sollicités. Dans son argumentaire auprès des médias il l'oppose à tous les portables actuels d'Apple sauf les 15"

L'autonomie du XPS 13 est annoncée à 22h 21min avec des applications bureautique, 13h 21min avec le navigateur Edge ou encore 13h 31min avec Netflix. Des valeurs très flatteuses mais qu'il faut tempérer. Elles ne s'appliquent qu'à la configuration avec écran Full HD et Core i3 de la (désormais précédente) 7e génération. Avec le modèle QHD+ (3 200 x 1 800) et Core i5, de 7e génération toujours, on descend brutalement à respectivement 13h 15min, 8h 30min et 9h 30min.

En clair, Dell ne communique pas pour le moment sur ce que l'on peut espérer avec les même processeurs de huitième génération, et encore moins avec ce Core i7 Quad. La première configuration qui en sera équipée débutera à 1 400 $, lancement le 12 septembre. La version Core i5 "Kaby Lake Refresh" est prévue en octobre. En France ces machines sont vendues à partir de 1 300 €.

Quant à Apple, difficile de prévoir son calendrier qui est tributaire de celui d'Intel. La Pomme peut tout à fait réaliser une mise à jour de certains modèles sans tambours ni trompettes mais ce ne serait pas très cohérent avec sa manière de procéder. Il paraît bien plus logique qu'elle attendent qu'Intel dispose de Kaby Lake améliorés pour couvrir, d'un coup, l'ensemble de ses besoins sur les MacBook Pro 13" et 15".