Depuis quelques années, les outils technologiques suivent une double tendance apparemment contradictoire : l'ubiquité et la dissolution. Ils sont à la fois partout dans notre environnement, et nulle part puisqu'ils ont non seulement tendance à s'effacer, mais également à s'abstraire géographiquement dans le "cloud". À quoi pourrait ressembler notre environnement technologique dans un avenir proche si l'on suit cette tendance ?

Depuis quelques années, les outils technologiques suivent une double tendance apparemment contradictoire : l'ubiquité et la dissolution. Ils sont à la fois partout dans notre environnement, et nulle part puisqu'ils ont non seulement tendance à s'effacer, mais également à s'abstraire géographiquement dans le "cloud". À quoi pourrait ressembler notre environnement technologique dans un avenir proche si l'on suit cette tendance ? Lors de notre interview au MIT avec le Professeur Randall Davis (lire MIT : à la croisée de l'intelligence artificielle et des nouvelles interfaces), nous l'avions interrogé sur l'évolution possible de cette tendance :

Il y a une sorte d'observation standard que l'on fait depuis un moment, sur le fait que les technologies ont tendance à évoluer, en commençant par être remarquables et extraordinaires, puis en faisant partie de la routine, pour finir par devenir invisibles, et lorsqu'elles sont invisibles vous savez qu'elles ont vraiment réussi. Un exemple classique de cette évolution, c'est l'électricité et l'énergie : d'abord c'était extraordinaire et c'était évident, puis c'est devenu la routine et maintenant c'est invisible.

Parce qu'elle est partout, elle est omniprésente, vous n'y pensez plus, elle est là quand vous en avez besoin, et ça n'a rien de nouveau, mais clairement ça devient de plus en plus vrai de manière continue. Et l'informatique prend la même direction : au départ c'était une chose extraordinaire qui impliquait que vous alliez dans un endroit donné pour l'utiliser, puis chacun a pu en bénéficier sur son bureau, ensuite chacun a pu l'emporter avec soi grâce aux portables, et maintenant bien sûr nous avons des téléphones qui sont plus puissants que certains de ces ordinateurs portables originaux, et bientôt même ceux-ci se réduiront encore pour devenir virtuellement invisibles.

L'ubiquité et la dissolution de la technologie dans notre environnement reposent sur deux évolutions parallèles : l'infrastructure du réseau mondial et les interfaces dites "naturelles".

À mesure que les réseaux haut débit s'étendent, de nouveaux services ont été rendus possibles. Aujourd'hui, YouTube compte pour 22 % du trafic mobile à lui seul, alors que la vidéo, sans même parler de la HD, n'était qu'un rêve lointain lorsque les modems émettaient encore leurs crissements sur le Réseau Téléphonique Commuté. Certes, la fibre optique et la 4G LTE sont encore loin de faire partie du quotidien de chaque internaute, mais il ne fait aucun doute qu'à terme le très haut débit sera accessible au plus grand nombre.

Le logiciel comme service

Ceux qui ont goûté au webmail ont eu un avant-goût des promesses d'un réseau accessible de n'importe où : quelle que soit la machine qu'on utilise, on retrouve en quelques clics ses données telles qu'on les avait laissées et une interface familière. Avec iTunes Match et iCloud, Apple a poussé cette logique pour la musique, et demain d'autres contenus encore. La dématérialisation avance à marche forcée : aujourd'hui les billets de train ou d'avion peuvent n'avoir d'existence que dans les serveurs des compagnies de transport, résumés dans la réalité à un simple code d'identification.

Des technologies comme OnLive rendent non seulement caduque la notion de compatibilité avec un système d'exploitation donné, mais même avec les capacités matérielles des machines. De grands éditeurs de logiciels comme Autodesk et probablement à terme Adobe investissent un nouveau modèle économique : le logiciel comme un service. Avec ce nouveau paradigme, l'utilisateur final ne paye plus à grands frais chaque mise à jour majeure, mais un abonnement plus modeste pour l'utilisation continue d'un logiciel qui s'exécute à distance et qui est maintenu en permanence.

Ainsi, finis les cycles des mises à jour : au quotidien, de nouvelles fonctionnalités sont ajoutées, des bugs sont corrigés, l'aspect matériel est entièrement maîtrisé puisque tout se fait sur des fermes de calcul distantes, qui plus est dotées d'une puissance impensable pour un poste de travail quelconque. En outre, plus aucune faille de sécurité ne peut être exploitée puisqu'aucun code n'est exécuté en local, sans même parler du piratage ou du casse-tête des utilisateurs qui s'entêtent à utiliser une ancienne version d'un logiciel donné dont les failles sont bien connues… et bien exploitées.

Naturellement un tel modèle, s'il présente des avantages indéniables, n'est pas sans inconvénient : avec une telle centralisation des données, l'appât est de taille pour les hackers qui peuvent récupérer d'un seul coup des millions de données confidentielles, là où il leur fallait autrefois s'attaquer à autant de postes différents. D'autre part, il suffit qu'une entreprise proposant ce type de service fasse faillite pour que ses utilisateurs perdent tout. Pour les professionnels, il y a cependant une solution intermédiaire, puisque les entreprises clientes de ces éditeurs, d'autant plus susceptibles de vouloir conserver la maîtrise de leurs données sans subir une pareille dépendance, pourront exploiter leurs propres serveurs. La sauvegarde et la maintenance en sera d'autant plus simplifiée, laissant comme seul problème technique à l'utilisateur final la maintenance d'une connexion au réseau, à laquelle, les logiciels sont en tout état de cause de plus en plus dépendants. Cette dissolution du problème technique et des contraintes liées à la technologie en rendront l'utilisation aussi simple qu'un poste de radio.

Ainsi, le moindre écran connecté permet de retrouver son environnement de travail tel quel en n'importe quel point de la planète pour peu qu'une connexion soit accessible, sans se préoccuper du système d'exploitation, ou de la puissance de la machine qui l'anime. C'est la naissance d'une plateforme universelle, indépendante des caprices des fabricants et des éditeurs de systèmes d'exploitation (qui ont pu parfois virer au chantage).

Mais en parallèle à cette dématérialisation à tout crin, la technologie redevient tangible.

Au doigt et à l'œil, ou le vrai langage de l'homme

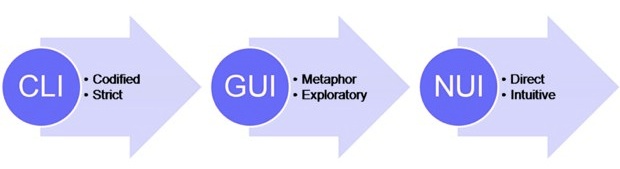

Depuis la naissance du Macintosh, et en dépit d'une véritable explosion de la puissance des machines, voilà bientôt 28 ans que l'informatique reste engoncée dans la métaphore du bureau, sans variation fondamentale, avec comme uniques périphériques d'entrée le clavier et la souris. Prise en étau par le carcan Wintel, l'industrie est restée dans le statu quo. Avec le Mac, Apple créait un manifeste face à la ligne de commande : ça n'est pas à l'homme de parler le langage de la machine, mais à la machine de parler le langage de l'homme. Pour autant, si l'interface graphique a amplement démontré sa supériorité face à la ligne de commande, elle n'a cependant pas rempli ses promesses.

Le clavier comme la souris sont des intermédiaires entre l'utilisateur et ses données, qui font figure de bâtons dans les roues. Ils ont séparé le principe physique action-réaction, qui fait notre quotidien dans le monde réel, et qui régit notre façon d'aborder notre environnement naturel.

Les interfaces utilisateurs naturelles, ou NUI, viennent mettre un terme à ce clivage. Les écrans multitouch redonnent aux données une tangibilité que la dématérialisation leur avait fait perdre, et induisent un rapport physique entre l'utilisateur et le logiciel. Nous interagissons avec un écran tactile comme nous le faisons avec les objets du quotidien, mais avec l'augmentation de l'informatique ("la bicyclette pour l'esprit" comme se plaisait à dire Steve Jobs), l'expérience est indubitablement plus plaisante encore.

Les interfaces tactiles exploitent d'ailleurs certaines découvertes apportées par l'interface graphique, comme les éléments d'interface explicites dont l'aspect visuel indique la fonction. Apple ne s'est pas fourvoyée en basculant complètement l'interface d'iOS dans un galimatias gestuel : nombre de boutons conservent simplement une étiquette de texte indiquant leur fonction. L'interface tactile, lorsqu'elle exploite des gestes, retrouve un point commun avec la ligne de commande, puisqu'il faut connaître préalablement ce vocabulaire.

Comme pour l'interface graphique du Macintosh, Apple n'a pas inventé à proprement parler l'interface multitouch, mais c'est elle qui l'a industrialisée et mise en pratique. En 2006, Jeff Han faisait une démonstration impressionnante lors d'une conférence TED, mais son produit, un écran multitouch 82" qui coûte 100 000$, n'est toujours pas arrivé sur le marché (lire Du 82" multitouch au doigt et au stylet).

La chose nous est si naturelle qu'un bébé de quelques mois, ou même un animal de compagnie peuvent interagir avec un simple iPad. Peut-on imaginer la chose sur un ordinateur ? En dépit de la simplicité que l'interface graphique a amenée, il reste encore un apprentissage à faire pour s'en servir, sans même parler des arcanes propres aux OS historiques comme la gestion des fichiers.

Si la pression d'un simple bouton ne nécessite aucune explication, et si le déplacement du doigt n'est pas soumis aux contraintes de surface d'une souris ou d'un trackpad pour déplacer le curseur au-delà de l'espace physique disponible, l'interface multitouch nécessite malgré tout l'apprentissage d'un vocabulaire gestuel. Le zoom à deux doigts par exemple, s'il est frappé au coin du bon sens, ne reproduit pour autant aucun geste du monde réel, et pour cause. L'interface naturelle ne mérite pas ce titre pour son absence d'apprentissage, mais pour son mode même d'interaction, qui n'exploite aucun intermédiaire, aucun périphérique d'entrée apparent. Les consoles de jeu s'y sont également mises : avec le Kinect de Microsoft, plus besoin de joystick pour piloter le jeu.

Certes, la souris est plus précise et permet de cliquer au pixel près, mais à vrai dire cette précision n'est vraiment indispensable qu'avec une interface conçue pour la souris. En somme, elle n'est la réponse adaptée qu'au problème qu'elle induit elle-même. Sur un écran tactile, le zoom ou le stylet répondent aussi bien à cette problématique, et le pixel en lui-même se dissout dans les écrans Retina Display, d'autant qu'il apparaît possible que les Mac en bénéficient prochainement (lire Du retina display dans Lion).

Si Jobs conspuait le stylet dans un contexte de mobilité, ou l'écran tactile pour un poste de travail fixe, il ne faut cependant pas jeter bébé avec l'eau du bain. Si l'on en revient au rapport que nous entretenons avec les objets réels, préférerions-nous écrire ou dessiner au doigt sur du papier ? Préférerions-nous un intermédiaire entre notre main et les objets que nous souhaitons manipuler ? Selon les cas, probablement pas. Les graphistes qui utilisent chaque jour les tablettes-écrans de Wacom peuvent en témoigner : ce type d'utilisation est amplement supérieur au doigt ou à la souris pour la tâche à laquelle il se consacre.

Le HP TouchSmart, un "iMac tactile"

Concernant un écran tactile sur un poste de travail, il est en effet trop fatigant et contraignant d'avoir à lever le bras en permanence pour toucher l'écran, du moins s'il reste à la verticale. Mais c'est bien l'écran d'ordinateur, et qui plus est le tube cathodique, qui a modifié la posture de travail à un bureau. Lorsqu'il n'était encore question que de papier, nul ne semblait avoir un problème à écrire dessus à même la surface horizontale ou inclinée d'un bureau. Revenir à ce format pourrait donc fonctionner, à ceci près que le clavier viendrait encore en gêner l'utilisation.

L'écriture est d'abord née pour répondre aux problèmes d'intendance, permettant de conserver une trace mémorielle d'un inventaire, puis elle a permis la communication à distance ou en temps différé. Le clavier, d'abord né pour la machine à écrire, a permis dans un premier temps d'offrir les lettres d'imprimerie au plus grand nombre, puis de proposer un mode d'entrée de texte qui puisse être traité comme tel par une machine. S'il y a eu des tentatives d'interprétation du texte manuscrit, dont le Newton d'Apple ne fut pas le moindre représentant, elles se sont toutes avérées hasardeuses : même entre humains le déchiffrage du texte manuscrit n'est pas toujours probant (lire Pour quelques neurones de plus).

Mais le mode de communication naturel et privilégié de l'humain reste la parole. Avec un ordinateur capable de transcrire la parole, et mieux encore de la comprendre, le besoin d'un clavier pour entrer du texte se fait beaucoup moins sentir, en dehors de cas spécifiques comme le formatage ou les graphies qui sortent des sentiers battus, ou le besoin de confidentialité. Siri ne fait pour l'heure que lever un coin du voile sur ce qui nous attend en la matière, et les perspectives offertes par cette technologie ont de quoi enthousiasmer. Quel dialogue avec la machine serait plus naturel qu'une conversation à proprement parler ?

Les interfaces naturelles, si elles ont démontré leur intérêt dans les domaines qui sont actuellement les leurs, peuvent offrir les mêmes avantages sur les ordinateurs dignes de ce nom. Mais l'ordinateur lui-même se voit peu à peu démantelé pour intégrer notre quotidien et se transformer au gré de nos besoins. Comme l'électricité, il se dissout dans notre environnement, pour y être à la fois omniprésent et invisible. De la même manière que l'ordinateur a redéfini la façon de travailler de nombreux métiers, cette évolution de la technologie se ressentira dans notre façon de l'utiliser à l'avenir.

Il ne fait guère de doute que plus aucun smartphone ne sera livré à l'avenir sans écran tactile. Et il y a fort à parier que d'ici peu, les générations à venir considèreront le clavier et la souris, voire le poste de travail lui-même, comme de singulières incongruités.