Si Intel domine sans partage sur le front des processeurs pour ordinateurs, elle peine à répondre dans le domaine des appareils mobiles. Face à la montée en puissance des processeurs ARM et des GPGPU, et alors qu'elle doit redoubler d'ingéniosité pour retarder un peu plus le cul-de-sac technologique de la fabrication des processeurs, Intel doit faire feu de tout bois pour conserver son leadership.

On l'a peut-être oublié depuis, mais en 1994, lorsqu'IBM, Motorola et Apple mettent le processeur PowerPC sur le marché, la firme de Cupertino répète à qui veut bien l'entendre que les processeurs CISC d'Intel sont en bout de course et n'ont guère que quelques années d'espérance de vie devant eux : le RISC était manifestement la seule issue. En cause, la gravure des processeurs, de plus en plus fine, qui finira nécessairement par se heurter à une barrière physique insurmontable : la taille de l'atome.

L'histoire aura doublement donné tort à Apple : non seulement la famille x86 a survécu aux PowerPC dans les micro-ordinateurs, mais humiliation suprême, elle-même a été contrainte d'abandonner son propre processeur pour passer à ceux d'Intel. Le fondeur a su modifier son architecture pour la maintenir à flots, tirant parti des unités de calcul vectoriel, mélangeant un peu de RISC avec le CISC, changeant ses processus de fabrication, etc.

Malgré tout, les processeurs sont arrivés à un premier plateau : la fin de la course au gigahertz. L'augmentation de la vitesse d'horloge est arrivée à un stade au-delà duquel la consommation et la dissipation d'énergie qu'elle entrainait devenaient déraisonnables. Qu'à cela ne tienne, la multiplication des cores et des processeurs en eux-mêmes a permis d'y suppléer, au prix toutefois de nouvelles architectures pour les logiciels, qui ne bénéficiaient plus automatiquement de cette augmentation de puissance transversale, contrairement à ce qui se produisait avec l'augmentation de la vitesse d'horloge.

Mais la multiplication des unités de calcul elle aussi n'aura qu'un temps : la loi d'Amdahl prédit son inéluctable défaillance passé un certain nombre de processeurs. Pour un logiciel optimisé à 50 % pour le calcul parallèle, la multiplication de processeurs ne se fait plus sentir au-delà de huit processeurs (lire Le monde parallèle de Photoshop). Certes, il est possible de relever ce plafond en augmentant la portion de calcul parallèle dans les logiciels, mais ce travail est particulièrement complexe et coûteux pour les développeurs (lorsqu'il est tout bonnement possible), et les fabricants se retrouveraient tributaires de la seule bonne volonté des développeurs pour que leurs architectures fassent la moindre différence avec leurs prédécesseurs (lire également Le CTO d'AMD prépare l'après-multicore). Et de fait, on constate d'ores et déjà un plafonnement dans certaines configurations (lire Photoshop CS5 : plus de cœurs, moins de performances).

Et quitte à faire du calcul parallèle, les logiciels auront meilleur compte de recourir aux processeurs graphiques, dont les pipelines sont capables de traiter énormément plus de données en une seule passe que les bons vieux CPU. C'est là un autre front sur lequel Intel doit batailler. Alors qu'AMD a décidé d'embrasser ce domaine avec l'acquisition d'ATI, Intel a tout fait pour freiner des quatre fers, notamment en arrêtant d'ouvrir ses chipsets à la concurrence, obligeant les constructeurs à embarquer les puces graphiques d'Intel, quitte à faire doublon avec une carte supplémentaire d'un concurrent. D'autre part, Intel a tâché tant bien que mal de répondre dans ce domaine en travaillant sur Larrabee, un processeur massivement parallèle qui conservait l'assembleur x86, mais ce fut en pure perte, et Intel dut retourner sur la planche à dessin (lire Larrabee, c'est où, dites ?).

Où l'on reparle des processeurs RISC

Enfin, Intel s'est laissée dépasser par la bande : alors qu'elle règne d'une main de fer sur l'équipement des ordinateurs, elle a commencé à céder du terrain d'abord avec les netbooks, puis les smartphones, et enfin les tablettes. Car les appareils mobiles présentent une contrainte supplémentaire : il s'agit de gagner en puissance tout en ne perdant rien de l'autonomie, et ça n'est pas sur les progrès en matière de batteries qu'il faudra compter. Les processeurs doivent donc en faire plus tout en consommant moins d'énergie, une véritable gageüre tant les deux paramètres sont intimement liés.

Bien qu'Intel propose une gamme de processeurs à basse consommation, les Atom, ceux-ci font piètre figure face à l'architecture ARM, qui gagne de plus en plus de terrain. Pire encore, Microsoft elle-même, le partenaire de toujours, finit par se résoudre à promettre une version de Windows pour cette famille de processeurs, et ARM s'attaque même à la chasse gardée d'Intel en investissant les ordinateurs, et même les serveurs, un autre domaine où la consommation joue un rôle important (lire ARM vient chasser Intel sur les PC avec NVIDIA et Microsoft). Il se murmure même qu'Apple pourrait lancer un Mac animé par un processeur ARM (lire Mac : changement d'architecture en 2013 ?). Cerise sur le gâteau, alors qu'Intel avait mis sur pied un partenariat avec Nokia sur le système d'exploitation mobile MeeGo, cette dernière lui fait défaut pour tomber dans les bras de Microsoft.

L'importance stratégique de ces nouveaux marchés ne fait plus guère de doute, et commence à faire sentir ses effets. Intel pourrait-elle perdre la main comme c'est le cas pour Microsoft ? (lire 1996-2011 : l'incroyable inversion des pôles). Dans un domaine où les nouvelles architectures matérielles ne peuvent se mettre en place du jour au lendemain, il devient urgent de réagir.

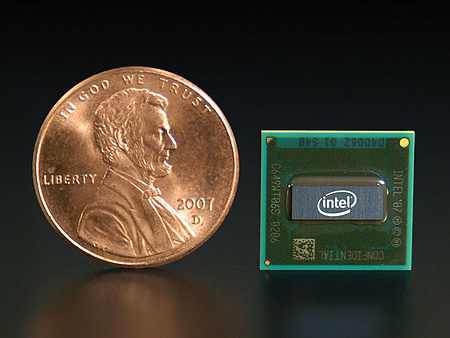

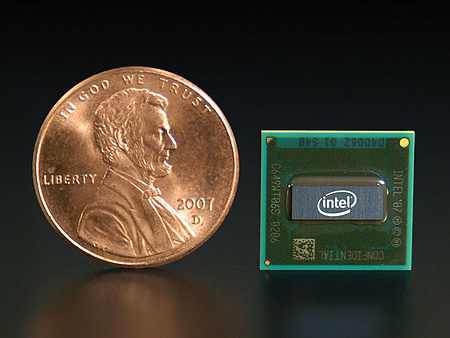

Intel abat alors une carte maîtresse, sur laquelle elle va bâtir sa riposte, en démontrant ses indéniables capacités pour relancer la machine. Au début du mois, elle dévoile rien de moins qu'une modification majeure de la brique maîtresse des processeurs, avec la mise au point de transistors tri-gate (lire Intel se met à la 3D. Avec ce nouveau transistor, Intel compte passer allègrement le cap des 22 nm pour la gravure des processeurs, et ce n'est qu'un début. Avec cette nouvelle technologie, Intel pourra continuer à ne pas faire mentir la loi de son co-fondateur, Gordon E. Moore, pour les années à venir et alors que les processeurs flirtent avec les trois milliards de transistors.

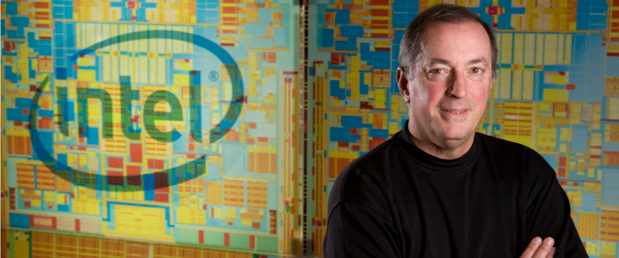

Au début de la semaine, Intel a dévoilé une nouvelle feuille de route qui marque un changement radical dans ses plans : alors que la puissance des processeurs Atom nécessite en moyenne 35 à 40 Watts de consommation électrique, Paul Otellini a annoncé que sa prochaine gamme de processeurs Core ciblerait les 15 Watts, et même 5 Watts pour les appareils mobiles. D'autre part, Intel compte passer à la gravure en 14 nm d'ici 2014. Ces processeurs présenteront l'intérêt d'une seule et même architecture qui irait du smartphone jusqu'au datacenter, et pourraient améliorer encore le rapport autonomie/puissance d'un futur MacBook Air. Malgré ce net progrès, les processeurs ARM font toujours mieux sur le plan de la consommation, un Cortex A9 nécessite généralement entre 0,5 et 2 watts de puissance. Et précisément ARM cherche à percer dans le domaine des serveurs, ce qui lui apporterait la même unité de langage d'un bout à l'autre du spectre informatique. Mais Paul Otellini considère que son adversaire n'a pas les reins assez solides techniquement : « La réponse simple c'est que leur architecture doit grandir. Les exigences des serveurs sont assez significatives : 64 bits, correction d'erreur, parallélisme multiple, capacités en hyperthreading, infrastructures des systèmes hautement parallèles… Il faut bâtir tout cela pour une nouvelle architecture, et historiquement c'est quelque chose de très difficile à faire.»

Otellini profite de cette annonce pour régler quelques comptes. Concernant Nokia, il déplore sa défection : « Avec le recul, c'était un mauvais choix de partenaire ». Nokia devait présenter des smartphones basés sur MeeGo et la gamme de SoC Medefield et Saltwell pour le second semestre 2011, il faudra désormais attendre la première moitié de l'année prochaine pour voir arriver cette architecture dans un smartphone. « Nous avions travaillé de très près et presque exclusivement avec Nokia, nous avons [donc] libéré ce personnel et changé ce concept en concept de référence que nous proposons à un certain nombre de sociétés. Les smartphones sont un domaine qui focalise l'attention, nous avons une nouvelle équipe dirigeante dans ce domaine et nous allons être très prospères dans ce domaine » Méthode Coué ou vœu pieux, il faudra un peu plus que ces affirmations pour y parvenir alors que le marché commence à se cristalliser autour de quelques acteurs majoritaires.

Otellini cherche également à tordre le cou à la rumeur qui voudrait qu'Apple lui fasse défaut avec le Mac : « cela prendrait trop de temps et leur coûterait bien trop cher », ajoutant qu'en outre les ventes de Mac ont explosé depuis le passage à ses processeurs. Par ailleurs, Intel avait déjà flatté Apple peu de jours avant (lire Intel toujours stimulé par Apple)

Avec ces annonces, Intel semble avoir pris la mesure des efforts qu'il lui reste à faire pour proposer un concurrent crédible aux processeurs ARM, mais il reste à voir si les annonces, et les produits qui leur correspondent, suffiront à inverser la vapeur.

On l'a peut-être oublié depuis, mais en 1994, lorsqu'IBM, Motorola et Apple mettent le processeur PowerPC sur le marché, la firme de Cupertino répète à qui veut bien l'entendre que les processeurs CISC d'Intel sont en bout de course et n'ont guère que quelques années d'espérance de vie devant eux : le RISC était manifestement la seule issue. En cause, la gravure des processeurs, de plus en plus fine, qui finira nécessairement par se heurter à une barrière physique insurmontable : la taille de l'atome.

L'histoire aura doublement donné tort à Apple : non seulement la famille x86 a survécu aux PowerPC dans les micro-ordinateurs, mais humiliation suprême, elle-même a été contrainte d'abandonner son propre processeur pour passer à ceux d'Intel. Le fondeur a su modifier son architecture pour la maintenir à flots, tirant parti des unités de calcul vectoriel, mélangeant un peu de RISC avec le CISC, changeant ses processus de fabrication, etc.

Malgré tout, les processeurs sont arrivés à un premier plateau : la fin de la course au gigahertz. L'augmentation de la vitesse d'horloge est arrivée à un stade au-delà duquel la consommation et la dissipation d'énergie qu'elle entrainait devenaient déraisonnables. Qu'à cela ne tienne, la multiplication des cores et des processeurs en eux-mêmes a permis d'y suppléer, au prix toutefois de nouvelles architectures pour les logiciels, qui ne bénéficiaient plus automatiquement de cette augmentation de puissance transversale, contrairement à ce qui se produisait avec l'augmentation de la vitesse d'horloge.

Mais la multiplication des unités de calcul elle aussi n'aura qu'un temps : la loi d'Amdahl prédit son inéluctable défaillance passé un certain nombre de processeurs. Pour un logiciel optimisé à 50 % pour le calcul parallèle, la multiplication de processeurs ne se fait plus sentir au-delà de huit processeurs (lire Le monde parallèle de Photoshop). Certes, il est possible de relever ce plafond en augmentant la portion de calcul parallèle dans les logiciels, mais ce travail est particulièrement complexe et coûteux pour les développeurs (lorsqu'il est tout bonnement possible), et les fabricants se retrouveraient tributaires de la seule bonne volonté des développeurs pour que leurs architectures fassent la moindre différence avec leurs prédécesseurs (lire également Le CTO d'AMD prépare l'après-multicore). Et de fait, on constate d'ores et déjà un plafonnement dans certaines configurations (lire Photoshop CS5 : plus de cœurs, moins de performances).

Et quitte à faire du calcul parallèle, les logiciels auront meilleur compte de recourir aux processeurs graphiques, dont les pipelines sont capables de traiter énormément plus de données en une seule passe que les bons vieux CPU. C'est là un autre front sur lequel Intel doit batailler. Alors qu'AMD a décidé d'embrasser ce domaine avec l'acquisition d'ATI, Intel a tout fait pour freiner des quatre fers, notamment en arrêtant d'ouvrir ses chipsets à la concurrence, obligeant les constructeurs à embarquer les puces graphiques d'Intel, quitte à faire doublon avec une carte supplémentaire d'un concurrent. D'autre part, Intel a tâché tant bien que mal de répondre dans ce domaine en travaillant sur Larrabee, un processeur massivement parallèle qui conservait l'assembleur x86, mais ce fut en pure perte, et Intel dut retourner sur la planche à dessin (lire Larrabee, c'est où, dites ?).

Où l'on reparle des processeurs RISC

Enfin, Intel s'est laissée dépasser par la bande : alors qu'elle règne d'une main de fer sur l'équipement des ordinateurs, elle a commencé à céder du terrain d'abord avec les netbooks, puis les smartphones, et enfin les tablettes. Car les appareils mobiles présentent une contrainte supplémentaire : il s'agit de gagner en puissance tout en ne perdant rien de l'autonomie, et ça n'est pas sur les progrès en matière de batteries qu'il faudra compter. Les processeurs doivent donc en faire plus tout en consommant moins d'énergie, une véritable gageüre tant les deux paramètres sont intimement liés.

Bien qu'Intel propose une gamme de processeurs à basse consommation, les Atom, ceux-ci font piètre figure face à l'architecture ARM, qui gagne de plus en plus de terrain. Pire encore, Microsoft elle-même, le partenaire de toujours, finit par se résoudre à promettre une version de Windows pour cette famille de processeurs, et ARM s'attaque même à la chasse gardée d'Intel en investissant les ordinateurs, et même les serveurs, un autre domaine où la consommation joue un rôle important (lire ARM vient chasser Intel sur les PC avec NVIDIA et Microsoft). Il se murmure même qu'Apple pourrait lancer un Mac animé par un processeur ARM (lire Mac : changement d'architecture en 2013 ?). Cerise sur le gâteau, alors qu'Intel avait mis sur pied un partenariat avec Nokia sur le système d'exploitation mobile MeeGo, cette dernière lui fait défaut pour tomber dans les bras de Microsoft.

L'importance stratégique de ces nouveaux marchés ne fait plus guère de doute, et commence à faire sentir ses effets. Intel pourrait-elle perdre la main comme c'est le cas pour Microsoft ? (lire 1996-2011 : l'incroyable inversion des pôles). Dans un domaine où les nouvelles architectures matérielles ne peuvent se mettre en place du jour au lendemain, il devient urgent de réagir.

Intel abat alors une carte maîtresse, sur laquelle elle va bâtir sa riposte, en démontrant ses indéniables capacités pour relancer la machine. Au début du mois, elle dévoile rien de moins qu'une modification majeure de la brique maîtresse des processeurs, avec la mise au point de transistors tri-gate (lire Intel se met à la 3D. Avec ce nouveau transistor, Intel compte passer allègrement le cap des 22 nm pour la gravure des processeurs, et ce n'est qu'un début. Avec cette nouvelle technologie, Intel pourra continuer à ne pas faire mentir la loi de son co-fondateur, Gordon E. Moore, pour les années à venir et alors que les processeurs flirtent avec les trois milliards de transistors.

Au début de la semaine, Intel a dévoilé une nouvelle feuille de route qui marque un changement radical dans ses plans : alors que la puissance des processeurs Atom nécessite en moyenne 35 à 40 Watts de consommation électrique, Paul Otellini a annoncé que sa prochaine gamme de processeurs Core ciblerait les 15 Watts, et même 5 Watts pour les appareils mobiles. D'autre part, Intel compte passer à la gravure en 14 nm d'ici 2014. Ces processeurs présenteront l'intérêt d'une seule et même architecture qui irait du smartphone jusqu'au datacenter, et pourraient améliorer encore le rapport autonomie/puissance d'un futur MacBook Air. Malgré ce net progrès, les processeurs ARM font toujours mieux sur le plan de la consommation, un Cortex A9 nécessite généralement entre 0,5 et 2 watts de puissance. Et précisément ARM cherche à percer dans le domaine des serveurs, ce qui lui apporterait la même unité de langage d'un bout à l'autre du spectre informatique. Mais Paul Otellini considère que son adversaire n'a pas les reins assez solides techniquement : « La réponse simple c'est que leur architecture doit grandir. Les exigences des serveurs sont assez significatives : 64 bits, correction d'erreur, parallélisme multiple, capacités en hyperthreading, infrastructures des systèmes hautement parallèles… Il faut bâtir tout cela pour une nouvelle architecture, et historiquement c'est quelque chose de très difficile à faire.»

Otellini profite de cette annonce pour régler quelques comptes. Concernant Nokia, il déplore sa défection : « Avec le recul, c'était un mauvais choix de partenaire ». Nokia devait présenter des smartphones basés sur MeeGo et la gamme de SoC Medefield et Saltwell pour le second semestre 2011, il faudra désormais attendre la première moitié de l'année prochaine pour voir arriver cette architecture dans un smartphone. « Nous avions travaillé de très près et presque exclusivement avec Nokia, nous avons [donc] libéré ce personnel et changé ce concept en concept de référence que nous proposons à un certain nombre de sociétés. Les smartphones sont un domaine qui focalise l'attention, nous avons une nouvelle équipe dirigeante dans ce domaine et nous allons être très prospères dans ce domaine » Méthode Coué ou vœu pieux, il faudra un peu plus que ces affirmations pour y parvenir alors que le marché commence à se cristalliser autour de quelques acteurs majoritaires.

Otellini cherche également à tordre le cou à la rumeur qui voudrait qu'Apple lui fasse défaut avec le Mac : « cela prendrait trop de temps et leur coûterait bien trop cher », ajoutant qu'en outre les ventes de Mac ont explosé depuis le passage à ses processeurs. Par ailleurs, Intel avait déjà flatté Apple peu de jours avant (lire Intel toujours stimulé par Apple)

Avec ces annonces, Intel semble avoir pris la mesure des efforts qu'il lui reste à faire pour proposer un concurrent crédible aux processeurs ARM, mais il reste à voir si les annonces, et les produits qui leur correspondent, suffiront à inverser la vapeur.