La startup HeyGen a récemment lancé un nouvel outil qui permet de facilement doubler n'importe quelle vidéo dans une autre langue grâce à l'IA. Le programme se démarque par sa simplicité et le fait qu'il s'occupe également de la synchronisation labiale. Le concept est simple : vous envoyez une vidéo d'au moins 30 secondes, et l'IA se charge de vous transformer en polyglotte.

So here at @HeyGen_Official, we've been working on a new AI feature to help creators and businesses translate their videos as simply as possible.

— Joshua Xu (@joshua_xu_) August 3, 2023

Step 1. Upload video

Step 2. Choose your language

Step 3. Submit

Here's a sample of @MKBHD, @elonmusk, @casey and Emma Chamberlain pic.twitter.com/Enoz8YDzWC

Si la voix est parfois perfectible et que le passage au français ajoute un accent québécois, l'IA arrive cependant à déceler et à reproduire certaines intonations pour un résultat globalement impressionnant. Plusieurs langues sont disponibles, à savoir l'anglais, l'espagnol, le français, l'hindi, l'italien, l'allemand… Le site fonctionne avec un système de crédit et offre un essai gratuit. Plusieurs formules payantes sont proposées allant de 48 $ à 179 $ par mois. Elles permettent de retoucher des vidéos plus longues en 4K, de faire sauter le filigrane ou d'obtenir un accès prioritaire aux serveurs.

Si certains se sont amusés à faire parler le général de Gaulle en italien, la startup vise évidemment les entreprises. Il n'est pas difficile de trouver tout un tas de secteurs qui pourraient être intéressés par une pareille technologie : publicité, éducation, divertissement… HeyGen estime notamment qu'elle pourrait décupler la portée de plateformes comme Coursera ou Udemy en rendant ses utilisateurs polyglottes.

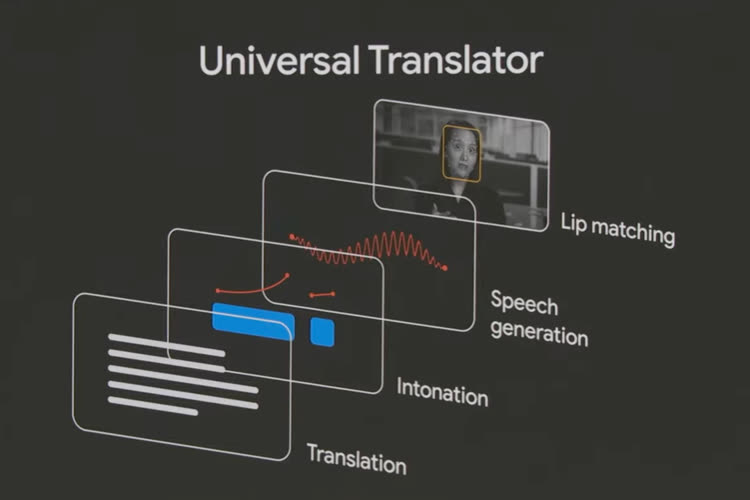

Cependant, on peut craindre de potentiels effets néfastes de cette technologie qui a de quoi inquiéter les doubleurs. La profession a été une des premières à se mettre en grève cet été aux côtés des scénaristes à Hollywood. Google travaille sur un outil similaire au fonctionnement différent, pour le moment exclusivement réservé à ses partenaires.