Apple est sérieusement affairée à construire son propre CDN, écrit StreamingMediaBlog. Cet acronyme désigne les Content Delivery Networks. Des réseaux de serveurs appartenant à des sociétés spécialisées, reliés aux points névralgiques d'Internet. Ils permettent à une entreprise qui en loue l'usage, de voir ses contenus distribués de manière plus efficace à travers le monde quels que soient les volumes de requêtes.

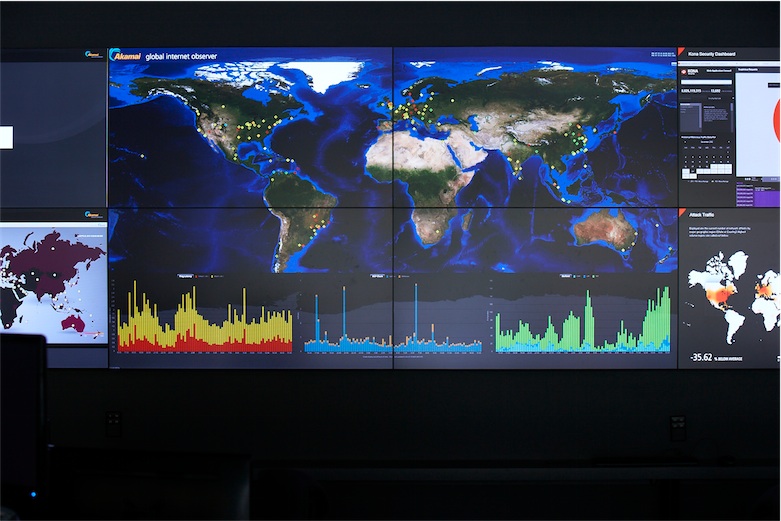

Chez Apple, les contenus à rendre disponibles sans heurts sont nombreux et variés : App Store, Apple Store, iCloud, iTunes Store, bandes-annonces de films et le site du fabricant. Depuis juillet 1999, Apple travaille avec Akamai. À l'époque il s'agissait de lancer le QuickTime TV Network pour envoyer audio et vidéo sur Internet. Puis est venu s'ajouter un autre acteur du domaine, Level 3.

StreamingMediaBlog explique que ce petit milieu du CDN a observé depuis l'an dernier une recrudescence d'embauches par Apple de spécialistes de haut niveau. Des recrues qui forment une équipe constituée l'année dernière, et dont l'objectif est de mettre en place un CDN maison, non plus uniquement pour les besoins internes mais vers les clients de la Pomme.

Les informations sont encore trop succinctes pour savoir jusqu'où vont les ambitions d'Apple dans le domaine et ce qu'elle veut faire précisément. Certains échos parlent d'une volonté d'améliorer les performances d'iCloud. En prenant en charge tout ou partie de cette activité, Apple s'assurait un contrôle plus large encore. Toute la chaîne de transmission, depuis ses serveurs vers ceux des fournisseurs d'accès Internet de ses utilisateurs, seraient sous sa supervision.

Akamai a indiqué en octobre dernier que son plus gros client dans la distribution de contenus - dont il n'a pas donné le nom - avait prévu de renégocier sa facture, après plusieurs années de statu quo. Il a aussi admis que cela aurait un impact sur plusieurs résultats trimestriels. Akamai avait connu à cette époque un boost dans cette partie de son activité grâce à la distribution d'iOS 7. Il semble que le client en question n'est autre qu'Apple.

En constituant un CDN destiné aux échanges vers l'extérieur, Apple ne ferait qu'appliquer une méthode déjà en oeuvre chez d'autres grandes sociétés, observe StreamingMediaBlog. Citant pêle-mêle Microsoft, Google, Netflix, Yahoo, Twitter et Facebook qui ont tous, à des degrés divers, mis en place de telles installations. Cela prend néanmoins du temps. Il a fallu 18 mois au moins pour que les CDN de Microsoft, YouTube ou NetFlix reprennent suffisamment de trafic à leurs partenaires pour que ceux-ci en ressentent les effets, ce qui ne les empêche pas de continuer à fournir des prestations à ces clients.