Une des raisons probables de l'abandon d'Intel par Apple dans les Mac vient notamment du manque d'innovation et du renommage de ses puces. Et avec les Core de 14e génération pour les PC de bureau, Intel semble tomber dans les mêmes travers qu'à la fin des années 2010.

Petit rappel : Intel a lancé l'architecture Skylake en 2015 avec les Core de 6e génération, qui ont fait les beaux jours des premiers MacBook Pro avec une Touch Bar. Et Intel a gardé la même architecture pour les Core de 7e, 8e, 9e et 10e génération dans les puces pour PC de bureau, avec quelques variantes (un peu) améliorées pour les PC portables avec la 10e et la 11e génération. Pour tenter de faire passer la pilule et aussi arriver à sortir une « nouvelle » génération tous les ans, Intel a donc augmenté le nombre de cœurs et la fréquence au fil des années, avec un résultat évident : une hausse très forte de la consommation et des gains parfois assez faibles.

Après une 11e génération un peu hybride (il s'agissait en simplifiant d'un cœur pensé pour les PC portables gravé moins finement), l'arrivée de la 12e génération (Alder Lake) fin 2021 semblait amener de la nouveauté : une nouvelle architecture plus rapide et des cœurs basse consommation… mais encore une consommation mal maîtrisée.

Malheureusement, ça ne s'est pas bien passé : la 13e génération est une évolution (très) timide de la 12e, avec un peu de mémoire cache en plus, plus de cœurs et une fréquence plus élevée (oui, l'histoire se répète). Et la future 14e génération, elle, ne devrait pas se démarquer : attendue dans très peu de temps, elle ne devrait rien amener de neuf.

Comme l'explique Tom's Hardware, Intel se contenterait de quelques cœurs basse consommation en plus sur certains CPU, d'une fréquence plus élevée… et d'une consommation encore en hausse. Par ailleurs, la société ne s'en cache pas vraiment : cette 14e génération porte le nom de Raptor Lake Refresh, c'est-à-dire un renouvellement de la gamme Raptor Lake (la 13e génération).

La suite arrive tout de même

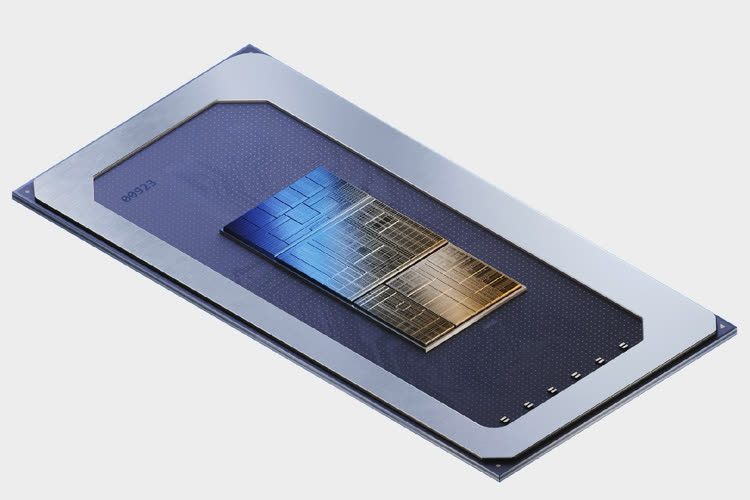

Cette 14e génération semble donc juste être là uniquement pour occuper le terrain et faire acte de présence. Pour la suite, Intel a visiblement deux idées : Meteor Lake, dont nous avons parlé récemment, et Arrow Lake. La première des deux architectures vise essentiellement les PC portables avec des optimisations sur la consommation, et la seconde devrait équiper la 15e génération de Core avec — enfin — une réduction de la consommation.

Intel dévoile Meteor Lake, les Core de prochaine génération qui veulent lutter contre les puces Apple

Il faut enfin noter que la stratégie d'Intel consiste tout de même à lancer une nouvelle génération par an, même s'il n'y a rien de nouveau. Apple, en face, semble aller moins vite, au moins dans les Mac : le M1 date de 2020, le M2 de 2022 et la puce M3 se fait attendre. Par contre, les puces A sont réglées comme une horloge, avec une nouvelle version chaque année dans les iPhone.