Peut-on utiliser deux eGPU en même temps ? La question n’est pas tout à fait idiote. Aucune machine, pas même le nouveau MacBook Air, ne possède qu’un seul port Thunderbolt 3. Disons-le tout de suite, la réponse est positive. Comme souvent toutefois, il ne s’agit pas d’un simple « oui », mais plutôt d’un « oui, mais ».

Apple mentionne clairement cette possibilité dans sa fiche technique dédiée aux processeurs graphiques externes. Elle précise même qu’il vaut mieux « pour des performances graphiques optimales », connecter directement les boîtiers eGPU à votre machine, « et non en série par l’intermédiaire d’un concentrateur ou d’un autre périphérique Thunderbolt. »

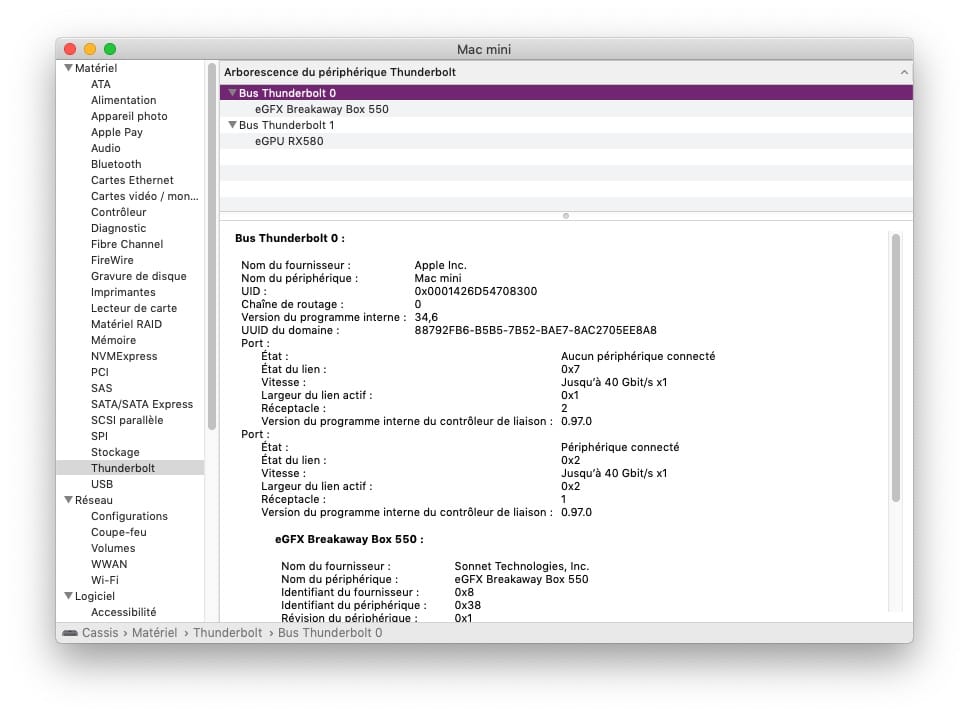

Mais attention, ne les branchez pas à n’importe quel port ! Dans les Mac, un contrôleur Thunderbolt gère deux ports, et donc les machines dotées de quatre ports possèdent deux contrôleurs et deux bus. Vous obtiendrez les meilleures performances en branchant un boîtier par bus (lire : Mac Pro : les ports, c’est important, et pourtant…).

Une fois connectés et démarrés, les deux boîtiers apparaissent dans le menulet « eGPU » (lire : Comment utiliser une carte graphique externe avec macOS). Que le système reconnaisse plusieurs processeurs graphiques externes ne signifie cependant pas qu’il est capable de les exploiter. Rares sont les applications capables d’utiliser plusieurs cartes graphiques, rarissimes sont celles capables d’utiliser plusieurs eGPU.

C’est le cas de LuxMark, l’outil de benchmarking basé sur le moteur de rendu open source LuxCoreRender, mais faut-il parler d’outils exploitant OpenCL, désormais déprécié ?1 Blackmagic fournit le plus bel exemple de prise en charge des eGPU avec son outil de montage et d’étalonnage vidéo DaVinci Resolve. Et pour cause ! Blackmagic propose deux eGPU, conçus en partenariat avec Apple, intégrant les circuits graphiques de l’iMac et de l’iMac Pro.

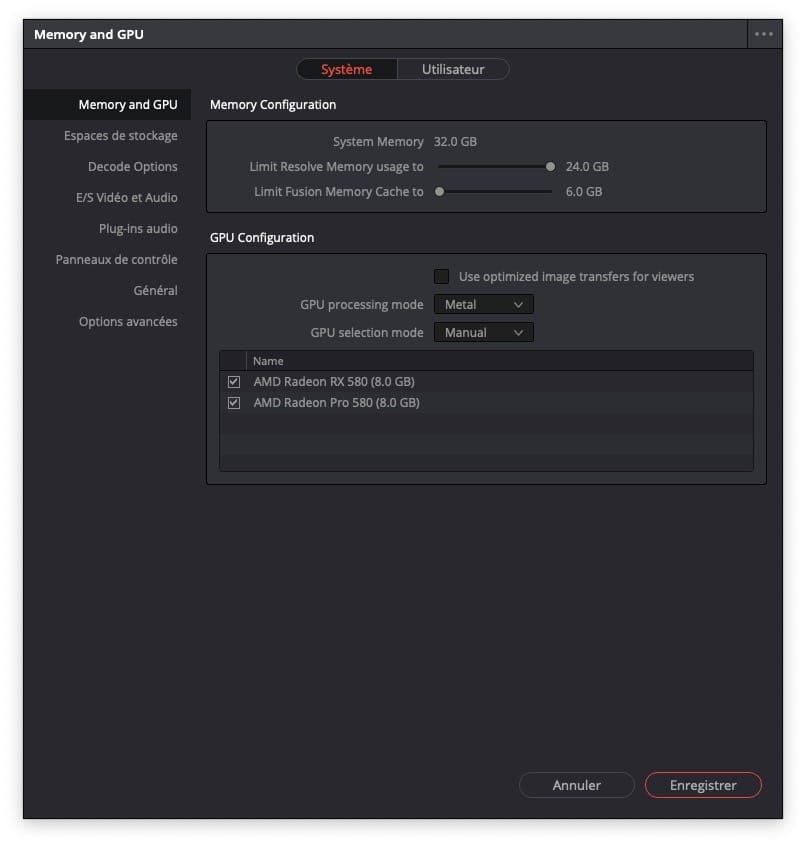

La différence est sensible : armé d’une paire de cartes AMD Radeon RX 580, le Mac mini passe le test Standard Candle en temps réel, ce qu’il est incapable de faire seul. Les préférences de Resolve permettent d’activer ou désactiver l’utilisation des processeurs graphiques, de forcer l’utilisation de telle ou telle API de GPGPU, et même de limiter l’usage de la mémoire.

Si toutes les applications professionnelles offraient les mêmes possibilités ! L’utilisation de multiples boîtiers eGPU serait seulement une question de retour sur investissement. En attendant, c’est au mieux un délire de geek, au pire un pis-aller en attendant un futur Mac Pro permettant d’utiliser des cartes conventionnelles. Les tests menés avec le boîtier Akitio Node Duo, qui peut embarquer deux cartes, en sont la parfaite démonstration.

- Pour celui qui a répondu « oui » au fond de la salle : attendez-vous à un triplement des performances avec un eGPU Radeon RX580 sur un Mac mini 2018. ↩︎