Les amateurs de boitiers eGPU à utiliser avec les tout derniers MacBook Pro 15" 2016 trouveront des tests de performances chez Bare Feats et eGPU.io qui soulignent l'intérêt de cette combinaison d'un portable avec une ou plusieurs cartes graphiques externes.

Entre la présence de ports Thunderbolt 3 et la mise à disposition par Nvidia de pilotes pour ses dernières cartes graphiques, les choses vont en se simplifiant pour les utilisateurs qui veulent pousser les performances de machines dont les cartes graphiques internes sont figées.

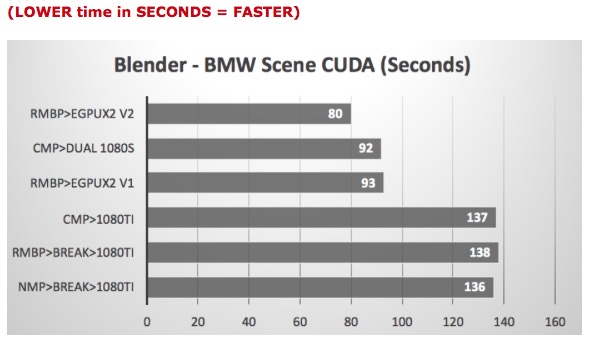

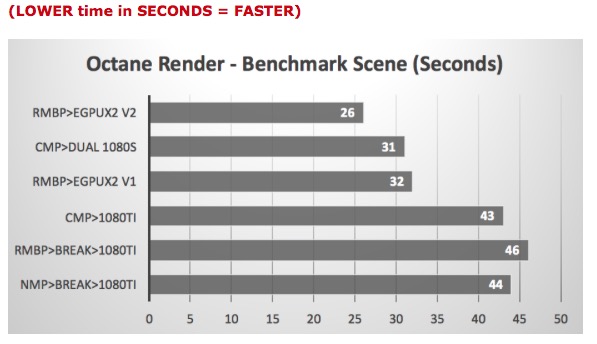

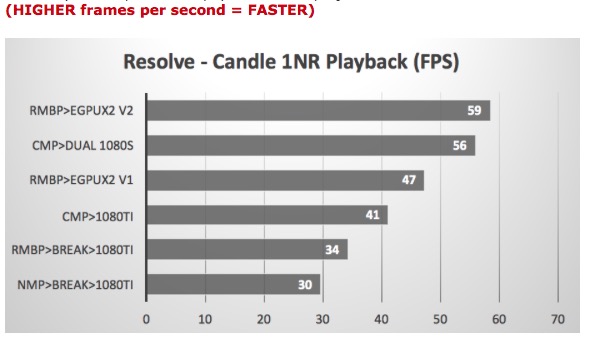

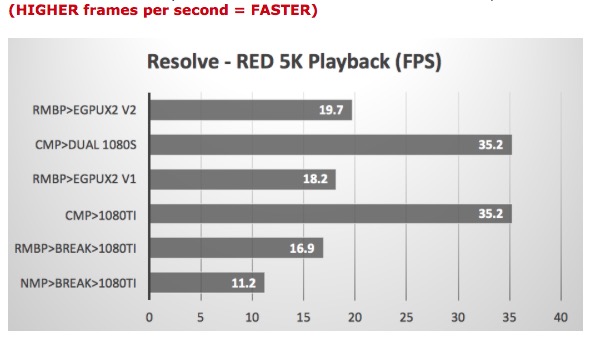

Bare Feats a comparé 6 installations pour voir ce que cela donnait avec deux boitiers eGPU branchés simultanément en Thunderbolt 3 sur un MacBook Pro 2016. Puis ces même cartes avec les deux générations de Mac Pro. Il est difficile d'en tirer une conclusion générale tant ces configurations sont différentes mais ces essais restent instructifs pour les curieux.

rMBP > eGPUx2 V2 : désigne le dernier MacBook Pro 15" avec deux boitiers Sonnet eFX Breakaway (sortie prochaine à 300 $) et AKiTiO Node (même prix), équipés de cartes NVIDIA GTX GeForce 1080 Ti et GeForce 1080. Ils sont reliés en Thunderbolt 3.

rMBP > eGPUx2 V1 est la même configuration mais avec deux NVIDIA GTX GeForce 1080.

cMP > Dual 1080s désigne l'ancien Mac Pro tour avec deux GeForce 1080 à l'intérieur

cMP > 1080Ti, une seule GeForce 1080 Ti dans le Mac Pro tour

rMBP > Break > 1080Ti, une GeForce 1080 Ti dans un boitier eGPU Sonnet branché à un MacBook Pro en Thunderbolt 3.

nMP > Break > 1080 Ti, une GeForce 1080 Ti dans un boitier eGPU Sonnet branché à un Mac Pro 2013 en Thunderbolt 2.

Chez eGPU.io aussi on a employé un MacBook Pro 15" Core i7 fin 2016 avec d'un côté ses différentes options de cartes graphiques AMD Radeon Pro 450/455/460 + Intel HD 530 et de l'autre, avec des boitiers eGPU AKiTiO Node et Mantiz Venus (389 $) branchés en Thunderbolt 3.

Dans le cas présent ils contenaient à chaque fois une GeForce GTX 1080 Ti. Les performances dans les tests Luxmark, Valley et Heaven sont multipliées au minimum par 3 ou 4 face à l'équipement de base de ces portables.