Dans les grands changements apportés par les Mac M1, il y a ce qui se voit d'emblée, comme la vitesse de ces machines et leur autonomie impressionnante sur les portables. Et puis il y a des évolutions plus discrètes mais pratiques au quotidien. C'est le cas pour la manière dont ces machines s'affranchissent de l'option « Power Nap » et d'une autre relative à la santé de la batterie.

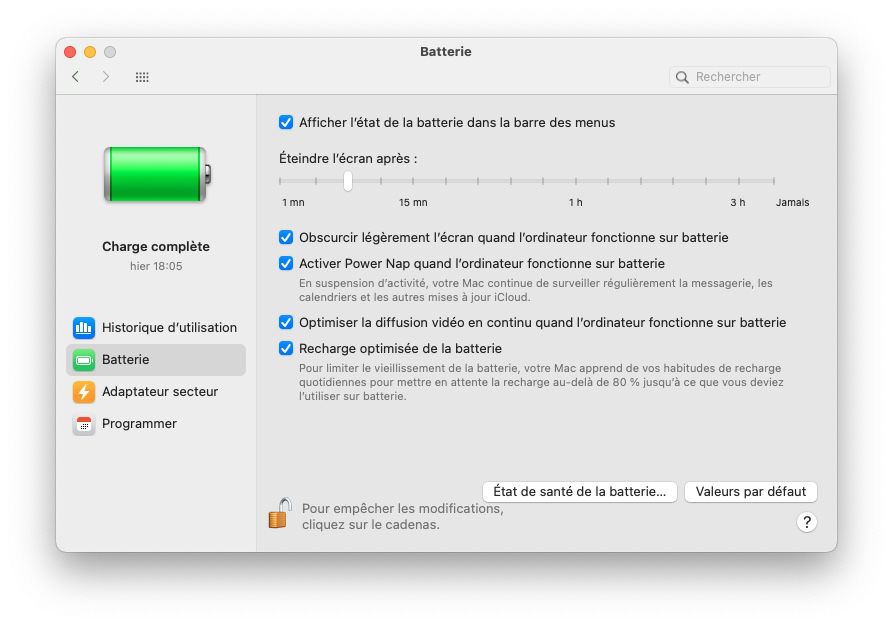

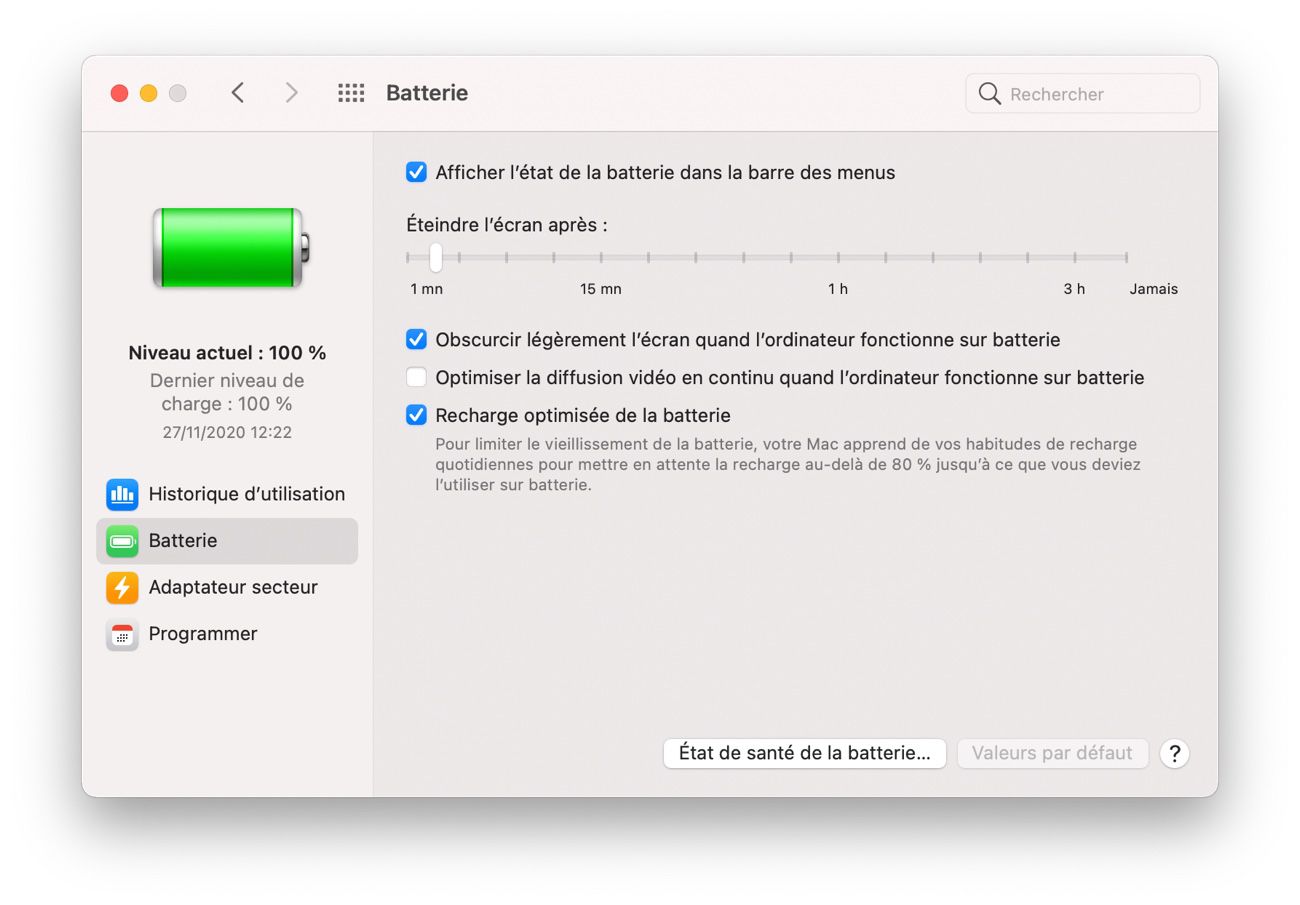

On l'a détaillé dans notre long test du Mac mini M1 mais cela mérite d'être doublement souligné pour les MacBook Air/Pro M1 : l'option « Power Nap » n'existe plus dans le panneau de préférences « Batterie ». Seuls les Mac Intel conservent cette case à cocher.

Bref rappel : Power Nap a été popularisé par les Mac dotés d'un SSD, plus rapides à se mettre en branle. Même si la machine a son activité suspendue, macOS exécute à intervalles réguliers quelques tâches d'actualisation : pour Mail, pour Calendrier, pour iCloud et, si une alimentation secteur est présente, pour récupérer des mises à jour d'application et lancer Time Machine. Ainsi, lorsqu'on sort sa machine de veille, on a des chances de trouver son environnement de travail fin prêt, au lieu d'attendre que chaque logiciel récupère les dernières infos.

On a pu le constater sur l'un de nos portables M1, celui-ci est beaucoup plus prompt que ses prédécesseurs Intel à rapatrier les dernières données. À peine détecte-t-il la connexion Wi-Fi en rentrant au domicile, et alors qu'il est encore dans le sac, qu'il lance l'actualisation. Avec l'appui d'une sortie de veille quasi immédiate, cela contribue à avoir une machine immédiatement opérationnelle et constamment à jour.

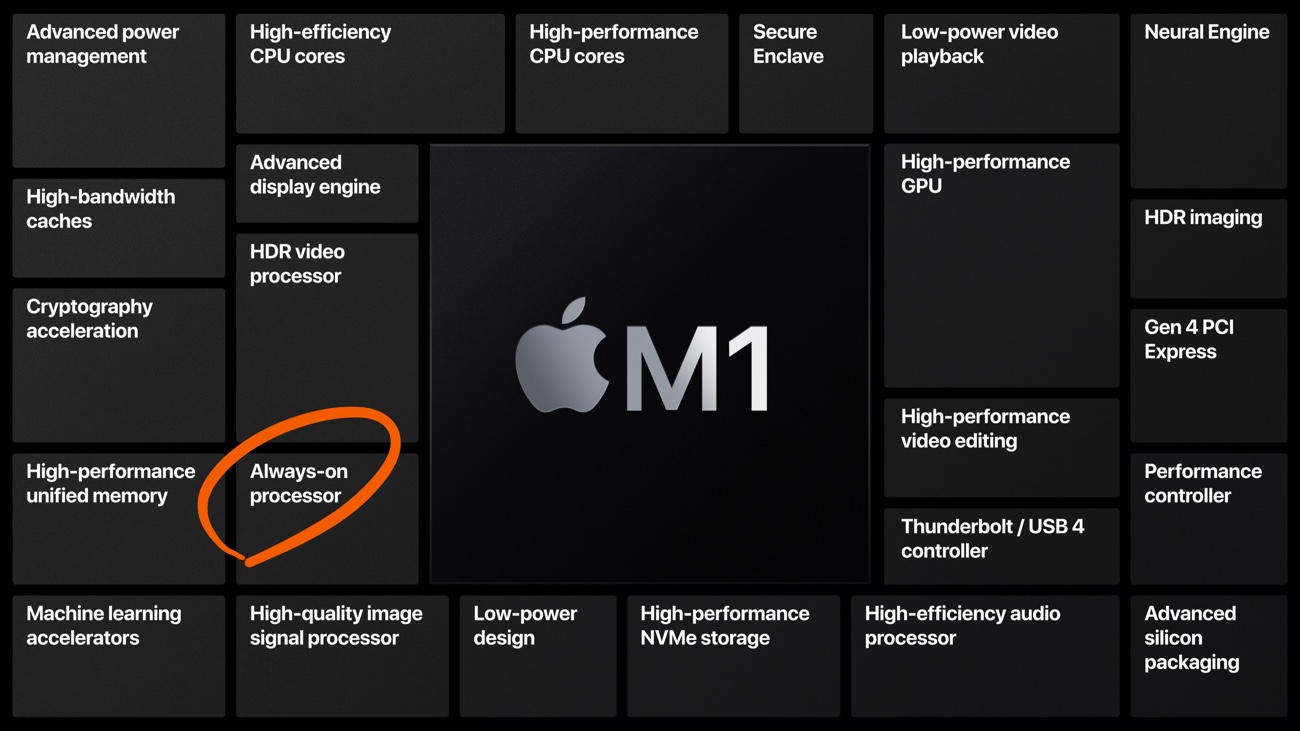

En retirant la case « Power Nap », Apple a intégré cette fonction au comportement naturel du système, par conséquent aussi on ne peut plus la désactiver. Mais le chipset M1 est justement prévu pour assurer cette tâche sans impact notable sur l'autonomie (ou sur la consommation électrique, s'agissant d'une machine de bureau comme le mini). L'ordinateur peut fonctionner en permanence en ultra-basse consommation, comme on a pu le constater en observant l'activité nocturne du Mac mini.

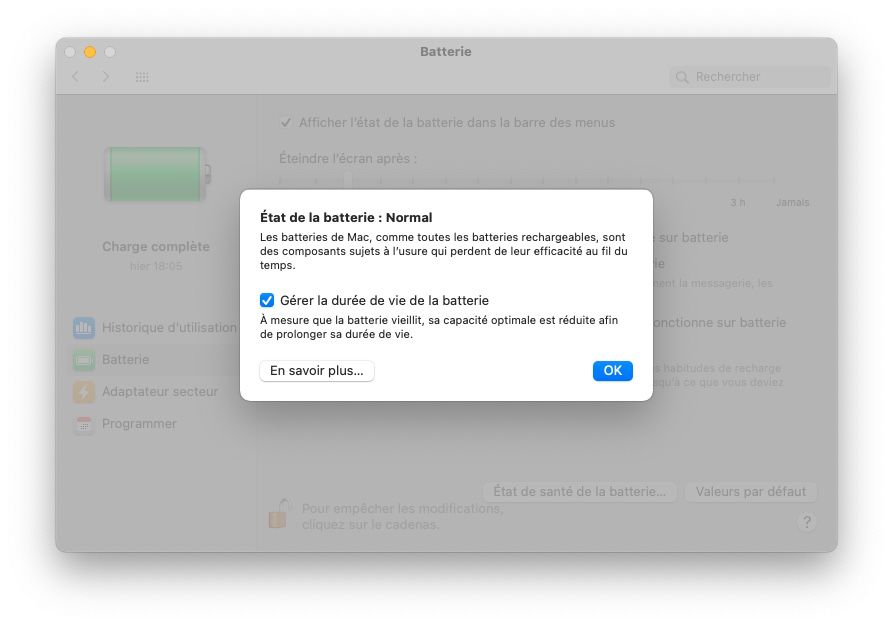

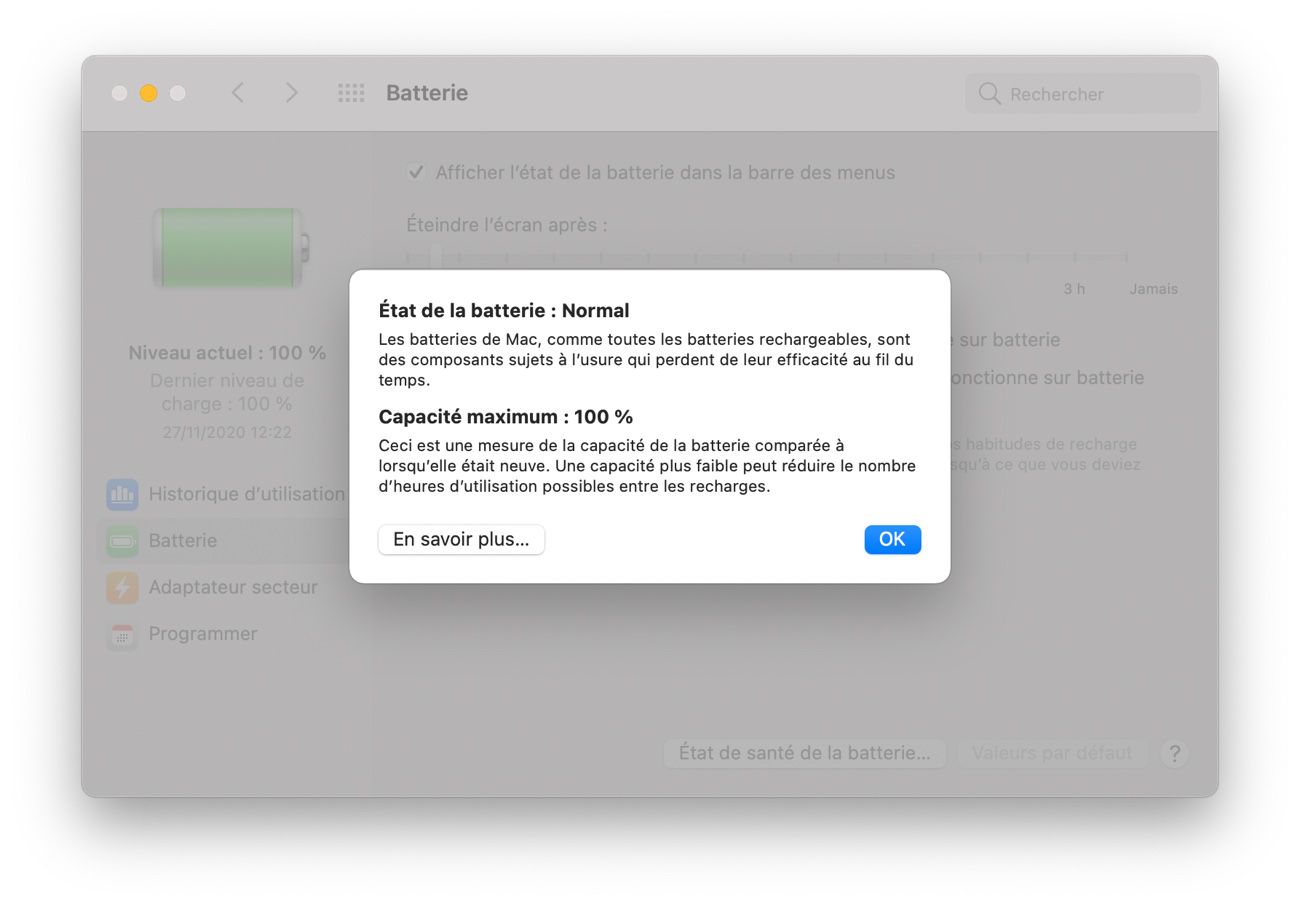

Les portables M1 disposant d'une autonomie hors du commun, ce Power Nap permanent n'est pas une source de préoccupation lorsqu'il opère sur batterie. Autre signe qu'à capacité de batterie égale, les Mac M1 se comportent beaucoup mieux que les Mac Intel, il y a la disparition aussi de l'option « Gérer la durée de vie de la batterie » dans « Etat de santé de la batterie ».

Lorsqu'on cochait cette case, macOS pouvait empêcher que la batterie ne se charge systématiquement à son maximum, pour en prévenir un vieillissement prématuré. La contre-partie était qu'on pouvait se retrouver avec une batterie qui n'était pas à 100 %, pile lorsqu'on avait besoin de s'en servir sur une longue durée.

Désormais, la page d'explications de cette fonction diverge selon qu'elle traite des Mac à puce Intel ou des Mac à puce Apple. Dans la seconde il n'est plus fait mention de ce risque d'avoir moins d'autonomie à sa disposition. Probablement parce qu'Apple considère que l'autonomie de ses portables M1 étant ce qu'elle est, ce n'est plus un motif d'inquiétude.

On n'a plus à choisir entre soigner la longévité de sa batterie et s'assurer une bonne autonomie, macOS et le processeur M1 s'attachent à garantir les deux en même temps.