CloudFlare a annoncé récemment l’ajout d’une option qui se charge de bloquer tous les robots liés aux intelligences artificielles génératives, comme GPTBot qui est géré par OpenAI pour ChatGPT, ClaudeBot d’Anthropic qui alimente Claude ou encore Applebot-Extended qui servira de fondations aux fonctionnalités d’Apple Intelligence. Cet ajout répond à la demande d’une partie des créateurs de sites web qui ne veulent pas que leurs contenus servent à alimenter les grands modèles de langage qui servent de base aux IA génératives. Contrairement à ce que l’on pourrait penser, un tel blocage est en réalité difficile à obtenir.

Rappelons tout d’abord que les robots sont très courants sur le réseau internet, il s’agit de programmes qui visitent des pages web pour diverses raisons. Les moteurs de recherche sont les premiers utilisateurs de ces robots, qui leurs permettent d’indexer toutes les pages web existantes pour fournir des résultats de recherche à leurs utilisateurs. Des robots peuvent aussi servir à vérifier si une page web a changé, si un site web ne répond plus ou bien d’autres tâches. Dernièrement, des robots ont permis de récupérer le maximum de texte publié sur internet afin de constituer des corpus suffisamment grands pour satisfaire les besoins des grands modèles de langage qui sont ensuite utilisés par les IA comme ChatGPT et ses concurrents.

Il existe une convention depuis les années 1990 pour (notamment, le fichier servant aussi à indiquer la carte du site, ou sitemap, qui liste toutes les URL) réguler l’accès des robots aux sites web : le webmestre peut ajouter un robots.txt à la racine de son site. À l’intérieur de ce fichier, il peut indiquer s’il autorise ou refuse l’accès à tout ou partie de ses pages web, pour tous les robots ou pour une partie des robots. La syntaxe consiste à lister des robots en fonction de leur identifiant (User-agent) puis les pages autorisées (Allow) et celles qui sont interdites. Par exemple, ces deux lignes vont indiquer au robot de Google de ne pas indexer toutes les URL avec /secret/, toutes les autres lui sont autorisées.

User-agent: Googlebot

Disallow: /secret/

Même si cette convention est en passe de devenir un standard, il faut bien comprendre qu’il ne s’agit pas d’une restriction technique, mais bien d’une convention que chaque robot peut respecter ou ignorer. Si les plus gros moteurs de recherche, Google en tête, se sont engagés à respecter les règles inscrites dans le fichier robots.txt, c’est loin d’être le cas de tous les acteurs. En particulier, les créateurs des IA génératives ont tendance à ignorer les avis des créateurs de sites et à indexer tous les contenus accessibles, indépendamment du contenu du fichier en question. Apple fait figure d’exception à cet égard, mais cette convention ne suffit pas le plus souvent.

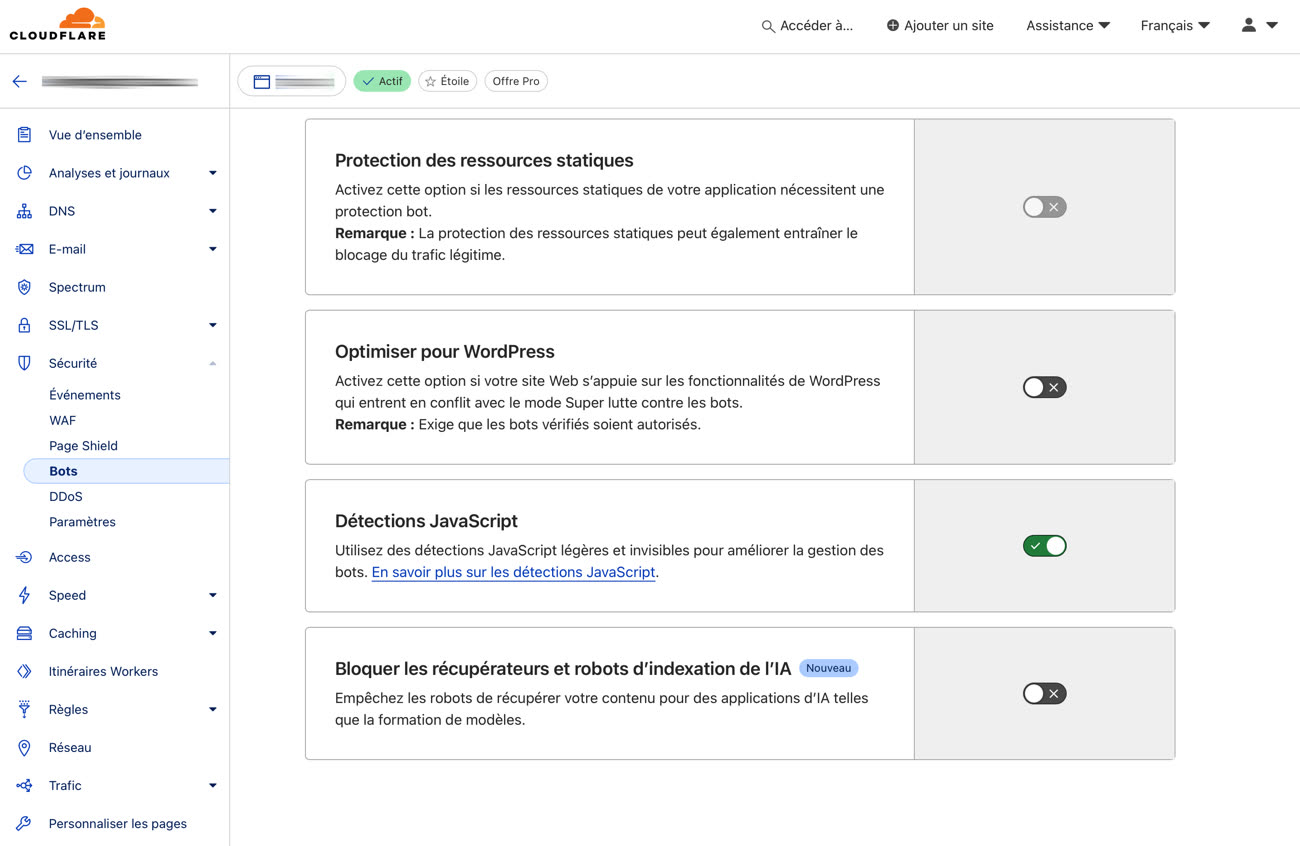

Pour bloquer les robots liés à l’intelligence artificielle, il faut mettre en place une solution technique, qui leur bloque l’accès au serveur et les empêche ainsi d’indexer le contenu qu’il contient. La solution dépend du serveur web utilisé, Robb Knight a détaillé ce qu’il a mis en œuvre pour Nginx par exemple, mais CloudFlare apporte une option nettement plus simple pour ses clients. En cochant la case dédiée dans les paramètres « Bots », un utilisateur du service peut bénéficier d’un blocage technique de tous les robots connus liés à l’IA.

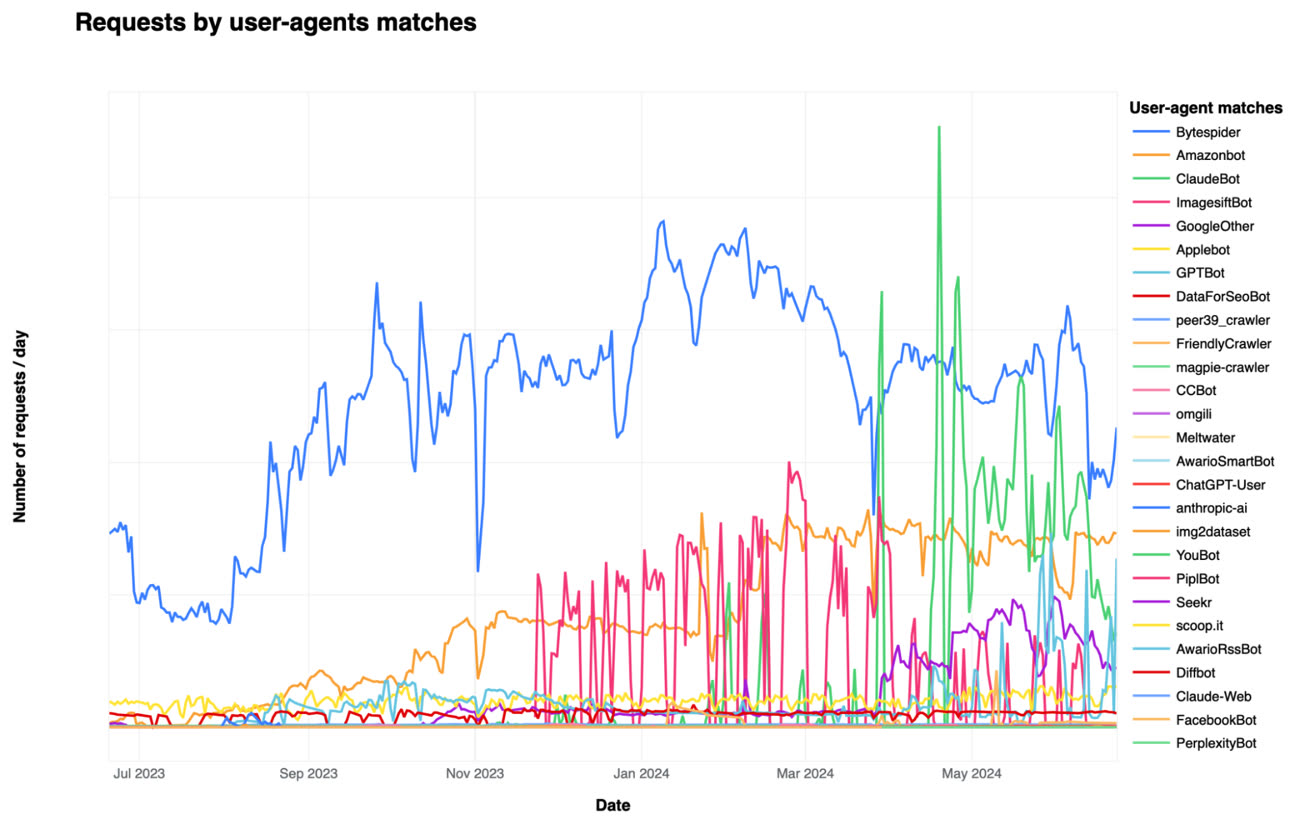

Si le sujet vous intéresse, CloudFlare a publié quelques détails sur les robots liés à l’intelligence artificielle qui indexent le plus les sites gérés par ses soins. Petite surprise au passage, GPTBot n’est pas le premier, il s’agit de Bytespider, un robot programmé par ByteDance, le propriétaire de TikTok.

CloudFlare précise aussi que son outil ne se base pas sur une base de données statiques, car les robots peuvent aisément se présenter sous un autre nom. L’entreprise a mis au point un système basé sur de l’apprentissage automatisé pour repérer les robots et les bloquer quel que soit leur identifiant. Ces méthodes de détection seront mises à jour régulièrement pour contrer les mesures mises en place pour les contourner, un jeu du chat et de la souris qui peut aussi bloquer des visiteurs légitimes, c’est le problème.

Malgré tout, la solution proposée par CloudFlare est indéniablement la plus simple et complète à l’heure actuelle si vous ne voulez pas que les robots de l’IA viennent indexer votre site. Cette nouvelle option est proposée gratuitement à tous les clients de l’entreprise.

Source :