Meta vient de présenter la deuxième grande version de LLaMA, son modèle de langage s'opposant au GPT-4 d'OpenAI. L'entreprise a annoncé la nouvelle à l'occasion d'un événement de Microsoft, précisant que cette dernière était son « partenaire privilégié » pour LLaMA 2. Bonne nouvelle : le modèle sera distribué gratuitement sous une licence permettant une utilisation commerciale.

La stratégie de l'open source est diamétralement opposée à celle d'OpenAI et de Google, qui gardent leurs algorithmes sous clefs. La diffusion d'un LLaMA 2 accessible à tous devrait multiplier les projets basés sur l'IA, et en faire une solution de choix pour les entreprises ne désirant pas payer pour les API de la concurrence.

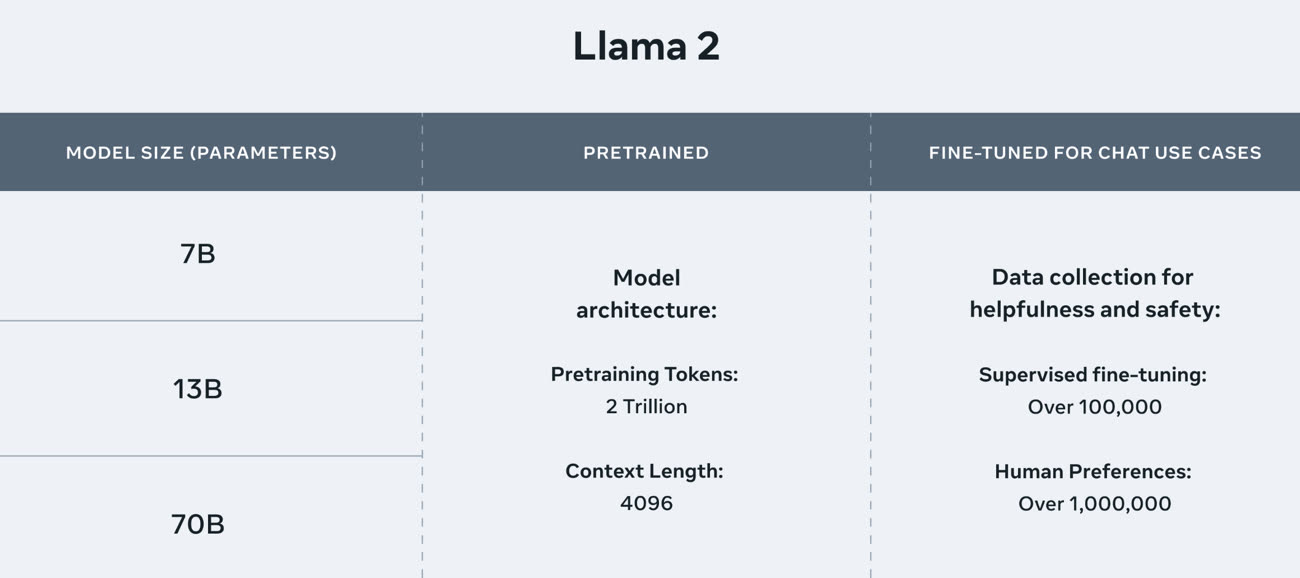

LLaMA 2 est disponible en trois déclinaisons plus ou moins gourmandes (7B, 13B et 70B) et a été entraîné avec 40% de données en plus par rapport à la première version. Selon Meta, LLaMA 2 est légèrement moins performant que GPT-4 ou PaLM 2, et loin derrière OpenAI en termes de programmation. Un partenariat avec Qualcomm va permettre d'optimiser le modèle pour les téléphones et autres appareils embarquant un SoC de l'entreprise à partir de 2024.

« Nous pensons qu'une approche ouverte est la bonne pour le développement des modèles d'IA d'aujourd'hui, en particulier ceux du secteur génératif où la technologie progresse rapidement », a déclaré Meta. L'entreprise ajoute vouloir mettre le modèle entre les mains de tous, que ce soit celles des grandes boîtes, des entrepreneurs ou des chercheurs. Les « poids » des modèles (les fichiers contenant les valeurs des paramètres des réseaux neuronaux formés) sont téléchargeables, tout comme le code pour le modèle préentraîné ainsi que les versions affinées pour les conversations.

Nous pensons que [l'open source] est plus sûr. Ouvrir l'accès aux modèles d'IA actuels signifie qu'une génération de développeurs et de chercheurs peut les tester en profondeur, identifier et résoudre les problèmes rapidement, en tant que communauté. En voyant comment ces outils sont utilisés par d'autres, nos propres équipes peuvent en tirer des enseignements, améliorer ces outils et corriger les vulnérabilités.

La mise à disposition de ce nouveau modèle a été faite à l'occasion d'un évènement Microsoft. Les deux entreprises disposent d'un partenariat, ce qui fait que Llama 2 est disponible dans le catalogue de modèles Azure AI. Il est également « optimisé » pour fonctionner localement sur Windows. Ce rapprochement avec Meta fait sens pour la firme de Redmond : elle gagne ainsi une longueur d'avance sur son principal rival Google, et peut proposer à ses clients un modèle personnalisable.

Meta mise sur l'open source pour gagner la course à l'IA, ce qui est loin d'être idiot : LLaMA va être à la base de nombreux projets open source et s'imposer dans la communauté libre. L'entreprise pourra regarder comment est optimisée sa création et réutiliser les trouvailles par la suite. De plus, les conditions d'utilisations impliquent que les entreprises dépassant la barre des 700 millions d'utilisateurs actifs devront demander une licence à Meta. Un chiffre très haut qui empêche son utilisation par Amazon ou Google.

IA : Google et OpenAI risquent de rapidement se faire dépasser par la communauté open source, estime un chercheur

Le modèle peut dès à présent être téléchargé via AWS, Hugging Face et d'autres fournisseurs. Cette approche change de la technique utilisée pour la première version de LLaMA : le modèle était accessible sur liste d'attente uniquement pour les chercheurs… mais a fuité sur 4chan en quelques heures.