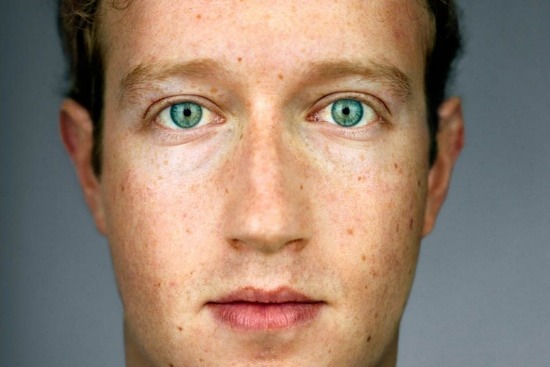

Facebook manipule ses utilisateurs pour une étude : scientifique ou inquiétant ?

Tout ne serait qu’une histoire de « mauvaise communication » , comme l’a avoué Sheryl Sandberg, la directrice des opérations de Facebook à la presse indienne. Et pourtant, l’affaire des flux manipulés dans le cadre d’une étude scientifique risque bien de se transformer en véritable cauchemar, ternissant un peu plus l’image du réseau social.

En janvier 2012, Facebook a mené une expérimentation pour le compte de chercheurs des universités Cornell (Californie) et de San Francisco. Le réseau social a modifié l’affichage des statuts chez 689 003 utilisateurs choisis au hasard, sans rien leur révéler. Pendant une semaine, leurs flux d’actualité ont affiché des messages soit positifs, soit négatifs. Les scientifiques ont ensuite analysé les messages de ces cobayes afin d’en connaître la teneur émotionnelle.

L’objectif de l’étude était de savoir si l’humeur des utilisateurs de Facebook pouvait être influencée par les émotions exprimées de leurs correspondants. Les enseignements de cette enquête à grande échelle prouvent que oui… dans une certaine mesure : les sentiments sont bien « contagieux » par écran interposé (les utilisateurs bombardés de statuts négatifs postent ensuite des messages plutôt négatifs, et c’est l’inverse pour ceux qui ont reçu des statuts positifs). L’étude reste néanmoins contestée pour sa qualité scientifique, ne serait-ce que sur l’interprétation faite du terme « émotion » par les chercheurs, ou encore par l’environnement de l’utilisateur qui ne se limite pas au seul Facebook et dont l’influence est impossible à quantifier.

Mais au-delà des conclusions de cette enquête, ce sont surtout les conditions de sa réalisation qui font polémique, et le fait que Facebook n’ait prévenu personne de cette étude – et surtout pas les cobayes. La manipulation des flux d’actualités est avérée, ce qui pose de sérieuses questions sur l’influence que peut exercer le réseau social (avec en toile de fond, des accusations sourdes de « Big Brother »). Si Facebook peut disposer à sa guise des informations publiées par ses utilisateurs et organiser les flux d’activités suivant le bon vouloir de ses algorithmes, ce ne sont sans doute pas des raisons pour manipuler ainsi ses abonnés… même si l’on parle ici d’une étude scientifique sans but publicitaire.

Facebook s’est justifié en expliquant réaliser des recherches pour « améliorer » ses services en essayant de « comprendre » la réponse des utilisateurs à des contenus positifs ou négatifs. Adam D. I. Kramer, co-auteur de l’étude, a également minimisé la portée de l’étude en précisant que seuls 0,04% des utilisateurs du réseau social ont été ainsi « surveillés » tout en assurant qu’aucun statut ne leur avait été caché. Depuis 2012, Facebook a révisé ses pratiques en matière de recherches.

Ces explications n’ont pas suffi à calmer les inquiétudes. L’Information Commissioner’s Office britannique, équivalent de la Cnil française, va ainsi ouvrir une enquête et juger si Facebook a enfreint la législation sur le respect des données privées. L’excuse de l’« erreur de communication » avancée par Sheryl Sandberg risque de ne pas suffire.

@stiflou

Il n'y a pas de lien. C'était juste pour te montrer avec un exemple un peu plus explicite qu'on peut très bien faire un truc anodin comme d'habitude (la forme) mais avec des conséquences très différentes (le fond)

Donc dire "Ok pas la peine d'ne faire un drame, Facebook a toujours modifié nos statuts pour améliorer ses algorithmes" n'est pas suffisant pour juger de la gravité de la situation.

J'ai l'habitude d'employer ce genre de parallèle pour expliquer la logique de mes raisonnements, mais ça implique justement d'en extraire ce qui diffère pour ne garder que ce qui est commun (c'est un truc très mathématique en fait) et parfois ça ne passe pas du tout.

Facebook a aussi modifier ses algorithmes pour ameliorer le flux de statut. Ca va dans les 2 sens.

Mais je pense qu'avoir une étude scientifique pour comprendre ces mécanismes psychologique est primordial pour pouvoir les détecté. Maintenant que l'on sait ca, Facebook et les autres devront faire attention a cela dans leur algo sous crainte de critiques.

J'ajouterai aussi que si tu veux combattre le lavage de cerveau il faut aussi combattre la pub, la télévision, la téléréalité, les nouvelles qui sont des recopies de depeches AFP sans analyse, ...

Je pense que Facebook devrait proposer a ses utilisateurs si ils sont pres a subir ce genre d'expérience.

Dans tous les cas c'est un sujet complexe.

@Stardustxxx

Effectivement, les études peuvent être une bonne choses, mais il convient effectivement aussi d'en informer les sujets, sinon, c'est de l'espionnage, et c'est pas très moral ... Mais dés que ça touche à la morale, c'est effectivement complexe ...

Pour ma part, et cela doit se voir dans mes commentaires, je combats avec assiduité la mauvaise pub, la mauvaise télévision, la téléréalité (ah tiens, pas besoin de « mauvaise » devant ^^), et la désinformation ;)

Pages