Il n’y a pas que les PC assemblés avec soin qui sont plus rapides que les Mac, un simple RaspBerry Pi 3 vendu à peine 50 € peut terminer une tâche deux fois plus vite qu’un Mac portable ! Bon, autant le dire d’emblée, ce n’est pas systématiquement le cas. C’est même encore un euphémisme, puisque ce n’est le cas que dans un seul cas très précis, mais la comparaison mise en avant sur le blog des créateurs du mini-ordinateur reste impressionnante.

Le RaspBerry Pi 3 est un ordinateur destiné aux bricoleurs, mais aussi à l’éducation. Et l’un des objectifs de cette version est d’être parfaitement optimisée pour Scratch, un langage dynamique imaginé par le MIT pour apprendre le développement aux enfants. On peut l’utiliser pour créer des petits jeux et programmes dès l’âge de huit ans.

Et comme ces deux vidéos le prouvent, le RaspBerry Pi 3 fait deux fois mieux qu’un MacBook Pro doté d’un Core i5 et sorti en 2011. Certes, cela prouve surtout que Scratch est bien mieux optimisé sur le mini-ordinateur que sur l’appareil d’Apple, ce qui n’est pas rien. En théorie, le processeur du portable devrait écraser littéralement celui du Pi 3, mais avec suffisamment de travail, on peut inverser les rôles.

Et même si ce n’est pas utile à la majorité dans le cas de Scratch, un même effort d’optimisation avait été mené par le passé pour le media-center Kodi, et pour le navigateur web de Gnome, Epiphany. Dans les deux cas, ce travail a permis d’optimiser suffisamment ces logiciels assez lourds pour les faire tourner correctement sur les RaspBerry Pi.

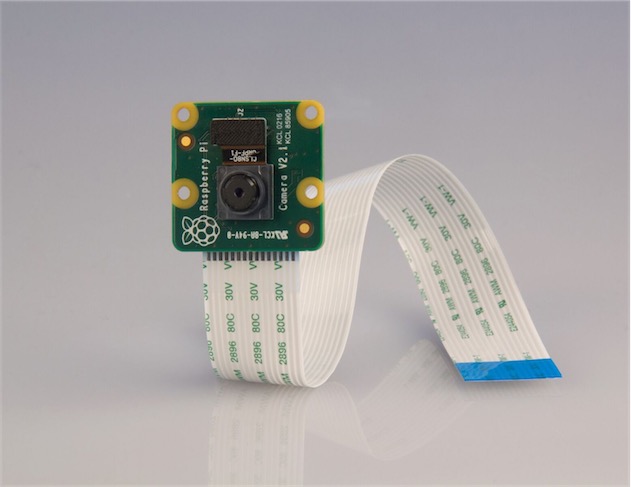

Et puisque l’on évoque ces petits ordinateurs pas chers, la fondation Raspberry a conçu un nouvel accessoire pour accompagner les Pi : une caméra. Ou plutôt, un nouveau modèle qui vient remplacer l’ancienne sortie en 2013. Capteur Sony de 8 mégapixels et toujours 25 $, de quoi enrichir encore son installation avec de l’image.

[MàJ 27/04/2016 10h17] : comme certains lecteurs plus attentifs que l'auteur l'ont noté, il s'agit d'un MacBook Pro, puisque les bordures autour de l'écran sont noires.