On a rapidement mis la main sur les premières mesures de performance du CPU intégré à l’Apple M1 Pro Max, la nouvelle puce d’Apple dédiée aux MacBook Pro. Mais il nous manque encore les premiers bench de son GPU, qui peut monter jusqu’à 32 cœurs en haut de gamme et qui doit affronter les meilleures puces graphiques de la concurrence.

En attendant les chiffres qui ne manqueront pas de fleurir dans les prochains jours, Apple a donné un bon indice des performances à attendre, comme le note @stroughtonsmith. En effet, le constructeur ne s’est pas contenté de graphiques promettant monts et merveilles face à une concurrence anonyme, il y avait une toute petite légende avec le nom des ordinateurs utilisés pour la comparaison.

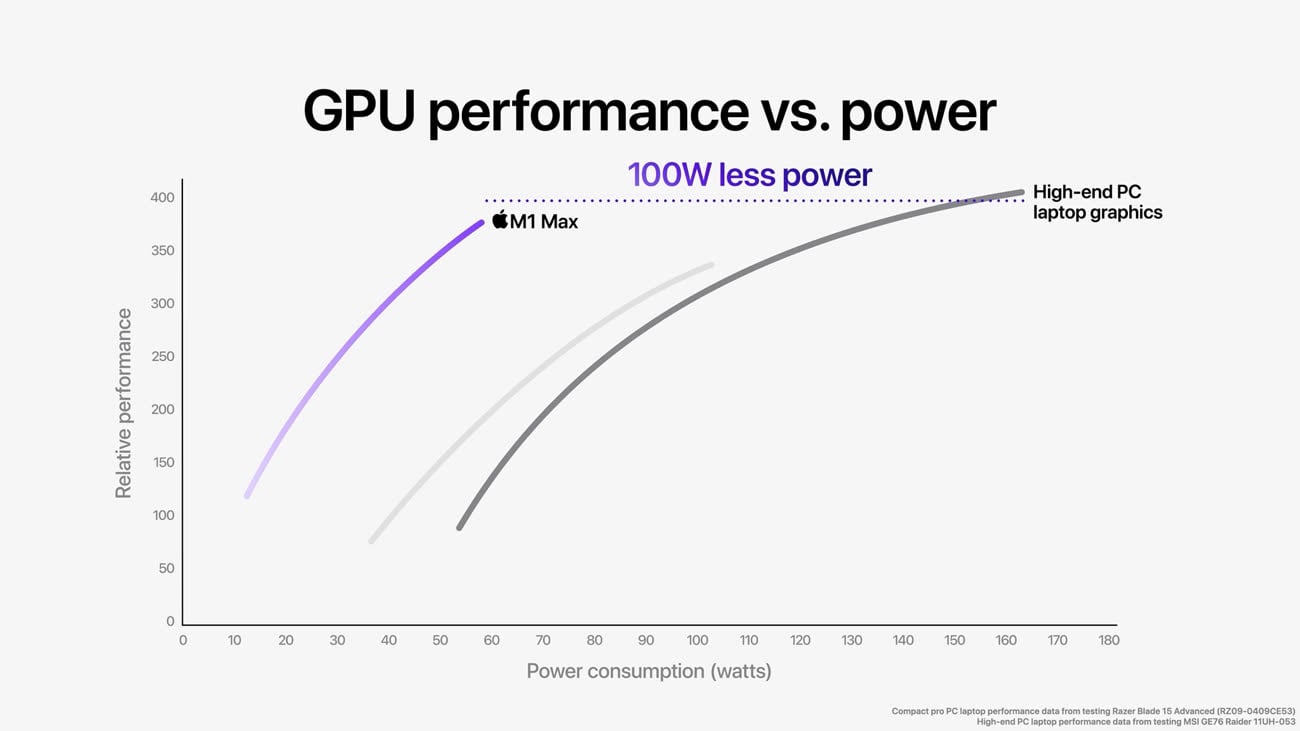

Ainsi, Apple a comparé le GPU de son M1 Max à celui du MSI GE76 Raider 11U053 (ouf), un ordinateur dédié aux joueurs qui intègre une RTX 3080 de Nvidia. C’est le haut de gamme actuel de ce que le constructeur peut offrir dans un ordinateur portable et il est associé à 16 Go de mémoire dédiée. Selon le constructeur, sa puce haut de gamme offre des performances proches, mais en consommant 100 W de moins de puissance.

C’est un écart énorme, surtout quand on sait que l’adaptateur secteur fourni avec les MacBook Pro 16 pouces délivre 140 W au maximum. Mais il suffit de lire la fiche technique détaillée de l’ordinateur de MSI pour comprendre que l’on est dans un autre monde. Sur cet ordinateur fourni avec une alimentation de 240 W, la carte graphique peut solliciter à elle seule jusqu’à 155 W en pointe !

Pour le dire autrement, la carte graphique de cet ordinateur portable peut consommer plus que le MacBook Pro 16 pouces complet, y compris son CPU de 10 cœurs et son écran avec ses 7,7 millions de pixels qui peuvent être rafraîchis 120 fois par seconde. En comparaison, MSI se contente d’une dalle de 17 pouces en 1080p, même si son taux de rafraîchissement est plus élevé (jusqu’à 360 Hz).

Cet écart sur la consommation a de multiples conséquences. Physiquement, l’ordinateur de MSI est un transportable de près de 3 kg avec des choix esthétiques bien différents de ceux d’Apple, mais contraint par les règles en avion sur la capacité de sa batterie. Les deux ordinateurs sont ainsi bloqués à une batterie de 100 Wh, mais là où celui d’Apple peut offrir une autonomie décoiffante, avec 14 heures annoncées de navigation web, celui de MSI se limite à trois heures en usage normal selon ce test.

Et pour ne rien arranger, les performances de la carte graphique sont fortement limitées quand l’ordinateur est sur sa batterie. C’est logique, la batterie seule ne peut pas offrir 155 W de puissance et il faut utiliser l’ordinateur branché pour en profiter pleinement. Alors que les performances des nouveaux MacBook Pro sont valables que l’ordinateur soit alimenté par un câble ou uniquement via sa batterie. Et en agissant a priori dans un bien meilleur confort que le PC de MSI, en termes de ventilation et de température.

Apple a toujours choisi une voie bien différente de ces PC dédiés aux joueurs, en ne compromettant jamais le confort ou l’autonomie pour obtenir les meilleures performances. C’est d’ailleurs pour cette raison, entre autres, que l’entreprise a abandonné les produits d’Intel, AMD et Nvidia au profit de ses propres puces…

Test du Gigabyte Aero 17 HDR : l’anti MacBook Pro

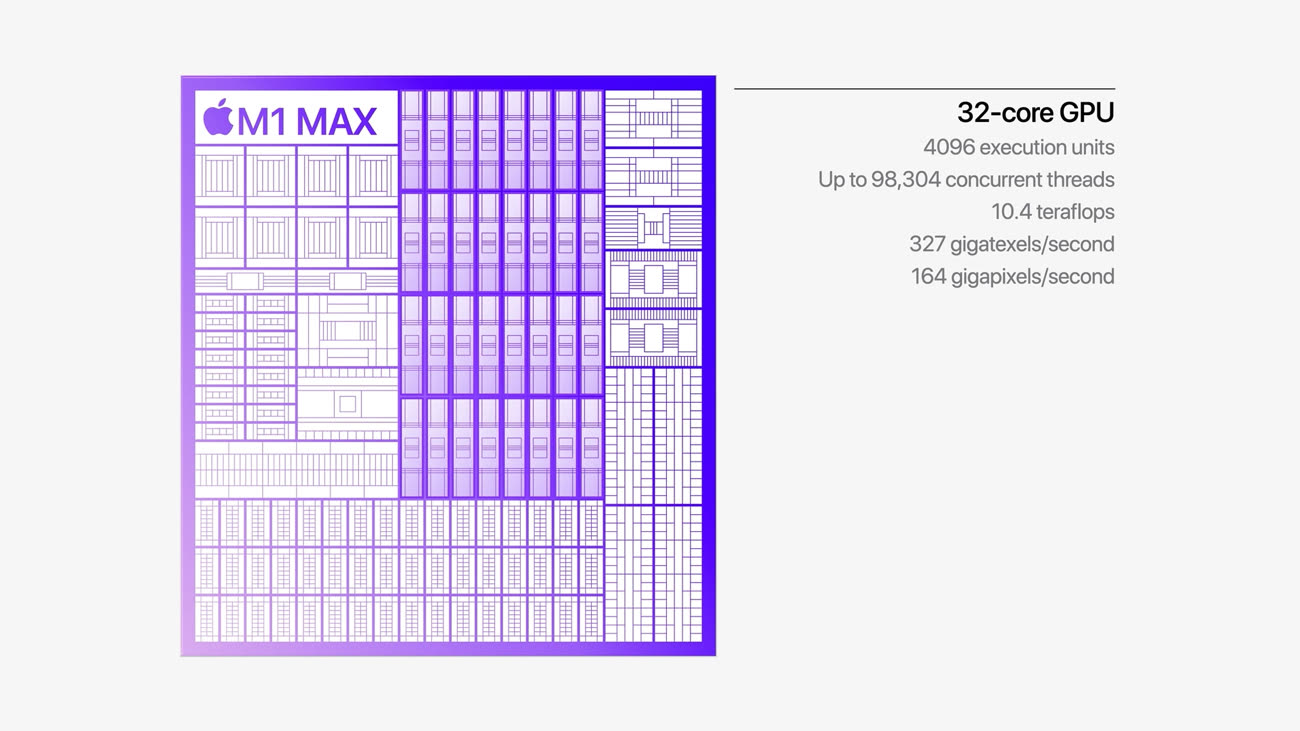

Mise à jour le 19/10/2021 10:11 : comme le notent plusieurs lecteurs, Apple a donné un meilleur indice encore des performances à attendre du GPU intégré à l’Apple M1 Max. Pendant la conférence, on a ainsi appris que la version avec 32 cœurs offrait 10,4 teraflops de performance.

Ces mesures théoriques permettent de comparer le GPU à ses concurrents et le bilan est alors moins positif que sur le graphique présenté plus haut. Sur le papier, la RTX 3080 portable de Nvidia peut monter jusqu’à 19 teraflops, près du double. Même le modèle en-dessous, la RTX 3070, affiche 16 teraflops d’après son constructeur.

Il faudra ainsi attendre les mesures concrètes pour savoir ce que la nouvelle puce d’Apple vaut réellement…