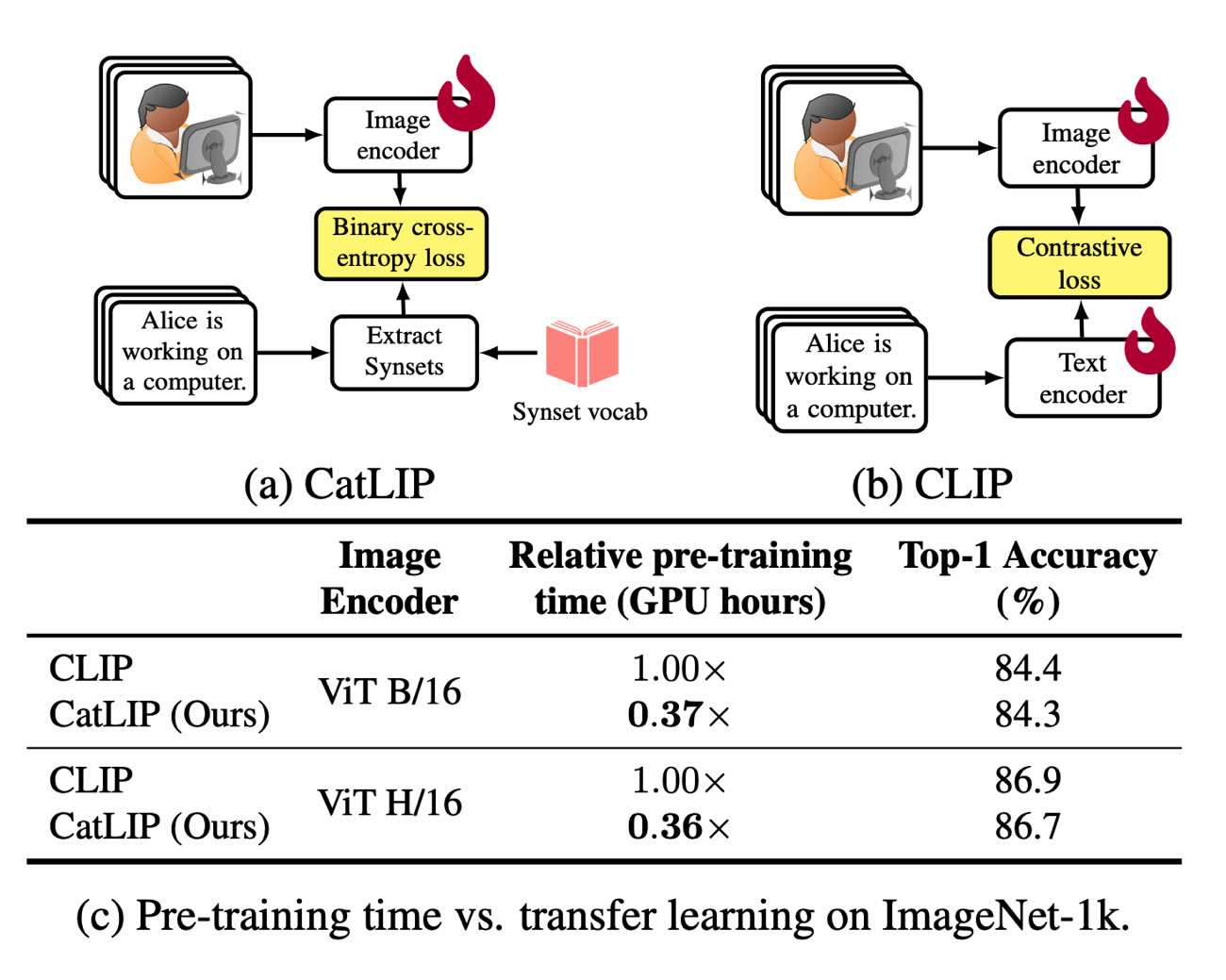

Apple continue de préparer le terrain pour une grosse vague d’IA, avec la publication de nouvelles recherches dans ce domaine. Cette fois, des chercheurs en la matière ont mis au point un modèle neuronal de classement d’images concurrent de CLIP d’OpenAI, un outil capable d’identifier ce que contient une photo en somme. CatLIP est annoncé comme étant nettement plus rapide : 2,7 fois plus que CLIP pour être précis, ce qui est intéressant car la vitesse d’exécution était justement un point faible du modèle d’OpenAI.

Grâce à ce gain, on pourrait envisager d’avoir la précision de CLIP à une vitesse suffisamment accrue pour offrir des résultats en temps réel ou pas loin. En comparaison, les outils qui reposent sur le modèle d’OpenAI ont besoin d’un temps d’analyse assez long en amont et de beaucoup de ressources pour y parvenir.

Queryable : le moteur de recherche intelligent qu'Apple devrait intégrer à Photos

Les résultats mis en avant par Apple suggèrent que la qualité de l’analyse est maintenue malgré la vitesse accrue des traitements. De là à penser que Photos pourrait intégrer CatLIP dans iOS 18 et macOS 15 ? On aura peut-être la réponse en juin…

Source :