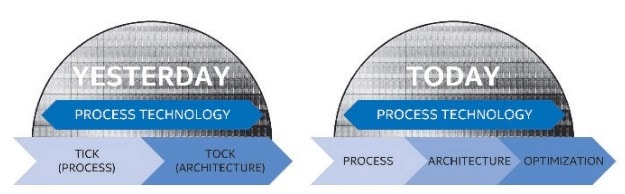

Intel retoque son Tick-Tock

En juillet dernier, Intel avait averti que son cycle « Tick-Tock » allait connaître pour la première fois une perturbation depuis sa mise en place en 2007. Pour rappel, un Tick, c'est un nouveau processus de gravure, tandis qu'un Tock, c'est une nouvelle microarchitecture.

La génération actuelle de processeurs, Skylake, est un Tock. Cette année, Intel aurait dû normalement proposer un Tick avec CannonLake, mais la gravure en 10 nm a pris du retard. Pour ne pas rester les mains vides, le fondeur va lancer au deuxième semestre Kaby Lake qui, étant toujours gravé en 14 nm, bouleverse son modèle établi.

Intel le confirme dans un rapport financier publié récemment : il abandonne son déroulement binaire Tick-Tock. À la place, il instaure un modèle à trois temps : Process, Architecture et Optimization. Kaby Lake sera ainsi une « Optimization ». CannonLake, qui est prévu pour l'année prochaine, sera un « Process » inaugurant la gravure en 10 nm.

Pourquoi ne pas conserver le Tick-Tock en espaçant ces deux stades de 18 mois au lieu de 12 ? « Pour conserver le lancement de produit annuel nécessaire à la bonne tenue [des] ventes », note Hardware.fr.

bah.

Intel sortira un nouveau processeur et il sera comme il sera. C'est les détails techniques et dates de sorties qui comptent. Tick, Tock, Tack, qu'est-ce que j'en ai à fiche ? on a jamais réussi à deviner la moindre date effective de vente ou le moindre ordinateur avec.

Process, Architecture, Optimization, Degradation, Disintegration, Whatever.

Oui et non.

Avant on pouvait expliquer l'évolution des performances par deux biais.

Le nouveau process et la nouvelle architecture.

D'ailleurs pour que ce soit plus simple il faudrait voir la nouvelle architecture puis le nouveau process de cette architecture mais bon.

Donc haswell nouvelle archi était en 22nm et Broadwell son évolution en 14nm.

Avec "l'optimisation" sur quelle notion ils vont ce concentrer pour qu'il y est une réelle différence? Consommation, performance, jeu d'instruction ? Bref il sera intéressant de voir le progrès par rapport à skylake et si elle se justifie.

"Avant" c'était jusqu'a l'epoque de la generation Westmere (32nm) sortie en 2010 et il faut preciser que les performances prises en compte concernent surtout l'optimisation de la consommation (extinction des composants non sollicités et distribution fine des charges en rapport du dégagement thermique) et cela date de l'architecture Core (donc 2006)!

En fait la derniere evolution substantielle du x86 a ete le passage a l'architecture Sandy bridge, qui a exposé aussi le grippage du terme uniquement marketing "tick-tock". Le passage a 22nm a posé de gros problèmes a Intel et c'est l'utilisation du FinFet qui a une dernière fois sauvé le sacro-saint principe du "die-shrink" (finesse de gravure) dans Ivy Bridge, alors que dans les faits il ne s'agissait d'une approche tres differente et qui mélangeait un changement dans la gravure en meme temps que de changement dans l'architecture.

De fait le principe directeur de l'evolution du x86, - la conjecture de Moore - a tapé contre le mur au moins des 2010!

Apres Ivy bridge, les desastres n'ont fait qu'empirer avec la berezina qu'est Broadwell. Il faut d'ailleurs rappeler que son prédécesseur, Haswell, a ete une belle ratée puisque ce n'est que la version "refresh" qui a ete stabilisé et a permis de maitriser les erreurs de conception et production qui ont posé tellement de problemes...

De fait il faut aujourd'hui compter au moins 3 ans par generation de x86 pour gagner un petit 5% de performances et compter surtout sur une optimisation de la consommation qui se base sur la capacité d'arreter le plus possible les composants internes de processeur!

Intel est depuis 2010 confronté au mur de la gravure et ne doit plus compter que sur le travail d'architecture et pilotage fin de l'alimentation pour apporter des optimisations ultimes a sa vielle architecture x86.

Bref Intel ne pouvait plus maintenir la farce commerciale du Tick-Tock sans sombrer dans le ridicule le plus absolu.

Tick, Tock, Tack

Aura-t-on un Core-i7 dans une montre connectée made by Intel ? Patience !

Donc Kaby Lake est une optimisation de Skylake ?

Vu le retard pris par skylake, j'avais lu ici ou là qu'intel avait bien eu le temps de l'optimiser.

Ou est juste un changement de nom en attendant le 10nm...?

Non, par optimisation, ils parlent d'amélioration des fonctionnalités sans changer l'architecture générale, par exemple plus de lignes PCIe, support du décodage hardware du H.265/10 bits en plus du 8 bits permis par le SkyLake, meilleures performances 3D des IGP (plus d'unités de calcul, optimisation du fonctionnement), plus de ports USB, support de mémoires plus performantes, optimisation de la consommation, et j'en passe.

@PierreBondurant

C'est plus compliqué que ça en fait.

Intel s'est embourbé avec Broadwell au point de devoir abandonner l'ecrasante majorité des processeurs de cette generation. Il y a eu un changement de strategie face a cette catastrophe qui a consisté a sortir dans l'urgence Skylake, mais en version "allegée".

De fait Kaby Lake sera le Skylake initialement prevu...

Intel apres les difficultés du passage de 32 a 22 nm a decidé de sauter directement sur le 14 nm en faisant l'impasse sur des finesses de gravure intermédiaires, espérant obtenir des performances permettant de continuer la course en tete. Mais non seulement le 14 nm n'a rien apporté d'autre que des problèmes colossaux de mise au point et de production (taux de déchets trop important) mais en plus les autres fondeurs ont rattrapé et dépassé Intel en qualité de production sur le 14nm ( mais sur l'architecture RISC d'ARM).

Mais tous les fondeurs sont arrivés au meme point avec le 14nm: ça n'apporte rien ni en puissance de calcul, ni en consommation, ni en dégagement thermique! Seul l'optimisation du finfet permet d'améliorer la consommation et cela ne va pas durer longtemps.

Le seul avantage du 14 nm c'est la diminution du cout de production puisque il faut presque 2 fois moins de materiaux que pour le 22nm. Mais cela est relativisé par le fait qu'il faut augmenter la qualité du silicium, et que les chaines de production a 14 nm ont un cout monstrueux (on parle de plus de 8 milliards...).

Bref seul un changement majeur d'architecture permet maintenant de gagner sur plusieurs front et les processeurs sont aujourd'hui des SoC qui regroupent sur un "die" de plus en plus de composants que l'on trouvait sur une carte mere. C'est aussi pour ça qu'Intel multiplie les coprocesseurs sur le "die": unité graphique (permettant de decharger les core sur certains calculs), unité de cryptage, unité de decodage H265, gestion d'alimentation, etc

@C1rc3@0rc

Encore une fois, tu racontes un bon nombre de conneries.

"Intel apres les difficultés du passage de 32 a 22 nm a decidé de sauter directement sur le 14 nm en faisant l'impasse sur des finesses de gravure intermediaires"

Pas du tout : Il n'y a pas de Node entre 22 et 14 nm. Donc il n'y a pas d'impasse.

"Mais tous les fondeurs sont arrivés au meme point avec le 14nm: ça n'apporte rien ni en puissance de calcul, ni en consommation, ni en degagement thermique"

Faux. Regarde nVidia et AMD, le 14 nm leur apporte un gain de 2.5 en terme d'efficacite energetiques.

D'autre part, quel interet d'investir des milliards si tu as 0 gains. Car si ca n'apporte rien en terme de calcul, de consommation ou de degagement thermique, a quoi ca sert ?

Le cout de production depend effectivement de la finesse de gravure, mais seulement en relation avec le rendemment.

Les chaines de production coutent effectivement tres cher, et ca coutera encore plus cher pour le 10, le 7 ou le 5 nm. La partie la plus importante etant l'optique. Et tous les fondeurs en sont dependants.

"Bref seul un changement majeur d'architecture permet maintenant de gagner sur plusieurs front et les processeurs sont aujourd'hui des SoC qui regroupent sur un "die" de plus en plus de composants que l'on trouvait sur une carte mere."

C'est le principe du Soc de remplacer la carte mere : System on Chip. C'est une evolution qui a lieu depuis des decennies, rien de nouveau ici. Intel ne vient pas de sortir un PC au format stick USB ?

Et quel changement d'architecture permettrai de gagner sur plusieurs fronts ?

Ce genre de declaration ne veut pas dire grand chose, c'est bien trop generique comme affirmation. Les nouvelles techno comme opto electronique, les memresistor permettent d'envisager des solutions radicales pour nos prochains PC, mais pour le moment il n'y a rien de concret.

Il faut aussi etre conscient que le plus gros probleme des CPU actuels est la lenteur de l'acces memoire.

duel de geeks !

Stardustxxx et C1rc3@0rc, aucun de vous deux ne dit des "conneries".

-

"Faux. Regarde nVidia et AMD, le 14 nm leur apporte un gain de 2.5 en terme d'efficacite energetiques."

ne serait-ce pas parce que les GPUs sont encore en 28nm ? ce qui évidemment fait un bon + important que ce qu'on voit en comparaison des cpus récents ?

Le point n'est pas que tout bond est inintéressant mais que sur les CPU le saut à 14nm ne donne pas autant de résultat qu'espéré par rapport à la génération d'avant.

@oomu

Merci pour ce recadrage.

Eh oui, les générations actuelles de puce graphiques sont gravées en 28 nm ou plus.

J'ajouterai que AMD et surtout NVidia ne produiront pas de GPU a 16nm avant la fin de l'annee et encore.

Initialement prévu pour 2015 le passage au 20nm a demontré que les benefices par rapport au cout etant trop faibles, et les constructeurs, surtout NVidia visent maintenant de 16 nm mais surtout le finfet de TSMC.

Et le 28 nm a encore du potentiel comme le prouve Nvidia avec son architecture Maxwell. Avec une finesse de gravure identique (28 nm), il a été possible d’augmenter les performances tout a assistant à un effondrement des besoins énergétiques.

Il faut aussi remarquer que Pascal c'est surtout une toute nouvelle architecture, donc on ne peut pas comparer cela a un simple "die-shrink" comme le faisait Intel avec les tick-tock d'avant Sandy Bridge.

@C1rc3@0rc

nVidia et AMD ne sont pas passe au 20 nm pour une raison tres simple : pas de places dispo chez les fondeurs.

«C'est le principe du Soc de remplacer la carte mere : System on Chip. C'est une evolution qui a lieu depuis des decennies, rien de nouveau ici.»

Ben si c'est nouveau pour Intel dont le principe directeur etait de concentrer les evolutions dans le processeur, en augmentant la complexité du Core et des ses fonctions: c'est quand meme la definition du CISC!

Depuis le 32nm Intel se met a faire comme dans les architectures RISC en multipliant les coprocesseurs. Cela permet de compenser la stagnation du core qui trop compliqué n'arrive ni a gagner en vitesse ni en consommation.

«D'autre part, quel interet d'investir des milliards si tu as 0 gains. Car si ca n'apporte rien en terme de calcul, de consommation ou de degagement thermique, a quoi ca sert ?»

Pour Intel le gain c'est d'avoir un argument commercial permettant de vendre a des prix absurdes des processeurs qui n'apportent aucune justification. Si Intel devait vendre pendant 5 ans le meme processeur le prix devrait baisser pour s'approcher du cout de production. Ce qui ne serait pas supportable pour Intel. L'autre element c'est la concurrence. Intel n'a pas de concurrent sur le x86 car il a detruit tout ce qui pouvait lui faire de la concurrence. Mais avec les OS multi architectures le monopole du x86 tombe en miettes.

La course a la finesse a toujours ete un argument commercial pour Intel face au concurrents, et le fait de s'etre fait battre par Samsung sur le 14nm est un coup de massue pour Intel!

Comme le cite l'article:

Pourquoi ne pas conserver le Tick-Tock en espaçant ces deux stades de 18 mois au lieu de 12 ? « Pour conserver le lancement de produit annuel nécessaire à la bonne tenue [des] ventes »

De plus comme je l'ecris, graver plus fin permet de produire moins cher donc d'augmenter les marges: si la gravure a 14nm a fait voler en eclat une importante partie de ce benefice il n'est pas nul pour autant. Et le passage a 40mm pour les wafer va l'augmenter!

@C1rc3@0rc

CISC n'a rien a voir avec un SoC. Tu agglomere plusieurs concept en un seul.

CISC : veut dire complex instruction set computing, en francais cela veut dire jeu d'instruction complexe. Rien a voir avec ce qui peut etre integres sur le chip.

Tout les processeurs Intel sont RISC depuis le Pentium Pro. Les instructions x86 sont transformes en micro-ops.

Intel ne c'est pas fait fait battre par samsung sur le 14 nm, il a ete le premier a sortir des processeurs avec cette finesse. Et surtout quand on regarde les caracteristiques precises, Intel a le meilleur process en terme de finesse, de compacite.

Et le 7nm comme le fait IBM ?

Intel doit bien avor quelques billes de prévues non?

Le 7nm d'IBM n'est plus basé sur le silicium pur comme les processeurs commercialisés jusqu'a maintenant. Le problème c'est le cout qui explose et rend difficilement commercialisable cette solution.

En fait il y a plusieurs alternatives en labo mais elles posent toutes des problèmes au niveau d'une production de masse et commerciale.

Pour l'instant la seule alternative serieuse c'est de travailler sur l'architecture car c'est la ou il y a des grosses ameliorations qui restent.

NVidia a demontré que le travail sur l'architecture permettait de quasi doubler l'efficacité énergétique en restant sur des gravures de 28nm.

On voit aussi du cote des ARM un doublement de performance avec une amelioration de l'efficacité énergétique.

Mais cela devient de plus en plus difficile et il faut de plus en plus de temps et de competences ( cf les difficultés de production par le passage precipité au 64bits)

Pour Intel le problème c'est l'architecture CISC du x86.

Elle est beaucoup trop compliquée et sa conception originelle (dans les annees 70) est ancrée sur la progression de la puissance grace a l'augmentation de la complication permise par la diminution de la gravure. Et la toutes les recettes et bidouilles ont ete sur-utilisées pour maintenir en vie cette antiquité.

Donc Intel va devoir abandonner le x86 et passer a autre chose, soit du RISC ou de l'EPIC...

L'autre voie d'amelioration c'est le logiciel.

La marge de progression est encore enorme, pour une raison toute simple: Intel a poussé avec le x86 a generaliser la programmation non optimisée en deplaçant l'optimisation dans le processeur. Un x86 c'est en fait plus une machine virtuelle qui decode des instruction x86, les rearrangent et les executent selon des recettes de cuisine compliquées.

La consequence c'est que les couches logicielles superieures sont aussi des marchines virtuelles...

On va donc revenir a des compilateurs "intelligents" et des langages permettant d'optimiser la compilation

Les différents OS ont déjà du mal à supporter Skylake qui apparement modifie beaucoup l'architecture, on peut bien attendre un peu.

Surtout que les processeurs Skylake sont déjà incroyablement puissants. J'arrive pas à dépasser les 15% de charge sur le mien avec une utilisation normale (Atom, terminal, Chrome, iTunes et Photoshop).

@iPoivre

"Les différents OS ont déjà du mal à supporter Skylake qui apparement modifie beaucoup l'architecture, on peut bien attendre un peu."

Ah bon!!! Et qu'est ce que les OS ont du mal a supporter ? C'est du x86, l'architecture n'a pas change.

Ok la micro architecture a change, mais c'est transparents pour les OSs.

"Surtout que les processeurs Skylake sont déjà incroyablement puissants. J'arrive pas à dépasser les 15% de charge sur le mien avec une utilisation normale (Atom, terminal, Chrome, iTunes et Photoshop)."

Utilisation normale... C'est quoi une utilisation normale ?

Suivant ton domaine professionel cela peut varier terriblement...

@Stardustxxx :

Bon je vais commencer à l'envers et répondre à ta deuxième question. J'ai mis la liste des logiciels que j'utilise dans mon utilisation normale, il suffit juste de lire...

Pour la première question, effectivement je n'ai pas réussi à installer un Debian ou un Ubuntu (en version stable, les deux sont sur le coeur 3.6 de Linux qui n'est pas compatible avec Skylake), MacOs n'est compatible avec Skylake que depuis fin janvier sur OSX 11.2, et Windows je suppose que c'est compatible (pas testé) mais je ne sais pas sûr qu'elle version.

Un peu de recherche avant d'agresser les gens ne fait de mal à personne ;)

@iPoivre

Ce n'etait pas mon intention de t'agresser ;)

J'ai bien compris que tu as decrit ton utilisation normale. Mais cela ne correspond pas a une utilisation "normale". "normale" ne veut pas dire grand chose en fait, suivant les applications que tu utilises, cette normalité change. Personnellement, je me retrouve regulierement avec tous les core a 100% avec un Skylake dans mon utilisation normale.

Pour la premiere question, la confusion vient du fait que l'on utilise architecture pour decrire plusieurs chose a la fois. Le probleme de Skylake sur linux viennent de la partie graphique du processeur, le cote CPU fonctionne tres bien. C'est une question de pilotes graphiques, l'architecture du CPU (x86, microarchitecture) n'a rien a voir avec ca. Il n'y a aucun probleme a signaler sous Windows pour les processeurs Skylake. Et pour OS X, ca a du poser problème pour les hackintosh. Ce que decris est le probleme des pilotes quand la plateforme change, et comme les cpu intel deviennent des SoC, un changement de CPU devient effectivement plus problematique en terme de support.

@Ginger bread

Tous les fondeurs sont capable de graver en 7nm dans leurs unites de recherche.

C'est une toute autre histoire d'avoir la meme precision au niveau commercial. avec un bon rendemment.

Le principal probleme pour augmenter la finesse de gravure est la partie optique pour les process utilises.

Tous les fondeurs achetent leur matos au meme endroit, ils sont tous limites par les performances optiques. Il n'y a pas de miracle.

Cette com. d'Intel est B2B. Intel ne parle pas aux utilisateurs mais à ses clients qui achètent des processeurs. Ces derniers ont bien besoin de ces calendriers pour ajuster leurs propres lignes de produits, car croyez-le ou non, ils ne sortent pas de nouveaux gadgets comme ça parce qu'il y a des fleurs dans le jardin.

J'avoue que j'apprécie beaucoup la direction prise ces dernières années chez Intel, avec une montée en puissance contenue mais beaucoup de travail sur l'efficacité énergétique, sur les entrées sorties très améliorées, sur les interfaces multi-protocoles. Bien, vraiment. Ils formalisent leur communication et officialisent ce process à trois étapes, dont cette très intéressante et importante étape d'optimisations.

Je compte sur le TB3+USB321+DP dans le chipset, sur de l'Ethernet 10G standardisé, etc.

On rentre dans les espoirs impossibles, mais j'aimerais voir apparaitre dans les gammes d'Intel le même type d'étagement qu'avec les gros Xeon : soit beaucoup de coeurs un peu moins rapides, soit moins de coeurs mais tirés au max. J'aimerais bien voir un i4 entre i3 et i5, deux coeurs, mais deux coeurs très gonflés.

C est pas HP qui a inventé le memresistor tout en evitant de le commercialiser ?