Intel atteint 6,2 GHz avec une édition spéciale un peu vaine d'un Core i9 🆕

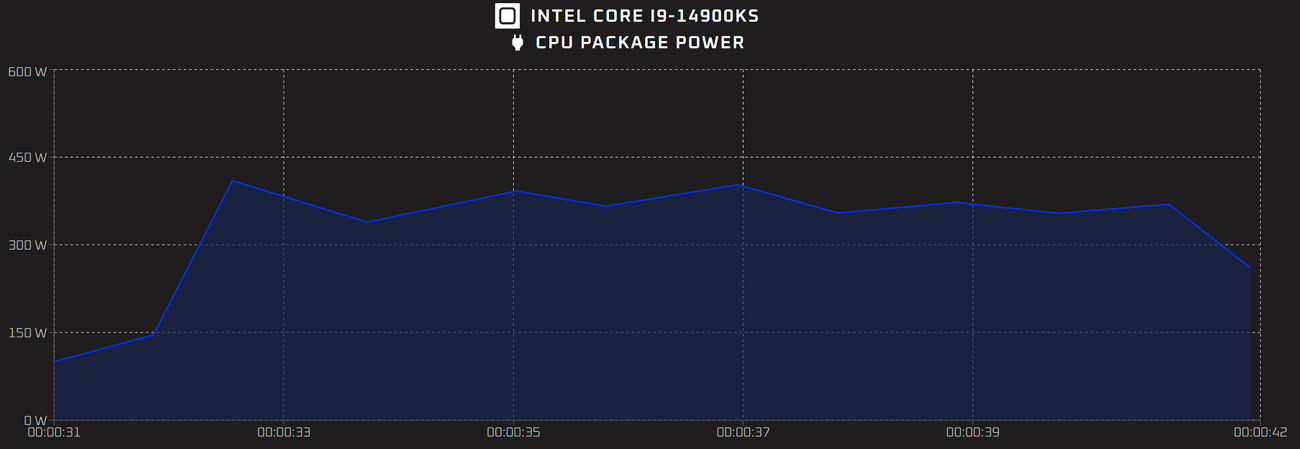

Mise à jour du 15 mars 2024 : Comme prévu, Intel a annoncé son Core i9 14900KS. Cette édition spéciale propose donc une boîte un peu exclusive et peut atteindre une fréquence de 6,2 GHz si vous n'avez pas peur de sa consommation électrique, qui peut atteindre 325 W en pratique (et sans overclocking). Il s'agit donc du processeur Intel le plus rapide du moment, même s'il reste battu dans les jeux par le Ryzen 9 7950X3D selon les premiers retours. Terminons par le prix : 700 $ aux États-Unis (sans les taxes) et 860 € en France. Soit 140 € de plus que le Core i9 14900K, pour 200 MHz (ou 3 % de gains en fréquence).

Depuis de nombreuses années, Intel propose de façon régulière des « éditions spéciales » de ses processeurs, pour les utilisateurs qui veulent battre des records. Ils s'appelaient « EE » du temps des Pentium 4, ils ont un « S » à la fin du nom pour les modèles modernes. Et le Core i9 14900KS devrait — comme ses prédécesseurs — battre des records de performances… mais aussi de consommation.

Si à une époque Intel déclinait des versions professionnelles dans le monde grand public, le Core i9 14900KS devrait bien être une puce classique, mais avec une fréquence plus élevée. Il intègre donc huit cœurs performants et seize cœurs basse consommation (soit trente-deux threads exécutables) selon les rumeurs (probablement avérées). Le processeur est a priori gravé en Intel 7 (le nom marketing du 10 nm) et reprend donc la même architecture que les Core de 12e et 13e génération. Cette édition spéciale devrait sortir du lot pour une raison : sur un seul cœur, il pourrait atteindre 6,2 GHz, un record dans les puces x86. C'est 200 MHz de plus que le précédent modèle « S » (le Core i9 13900KS) ou le Core i9 14900K.

Comme souvent chez Intel, la seule marge de manœuvre possible est visiblement ici la consommation. Le TDP de base devrait être de 150 W (contre 125 W sur les versions classiques) et la valeur PL2 (dite Turbo) sera probablement la même que pour les modèles précédents, c'est-à-dire 253 W. Mais, car il y en a un, les cartes mères haut de gamme n'appliquent généralement pas ces limites1. Les premiers tests, relayés par Igor's Lab, montrent d'ailleurs une consommation moyenne en charge de 330 W et une consommation maximale de 410 W.

En résumé, le Core i9 14900KS est un processeur pensé pour battre des records, avec une consommation hors norme. Il n'est pas réellement adapté à un usage quotidien car les rares systèmes de refroidissement capables d'encaisser une telle débauche de watts sont onéreux et bruyants. Dans un sens, ce genre de puces montre d'ailleurs que la voie actuellement choisie par Intel est un peu vaine, même si certains aiment s'amuser avec des CPU qui sont essentiellement des démonstrations technologiques qui existent uniquement pour rassurer les clients d'Intel : ce sont bien les CPU les plus rapides.

-

Pour une raison bassement pragmatique : avec une limite à 253 W, les contraintes thermiques ne devraient pas lui permettre d'être plus rapide que ces prédécesseurs. ↩︎

@valcapri

Avez-vous monitoré votre RAM pour savoir si elle était bien en Quad Channel et si elle tournait bien à la fréquence que vous annoncez ? Il y a énormément de retours qui expliquent qu’en dual Channel les fréquences peuvent être atteintes mais pas en Quad Channel.

Et en matière de jeux vidéo, les CPU Intel sont plus performants, c’est factuel, je ne parle pas du framerate moyen qui est plus ou moins proche mais du 1% low et du 0,1% low, qui sont des valeurs importantes et qui permettent de savoir si le jeu est réellement fluide.

Et dans ce domaine l’écart est assez grand entre les meilleurs CPU Intel et les meilleurs CPU AMD, même les X 3D et leur apport de cache supplémentaire.

Ça vient notamment des fréquences plus élevées chez Intel, ça c’est une certitude, mais également du fait que les jeux semblent mieux optimisés sur des CPU Intel et ça je n’en connais pas la raison, ça tient peut être à une architecture différente et plus complexe à explorer je ne sais pas.

je prends bonne note de cet excellent résumé. Grand merci.

@Moebius13

Vous et moi, nous avons des points de vue opposés sur bon nombre de sujets. Et je n’ai jamais hésité à manifester mon désaccord avec véhémence.

Aussi est-ce de mon devoir de vous signifier que je trouve votre contribution sur ce fil admirable, et que je considère qu’elle forme une référence sur ce sujet.

Merci.

@occam

Et bien écoutez je vous remercie très sincèrement pour votre message.

Je sais que je peux être parfois un peu trop « passionné » sur certains sujets, mais ce que j’aime c’est le débat et je respecte chacune des personnes en commentaires même si certaines peuvent avoir l’impression que ça n’est pas le cas.

Le simple fait que vous ayez pris le temps de m’écrire ce petit commentaire pour me dire ça, prouve à quel point vous méritez tout mon respect et je ferais en sorte de mettre de l’eau dans mon vin pour paraître moins agressif sur certains posts (je m’en rends compte moi même).

Merci encore, je vous assure que cela fait chaud au cœur, surtout venant d’une personne qui justement n’est pas souvent en accord avec moi.

@Moebius13

😇

@occam

chapeau bas à tous les 2 (@occam et @Moebius13)

@Moebius13

Et toute cette débauche technologique et énergétique pour…. Jouer à Panpan t’es mort?

N’est-ce pas cela le plus vain?

Quand je vois les ressources le temps et l’énergie gaspillée par la génération Z pour jouer…. Ou regarder des vidéos de 20 » sur des réseaux…. J’avoue que je préfère être un vieux con qui a une vie sociale dans le monde réel et qui occupe son temps à rendre le monde meilleur…,

@gillesb14

Quelle caricature ridicule….

Premièrement je déteste les jeux de guerre et ensuite mon genre de prédilection ce sont les RPG, dont l’un des représentants en 2023 et qui est déjà culte est Baldur’s Gate III.

Un jeu particulièrement stimulant intellectuellement et d’une très grande richesse (encore faut-il se donner la peine de connaître son sujet).

Et voyez vous, c’est un jeu très gourmand, notamment dans son acte III d’un point de vue CPU si l’on décide de pousser les visuels au maximum (et Dieu qu’il est beau quand on peut se le permettre).

En parallèle je suis en train de parcourir Cyberpunk 2077 qui est aussi un très grand jeu, absolument magnifique et à l’écriture soignée, et chaque soir avec ma femme nous bloquons 2h pendant lesquelles elle apprécie me voir jouer à Alan Wake 2, un jeu qui se rapproche énormément de Twin Peaks (c’est un véritable hommage), qui demande de faire tourner ses neurones, et qui est très certainement un des plus beaux jeux actuellement (notamment en raison de son utilisation du Pathtracing), mais qui nécessite par conséquent une grosse configuration.

En parallèle je fais du tennis, de la randonnée, je suis un grand lecteur, mon Kindle est de tous les voyages, je roule en Clio hybride pour polluer le moins possible, j’achète le minimum de vêtements, je recycle systématiquement tout ce que je peux, et j’apprends à mes enfants à en faire de même, et si je les laisse jouer à la Switch ou regarder la TV, c’est à la condition qu’ils sortent aussi s’aérer pour faire du vélo et sociabiliser.

Par conséquent je ne vous permet pas de juger de mon mode de vie et encore moins de mes choix, et dites vous bien que pour pouvoir jouer sur une telle configuration il a fallu que je mette de côté pendant près de 4 ans et que c’est un loisir qui me permet de décompresser d’un emploi particulièrement stressant qui m’occupe parfois même les week-ends !

@gillesb14

La génération Z joue très aux jeux dont parle Moebius13. Il n'y a que les fils·illes à "vieux cons" pété·e·s de thunes (je ne vous cible pas particulièrement ici et je reprends juste votre expression) qui peuvent se le permettre.

Et il est assez facile de railler toute une génération d'un coup (et c'est tout aussi odieux que le racisme puisque de même que l'on ne peut pas changer de couleur, on peut encore moins changer de date de naissance) quand l'école les assomme de devoirs et que l'énergie qu'il leur reste ne laisse place qu'à des loisirs "drogue" que sont les réseaux sociaux et leurs algorithmes. Et quand le travail des deux parents les laisse souvent sans soutien là où les loisirs extrascolaires sont de plus en plus chers et inhibés par la pression scolaire. Les jeunes sont peut-être responsables mais je pense que la société moderne ne fait rien dans le bon sens vis-à-vis d'eux.

@gillesb14

"N’est-ce pas cela le plus vain?

Quand je vois les ressources le temps et l’énergie gaspillée"

en principe, si l'on en croit l'évolution de la précarité énergétique annoncée par certains dans le contexte du changement climatique, le "problème" devrait vite être résolu ...

mais cela pose surtout la question de l'occupation que l'on a en tant que société moderne : au temps des serfs, on travaillait pour ne se nourrir, au moment de la révolution industrielle, même combat (cf germinal), aujourd'hui, l'industrialisation (les machines ) et la globalisation (on fait travailler les autres) nous ont acheté du temps libre à profusion, que l'on utilise pour regarder netflix, jouer à des jeux vidéos, voyager dans les coins soigneusement préparés / adaptés pour les touristes ...

est-ce bien ? est-ce mal ? chacun répondra comme il l'entend ...

néanmoins, ce qui nous "achète" ce temps libre, c'est la richesse de nos sociétés occidentales ... reste à espérer que nos sociétés resteront "riches" encore longtemps, et qu'aucun grain de sable ne viendra perturber ce doux rêve 🤔

@Moebius13

"Cependant le problème, en tout cas pour les jeux, vient aussi des développeurs puisque 90% des jeux qui sortent fonctionnent au maximum sur 4 cœurs en parallèle et profitent de fréquences très élevées en single core."

Ce n’est pas tout à fait exact. Les Ryzen X3D montrent au contraire qu’un grand cache et une fréquence moindre sont très profitables à de nombreux jeux, pour ne pas dire une majorité, et souvent dont plus profitables que fréquence élevée et plus petit cache, pour ne pas dire une majorité.

D’où sors-tu ce 90% ?

@fte

D’une interview de développeurs concernant les 90%.

Et le 3D cache des Ryzen ne leur permet que de se mettre au niveau des CPU Intel qui n’ont pas de 3D cache.

Si tu regardes un comparatif de 20 jeux (y’en a plein sur YouTube), tu verras que globalement l’avantage va indéniablement aux CPU Intel, que ce soit sur la moyenne des FPS, mais surtout le 1% et le 0,1% low.

L’écart n’est pas gigantesque je te l’accorde et sur certains jeux (minoritaires) AMD est légèrement devant (seulement en fps moyens), mais au global le 3D cache ne permet que d’égaler la concurrence pas de la dépasse.

Si demain Intel se met à faire pareil, l’écart sera largement en leur faveur.

Cela s’explique notamment parce que les jeux sont mieux optimisés Intel, ça c’est une certitude, mais également justement parce que ce qui prime ça n’est pas le nombre de cœurs (malheureusement les développeurs de jeux sont toujours feignants pour pleinement exploiter le calcul parallèle sur un grand nombre de cœurs), mais la fréquence sur 4 voire 6 cœurs maximum, et un 14900k tape du 6Ghz ce qui l’avantage par rapport aux Ryzen.

J’étais moi même passé sur Ryzen avec un 5800X puis un 5950X parce que quand ils sont sortis ils étaient plus performants que ce que faisait Intel, mais il a suffit à ces derniers de moins de 6 mois pour reprendre la main et depuis ils ne se sont plus laissés déborder.

De fait je suis repasser sous Intel avec un 14900k justement mais c’est aussi parce que mon 5950X était CPU limited par rapport à ma RTX 4090 sur un jeu comme Cyberpunk 2077 notamment et que je cédais plus de 20 fps avec le même GPU par rapport à une personne sous Intel 13900k, ce qui est assez énorme et ça fait chier d’avoir un CPU monstrueux qui n’est pas exploité correctement (le monitoring montrait qu’il descendait souvent à 92-93% d’utilisation, quand sous Intel il est constamment à 99%), et le optimisations Intel font le reste.

(Erreur)

article vain qui essaie de décrédibiliser une prouesse technologique (à savoir faire une cpu qui dépasse les 6GHz et donc fait le double de ceux d'apple en SC) en comparant ce genre de processeur avec ceux d'apple qui sont aux antipodes de AMD/intel en terme de conception à l'heure actuelle

mais c'est pas grave, heureusement qu'apple peut optimiser le code pour 3-4 processeurs et quelques machines versus des config à l'infini hein ?

@Pierre Dandumont

Vous pouvez préciser le "même niveau de performance" ? C'est des résultats sur les logiciels de tests ?

Les M3Max sont de véritables brutes de puissance. Les benchs en donnent une bonne impression générale, mais à l'usage c'est largement vérifié, et je ne parle pas de jeux vidéo

Après le souci c'est que chez Apple, tu auras jamais mieux que le M3Max, ou bientôt le M3Ultra, alors que sur PC tu peux encore monter plus haut en perfs CPU multi (pas mono) avec les Xeons ou les ThreadRipper, et je parle même pas du GPU où Apple offre l'équivalent du moyen de gamme nVidia actuel ... soit de quoi faire mumuse (ce qui souvent en usage pro suffit largement, sauf à vouloir faire du taf essentiellement basé sur la puissance GPU, auquel cas tu bosses pas sur Mac)

@Dimemas

Ils sont juste pas bon lol

300W en gros, à savoir la conso totale d'un M3max à pleine charge...

Outre l'exploit technique (et non, un watercooling ne fait pas beaucoup de bruit contrairement à ce qu'en dit le journaliste), ce qu'il faut voir c'est la différence de temps de calcul. Un M3Max c'est 30% moins rapide que les meilleurs AMD, pour cet Intel je sais pas... Mais si sur un temps de calcul un M3Max met 30% plus temps à pleine charge, alors on peut retrancher 30% de la conso... Je pense que le M3Max reste devant, mais in fine pas tant que cela (un couple i7/4060 c'est 360W), ou tout du moins bien moins que lors de la sortie du M1 en comparaison de ce qu'il y avait sur le marché.

Bien évidemment, il ne faut pas oublier que c'est quand même un bon repaire de Apple fanboy. Même si Apple domine effectivement au niveau des benchmarks synthétique en ce qui concerne l'efficacité et le single core; dans la pratique c'est beaucoup plus nuancé.

Puisqu'au final lorsqu'on prend la performance en situations réelle, Apple ne fait pas si mieux que ça que les autres, surtout qu'il faut en général volontairement limiter la performance des compétiteurs pour avoir quelque chose de comparable.

C'est d'autant plus vrai aujourd'hui avec les Macs sous doté en RAM vendu à prix d'or, qui en théorie font mieux mais qui en fait ne peuvent même pas finir certain benchmarks faute de suffisamment de RAM.

En fait pour quiconque suis un minimum, vu les résultats préliminaires de la transition architecturale d'Intel, je dirais que ça ne sent pas bon pour la concurrence, étant donné que Intel "jouait" avec quelques désavantages architecture/finesse de gravure jusqu'à présent...

@SeeC,

« Bien évidemment, il ne faut pas oublier que c'est quand même un bon repaire de Apple fanboy. »

Apple et Linux fanboys il me semble !

« C'est d'autant plus vrai aujourd'hui avec les Macs sous doté en RAM vendu à prix d'or, qui en théorie font mieux mais qui en fait ne peuvent même pas finir certain benchmarks faute de suffisamment de RAM. »

Vous résistez visiblement aux messages mercatiques d'Apple pour qui 8 Go de mémoire unifiée, c'est finalement pas si mal que ça !

😁

« En fait pour quiconque suis un minimum, vu les résultats préliminaires de la transition architecturale d'Intel, je dirais que ça ne sent pas bon pour la concurrence, étant donné que Intel "jouait" avec quelques désavantages architecture/finesse de gravure jusqu'à présent... »

Qui vivra verra, si Poutine nous en laisse le temps évidemment !

🥳

@debione,

J'ai au pif comparé un Apple Silicon M3 Max et un Intel i9-14900K

https://nanoreview.net/en/cpu-compare/intel-core-i9-14900k-vs-apple-m3-max

Ben c'est pas en faveur du processeur Intel il me semble !

😎

@Scooby-Doo |

Dans le sens énergétique? Oui assurément... Dans le sens de la puissance? Non, vu que même un proc de 13ième génération fait mieux...

Et c'est encore plus flagrant sous cinebench, ou on retrouve le M3Max au-delà de la 25ième position avec un score 70% inférieur aux meilleurs AMD/Intel

https://dropandrender.com/fr/cinebench-benchmarks/

@debione,

À vous lire, j'ai comme la légère impression que nous avons les mêmes usages !

Power user inside…

😁

Maintenant, les logiciels de rendus, les rendus par IA, etc., sont de plus en plus optimisés pour exploiter le maximum de cœurs.

Donc le nombre et la fréquence peuvent effectivement jouer !

👍

@debione,

Oui je comparais les efficacités energétiques des deux processeurs car c'était le cœur de nos échanges à un moment !

Désolé.

😉

#balancetonproc

Les AiO peinent vraiment avec ce genre de consommation, en fait (i.e. j'en ai utilisé sur des KS). Plus le fait qu'un M3 Max ne consomme pas 300 W (même avec le GPU activé), c'est plutôt de l'ordre de 100 W pour le Mac complet. Et accessoirement, les performances en single core sont équivalentes à un 13900K.

Mais de fait, sur des tests qui sont bien multi threadés, c'est plus lent (y a moins de coeurs).

@Pierre Dandumont,

C'est moi où j'ai trouvé que le GPU du M3 Max est 3,5 fois moins performants que la NVIDIA 4090 !

Donc quand les logiciels tirent un maximum parti du GPU, ben cela peut faire la différence.

En IA, c'est juste incroyablement lent si on n'a pas de puissance de calcul brut.

😢

Et encore, arriver à 25% d'une 4090 est une formidable performance, car ces deux GPU sont incomparables : un bout de puce sur un SOC d'un coté, une monstrueuse carte PCI de l'autre

Ceci dit, je ne suis pas sur de ton 3,5, cela voudrait dire que sur un rendu 3D qui prends 1h sur un M3Max, il prendrait 17 min sur une 4090. Des tests comparatifs que j'ai pu voir, on serait plutôt sur du x5 à x6 pour la 4090

@Pierre Dandumont :

Ah oui c'est le M2 Ultra du Macstudio qui consomme 295W pas le M3Max:

https://support.apple.com/fr-ch/102027

Et le MacPro 330.

My Bad, par contre si Apple veut se rapprocher de la puissance Intel/Nvidia/Amd on se doute bien que la consommation va très vite augmenter. Certes pas je pense au point de les rattraper sur ce segment, mais au point de ne pas avoir ce gap en terme d'autonomie qui fait que le Mac portable est très intéressant sur ce point. Mais pour les modèle de bureau (ou ceux qui sont en "trans-portable") 100W de plus ou de moins est bien moins important qu'un gros gain de puissance (ne serait-ce qu'occasionnellement).

A voir, avec leur M3, j'ai du mal a savoir si Apple n'arrive a gagner en puissance que par la finesse de gravure et qu'ils sont un peu dans une impasse pour faire des améliorations, ou alors un savant mélange de production/stock restant a écouler avec très légère amélioration pour chaque itération.

Parce que si en 2020 les Silicon on foutu une sacrée baffe au X86, ce qui a été spectaculaire sur les 4 dernières années, c'est l'évolution du X86, pas des Silicon.

Comme quoi la conccurence...^^

Pas trop tôt !

Vivement le 7ghz!

Merci Moebius pour ta contribution

Cela fait plaisir de voir que l on peut parler des pc sur Mac gen et argumenté en plus

Le fait est que la vieille architecture est toujours plus puissante mais que la jeune architecture progresse vite et avec un ARM en pleine forme

Le sweet spot ne va pas trop tarder

"Pourquoi faire ? 🤷🏻♂️🤣🤣"

Il intègre donc huit cœurs performants et seize cœurs basse consommation (soit trente-deux threads exécutables)

Soit : 8 + 16 = 32

😳

@marc_os

Les coeurs performants supportent l'hyperthread, et donc chaque coeur est capacble d'exécuter 2 threads en même temps (pas tout à fait vrai en terme de performance, mais en terme de parallélisme c'est bien exact).

Donc 8 coeurs performants = 16 threads, + les 16 coeurs basse consommation qui, eux, n'ont pas d'hyperhtreading, donc 16 + 16 = 32.

@ byte_order

> Les coeurs performants supportent l'hyperthread, et donc chaque coeur est capacble d'exécuter 2 threads en même temps

Pourquoi deux et pas quatre ?

Sans connaître les specs du machin, c'est de la devinette.

Quitte à parler aussi de threads, l'article aurait dû préciser ce point.

Edit : Il faut chercher dans la doc (générale) de Intel sur l'hyper-threading pour lire :

the CPU exposes two execution contexts per physical core

Rq: L'hyper-threading n'a pas que des avantages. D'ailleurs il n'est pas implémenté sur tous les Core i7 semble-t-il...

De plus : In 2018 the OpenBSD operating system has disabled hyper-threading "in order to avoid data potentially leaking from applications to other software" caused by the Foreshadow/L1TF vulnerabilities.

Chez Apple, pas de pis-aller de ce genre dans ses M1 &co, ils misent plutôt sur des cœurs efficaces.

ne pas confondre les threads et les coeurs !

En résumé, le Core i9 14900KS est un processeur pensé pour battre des records, avec une consommation hors norme. Il n'est pas réellement adapté à un usage quotidien

Il sert donc à quoi ce truc ?

Quel est l'objectif d'Intel ? 😳

montrer qu'il a la plus grosse.

vous savez, on parle ici des tours PC, en general ces bécanes sont soit celles achetées pour le prix tres bas, soit pour la possibilité de mettre la puissance et le refroidissement qu'on veut. C'est donc là qu'on trouvera le public le plus apte à mettre des refroidissement monstrueux sur des processeurs du meme genre.

ca existait sur mac encore du temps du mac pro 2010, évidement moins pour celui de 2019 sans meme parler de 2023 (ou de 2013 ^^)

Nous connaissons tous deux un certain dentiste qui en a fait son fond de commerce.

@raoolito

"Nous connaissons tous deux un certain dentiste qui en a fait son fond de commerce."

😂

J’adore !

@David Finder

je n'ai nomme personne!

@raoolito

Ah non, je sais bien.

Mais les plus « anciens » savent qui est ce dentiste 😉

L'objectif d'Intel est de pouvoir vendre ensuite dans chaque foyer un SMR/PMR pour alimenter son i9 ... :P

860 euros 410Watts en pic, est-ce intéressant ?

Je ne sais pas.

Ca coûte combien un chauffage d'appoint de 400Watts chez brico dépôt ?

Le précipice approche et Intel continue de foncer droit devant.

🙃

Et encore une fois il faut répondre à votre mise à jour du 15 mars que NON le 7950X3D ne surpasse pas le 14900K ou 14900KS dans les jeux.

Je n’ai aucune action chez Intel, la preuve j’ai tourné sous 5800X puis sur 5950X et j’ai changé il y a une semaine pour un passage sous Intel et 14900K justement.

Si vous regardez les benchmarks, sur une vingtaine de jeux récents testés, le 7950X3D ne surpasse le 14900K que dans moins de 30% de ces derniers et un des jeux qui revient très souvent bizarrement c’est Tomb Raider en 1080p et sans explication le 7950X3D met plus de 25 fps dans la vue du 14900k, c’est le seul ou unique cas.

Dans les autres quand le 7950X3D dépasse le 14900k ça se joue à moins de 4-5 fps grand max et dans 70% des cas c’est le 14900k qui est en tête.

D’ailleurs sur une moyenne globale, pour les jeux le 7800X3D est plus efficace que le 7950X3D.

Au passage, vous négligez un élément important en jeux, le framerate moyen c’est une chose, mais la sensation de fluidité et de stabilité est étroitement liée au 1% et 0,1% low du framerate et sur ces points précis, les CPU Intel dominent largement les derniers CPU AMD (croyez bien qu’avant d’investir 1400€ pour changer de config j’ai tout passé au peigne fin).

Alors est-ce que ta tient à l’architecture Intel ou est-ce que ça tient aux jeux qui sont mieux optimisés pour les CPU Intel je n’ai guère la réponse mais c’est un fait incontestable.

Et en passant, en applicatif y’a pas photo, le 14900k est en tête que ce soit vis à vis du 7950X3D ou même du 7950X qui lui est normalement plus taillé pour l’applicatif justement.

Alors oui ça se fait au détriment d’une consommation bien plus importante chez Intel (sachant que d’après Anandtech à raison de 4h par jour sur 365 jours et à leur utilisation maximale respective, ça représente une différence de 33$ à l’année sur la facture d’électricité, donc pour moi c’est même pas un argument).

L’argument serait plutôt du côté de la dissipation thermique et de ce point de vue je reconnais qu’il faut du costaud pour tenir un 14900k, j’ai un AIO en 360mm et sur Cinebench R23 ventilos à fond ça n’empêche pas les cœurs performances de taper les 100° (mais bon la limite thermique a été repoussée à 115º donc c’est safe), mais ça reste un bench, en jeu ça ne part pas en mode soufflerie et mon pote qui vit à Mayotte et qui a lui aussi un 14900k dans son PC confirme que ça va malgré la chaleur ambiante.

Autre avantage que vous pouvez concéder à AMD c’est que la plate-forme M5 devrait accueillir la prochaine génération de CPU et qu’elle est donc plus durable alors que côté Intel il est à peu près certain que pour la 15th génération il va falloir abandonner le LGA 1700 et passer sur de nouvelles cartes mères (ce qui est bien trop souvent chez Intel…).

Donc en conclusion, le 14900 KS c’est de la connerie c’est juste le tri des meilleurs 14900K, ça n’a aucun intérêt particulier par rapport à ce dernier si ce n’est aimer payer beaucoup plus cher pour la même chose, mais ça reste à l’heure actuelle le meilleur CPU sur le marché que ce soit en jeux ou en applicatif dans l’immense majorité des cas.

Bon, comme Intel et l’autre quoi…

Alors oui le Ryzen 9 7950X3D est meilleur pour les jeux mais en multi taches le i9 est loin devant. Par contre le i9 consomme et chauffe beaucoup. Le miens je suis obligé de faire de l’undervolting pour réduire sa conso et sa chaleur

Pages