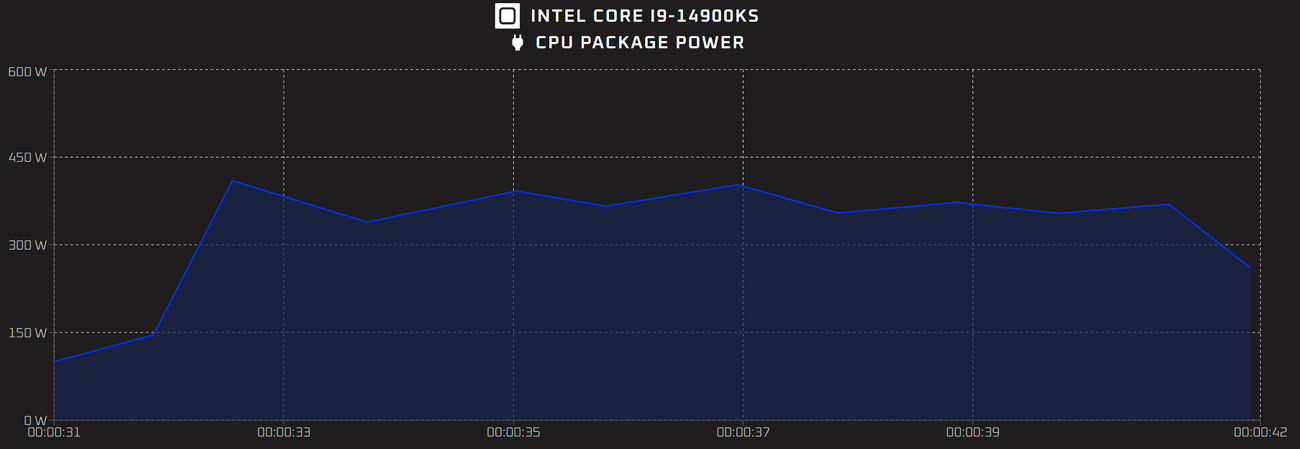

Mise à jour du 15 mars 2024 : Comme prévu, Intel a annoncé son Core i9 14900KS. Cette édition spéciale propose donc une boîte un peu exclusive et peut atteindre une fréquence de 6,2 GHz si vous n'avez pas peur de sa consommation électrique, qui peut atteindre 325 W en pratique (et sans overclocking). Il s'agit donc du processeur Intel le plus rapide du moment, même s'il reste battu dans les jeux par le Ryzen 9 7950X3D selon les premiers retours. Terminons par le prix : 700 $ aux États-Unis (sans les taxes) et 860 € en France. Soit 140 € de plus que le Core i9 14900K, pour 200 MHz (ou 3 % de gains en fréquence).

Depuis de nombreuses années, Intel propose de façon régulière des « éditions spéciales » de ses processeurs, pour les utilisateurs qui veulent battre des records. Ils s'appelaient « EE » du temps des Pentium 4, ils ont un « S » à la fin du nom pour les modèles modernes. Et le Core i9 14900KS devrait — comme ses prédécesseurs — battre des records de performances… mais aussi de consommation.

Si à une époque Intel déclinait des versions professionnelles dans le monde grand public, le Core i9 14900KS devrait bien être une puce classique, mais avec une fréquence plus élevée. Il intègre donc huit cœurs performants et seize cœurs basse consommation (soit trente-deux threads exécutables) selon les rumeurs (probablement avérées). Le processeur est a priori gravé en Intel 7 (le nom marketing du 10 nm) et reprend donc la même architecture que les Core de 12e et 13e génération. Cette édition spéciale devrait sortir du lot pour une raison : sur un seul cœur, il pourrait atteindre 6,2 GHz, un record dans les puces x86. C'est 200 MHz de plus que le précédent modèle « S » (le Core i9 13900KS) ou le Core i9 14900K.

Comme souvent chez Intel, la seule marge de manœuvre possible est visiblement ici la consommation. Le TDP de base devrait être de 150 W (contre 125 W sur les versions classiques) et la valeur PL2 (dite Turbo) sera probablement la même que pour les modèles précédents, c'est-à-dire 253 W. Mais, car il y en a un, les cartes mères haut de gamme n'appliquent généralement pas ces limites1. Les premiers tests, relayés par Igor's Lab, montrent d'ailleurs une consommation moyenne en charge de 330 W et une consommation maximale de 410 W.

En résumé, le Core i9 14900KS est un processeur pensé pour battre des records, avec une consommation hors norme. Il n'est pas réellement adapté à un usage quotidien car les rares systèmes de refroidissement capables d'encaisser une telle débauche de watts sont onéreux et bruyants. Dans un sens, ce genre de puces montre d'ailleurs que la voie actuellement choisie par Intel est un peu vaine, même si certains aiment s'amuser avec des CPU qui sont essentiellement des démonstrations technologiques qui existent uniquement pour rassurer les clients d'Intel : ce sont bien les CPU les plus rapides.

-

Pour une raison bassement pragmatique : avec une limite à 253 W, les contraintes thermiques ne devraient pas lui permettre d'être plus rapide que ces prédécesseurs. ↩︎