Quelques jours après l'annonce de sa nouvelle architecture Turing et de GPU dédiés aux professionnels, Nvidia a profité de la gamescom pour présenter ses cartes graphiques de nouvelle génération visant les joueurs.

Les GeForce RTX 2070, RTX 2080, RTX 2080 Ti vont prendre la relève des GeForce GTX 1080 et dérivées qui auront dominé le marché pendant plus de deux ans. Les RTX exploitent donc l'architecture Turing, utilisent de la GDDR6 et tirent leur nom du ray tracing, une technique de rendu 3D particulièrement lourde qu'elles sont capables de traiter en temps réel, selon Nvidia. Le fabricant fait miroiter des jeux aux graphismes ultra réalistes, et même, le mot est prononcé, « photoréalistes », mais ne précise pas le gain de performances par rapport à la génération actuelle.

En attendant des modèles plus abordables, la GeForce RTX 2070 va jouer le rôle d'entrée de gamme. Elle a 2 304 cœurs CUDA, 8 Go de RAM, et est cadencée de 1 410 à 1 620 MHz. Au-dessus, la RTX 2080 est composée de 2 944 cœurs CUDA et 8 Go de RAM. Elle est cadencée à 1 515 MHz de base et peut monter jusqu'à 1 710 MHz. La RTX 2080 Ti, le haut du panier, bénéficie pour sa part de 4 352 cœurs CUDA et 11 Go de RAM. Sa fréquence va de 1 350 MHz à 1 545 MHz.

Ces cartes seront vendues 499, 699 et 999 $ minimum respectivement. Les précommandes sont déjà ouvertes sur plusieurs sites (Materiel.net, Hardware.fr…) à des prix variables pour les RTX 2080 qui seront disponibles à partir du 20 septembre. La RTX 2070 arrivera en octobre.

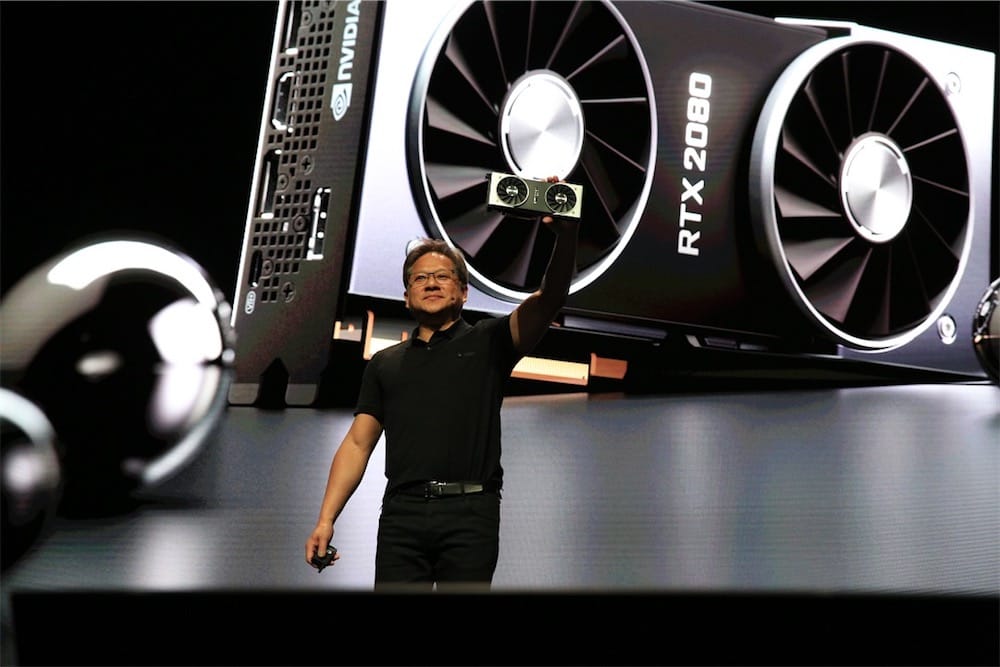

Des éditions « Founders », overclockées, disposant d'un système de refroidissement à deux ventilateurs ainsi que d'un port USB-C, seront également proposées.

Contrairement à ceux d'AMD, les GPU de Nvidia ne sont pas pris en charge nativement par macOS. Cela étant, Nvidia publie ses propres pilotes graphiques pour le système d'Apple et la communauté s'emploie à rendre ses cartes utilisables en tant qu'eGPU.