Une feuille de route supposée d'Intel publiée sur un forum interroge sur le devenir du MacBook Pro 15". Actuellement, le portable est proposé en deux modèles : le premier dispose uniquement d'une carte graphique intégrée (modèle haut de gamme Iris Pro Graphics, GT3e), le deuxième d'une carte graphique dédiée supplémentaire.

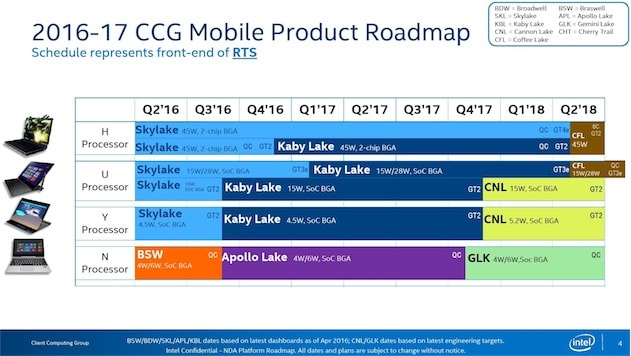

D'après le planning d'Intel qui a fuité, il n'y aura pas de processeurs de nouvelle génération Kaby Lake avec un GPU équivalent (GT3e) avant le premier trimestre 2017. Mais on parle là de processeurs de la gamme U (15 W / 28 W) utilisée dans le MacBook Pro 13", pas dans le 15", qui va piocher dans la gamme H (45 W).

Les prochaines puces H Kaby Lake qui seraient disponibles à la fin de l'année n'auraient qu'un GPU GT2 bien moins puissant. Autrement dit, si Apple continue de proposer un MacBook Pro 15" sans carte graphique dédiée et le renouvelle dans les prochains mois, il aura probablement un processeur Skylake, et non Kaby Lake, faute de GPU intégré assez puissant.

Cela étant, la Pomme bouleversa peut-être la gamme à l'occasion de la refonte attendue. Si elle tient à Kaby Lake, elle pourrait intégrer une carte graphique dédiée (a priori une AMD Polaris) dans tous les modèles pour pallier le manque de puissance du GPU Intel. À moins qu'elle ne poursuive sa politique actuelle (un modèle sans GPU dédié, un autre avec), ce qui serait synonyme de processeur Skylake.

Bloomberg, généralement bien renseigné, affirme que la carte graphique AMD Polaris sera disponible en option. Mais en option sur quel MacBook Pro ? Le 13" ? Le 15" ? Les deux ? En l'état, difficile de savoir ce qu'Apple compte faire avec le MacBook Pro 15". On espère que la remise à plat de la machine sera favorable à une partie graphique puissante (comprenez avec un GPU dédié) pour tous les modèles, mais la situation est incertaine.

Source :