PyTorch annonce la sortie d’une version optimisée pour les Mac Apple Silicon de ses outils, un travail réalisé avec l’aide d’Apple. Ce framework open-source d’apprentissage automatisé (machine learning) construit sur une base de Python est utilisé sur de multiples projets, y compris de grande envergure, puisqu’une entreprise comme Tesla l’a utilisé pour la conduite autonome, pour ne donner qu’un exemple. Sur les Mac, il reposait uniquement sur le CPU jusque-là, avec des performances médiocres.

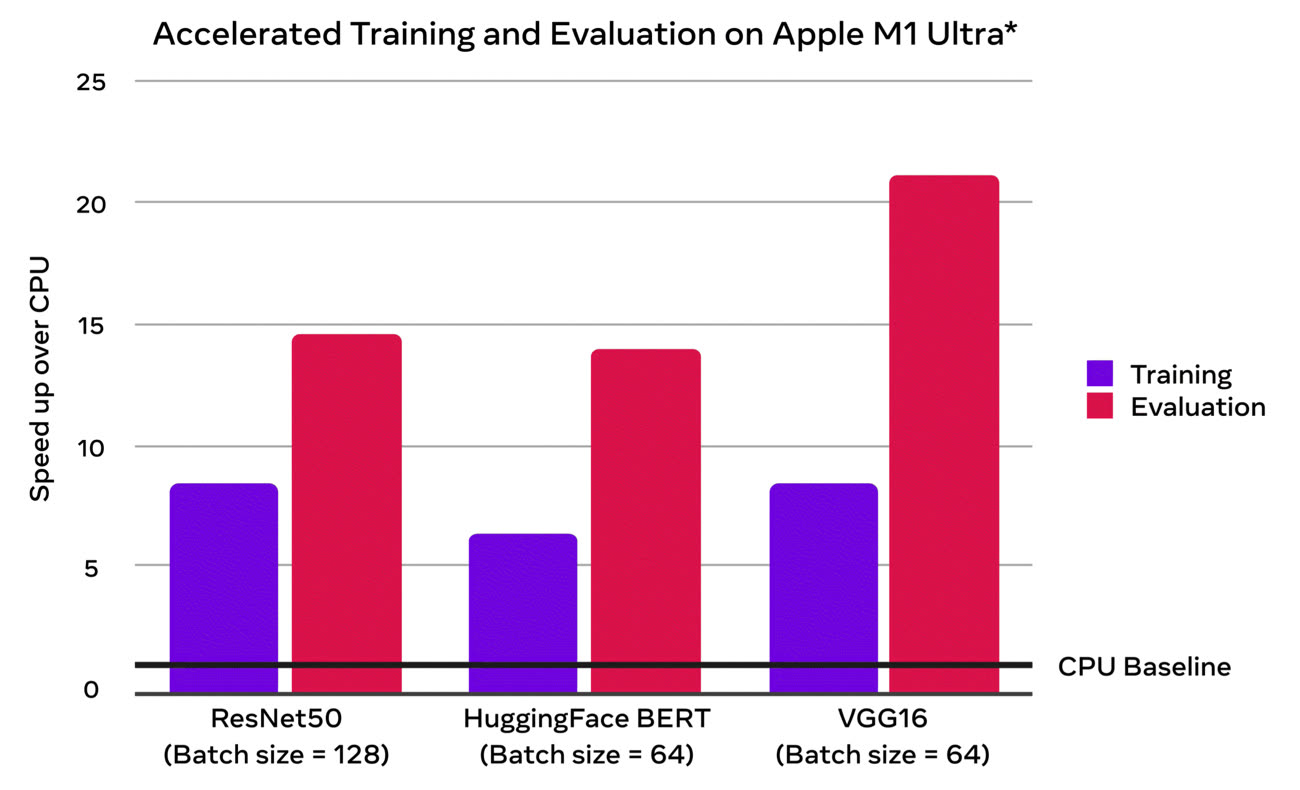

La version 1.12 exploitera le GPU et la mémoire unifiée des puces Apple destinés aux Mac M1. Metal, l’API graphique maison, est aussi exploitée, mais apparemment pas le moteur neuronal pourtant présent dans toutes les puces Apple Silicon. Quoi qu’il en soit, les gains devraient être spectaculaires, avec des performances multipliées par au moins cinq en phase d’apprentissage sur un Mac Studio équipé d’une puce M1 Ultra. C’est encore plus net quand le modèle entraîné est exploité, avec jusqu’à 20 fois plus de performances selon les tests.

La version 1.12 n’est pas encore finalisée, c’est la version 1.11 qui est actuellement stable. Si vous utilisez PyTorch et un Mac Apple Silicon, vous pourrez tester la mise à jour en installant la « Preview (Nightly) » depuis la page des téléchargements du projet. Deux précisions importantes, il faut non seulement macOS 12.3, mais aussi une version récente et arm64 de Python. Les détails sont donnés sur cette page de téléchargement.