Le secteur de la diffusion de vidéos en streaming est tout proche d’un grand bouleversement. Jusqu’à présent, cette industrie n’avait guère plus qu’un codec à gérer, le H.264/AVC. Les choses vont changer très rapidement, Apple ne faisant aucun mystère de son support du H.265/HEVC, qui sera la norme dans iOS 11 et macOS High Sierra ; du côté de Google et d’Android, on supporte le codec VP9, tandis que l’Alliance for Open Media a son AV1 libre et gratuit, supporté par les plus grands noms de l’industrie tech.

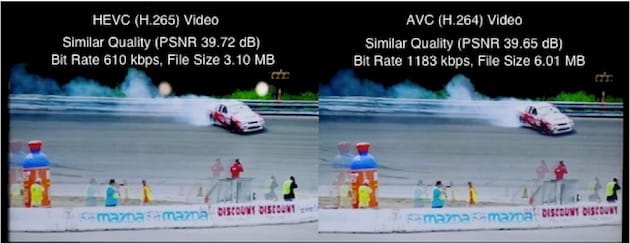

La fragmentation est donc en marche, les diffuseurs devant supporter au moins trois codecs : H.264, H.265 et VP9, en attendant l’AV1 qui devrait être lancé en 2019. Pour l’utilisateur et les tuyaux des opérateurs, les atouts des nouveaux codecs sont évidents : les fichiers pèsent beaucoup moins lourd à qualité égale. En revanche, c’est un casse-tête pour les diffuseurs qui vont devoir consacrer beaucoup de ressources pour encoder leur contenu dans ces formats.

Pour les serveurs, le coût d’encodage en H.265 et en VP9 est multiplié par cinq. Pour l’AV1, ces coûts sont même multipliés par… 20 ! Et il faut aussi prendre en compte les différents niveaux de qualité : aux SH, HD et 4K, il faut ajouter le HDR, le 10-bit, et un framerate plus élevé dans certains cas. Or, il faut multiplier par 5 les coûts serveur pour passer du 1080p SDR au 4K HDR. Et puis il y a également les contenus 360° qui sont de plus en plus consommés et qu’il faut bien prendre en charge également.

Selon Dan Rayburn, analyste pour StreamingMedia, les diffuseurs de contenus en streaming pourraient bien subir une multiplication par 500 de leur facture d’encodage dans les prochaines années en raison de la prise en charge des nouveaux codecs, de la qualité d’image et des vidéos 360°. Évidemment, l’industrie a commencé à réfléchir sur le sujet en exploitant une technologie qui commence à prendre racine dans les fermes de serveurs, le FPGA (Field Programmable Gate Array) ou encore circuits logiques programmables.

Plus souples que les processeurs et processeurs graphiques, ces circuits sont déjà installés dans les centres de données d’Amazon, de Baidu ou encore chez OVH, où on estime d’ailleurs que « 2017 sera l’année du déploiement » de cette technologie.