Microsoft teste depuis un an l'idée de plonger des data centers au fond des mers et océans pour y trouver les basses températures dont ils ont besoin. L'un des problèmes auxquels font face ces installations, lorsqu'elles sont installées sur la terre ferme, réside dans la chaleur que dégagent leurs centaines sinon milliers de serveurs.

« Lorsque vous sortez votre smartphone vous croyez utiliser ce miraculeux petit ordinateur, alors qu'en fait vous utilisez plus de 100 ordinateurs dans ce que l'on appelle le nuage » rappelle Peter Lee, un responsable de Microsoft Research interrogé par le New York Times, « Et vous multipliez cela par des milliards de gens, et c'est une somme énorme de calculs à réaliser ».

Un effort qui se traduit par des serveurs qui fonctionnent non stop, avec des besoins en refroidissement massifs, permanents et coûteux. Microsoft, en ce qui le concerne, a plus de 100 data centers à travers le monde pour un coût total d'investissement qui a dépassé les 15 milliards de dollars.

Son projet Natick consiste à placer ces serveurs à l'intérieur de caissons immergés. Sous l'eau, les températures sont plus clémentes et réduisent considérablement la facture énergétique pour le refroidissement de l'air. Il y a lieu ensuite de produire de l'énergie nécessaire à leur fonctionnement en les faisant flotter à basse profondeur, leurs turbines profiteront des mouvements de la houle.

Ce ne sont pas les seuls avantages mis en avant. Il y a la possibilité de rapprocher des utilisateurs ces data centers qui gèrent données et services et de réduire ainsi les temps de latence entre demandes et réponses. 50% des populations vivent près des côtes, estime l'équipe de Microsoft, alors qu'aujourd'hui les propriétaires de data centers ont tendance à les placer loin des villes pour trouver de grands espaces.

Ensuite ces nouvelles fermes de serveurs seraient plus rapidement déployées, de l'ordre de trois mois au lieu de deux ans pour une installation équivalente sur la terre ferme.

Enfin, en imaginant de nouveaux types de data centers, il y aura peut-être matière à faire évoluer les serveurs tels qu'ils existent. Actuellement ils sont conçus et installés de manière à être manipulés facilement par des techniciens. Dans ces capsules, il n'y aura pas de présence humaine, ce qui donne davantage de liberté pour l'agencement des serveurs (plus besoin de raisonner en termes d'armoires sagement alignées). Ce qui implique aussi de les rendre plus fiables, pour qu'ils puissent fonctionner pendant au moins 5 ans sans maintenance physique directe. Au bout de cette période, le container serait remonté en vue d'être replongé après avoir été révisé.

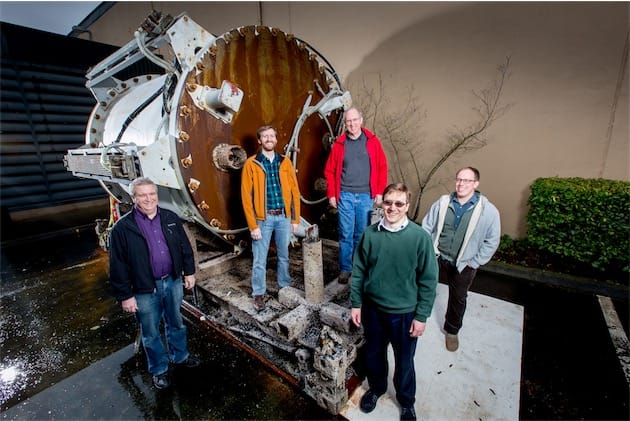

Microsoft a testé concrètement son idée l'été dernier, en plongeant au large des côtes californiennes une capsule de 2,5 mètres de diamètre à 10 mètres de profondeur. Elle y est restée trois mois, armée d'environ 100 capteurs pour mesurer les conditions de son environnement. Les choses se sont bien déroulées, au point que les ingénieurs ont fait quelques tests grandeur nature en reliant leur capsule au nuage de services Azure de l'éditeur.

Face aux inévitables questions environnementales, Microsoft a mené quelques tests. Acoustiques d'abord, qui ont montré que les bruits des disques durs et des ventilateurs à l'intérieur de la capsules étaient effacés par celui du déplacement de bancs de crevettes qui nageaient autour de la capsule. Sur le dégagement de chaleur ensuite, qui s'est révélé « extrêmement faible » s'agissant d'une capsule qui produit sa propre énergie.

Ce ne sont là que des observations préliminaires avec une petite capsule de test. Ce projet n'en est qu'à ses débuts et il est trop tôt pour savoir s'il se concrétisera un jour à plus grande échelle.