Après un mois de bêta test, Apple livre la version finale de macOS 26.2. Cette mise à jour apporte une fonction inattendue et une optimisation qui était, elle, très attendue.

Éclairage des bords

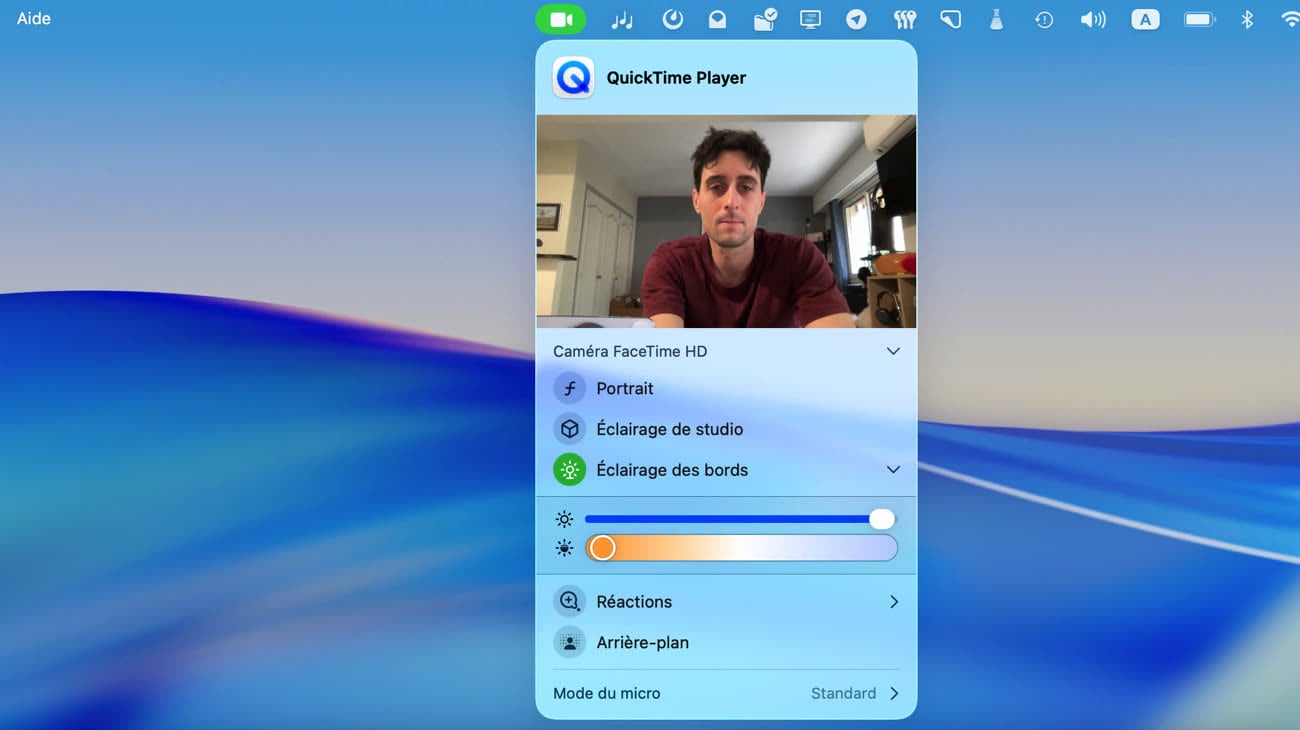

Vous connaissez les ring lights, ces anneaux lumineux qui se fixent sur un pied et servent à bien éclairer le visage pour les vidéos face caméra ? macOS 26.2 propose un équivalent logiciel. Accessible depuis les options de FaceTime et des autres applications de visioconférence (l’icône caméra dans la barre des menus), la fonction Éclairage des bords affiche une large bande lumineuse sur les contours de l’écran pour améliorer l’éclairage du sujet.

Il est possible d’ajuster l’épaisseur de cette lumière ainsi que sa température, du jaune au bleu. L’objectif est d’améliorer le rendu dans les pièces peu éclairées. La fonctionnalité est réservée aux Mac Apple Silicon : selon Apple, le Neural Engine détecte automatiquement le visage, sa taille et sa position afin d’optimiser l’éclairage. Les Mac sortis à partir de 2024 bénéficient d’un petit plus : l’éclairage peut s’activer automatiquement lorsque l’environnement est trop sombre.

Plus de détails dans notre prise en main :

Éclairage des bords : coup d'œil sur l'anneau lumineux de macOS 26.2

Optimisations en IA

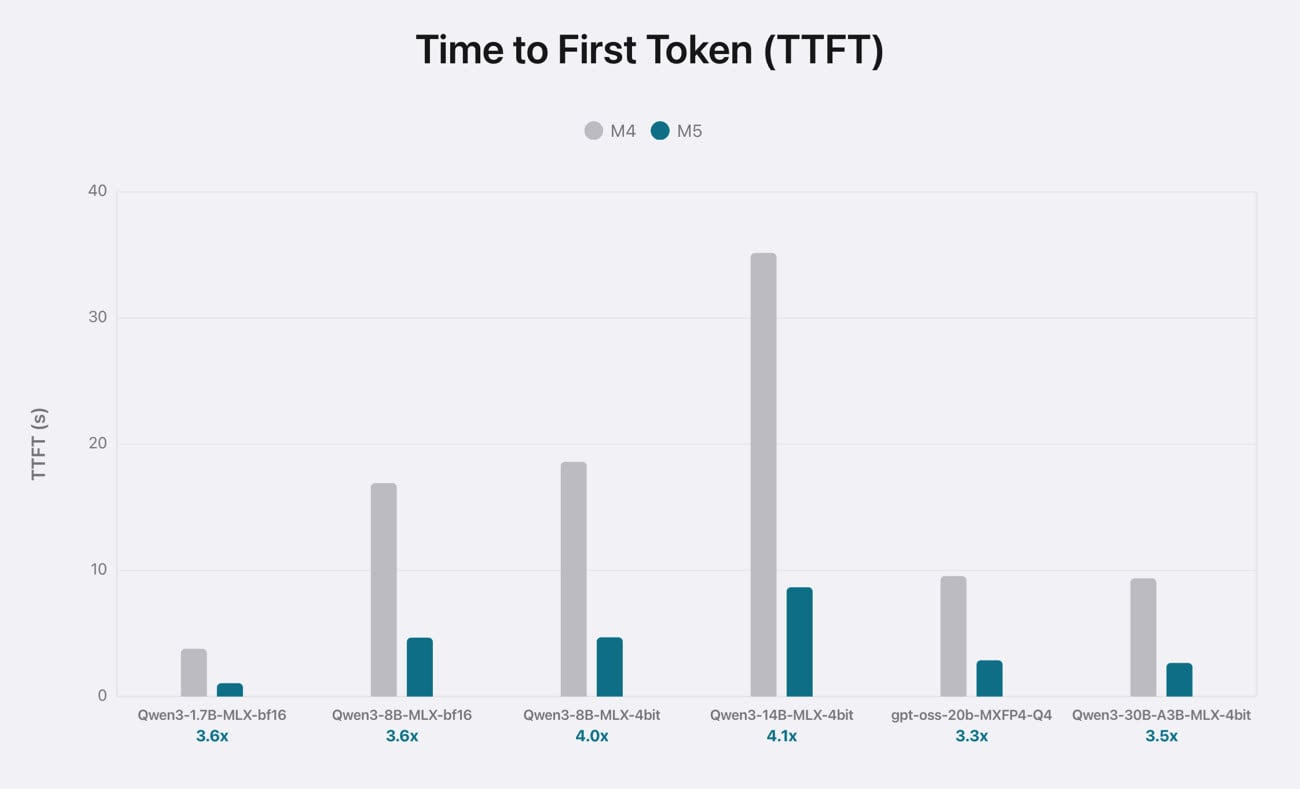

La grande nouveauté de la puce M5, c’est la présence d’accélérateurs neuronaux dans le GPU qui, comme leur nom l’indique, doivent accélérer (significativement) les tâches liées à l’intelligence artificielle. Une nouveauté majeure sur le papier, sauf qu’elle n’était pas encore pleinement exploitable.

Avec macOS 26.2, Apple comble cette lacune : son framework MLX, qui sert à faire tourner des modèles de langage en local, tire désormais parti de cette puissance de calcul supplémentaire. Le gain annoncé est spectaculaire : selon le fabricant, le MacBook Pro M5 (avec 24 Go de RAM) génère le premier token jusqu’à quatre fois plus vite qu’un MacBook Pro M4.

Par ailleurs, macOS 26.2 ajoute un nouveau pilote permettant de mieux gérer le clustering entre plusieurs Mac, notamment lorsqu’ils sont connectés en Thunderbolt 5. Jusqu’ici, il était déjà possible d’assembler plusieurs machines par Ethernet ou Thunderbolt 4, mais le Thunderbolt 5 promet des échanges nettement plus rapides grâce à une bande passante doublée à 80 Gb/s.

Ces avancées ouvrent la voie à de petits clusters d’IA locaux. Un laboratoire de recherche, par exemple, pourrait combiner la puissance de plusieurs Mac mini ou Mac Studio pour exécuter de très grands modèles de langage directement sur site.

macOS Tahoe 26.2 va doper le machine learning sur les Mac M5

Test du MacBook Pro M5 : ennuyeux mais terriblement efficace

Correction d’un problème de performances avec les apps Electron

Le problème de performances lié aux apps Electron que macOS Tahoe traîne depuis sa sortie semble enfin en voie de disparition. macOS 26.2 corrige apparemment le bug d’un seul coup pour l’ensemble des applications concernées.

Dans macOS Tahoe, le framework Electron remplace l'API privée AppKit d'Apple pour appliquer un masque d'angle personnalisé semi-transparent. Ce changement provoque une sollicitation du GPU par le processus WindowServer pouvant grimper à 100 % au lancement d’une app Electron, avec à la clé des ralentissements et une grosse consommation d’énergie pour les Mac.

Depuis l’identification du bug, plusieurs apps populaires (Discord, Slack, Microsoft Teams, VS Code…) ont été mises à jour vers une version d’Electron qui corrige le problème. Mais d’autres n’ont pas encore été actualisées et continuent donc de provoquer ces performances dégradées. macOS 26.2 semble régler le problème une bonne fois pour toutes.

macOS 26.2 corrigerait une bonne fois pour toutes le bug des apps Electron qui font ramer Tahoe

App Detective dévoile la technologie derrière chaque app Mac