Le Liquid Glass d’Apple a beaucoup fait parler depuis sa présentation, divisant souvent les observateurs. Mais un constat s’impose : si la nouvelle expression graphique de Cupertino est omniprésente dans le système, elle tarde à se matérialiser dans les applications.

Le contraste est saisissant avec le passage au flat design. À l'époque, les développeurs avaient cravaché tout l’été pour mettre leurs apps au diapason des nouveaux codes d’Apple. Avec le Liquid Glass, c’est une toute autre histoire…

Une chose est certaine : Apple ne montre guère l’exemple. Si l’on regarde les apps qui ne sont pas préinstallées avec le système, nombre d’entre elles se sont contentées d’une simple mise à jour de l’icône. Ni plus, ni moins… Alors qu’iOS 26 est disponible depuis bientôt trois mois, la suite iWork n’a toujours pas été revue pour tirer profit, entre autres, de cette nouvelle interface.

iWork attend toujours son bain de Liquid Glass

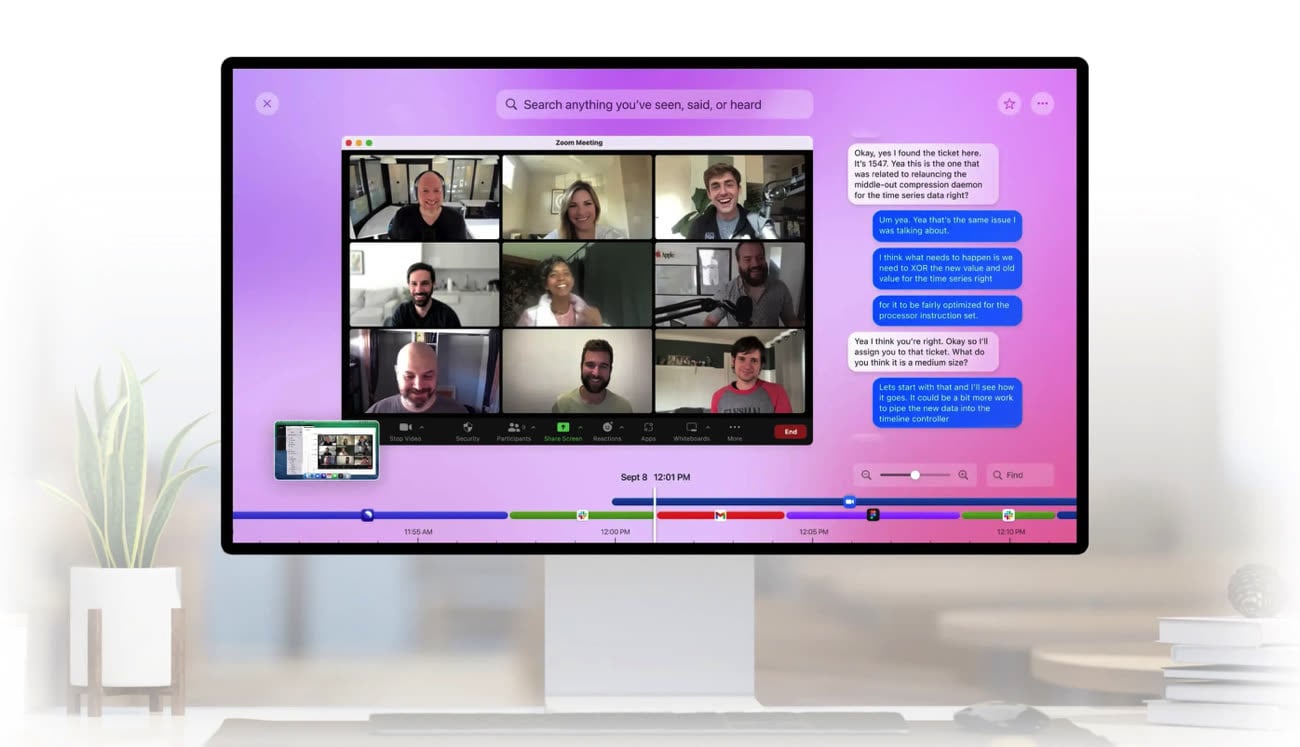

Le même constat s'applique aux éditeurs de grosses apps. Lancez Discord, YouTube ou Reddit, et le choc visuel est immédiat. D’un côté, les nouveaux panneaux translucides et le clavier modernisé d’Apple ; de l’autre, des interfaces qui semblent figées dans une époque révolue. Cette cohabitation forcée sur le même écran OLED donne parfois l’impression d’un système à deux vitesses.

D'ordinaire, les poids lourds de l'App Store dégainent vite après une mise à jour majeure d'iOS. Cette année, le déploiement est poussif. On se retrouve dans une étrange zone de transition où le système paraît frais et moderne, tandis que les apps que l'on utilise le plus vivent encore à l'heure du pré-Liquid Glass.

Les indés à la rescousse, les géants en retrait

Comme souvent, le salut vient des développeurs indépendants. Il suffit de traîner un peu sur les forums pour constater que ce sont les petites équipes qui embrassent le changement le plus rapidement. Plus agiles, elles n'hésitent pas à jouer avec la transparence et les nouveaux contrôles pour donner un coup de jeune à leurs interfaces.

En face, les géants de la Tech jouent une toute autre partition. Pour Facebook, Google et consorts, la cohérence visuelle prime sur les desiderata esthétiques de Cupertino. Leur objectif est simple : une app doit ressembler à elle-même, qu'elle tourne sur iOS, Android ou le web. Refondre une application massive pour coller au Liquid Glass, c'est prendre le risque de briser cette uniformité inter-plateforme. Sans compter que pour certains designers, faire ressembler leur app aux logiciels d'Apple n'est pas un but, mais un problème d'identité.

Le casse-tête du cross-platform

Il faut dire que la technique n'aide pas. À l'heure où beaucoup ne jurent que par React Native ou Flutter pour mutualiser le développement, l'adoption de composants 100 % natifs devient un chemin de croix. Le Liquid Glass reposant énormément sur les API système, il est difficile de « faker » cet effet dans un framework générique.

Résultat : les développeurs sont coincés. Soit ils attendent une prise en charge officielle dans leurs outils (ce qui arrive souvent avec un train de retard), soit ils bricolent des effets de transparence qui jurent souvent avec le reste.

Pourquoi certaines apps ont encore un vieux clavier

Le diable se cache aussi dans les détails, comme ce bon vieux clavier. Si vous vous demandez pourquoi certaines apps affichent encore l'ancien clavier grisâtre alors que Messages arbore fièrement la nouvelle version, ne cherchez pas plus loin : c'est souvent une histoire de compilation avec de vieilles versions de Xcode. Tant que les développeurs ne mettent pas à jour leur chaîne de production, vous resterez avec l'ancienne interface.

Ajoutez à cela les sueurs froides des équipes accessibilité (la transparence et la superposition des couches n'ont jamais fait bon ménage avec le contraste) et la frilosité légitime à essuyer les plâtres d'API encore buggées, et vous obtenez le statu quo actuel.

Source :