Mise à jour le 9 mai : macFUSE 5.0 est distribué dans une première version bêta. Son développeur précise qu'il a abandonné la prise en charge de macOS 10.9 jusqu'à 10.15 pour démarrer à partir de macOS 11 (Big Sur en 2020).

Article du 14 avril

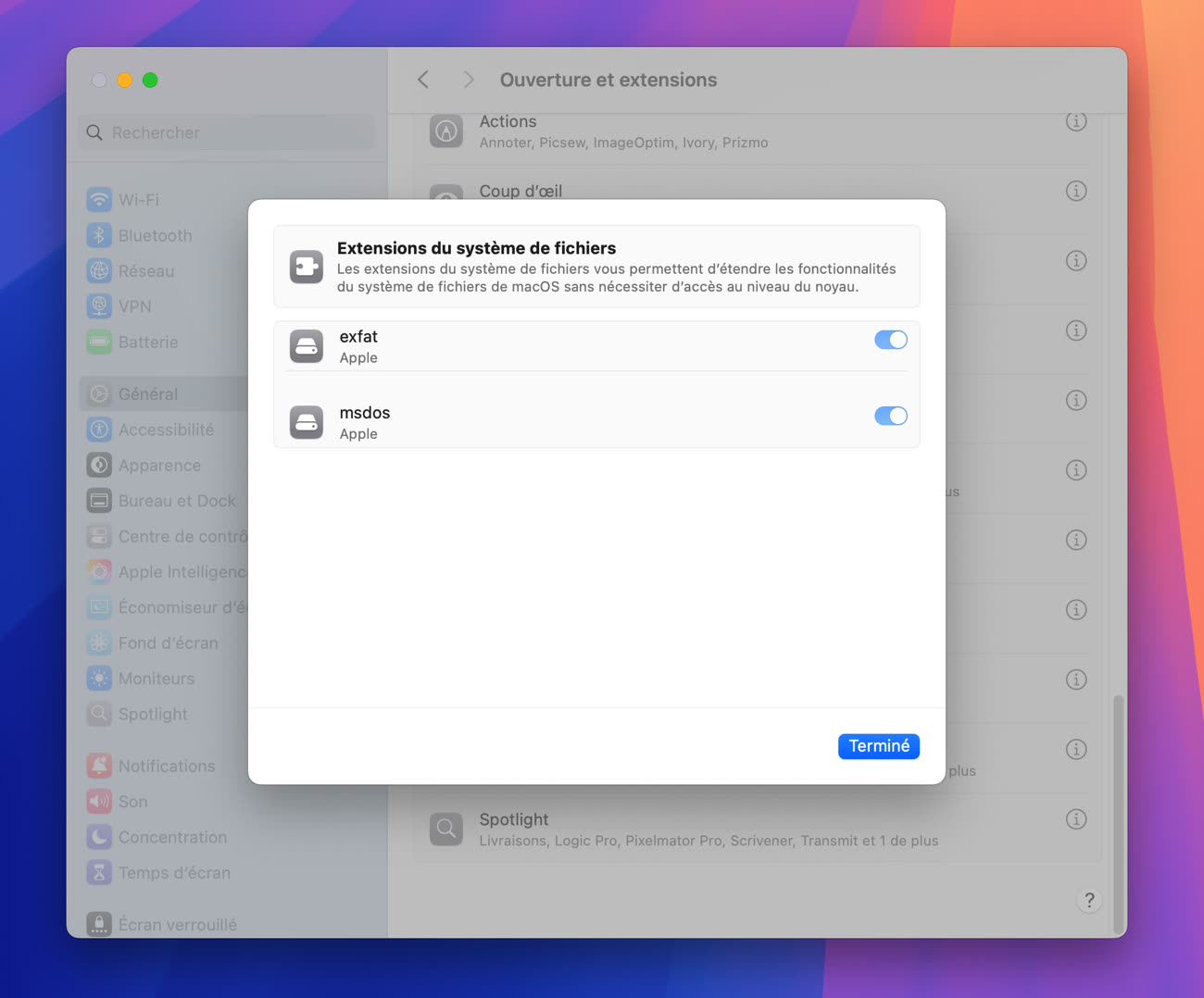

FSKit étant finalement implémenté dans macOS 15.4, les développeurs peuvent tirer profit de ce framework qui facilite l’ajout de systèmes de fichiers. C’est ce que va faire Benjamin Fleischer avec macFUSE, un logiciel lui-même destiné à simplifier la prise en charge de systèmes de fichiers supplémentaires sur macOS.

macFUSE 5 laissera le choix aux utilisateurs : soit l’installation classique avec une extension du noyau, soit l’installation allégée grâce au framework FSKit. L’avantage de cette dernière, c’est qu’il ne sera pas nécessaire de basculer son Mac en « sécurité réduite » pour utiliser le programme, l’intérêt de FSKit étant justement que les systèmes de fichiers deviennent des extensions exécutées dans l’espace utilisateur.

macFUSE 5 va conserver la méthode d’installation traditionnelle pour ceux qui le souhaitent car le nouveau framework n’offre pas encore toutes les possibilités permises par une extension du kernel. « La version actuelle de FSKit est destinée aux volumes locaux. Cela implique des limitations qui peuvent s'appliquer lors du montage d'un système de fichiers distribué ou réseau. […] Pour de nombreux systèmes de fichiers FUSE, l’infrastructure FSKit sera le premier choix, pour d'autres, l’infrastructure de l'extension du noyau restera le plus adapté », explique le développeur. La date de sortie de macFUSE 5 n’a pas encore été annoncée.

FUSE-T, une autre implémentation de FUSE sur macOS (qui ne nécessite pas d’extension du noyau, contrairement à macFUSE), va se tenir à l’écart de FSKit à court terme. Après une discussion avec un ingénieur d’Apple, son développeur estime que le nouveau framework n’est pas pertinent pour l’instant. Dans cet échange, l’employé de Cupertino soulignait justement que FSKit n’était pas pensé pour les volumes réseau, tout en précisant avoir bien conscience de cette demande.