C’est le calme avant la tempête… Les jours qui viennent risquent d’être chargés avec les différentes annonces Apple. Alors, si ce n’est pas déjà fait, pensez à précommander votre exemplaire de notre livre : L’aventure Apple : 50 ans de souvenirs.

En fin de semaine, nous avons franchi un nouveau cap symbolique : celui des 1 000 exemplaires précommandés. Nous sommes impatients que ce livre vous parvienne afin d’avoir vos réactions. J’espère qu’il vous plaira autant qu’il nous plaît. Mille mercis pour votre soutien !

Si tout se passe bien, nous devrions recevoir les premiers exemplaires pendant la seconde quinzaine de mars. Il ne restera plus alors qu’à organiser les expéditions.

Objectif 6502

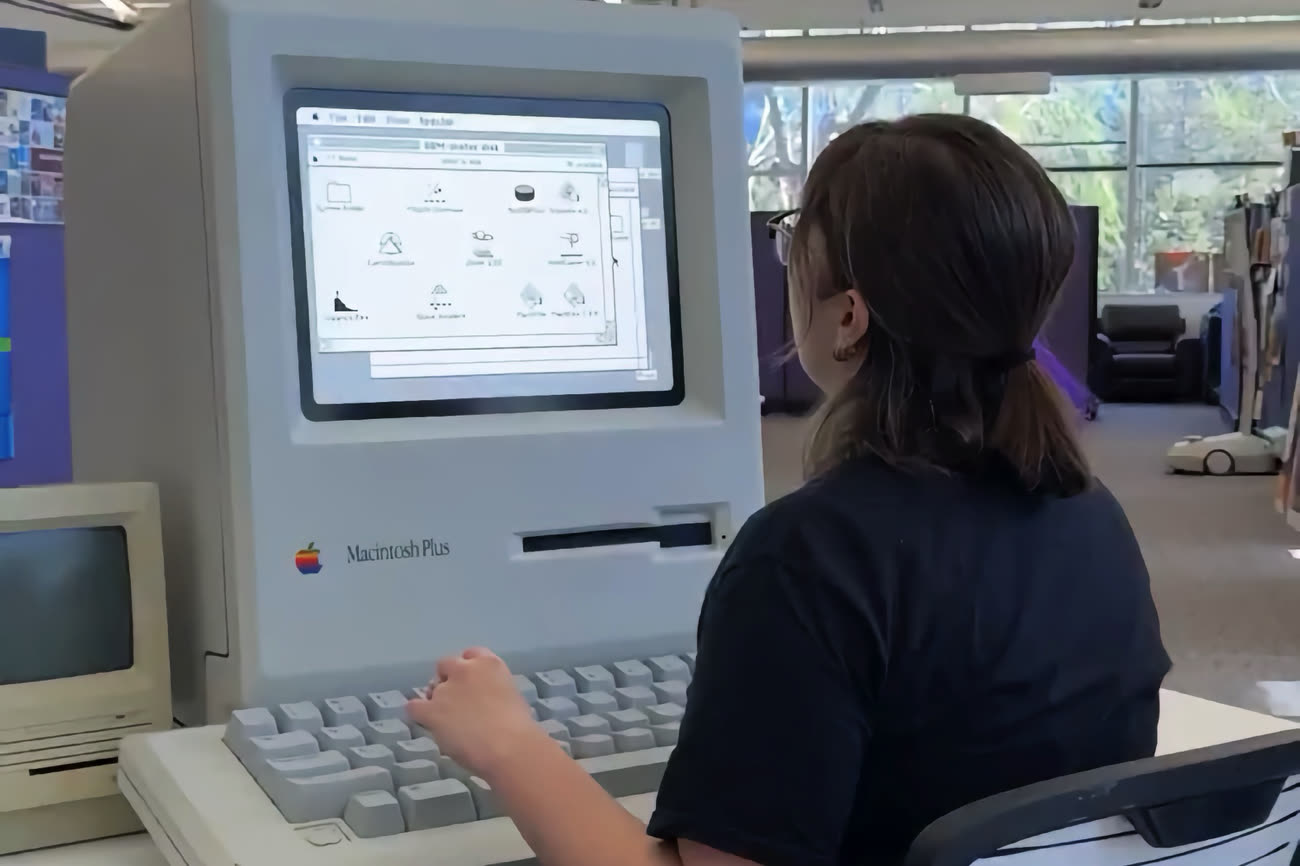

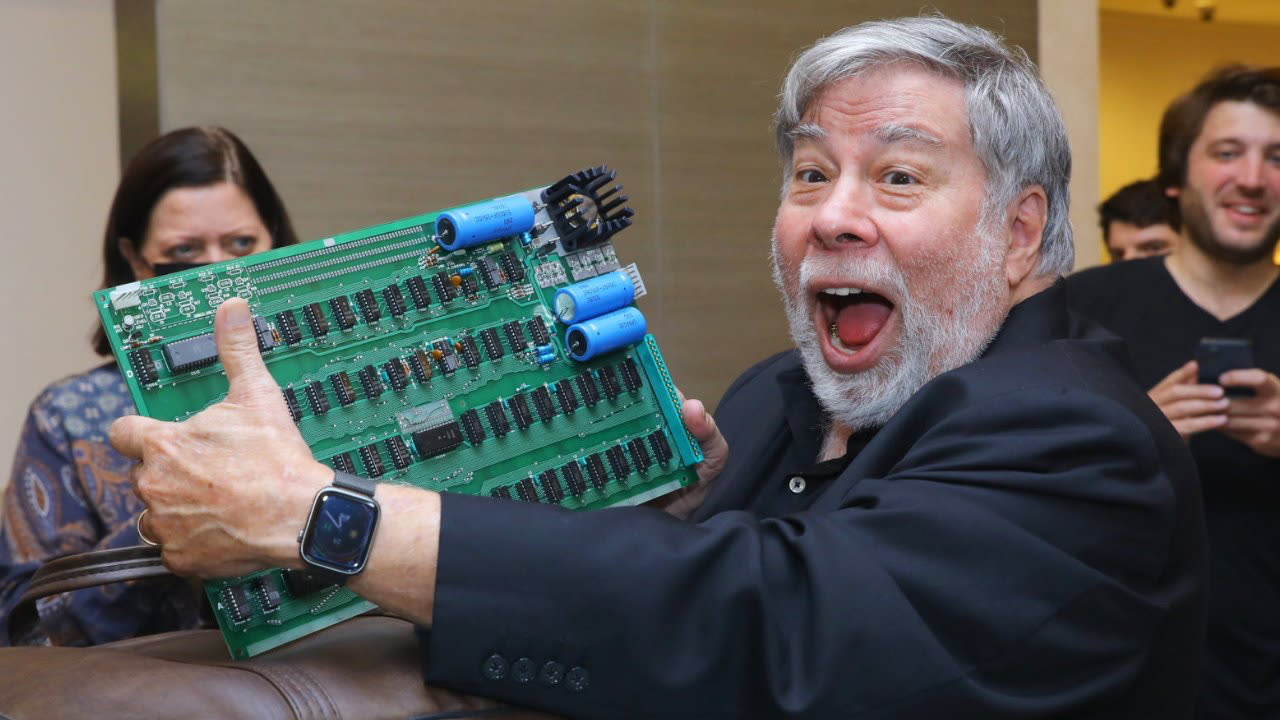

Le prochain objectif, plus très loin, est fixé à 65 020 €. Alors pourquoi 65 020 ? En référence au processeur 6502 que l’on retrouvait au cœur de l’Apple I et de l’Apple II. Il est toujours fascinant d’évoquer les caractéristiques techniques des puces d’antan. Pensez donc : cette puce 8 bits était cadencée à 1 MHz et pouvait adresser 8 Ko de mémoire vive. Nos complaintes sur l’évolution du prix de la RAM ou le retour d’un Mac avec 8 Go de mémoire paraissent soudainement un brin dérisoires. Lors de la journée de MacGeneration, le 18 avril, nous prévoyons de faire une démo d’un Apple I. Le souci, c’est que si nous avions voulu faire l’acquisition d’un original, il aurait fallu trouver quelques centaines de milliers de dollars. Ce n’est sans doute pas très raisonnable.

À la place, nous allons faire l’acquisition d’une carte mère qui est une réplique fidèle de l’Apple-1. Le prix est nettement plus raisonnable.

Si nous franchissons la barre des 65 020 €, nous offrirons à l’un des participants cette réplique pour qu’il puisse se replonger dans le passé à ses heures perdues. Franz Achatz, à qui l’on doit ce petit bijou, a reçu de Steve Wozniak l'autorisation écrite personnelle d'utiliser le code ROM original de l'Apple I. Cela fait de l'A-ONE non seulement une réplique matérielle, mais également un véritable héritier fonctionnel de l'Apple I.

Alors, pour participer à ce petit concours, vous savez ce qu’il vous reste à faire…

👉 Je précommande mon exemplaire du livre de MacGeneration sur les 50 ans d’Apple