OpenAI a annoncé plusieurs nouveautés à l’occasion de son « DevDay », notamment pour ChatGPT, son robot qui peut faire la conversation et vous donner des réponses à peu près justes. Sous le capot, le moteur reste sur la même génération améliorée et l’entreprise présente ainsi GPT-4 Turbo, une évolution de GPT-4 présenté en mars dernier, mais rendu disponible dans le courant de l’été passé. Si cette mise à jour peut sembler mineure, elle apporte en réalité une nouveauté majeure pour ChatGPT : des connaissances plus à jour.

En effet, OpenAI a entraîné son grand modèle sur un corpus qui se termine en avril 2023, ce qui veut dire que ChatGPT aura des informations jusqu’à cette date. C’est un changement significatif par rapport à toutes les générations précédente de GPT, qui étaient entraînées sur des données de septembre 2021. Même s’il y avait des méthodes pour obtenir des données plus récentes avec le bot, cette mise à jour devrait apporter des réponses plus fraiches par défaut, sans toutefois pouvoir l’utiliser pour des actualités, puisque le corpus de base n’évoluera plus.

GPT-4 Turbo devrait aussi bénéficier d’une augmentation nette du nombre de « contextes », ce qui lui permet pour faire simple d’avoir une meilleure compréhension de la question et d’offrir des réponses plus adaptées. GPT-4 était limité à 8 000 ou 32 000 contextes selon les versions, GPT-4 Turbo dispose systématiquement de 128 000 contextes. Ces améliorations ne se font pas au détriment du prix, au contraire même, puisque ce nouveau modèle sera deux à trois fois moins cher que GPT-4. GPT-3.5 Turbo est dix fois moins cher et l’ancien modèle bénéficie d’améliorations techniques similaires, y compris une augmentation du nombre de contextes.

On ne sait pas encore quand ce GPT-4 Turbo sera disponible, mais cela devrait venir dans les prochaines semaines, d’après OpenAI. Et si cela ne vous suffit pas, l’entreprise a aussi annoncé la possibilité de créer ses propres modèles, ou plutôt des « GPTs ». L’idée n’est pas tant d’entraîner des modèles avec ses propres données, plutôt de créer des variantes spécialisées dans une tâche précise. On peut ainsi obtenir un assistant qui connaît très bien un domaine spécifique, ou un autre qui est optimisé pour aider à réaliser une tâche donnée.

La création d’un nouveau GPT se fait sans aucune connaissance technique en développement, à travers une nouvelle interface web que les clients d’OpenAI peuvent tester à cette adresse. Une boutique nommée GPT Store permettra de diffuser ces modèles spécialisés et à terme, on devrait même pouvoir gagner de l’argent grâce à ces créations. Les entreprises pourront également créer des GPTs à usage interne.

Parmi toutes les autres annonces du jour, notons l’arrivée d’un modèle pour Whisper, l’extraordinaire outil de transcription d’OpenAI qui brillait déjà par la qualité de son travail. La troisième version est disponible sur GitHub et promet d’améliorer encore ses performances dans toutes les langues prises en charge, mais on n’en sait pas plus.

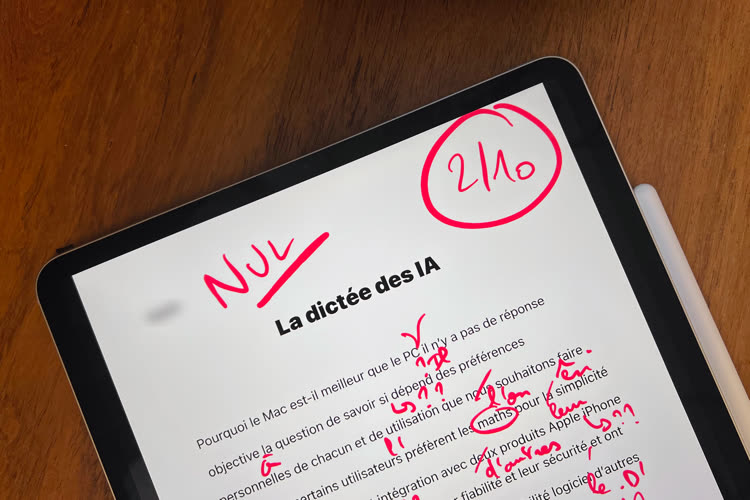

Dictée surprise pour Apple, Google et OpenAI : qui est le meilleur élève ?

OpenAI a aussi indiqué que ChatGPT était désormais utilisé régulièrement par cent millions de personnes. Une réussite indéniable pour cette fonctionnalité qui n’a même pas encore fêté son premier anniversaire, puisque le robot conversationnel a été lancé le 30 novembre 2022.