AMD a profité du Computex, un grand salon taïwanais, pour présenter la nouvelle version des Ryzen. Les Ryzen 9000 succèdent donc aux Ryzen 7000 et passent de Zen 4 à Zen 5. Depuis quelques années, AMD a le vent en poupe et la nouvelle génération devrait donc encore amener des gains importants face aux générations précédentes.

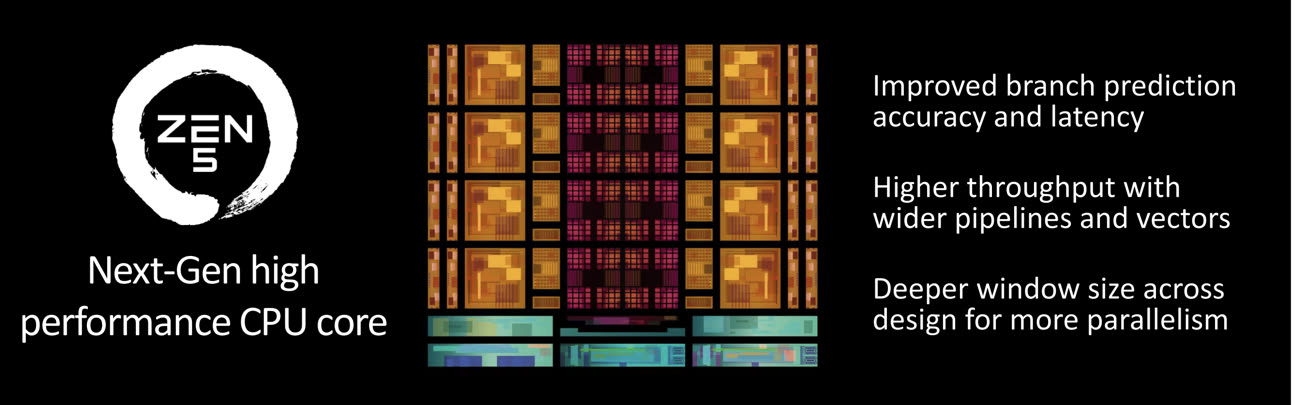

Les Ryzen 9000 (nom de code Granite Ridge) gardent le même type de structure qui a fait le succès d'AMD depuis Zen 2. Un processeur est donc composé de différents blocs physiques (les chiplets) qui comprennent soit des cœurs pour le CPU, soit toute la partie plus secondaire, comme le GPU intégré (qui sert juste à afficher le bureau de Windows) ou le contrôleur mémoire. Cette partie reste en 6 nm (par TSMC) alors que les cœurs CPU, eux, passent en 4 nm.

AMD a annoncé avoir amélioré l'IPC (instructions par cycle, c'est-à-dire l'efficacité du processeur) et amélioré la bande passante des différents niveaux de cache. Si vous trouvez que c'est proche de ce qu'Arm a annoncé récemment, vous avez raison : il s'agit du nerf de la guerre dans ce domaine.

Arm annonce sa gamme de CPU 2024, pour les puces de 2025 : Cortex X925 et A725

AMD a notamment amélioré les performances avec les instructions AVX-512, utilisées dans certains calculs liés à l'IA. Alors que les Ryzen 7000 traitent les vecteurs de 512 bits sous la forme de deux vecteurs de 256 bits (et donc en deux cycles), les Ryzen 9000, eux, travailleront directement en 512 bits avec un gain de performances évident à la clé. Dans l'ensemble, AMD annonce un gain de 16 % par rapport à Zen 4, ce qui est dans la moyenne haute pour une nouvelle architecture. Compte tenu des avancées annoncées, AMD devrait donc proposer des puces aussi rapides que l'Apple M4, du moins sur les performances. Comme chez Arm, par ailleurs, AMD n'intègre pas encore de NPU dans ses puces haut de gamme, contrairement à Apple.

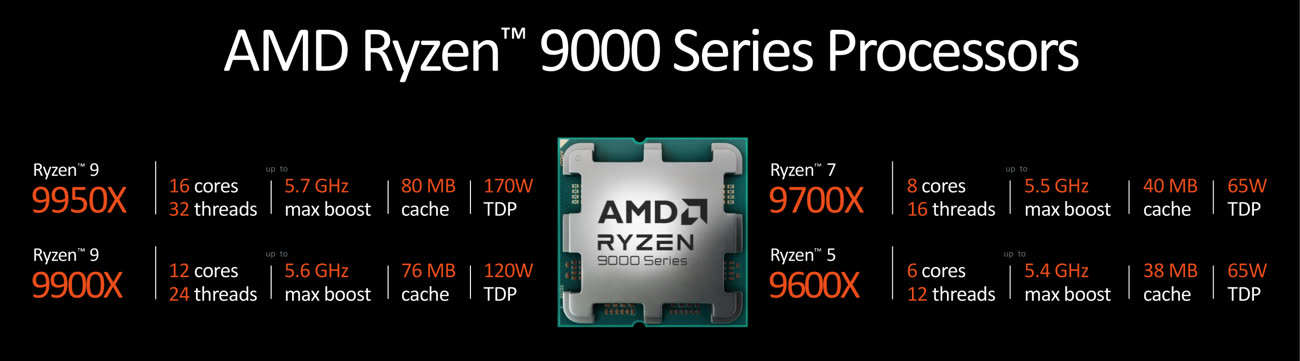

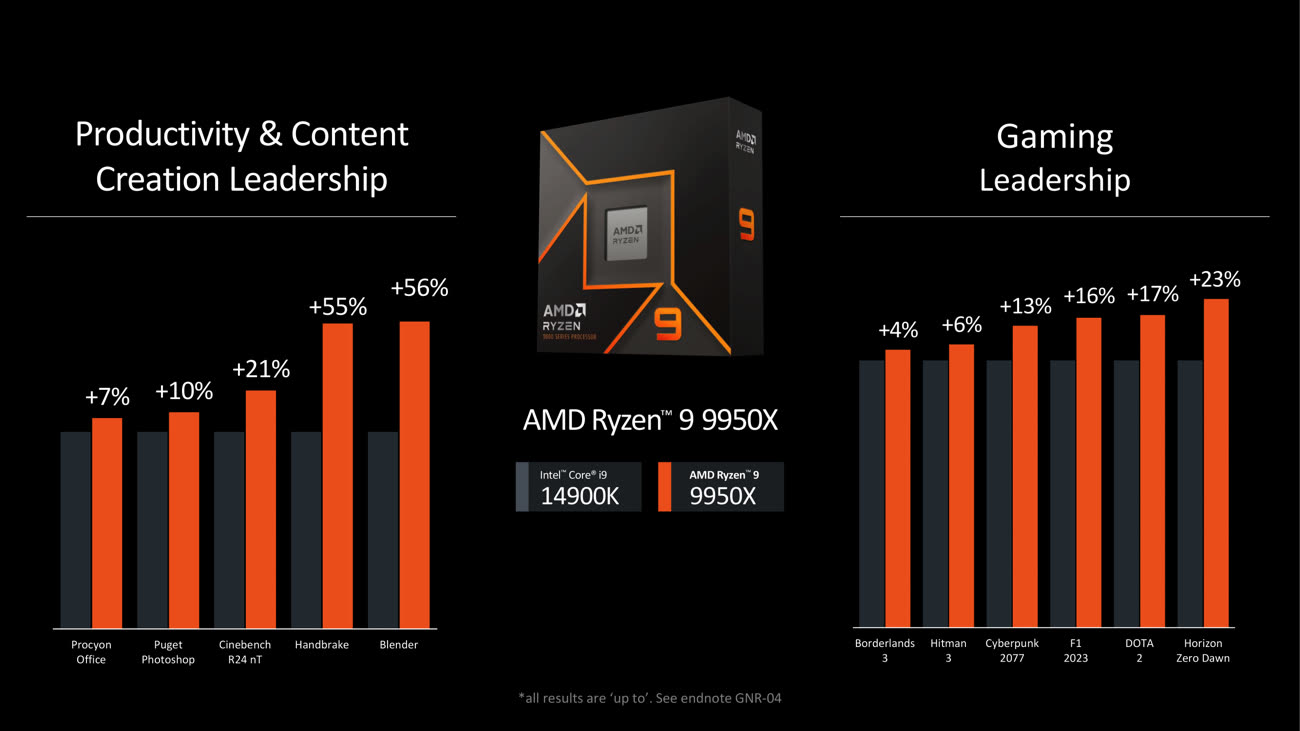

Comme toujours, la marque a d'abord annoncé les puces les plus performantes de la gamme. Le principal est évidemment le Ryzen 9 9950X : il intègre seize cœurs avec une fréquence maximale de 5,7 GHz, 64 Mo de cache de niveau 3 et un TDP de 170 W. Le Ryzen 9 9900X se contente de douze cœurs et 5,6 GHz, contre huit cœurs et 5,5 GHz pour le Ryzen 7 9700X. Enfin, le Ryzen 5 9600X possède six cœurs et une fréquence maximale de 5,4 GHz, pour 65 W de TDP.

Le Ryzen 9 9950X est évidemment présenté comme le meilleur processeur pour les joueurs, et il ne sera probablement détrôné que quand AMD proposera une variante 3D équipée d'une puce de mémoire cache supplémentaire. Si AMD garde une compatibilité intéressante — les Ryzen 9000 vont fonctionner sur les cartes mères dédiées aux Ryzen 7000 en AM5 —, une nouvelle gamme de chipsets (la série 800) amène tout de même deux choses. Premièrement, les cartes mères intégreront obligatoirement de l'USB4, alors que la norme est optionnelle (mais courante) sur la série 600 actuelle. Deuxièmement, le Wi-Fi 6E va laisser sa place au Wi-Fi 7. Ce n'est pas directement lié au chipset (le Wi-Fi n'est pas intégré) mais probablement une obligation pour les constructeurs.

Dans tous les cas, il s'agit d'une évolution intéressante de la part d'AMD, qui ne se repose pas sur ses lauriers. La date de sortie des nouvelles puces est connue (juillet 2024) mais pas le prix, malheureusement. Il faut tout de même rappeler que si les puces dédiées aux PC de bureau représentent le fer de lance de la gamme, la majorité des ventes s'effectue maintenant sur les PC portables. Mais comme toujours avec AMD, il y a un petit décalage entre les Ryzen desktop et les versions mobiles, qui se basent sur des concepts différents.

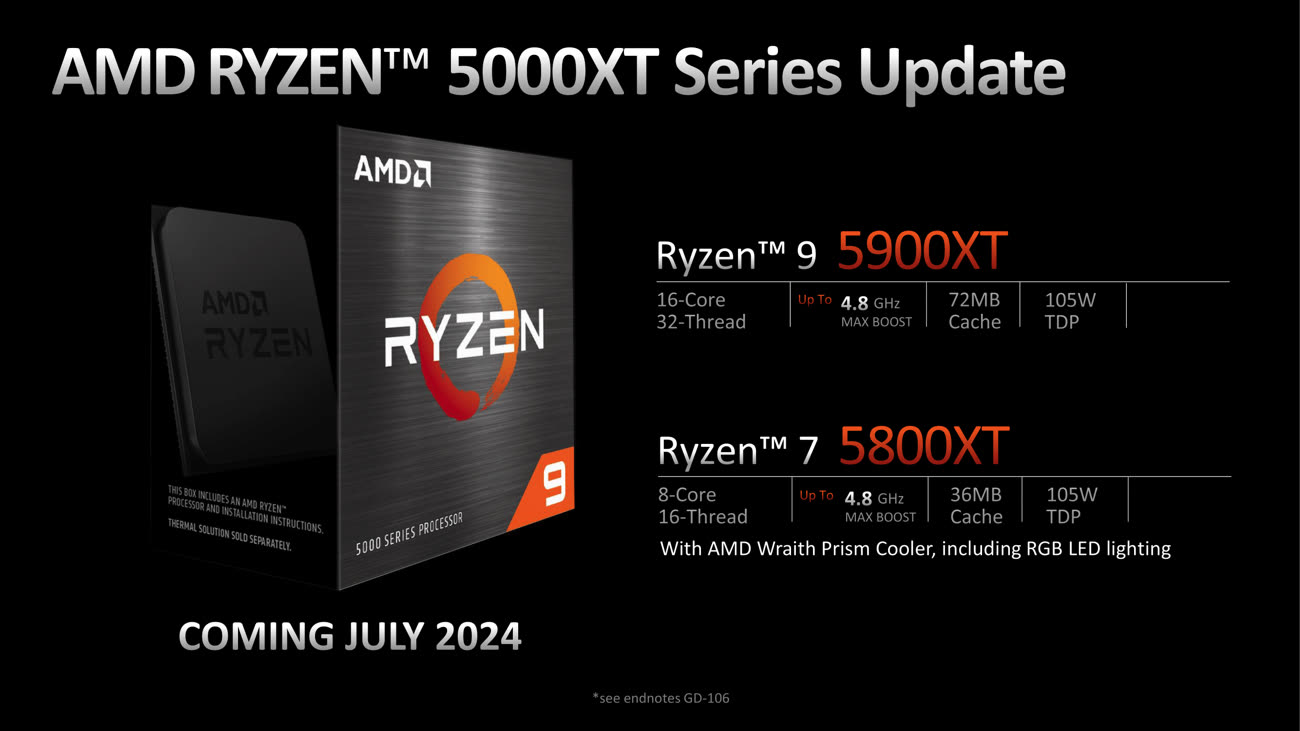

Deux nouveaux Zen 3

En parallèle, AMD a aussi annoncé deux nouveaux processeurs parfaits pour une mise à jour, les Ryzen 7 5800XT et Ryzen 9 5900XT. Prévus pour les supports AM4 — qui a été employé depuis les premiers Ryzen de 2017 —, ils devraient normalement être proposés à un prix faible pour que ceux qui ont encore un PC à base de DDR4 puissent mettre à jour leur processeur. Le Ryzen 7 5800XT est une mise à jour très mineure : il garde le même TDP (105 W) et le même nombre de cœurs (huit) que la version classique (Ryzen 7 5800X) mais monte la fréquence de 100 MHz, soit 2,3 % (de 4,7 GHz à 4,8 GHz en pointe). Le second est plus intéressant : alors que le Ryzen 9 5900X est un modèle doté de douze cœurs, le Ryzen 9 5900XT en possédera seize. Le TDP reste le même (105 W), tout comme la fréquence maximale (4,8 GHz) mais la fréquence de base, elle, diminue de 3,7 GHz à 3,3 GHz. Ce n'est normalement pas un problème sur un système bien refroidi. Si les prix sont compétitifs, les deux puces pourraient donc trouver le succès.