L'information vient d'Intel directement : Michelle Johnston Holthaus (responsable de la branche Client Computing) a indiqué à Ian Cutress (ancien rédacteur en chef d'Anandtech, devenu consultant) que l'architecture Lunar Lake allait (enfin) mettre l'accent sur les performances par watt, en ciblant les appareils mobiles. Le problème, c'est que Lunar Lake n'est pas pour tout de suite, comme l'explique Tom's Hardware.

Beaucoup trop de Lake

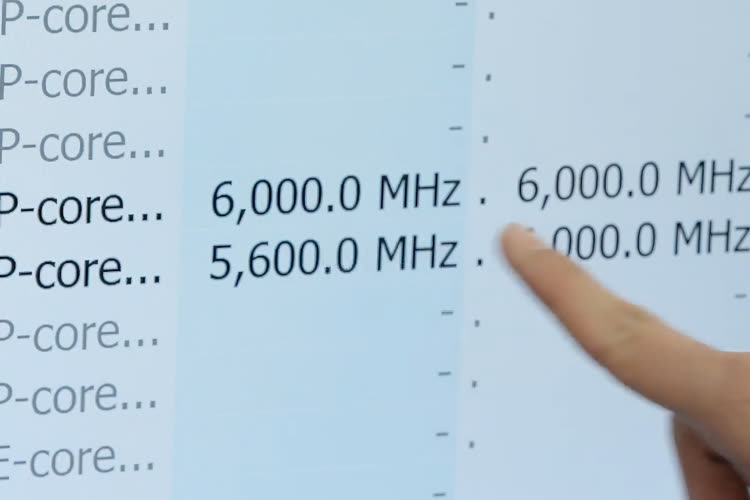

Essayons de résumer. La 13e génération de processeurs Core (l'actuelle) porte le nom de Raptor Lake. Elle offre des performances élevées, mais une efficacité énergétique assez moyenne, pour ne pas dire mauvaise. Les puces classiques (comme les Core i5) arrivent à rester dans les clous, mais dès qu'Intel tente d'aller plus vite, comme — au hasard — en montant la fréquence à 6 GHz, la consommation explose.

Intel atteint les 6 GHz avec une édition spéciale « je n'aime pas la planète »

Le cru 2023 de la gamme Intel devrait (selon les rumeurs) être une déception : on parle pour le moment d'un Raptor Lake Refresh, c'est-à-dire une optimisation des puces de 2022, qui sont elles-mêmes des évolutions assez mineures de celles de 2021 (Alder Lake, la 12e génération). Pour le moment, personne ne sait si Intel va garder le nom « 13e génération » ou considérer qu'il s'agit de la 14e. Dans le passé, la société a en effet choisi les deux voies : les Haswell Refresh sont restés en 4e génération, les Coffee Lake Refresh sont devenus la 9e génération.

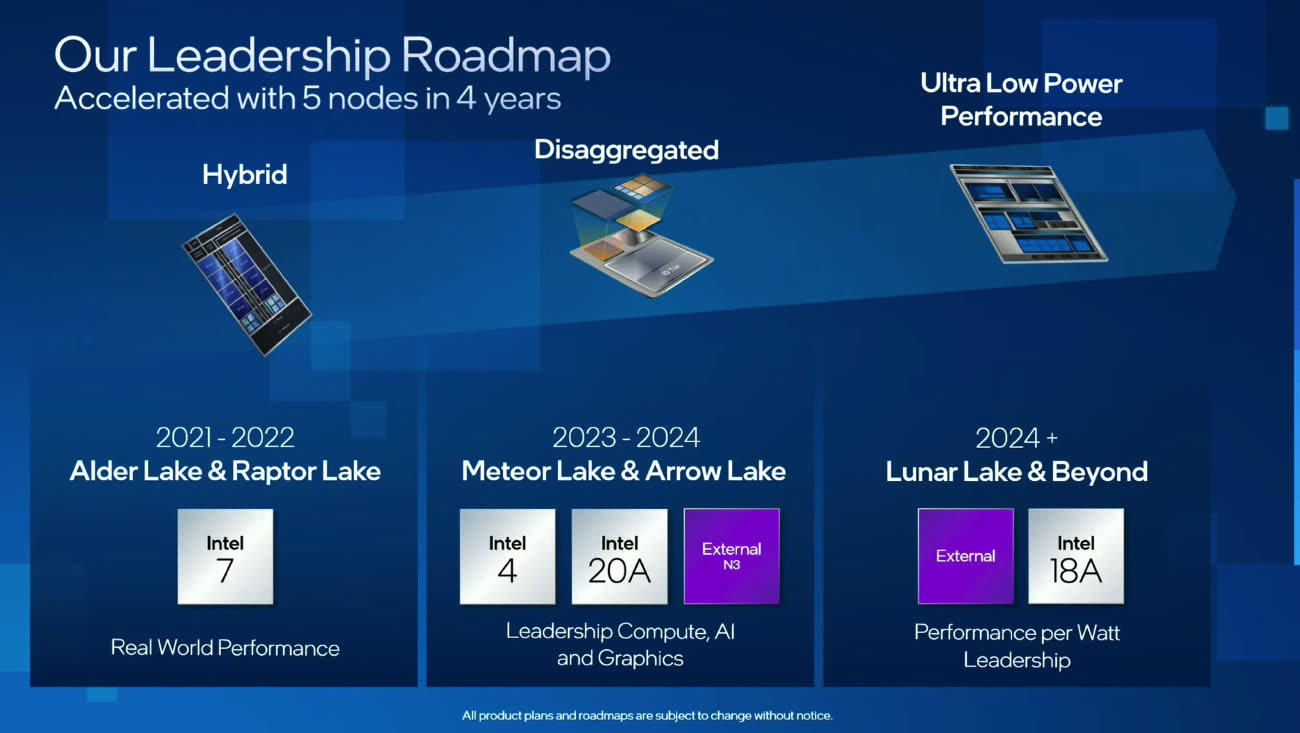

Meteor Lake, qui est officiellement la 14e génération, n'a pas encore de dates de sortie. Intel devrait améliorer les cœurs rapides et les cœurs basse consommation1, mais il y a peu de détails. Avec cette version, la gravure passerait en « Intel 4 », ce qui n'indique pas précisément la finesse : Intel considère simplement que c'est équivalent au 4 nm des autres fondeurs.

Avant Lunar Lake, il y a encore une autre sortie prévue : Arrow Lake. S'il n'y a pas de puces intermédiaires ou de changement de nom, il devrait s'agir de la 15e génération, avec là aussi des architectures mises à jour pour les deux types de cœurs. La gravure passerait en Intel 20A, soit environ 2 nm. Le A signifie angstrom, une unité 10x plus petite que le nanomètre.

Enfin, la 16e génération (si tout se passe bien) serait celle dont nous parlons au début de l'article : Lunar Lake. À part le fait qu'Intel partirait visiblement de zéro pour tenter d'optimiser la consommation de ses puces et que la partie graphique emploierait l'architecture Xe2, il y a peu de choses connues. Dans le meilleur des cas, les puces ne devraient pas débarquer avant 2025 ou 2026, avec une gravure Intel 18A (soit 1,8 nm, ou équivalent).

(Image d'ouverture : Dylan Ashe, CC BY-SA 2.0)

-

Dans la 13e génération, les cœurs rapides ont évolué, mais pas les cœurs basse consommation. ↩︎