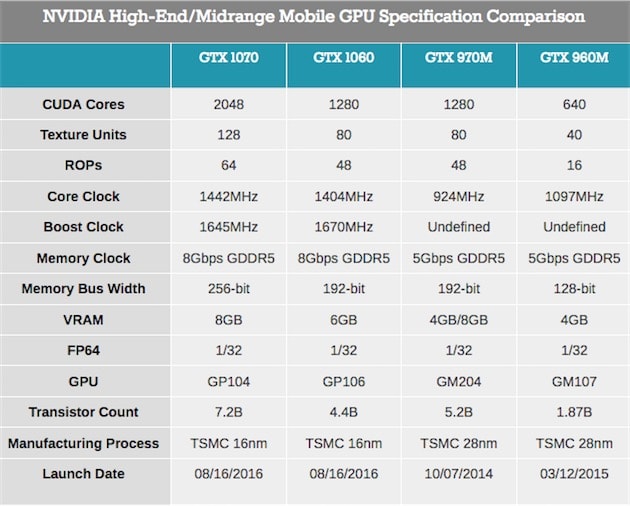

Peu de temps après leur sortie sur ordinateur de bureau, les GeForce GTX 1080, 1070 et 1060 sont déclinées sur portable. Notez que Nvidia ne parle pas de GTX 1080M, mais bien de GTX 1080 (idem pour les deux autres cartes). En abandonnant le suffixe « M » traditionnellement dévolu aux déclinaisons pour portable, le fabricant veut souligner que ces GPU sont comparables à leur version de bureau.

Il y a effectivement peu de différence entre les deux. Ils comportent le même nombre d'unités de calcul et d'unités de texturing (la version mobile de la GTX 1070 en a même un peu plus que la version de bureau), la même architecture, la même mémoire...

Ce qui les différencie principalement est leur fréquence de base et leur fréquence turbo, qui sont logiquement un peu inférieures sur portable pour s'accommoder des contraintes d'énergie (sauf pour la GTX 1080 qui a une fréquence turbo équivalente). Au bout du compte, Nvidia assure que les performances sont équivalentes en moyenne à au moins 90 %.

Par rapport aux modèles précédents (GTX 960M...), les GeForce GTX 1000 promettent d'être significativement plus puissantes grâce notamment à une montée en fréquence importante et une multiplication des unités de calcul, des évolutions permises par une gravure plus fine (16 nm contre 28 nm). Là encore, Nvidia promet monts et merveilles puisque les performances seraient supérieures d'environ 70 %.

Plusieurs constructeurs vont proposer très prochainement des machines embarquant une de ces cartes graphiques : Acer, Alienware, Asus, HP, Lenovo... mais sans doute pas Apple, qui aurait choisi les nouveaux GPU Polaris d'AMD pour les prochains MacBook Pro.