Apple a modernisé son API de transcription de l’audio en texte avec les mises à jour annuelles et SpeechAnalyser, c’est le nom de la nouvelle génération, peut désormais concurrencer Whisper, le modèle de transcription proposé par OpenAI. Un développeur a mis au point un utilitaire pour le terminal nommé Yap pour l’exploiter sous macOS Tahoe et les résultats sont impressionnants. Cette transcription réalisée entièrement en local sur les Mac équipés d’une puce Apple Silicon est non seulement bien plus rapide que celle de Whisper, elle propose une qualité à la hauteur de son illustre concurrent.

Pour tester la nouveauté, j’ai utilisé un MacBook Pro M1 passé sous macOS 26. Yap doit être installé avec un gestionnaire de paquets comme Homebrew et il fonctionne ensuite directement, puisqu’il est basé sur un modèle fourni par Apple et intégré au système. En face, j’ai utilisé MacWhisper, une excellente app qui permet de télécharger le modèle Whisper pour réaliser une transcription locale. J’ai téléchargé le dernier épisode de Sortie de Veille, notre podcast hebdomadaire, soit un fichier audio d’un petit peu plus de 26 minutes.

Sur cet ordinateur, le moins puissant des Mac Apple Silicon, Yap a terminé sa tâche en environ 16 secondes. Avec le même fichier et MacWhisper, le temps d’exécution dépend des modèles, mais il est systématiquement supérieur. Avec le modèle « Base », le plus léger (150 Mo) et rapide, il a fallu une minute et dix secondes, tandis que le modèle « Large V3 Turbo » (1,6 Go) que j’utilise au quotidien a demandé 4 minutes et 23 secondes. Apple utilise un modèle compact, tout en offrant de très bons résultats, car il faut aussi comparer la qualité de la transcription.

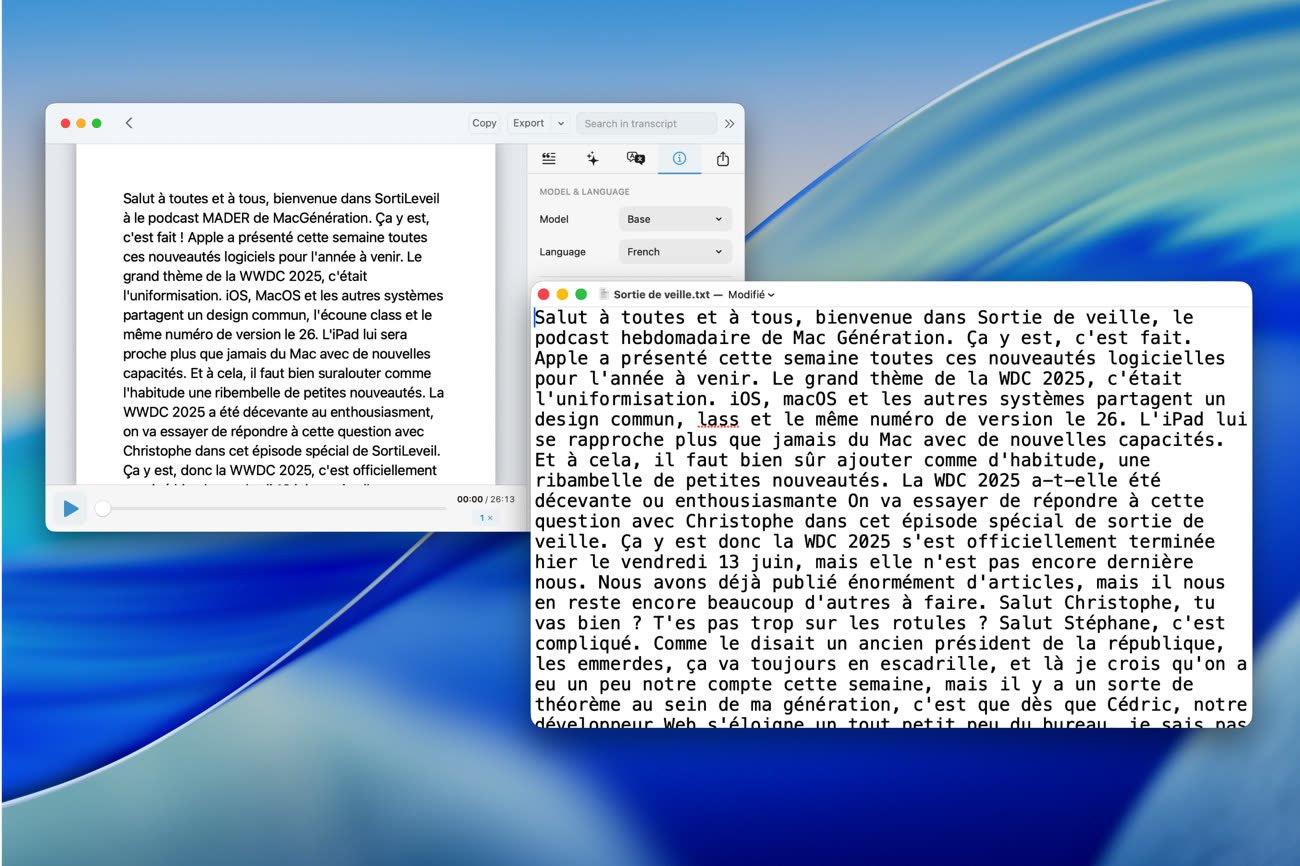

Alors qu’il est extrêmement rapide, SpeechAnalyser a produit un fichier d’excellente qualité, comparable au modèle large de Whisper, mais ce dernier est seize fois plus lent ! En comparaison, le modèle de base fourni par OpenAI reste plus lent que celui d’Apple et ses résultats sont bien plus mauvais, à la limite de l’exploitable. La copie fournie par Yap n’est pas parfaite, on note notamment qu’elle a du mal sur les noms de produits (ce sont pourtant des produits Apple…) comme « Liquid Glass » ou encore « WWDC », elle reste toutefois bien supérieure, tout en étant obtenue bien plus rapidement.

Whisper reprend à peine l’avantage si vous avez le temps, le grand modèle donne un résultat subjectivement un petit peu meilleur, même si la différence n’est pas aussi importante que je l’imaginais alors que le temps de traitement n’a rien à voir. Il faut aussi penser aux ressources nécessaires : si j’ai utilisé ici un petit fichier audio, il faut savoir que vous aurez besoin d’une quantité de RAM d’autant plus importante que la transcription est longue. Sur cet exemple facile, je note déjà une différence importante entre les deux : le modèle d’Apple n’utilise qu’environ 350 Mo de mémoire, contre 2,2 Go environ pour MacWhisper (avec le modèle large).

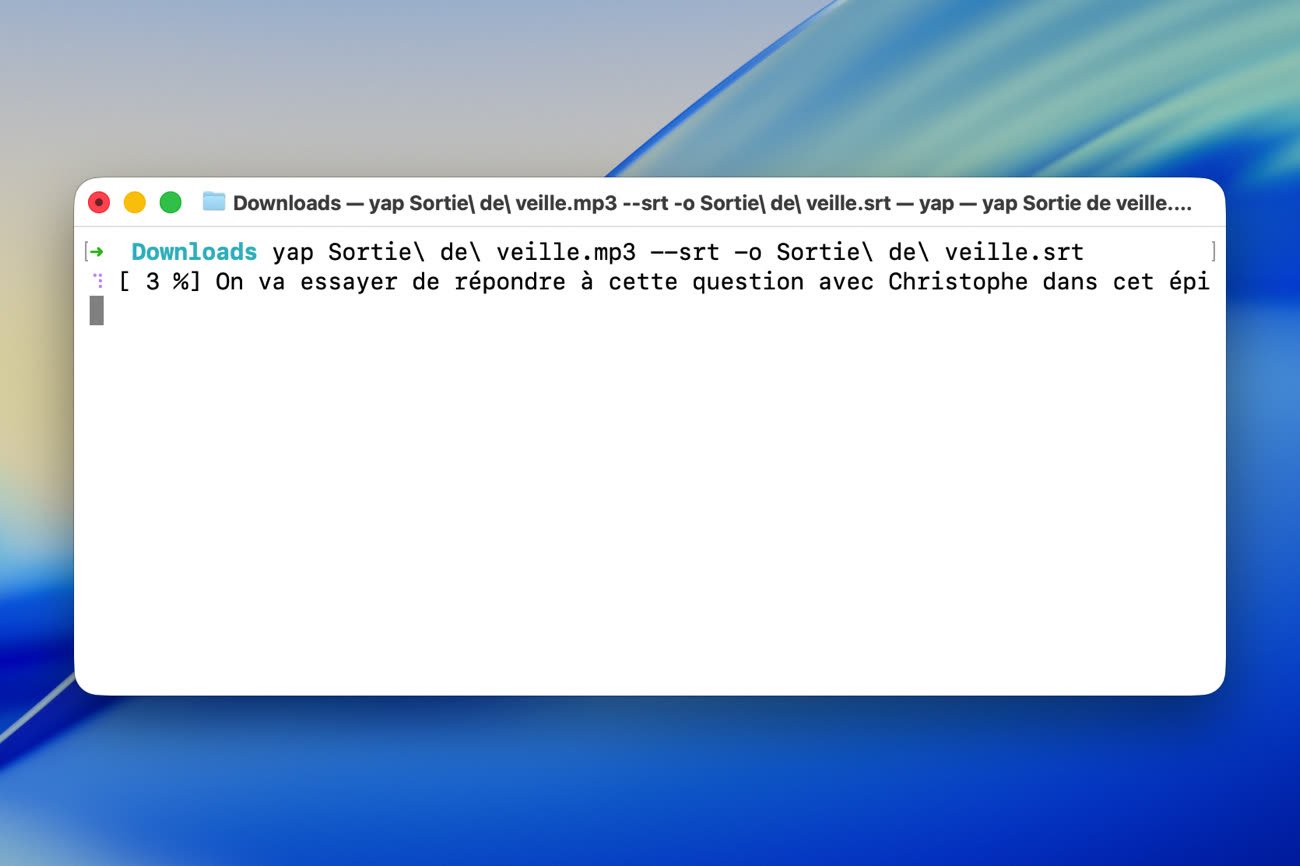

Si vous voulez tester ce nouveau concurrent à Whisper, vous devrez installer macOS Tahoe sur un Mac Apple Silicon, puis installer Yap :

brew install finnvoor/tools/yap

Vous pourrez ensuite l’utiliser avec une ligne de commande de ce type :

yap audio.mp3 -o texte.txt

La documentation liste quelques options disponibles, on peut notamment générer un fichier de sous-titres au format SRT et on peut pointer le service sur une vidéo en entrée. On peut même combiner l’outil à yt-dlp pour transcrire des vidéos en ligne sans les télécharger en local. On imagine que de nombreuses apps proposeront une interface graphique, plus conviviale, pour utiliser SpeechAnalyser d’ici la sortie de macOS 26.

Pour en savoir plus sur la nouvelle API, Apple propose aux développeurs une session technique qui détaille comment l’exploiter dans une app. Apple l’utilise elle-même dans plusieurs apps, dont Notes, Dictaphone, Journal ou encore Téléphone. iOS 26 permettra de transcrire l’anglais (britannique et américain), le français (uniquement en France), l’allemand, le portugais (Brésil) et l’espagnol (Espagne) et on peut sans doute compter sur la même liste de langages pour l’API sous-jacente.

Source :