Apple publie de temps en temps des études sur les LLM — les grands modèles de langage — et la dernière, opportunément publiée un peu avant la WWDC de 2025, est assez critique : selon les chercheurs, les LRM ne pensent pas mais ont une capacité de mémorisation intéressante dans certains cas, ce qui ne devrait pas nécessairement étonner tout le monde mais fait parfaitement illusion.

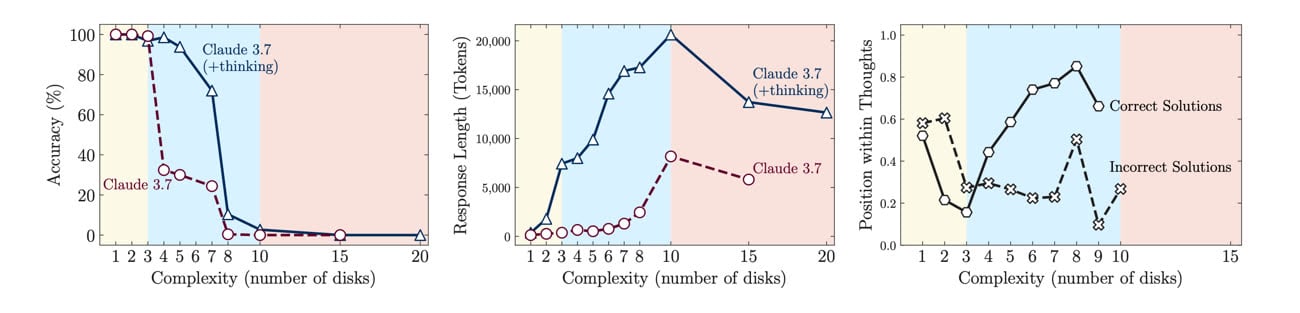

Le papier s'intéresse spécifiquement au LRM, pour Large Reasoning Models. Ces versions plus évoluées des LLM classiques sont en théorie prévues pour améliorer les capacités de raisonnement des modèles. Les chercheurs d'Apple ont évalué o1 et o3 (OpenAI), DeepSeek-R1, Claude 3.7 Sonnet Thinking et Gemini Thinking. Un des problèmes, selon eux, est que les tests employés habituellement sont biaisés, notamment parce que les données sont parfois présentes dans le corpus qui a servi à l'entraînement. Pour éviter ce biais, ils ont utilisé des casse-têtes logiques en modifiant les règles et la complexité.

Les résultats montrent d'abord que les LLM classiques trouvent plus rapidement et plus efficacement la réponse sur les problèmes dont la logique est simple. Quand la logique est plus complexe, les LRM prennent l'avantage sur les LLM, et quand les problèmes sont très complexes, aucune des deux technologies n'est capable de proposer une réponse correcte. Une des raisons des performances moins élevées sur les problèmes simples vient d'un phénomène de surréflexion : les LRM ont tendance à évaluer des résultats incorrects avant d'arriver à la solution attendue.

Un des cas intéressants qui montre parfaitement le biais des tests est celui des tours de Hanoï. C'est un casse-tête logique assez courant, que beaucoup de développeurs ont probablement codé pendant leurs études. Vous connaissez peut-être le principe de base : il y a n disques, du plus petit au plus grand, et trois tours. Les disques sont rangés du plus grand (en bas) au plus petit (en haut) et il faut déplacer l'ensemble des disques de la tour de gauche à celle de droite. Les règles sont simples : un disque à la fois, et uniquement en plaçant un disque sur un emplacement vide ou un disque plus grand. Avec ce casse-tête, les LRM proposent une solution parfaite dans pratiquement tous les cas avec 5 disques (ce qui nécessite 31 mouvements) et ne commencent à commettre des erreurs qu'à partir de 10 disques et une centaine de mouvements.

Dans le problème du passage de la rivière, la donne est différente. La version exacte du problème est expliquée dans les appendices (la page Wikipedia donne quelques exemples), mais le but est de transporter des personnes d'une rive à une autre avec des contraintes sur les couples possibles, tout en sachant que le bateau doit transporter au moins une personne. C'est un problème largement moins étudié que le précédent, avec de nombreuses variantes, et les LRM échouent dès que le nombre de mouvements nécessaires est de 11.

Selon les chercheurs, les raisons de ces disparités ne viennent pas de la complexité elle-même des casse-têtes, mais bien du fait que les tours de Hanoï sont très étudiées et que de nombreuses solutions se trouvent a priori dans les données d'entraînement des LRM. Ce n'est donc pas un raisonnement à proprement parler qui permet au LRM de résoudre le problème, mais une mémorisation des étapes nécessaires. A contrario, le second problème est moins étudié et moins formalisé, et les capacités de raisonnement bien trop limitées (ou absentes) pour résoudre efficacement le casse-tête.