Des employés de Samsung ont diffusé des informations confidentielles à ChatGPT, un manque de prudence qui remet sur la table la question de la gestion des données par OpenAI. Le site coréen Economist rapporte que plusieurs salariés de la branche dédiée aux semi-conducteurs de Samsung ont fait appel au bot pour traiter des informations internes. Or, ChatGPT garde tout en mémoire et utilise les conversations pour s'améliorer : ces informations privées sont donc désormais entre les mains d'OpenAI.

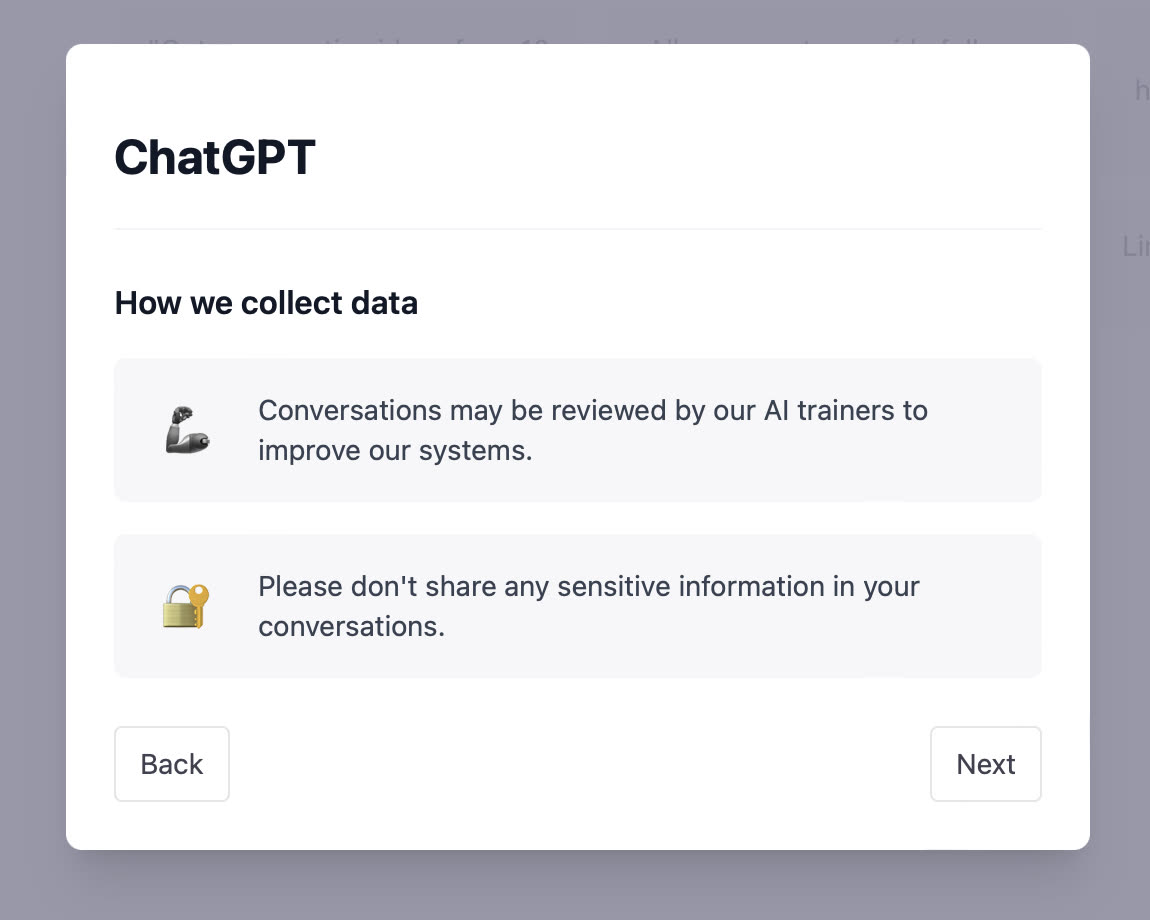

Les règles d'OpenAI sont pourtant claires. La FAQ de ChatGPT confirme que les conversations seront utilisées pour l'entraînement de l'IA et que les discussions peuvent être surveillées. Elle précise également que l'entreprise n'a pas la possibilité de supprimer les requêtes envoyées par l'utilisateur. Au démarrage, le bot invite noir sur blanc à ne pas partager de données sensibles dans ses échanges.

Malgré cela, un employé de Samsung a copié le code source d'un logiciel identifiant les rendements de puces défectueux dans ChatGPT et lui a demandé de l'aider à trouver une solution. Un second a ordonné au bot de convertir des notes d'une réunion interne en une présentation. Un troisième a partagé le code d'un programme maison et a invité le bot à l'optimiser.

Pour tenter de répondre au problème, Samsung a limité le nombre de caractères maximum pour les questions posées à ChatGPT et a menacé de bloquer l'IA sur son réseau. En coulisse, l'entreprise envisagerait le développement de son propre modèle textuel, qui serait réservé aux employés.

Ce problème d'employés un peu trop imprudents ne touche pas que Samsung. Son concurrent SK Hynix aurait bloqué l'utilisation de ce type de chatbots sur son réseau interne, imposant une autorisation spécifique aux employés. LG Display aurait lancé des campagnes éducatives pour faire prendre conscience à son personnel des potentiels risques de confidentialité.

Une étude récente de Cyberhaven (une entreprise spécialisée dans la cybersécurité) a montré que 3,1 % de ses clients qui utilisaient l'IA avaient divulgué des données vulnérables de leur entreprise à ChatGPT à un moment donné. Une entreprise de 100 000 employés pourrait transmettre des informations sensibles à OpenAI des centaines de fois par semaine.