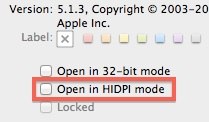

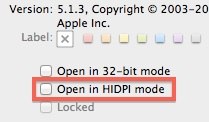

La dernière version bêta d'OS X 10.7.3 a fait au moins une victime, la disparition d'une option pour l'affichage haute définition des interfaces d'applications. MacRumors explique qu'il y avait dans ces 10.7.3, à l'intérieur de la fenêtre Lire les informations, une case à cocher pour basculer l'application en mode HIDPI à son prochain lancement. Une option présente, mais jamais fonctionnelle. Cette case a maintenant disparu avec la bêta distribuée cette nuit. Ce va-et-vient montre au moins que le sujet de l'indépendance de la résolution dans OS X n'a pas été complètement oublié chez Apple.

Ce mode d'affichage surnommé "retina display" en écho à celui utilisé dans les iPhone 4 et 4S était revenu dans l'actualité à la faveur d'une rumeur d'écrans à très haute définition (ou densité de pixels) pour les prochains MacBook Pro (lire Rumeur de MacBook Pro "Retina Display").

Ce mode d'affichage surnommé "retina display" en écho à celui utilisé dans les iPhone 4 et 4S était revenu dans l'actualité à la faveur d'une rumeur d'écrans à très haute définition (ou densité de pixels) pour les prochains MacBook Pro (lire Rumeur de MacBook Pro "Retina Display").